creativeneko - stock.adobe.com

IA générative : Llama 3.1 405B, le champion de Meta pour détrôner OpenAI

Meta a terminé l’entraînement de son grand modèle de langage doté de 405 milliards de paramètres. Outre le fait qu’il égale (ou presque) Anthropic et OpenAI avec un LLM « open weight », le géant des réseaux sociaux se rapproche des équipementiers et fournisseurs cloud, pour mieux cibler les entreprises.

Lors du lancement de Llama 3 8B et 70B, Meta avait précisé qu’il était en train de préparer une variante dotée de 400 milliards de paramètres. Elle compte finalement 405 milliards de paramètres et se nomme Llama 3.1. C’est le plus gros modèle de langage entraîné à ce jour par l’entreprise.

Llama 3.1 est également distillé dans des variantes de base et instruites, dotées respectivement de 8 et 70 milliards de paramètres.

Le géant des réseaux sociaux le présente comme le premier « modèle open source de niveau frontière (sic) ». Pour le préentraînement de Llama 3.1 405B, il a utilisé 3,8 × 1 025 FLOPs de puissance de calcul. Selon la grille de lecture actuelle de l’AI Act, cela le catégoriserait automatiquement dans les modèles d’IA présentant un risque systémique. Il n’est toutefois pas certain qu’il soit banni de l’UE, puisqu’il découle d’un projet de science ouverte.

De petits ajustements pour un très grand modèle

Les équipes de recherche de Meta ont optimisé un jeu de données d’entraînement de 15 600 milliards de tokens. Comme Llama 3, les modèles Llama 3.1 dépendent à nouveau d’une architecture dense et leur limite de connaissances est fixée au mois de décembre 2023.

« Nous avons choisi une architecture Transformer en mode décodeur uniquement avec des adaptations mineures plutôt qu’un mélange d’experts, afin de maximiser la stabilité de l’entraînement », écrivent les chercheurs de Meta.

Parmi ces ajustements, Meta utilise 8 têtes clé-valeur pour le mécanisme d’attention groupé (GQA), comme le fait déjà Mistral AI avec ses modèles denses. Cela permettrait d’accélérer la vitesse d’inférence tout en réduisant l’espace occupé par les clés-valeurs en cache.

Les chercheurs utilisent par ailleurs un masque d’attention « pour empêcher l’attention entre différents documents dans une même séquence. Cela a peu d’impact pendant l’entraînement standard, mais s’avère crucial pour l’entraînement prolongé sur des séquences très longues », signalent les chercheurs.

Ils ont également fait varier l’hyperparamètre de la fréquence de rotation du mécanisme d’encodage des embeddings (ROPE) afin de mieux prendre en charge des contextes plus longs.

En ce sens, Meta profite pleinement de son tokenizer revu et corrigé basé sur Tiktoken, dont le vocabulaire atteint la taille de 128 000 tokens.

Qui plus est, Meta a enfin trouvé un moyen d’ingérer plus 8 192 tokens en entrée. Comme Mistral AI, le géant des réseaux sociaux propose une fenêtre de contexte de 128 000 tokens.

Dans le détail, l’entraînement a débuté par l’utilisation d’une fenêtre de contexte de 8 192 tokens qui a été augmentée progressivement à sa taille maximale dans un processus de préentraînement continu.

Par ailleurs, Meta a optimisé sa chaîne post entraînement. La branche R&D mise encore et toujours sur des techniques de fine-tuning supervisé, de réglages des données d’instruction, d’optimisation directe des préférences (Direct Preference Optimization ou DPO) et de rejet d’échantillons. Là encore, les chercheurs ont privilégié la stabilité des traitements plutôt que l’adoption de techniques plus élaborées.

Si Meta favorise la constitution manuelle de jeux de données, les chercheurs exploitent tout de même la génération de données synthétiques. Ils ont produit 25 millions d’exemples synthétiques utilisés lors du fine-tuning des modèles. Ceux-là sont triés sur le volet à l’aide de plusieurs techniques de filtrage de données.

Le plus grand défi a été d’adapter les différentes étapes d’entraînement à la fenêtre de contexte de 128 000 tokens, tout en s’assurant qu’il n’y aurait pas de perte de performance quand les textes ingérés sont plus courts.

Meta, coude à coude avec OpenAI et Anthropic

Résultat, Llama 3.1 405B passe devant GPT-4-0125 face aux benchmarks MMLU, MMLU Pro, IFEval, GSM8K, HumanEval, MBPP EvalPlus, Math, ARC-C, GPQA ou encore MGSM. Il titille du doigt GPT-4o dans plusieurs de ces parangonnages, mais se fait battre de peu par Claude 3,5 Sonnet.

En savoir plus :

« Notre évaluation expérimentale suggère que notre modèle phare est compétitif par rapport aux principaux modèles de base pour toute une série de tâches », avance Meta.

Llama 3,1 8B devance de peu devant Gemma 2 9B Instruct et LLama 3.1 70B devant Mixtral 8x22B et GPT-3.5 Turbo dans la plupart des benchmarks génériques.

« Llama 3.1 est destiné à un usage commercial et de recherche dans plusieurs langues. Les modèles de texte seul adaptés à l’instruction sont destinés à la conversation de type assistant, tandis que les modèles préentraînés peuvent être adaptés à une variété de tâches de génération de langage naturel », précise Meta.

Il prend en charge huit langues : l’anglais, le français, l’allemand, l’italien, le portugais, l’hindi, l’espagnol et le thaï.

Bien que la licence propriétaire permissive change de nom, elle porte les mêmes critères permettant, dans la plupart des cas, une exploitation commerciale sans redevance.

Un bilan carbone faramineux

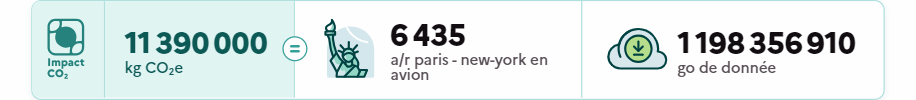

Toutefois, alors que le marché s’oriente vers l’utilisation de small language models (SLM) ou de petits LLM (entre 7 et 15 milliards de paramètres), la mise à disposition d’un modèle de 405 milliards de paramètres entraîné sur un cluster de 16 000 GPU Nvidia H100 (80 Go VRAM HBM3e, TDP de 700 watts) paraît (déjà) décalée. D’autant que Meta vient de grever son bilan carbone basé sur la localisation en y ajoutant 11 390 tonnes équivalent CO2 (39,3 millions d’heures de traitement cumulées), dont 8 930 tco2eq imputables à l’entraînement de son très gros modèle.

Selon le comparateur de l'ADEME, le bilan carbone non compensé de Llama 3.1 représente 6435 vols aller-retour entre Paris et New York - Crédits image : ADEME

Selon le comparateur de l'ADEME, le bilan carbone non compensé de Llama 3.1 représente 6435 vols aller-retour entre Paris et New York - Crédits image : ADEME

La collection Llama 3.1 représente 6 435 allers-retours Paris-New York en avion ou 1 198 Po de données stockées dans le cloud, selon le comparateur de l’ADEME. Une hausse de plus de 2 013 % par rapport au bilan carbone de la collection Llama 2, soit une multiplication des émissions par 20, et de près de 400 % par rapport à Llama 3. Pour rappel, la constitution des premiers membres de la famille Llama 3 avait émis 2 290 tonnes équivalent CO2, ce qui était déjà quatre fois plus que pour Llama 2.

Des émissions que l’entreprise dit avoir déjà compensées en achetant ou en finançant l’équivalent de 100 % de sa consommation d’électricité en énergies renouvelables.

Meta reste l’un des acteurs de l’IA les plus transparents quant à l’exposition de son bilan carbone et continue de considérer que d’autres n’auront pas à réaliser cet entraînement.

Meta se tourne pleinement vers les entreprises

Toutefois, exploiter en production un modèle de 405 milliards de paramètres est un défi. Le géant des réseaux sociaux en est conscient. « Bien qu’il s’agisse d’un modèle incroyablement puissant, nous reconnaissons qu’il nécessite des ressources de calcul et une expertise considérables », note l’entreprise.

« Le modèle de 405 milliards de paramètres exige d’immenses ressources de calcul, notamment des GPU très performants et une capacité de stockage importante », juge Paul Nashawaty, analyste chez Futurum Group, dans un communiqué de presse. « Cela se traduit par des coûts initiaux importants pour le matériel, ainsi que par des dépenses permanentes pour l’électricité et le refroidissement ».

Meta sait aussi qu’il doit rentabiliser ses investissements. Selon les estimations de SearchAIEnterprise, une publication sœur du MagIT, un GPU Nvidia H100 coûte entre 25 000 et 40 000 dollars. Au prix courant, Meta aurait déboursé entre 400 millions et 640 millions de dollars pour acheter ses accélérateurs.

Des GPU qui ont tendance à tomber en panne quand ils sont exploités de manière intensive. En 54 jours de préentraînement de Llama 3.1 405B, Meta rapporte que « les problèmes liés au GPU constituent la catégorie la plus importante, représentant 58,7 % de toutes les interruptions ».

Malgré tout, il n’y aurait eu que trois grandes interventions manuelles, « le reste des défauts étant géré par l’automatisation ». Sans compter les autres composants des serveurs de calcul, le réseau, ou encore les 7 500 machines connectées pour former un espace de 240 pétaoctets disponibles lors de l’entraînement.

Ainsi, et c’est sans doute le changement le plus notable dans la présentation de ce modèle, Meta reproduit l’approche de Mistral AI et Anthropic en affichant ses partenaires, au nombre de dix.

AWS, Databricks, Dell, Nvidia, Groq, IBM, Google Cloud, Microsoft, Scale et Snowflake proposeront tous LLama 3.1 405B en permettant différentes modalités d’usage. Le tableau ci-dessous rapporte la tarification des services cloud pour un million de tokens en entrée et un autre en sortie.

Dell sera le porteur d’une offre on premise. L’équipementier précise que les modèles seront prochainement disponibles sur le Dell Enterprise Hub.

Meta remercie également AMD, Anyscale, CloudFlare, Deloitte, Fireworks.ai, Infosys, Kaggle, Intel, OctoAI, Oracle Cloud, PWC, Replicate, Sarvam AI, Scale.ai, Together AI, Sky Computing Lab… et la SNCF. Tous ont participé d’une manière ou d’une autre à l’entraînement de Llama 3.1.

En parallèle, Meta a mené des efforts pour compresser Llama 3.1 405B au format d’encodage FP8 afin de le faire tenir sur un « seul serveur » doté de huit GPU H100. De fait, le modèle pèse plus de 800 Go au format BF16, bien au-dessus des 640 Go de VRAM totalisées par un HGX100.

De leur côté, les ingénieurs de Dell ont pu déployer la variante FP8 sur un serveur PowerEdge XE9680 (deux CPU Intel Xeon Scalable jusqu’à 56 cœurs chacun, 8 Nvidia H100 SXM5 NVLINK, 4 To de RAM max) et le modèle BF16 sur deux serveurs de cette même gamme, interconnectés en Infiniband ou en RoCE (Meta prend en charge les deux options).

L’inférence en temps réel, en batch, le fine-tuning, l’évaluation d’autres LLM, la constitution de bases de connaissances, le préentraînement continu, la génération de données synthétiques, la mise à disposition de garde-fous et de recettes de distillation sont autant de capacités que ces partenaires peuvent prendre partiellement ou totalement en charge.

Au vu de la disponibilité restreinte des GPU, de leur prix, il semble plus évident pour les entreprises d’opter pour les variantes 8B et 70B de Llama 3.1.

Un outillage nécessaire pour dompter Llama 3.1

D’autant que Meta souligne (littéralement) que ses LLM ne sont pas à déployer isolément de certains outils, dont LLama Guard 3, un LLM entraîné pour empêcher l’inférence de contenus toxiques, Prompt Guard, un filtre contre l’injection de prompts de type Jailbreak.

Bien que la collection ait été éprouvée par sa red team, le géant des réseaux sociaux demeure prudent. « Llama 3.1 peut encore générer du contenu préjudiciable en raison de l’entraînement sur divers ensembles de données, en particulier pour les langues autres que l’anglais, et lorsqu’il est conçu par des équipes de red teaming qualifiées », signalent les chercheurs. « Des développeurs ou des utilisateurs malintentionnés peuvent trouver de nouvelles façons de casser nos modèles et de les utiliser pour diverses activités malveillantes ».

Plus tard, le fournisseur de LLM ajoutera des capacités multimodales à LLama 3.1. Il travaille notamment avec des startups pour y intégrer des fonctions d’interprétation d’images.