Laurent - stock.adobe.com

Non, le Deep Learning n’est pas une obscure boîte noire

Les réseaux neuronaux profonds se forment en fonction des données qu’on leur soumet. Mais contrairement à une idée fausse, leurs résultats peuvent s’expliquer. Reste à le faire avec des méthodes normalisées.

Comme avec toute révolution technologique, l’intelligence artificielle – et plus particulièrement les réseaux de neurones profonds, qui permettent de faire du deep learning – soulève des questions et des doutes, surtout lorsqu’il s’agit d’applications critiques. La critique la plus fréquente, lorsqu’il s’agit de cette technologie, vise l’incapacité de l’Homme à comprendre le processus, à l’expliquer dans un langage simple et à le comparer à une décision humaine.

Mais sur ce sujet, les idées fausses sont nombreuses. Une d’entre elles, qui est très courante, consiste à dire que le processus d’apprentissage d’un algorithme de deep learning revient à « stocker des images dans une bibliothèque ». En résumé, l’algorithme stockerait beaucoup de scènes, étiquetées lors de sa « formation », puis lorsqu’il est testé, si une scène se révèle être proche d’une contenue dans sa bibliothèque, il la reconnaît.

Simple. Mais ce n’est pas comme cela que fonctionnent les réseaux neuronaux profonds ! Et les tests permettent justement de bien mieux comprendre ce qui se passe vraiment.

Les tests jouent beaucoup dans la compréhension

Lorsqu’un algorithme est entraîné pour détecter des avions sur des images satellites, l’algorithme ne va pas « stocker » les images. Il va en fait apprendre ce qu’est un avion sur ces images.

En d’autres termes, quelles sont les caractéristiques clés de l’image qui font de cet objet un avion (ou ce qui fait que ce n’en est pas un) : un avion a des ailes, un fuselage, une queue, un moteur, il peut être de toutes les couleurs, il est généralement plus grand que 10 m et plus petit que 80 m, etc.

Non seulement le réseau de neurones apprend à détecter ces caractéristiques. Mais il apprend aussi quelles caractéristiques sont nécessaires (et lesquelles sont optionnelles) et comment elles peuvent être hiérarchisées.

Revenons au test. Si la base de formation est bien conçue – qu’elle est représentative en termes de qualité d’image et d’objets correspondant aux futurs cas d’usage – alors le test démontrera les performances algorithmiques sur un certain ensemble de caractéristiques d’image (ou « domaine » en langage mathématique). Le « truc » vient de l’interprétation de ce domaine ou de la réponse à la question « est-ce que cette image est dans le même domaine que l’ensemble de tests, pour que je sois sûr d’avoir les mêmes performances en test et prédiction ? ».

En effet, les algorithmes de deep learning n’utilisent pas l’information des images comme les humains. Le bruit, les artefacts de compression ou le flou peuvent activer ou désactiver certains neurones sans avoir d’impact sur l’interprétation humaine, mais en avoir sur un réseau de Deep Learning.

Cependant, cet impact peut être mesuré. Plusieurs méthodes permettent d’estimer la confiance et la robustesse d’un algorithme en s’appuyant sur un ensemble de tests et de formations donné. En d’autres termes, il est possible de dire si une image correspond au domaine de validation ou non, et d’alerter l’utilisateur sur un cas non couvert par l’algorithme ou dont les performances n’ont pas été testées.

Le Deep Learning peut être expliqué

Le reproche principal fait à la méthodologie du machine learning est souvent la question de savoir « comment il décide ». On entend souvent le terme « boîte noire » c’est-à-dire que « même les mathématiciens ne comprennent pas pourquoi et comment les algorithmes travaillent ».

Mais cette idée aussi est fausse. Elle tire son origine du fait que le réseau « apprend » et qu’il n’est pas conçu directement dans sa version définitive. Mais les experts comprennent réellement chaque étape du processus.

Répétons-le clairement : de la rétropropagation à la convolution, chaque étape et chaque module d’un réseau neuronal profond est compréhensible et explicable pour un expert.

Ce qui est vrai en revanche c’est qu’en raison de la complexité du processus d’apprentissage, il est difficile d’exposer l’explication dans une langue pertinente pour un client. En d’autres termes : « oui le chat sur cette image de smartphone est détecté ici à cause de certaines activations de neurones qui ont été configurées de cette façon à cause de la rétropropagation… mais que signifie-t-elle réellement pour moi ? »

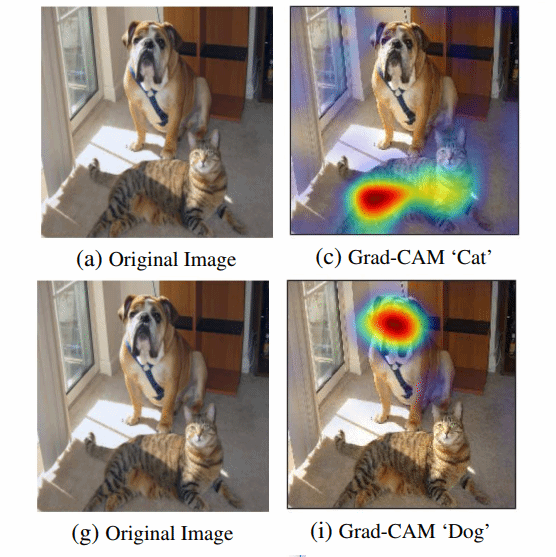

Exemple de Heat Map

Exemple de Heat Map

Heureusement, il existe plusieurs méthodes pour aider les utilisateurs à visualiser « pourquoi » l’IA a décidé de se comporter d’une certaine manière. Dans le cas de la détection d’images par exemple, la visualisation d’une « heat map » (carte de chaleur) permet de comprendre pourquoi et où le réseau s’active sur l’image et « pourquoi » il choisit de se comporter ainsi.

Des dizaines d’autres outils et méthodologies permettent ce type d’interprétation : par exemple, les réseaux de neurones Bayesian peuvent signaler où l’algorithme est « incertain » de ses choix.

Vers la normalisation

Toutes ces méthodes et toutes ces techniques permettent de valider des algorithmes, de donner des estimations de confiance et de repérer des indicateurs qui peuvent créer un comportement anormal.

Ils sont essentiels pour déployer un apprentissage approfondi efficace au niveau des applications critiques, et convaincre les utilisateurs de faire confiance à ces technologies.

Car au final, tout repose sur la confiance. Le deep learning n’est pas différent des autres technologies sur ce point. C’est aux ingénieurs et aux spécialistes des données qu’il incombe de présenter les bons outils pour que les utilisateurs puissent comprendre et, éventuellement, leur faire confiance.

Pour y parvenir, la communauté du deep learning devrait s’orienter vers des protocoles et des logiciels normalisés pour les tests, pour l’explicabilité, pour l’évaluation de la robustesse et participer ainsi activement au processus de certification afin que les normes soient pertinentes sur cette technologie. Au passage, Earthcube participe d’ailleurs au groupe de travail pour la certification ISO des algorithmes d’apprentissage profond en Europe (AFNOR/CN JTC1/SC 42).

Le Deep Learning incontournable par ses performances

Enfin, il devient de toute façon de plus en plus difficile de se passer du deep learning. Oui, d’autres technologies de machine learning ou de systèmes experts fonctionnent très bien pour des problèmes simples, ou pour un nombre fixe de solutions. En fait, même dans le monde du machine learning, le nombre d’applications où il est spécifiquement nécessaire d’utiliser des réseaux neuronaux profonds est très limité. Mais pour celles-ci, rien ne se rapproche du deep learning en termes de performances. Raison de plus pour bien l’expliquer.