Intelligence artificielle (IA)

Qu'est-ce que l'intelligence artificielle (IA) ?

L'intelligence artificielle est la simulation des processus de l'intelligence humaine par des machines, en particulier des systèmes informatiques. Les applications spécifiques de l'IA comprennent les systèmes experts, le traitement du langage naturel, la reconnaissance vocale et la vision artificielle.

Comment fonctionne l'IA ?

Alors que le battage médiatique autour de l'IA s'est accéléré, les fournisseurs se sont empressés de promouvoir la façon dont leurs produits et services l'utilisent. Souvent, ce qu'ils appellent l'IA n'est qu'un composant de la technologie, comme l'apprentissage automatique. L'IA nécessite une base d'infrastructure et de logiciels spécialisés pour l'écriture et la formation des algorithmes d'apprentissage automatique. Aucun langage de programmation n'est synonyme d'IA, mais Python, R, Java, C++ et Julia ont des caractéristiques très prisées par les développeurs d'IA.

En général, les systèmes d'IA fonctionnent en ingérant de grandes quantités de données d'apprentissage étiquetées, en analysant les données à la recherche de corrélations et de modèles, et en utilisant ces modèles pour faire des prédictions sur les états futurs. C'est ainsi qu'un chatbot nourri d'exemples de texte peut apprendre à générer des échanges réalistes avec des personnes, ou qu'un outil de reconnaissance d'images peut apprendre à identifier et à décrire des objets dans des images en examinant des millions d'exemples. Les nouvelles techniques d'IA générative, qui s'améliorent rapidement, peuvent créer des textes, des images, de la musique et d'autres médias réalistes.

La programmation de l'IA se concentre sur les compétences cognitives suivantes :

- L'apprentissage. Cet aspect de la programmation de l'IA se concentre sur l'acquisition de données et la création de règles pour les transformer en informations exploitables. Les règles, appelées algorithmes, fournissent aux dispositifs informatiques des instructions étape par étape sur la manière d'effectuer une tâche spécifique.

- Raisonnement. Cet aspect de la programmation de l'IA se concentre sur le choix du bon algorithme pour atteindre un résultat souhaité.

- L'autocorrection. Cet aspect de la programmation de l'IA est conçu pour affiner continuellement les algorithmes et s'assurer qu'ils fournissent les résultats les plus précis possibles.

- Créativité. Cet aspect de l'IA utilise des réseaux neuronaux, des systèmes basés sur des règles, des méthodes statistiques et d'autres techniques d'IA pour générer de nouvelles images, de nouveaux textes, de nouvelles musiques et de nouvelles idées.

Différences entre l'IA, l'apprentissage automatique et l'apprentissage profond

L'IA, l'apprentissage automatique et l'apprentissage profond sont des termes courants dans l'informatique d'entreprise et parfois utilisés de manière interchangeable, en particulier par les entreprises dans leurs documents marketing. Mais il existe des distinctions. Le terme "IA", inventé dans les années 1950, fait référence à la simulation de l'intelligence humaine par des machines. Il recouvre un ensemble de capacités en constante évolution au fur et à mesure que de nouvelles technologies sont développées. Les technologies qui relèvent de l'IA comprennent l'apprentissage automatique et l'apprentissage profond.

L'apprentissage automatique permet aux applications logicielles de devenir plus précises dans la prédiction des résultats sans être explicitement programmées pour le faire. Les algorithmes d'apprentissage automatique utilisent des données historiques pour prédire de nouvelles valeurs de sortie. Cette approche est devenue beaucoup plus efficace avec l'apparition de grands ensembles de données sur lesquels s'entraîner. L'apprentissage profond, un sous-ensemble de l'apprentissage automatique, est basé sur notre compréhension de la structure du cerveau. L'utilisation par l'apprentissage profond de la structure des réseaux neuronaux artificiels est à la base des récentes avancées en matière d'IA, notamment les voitures auto-conduites et ChatGPT développé par OpenAI.

Pourquoi l'intelligence artificielle est-elle importante ?

L'IA est importante en raison de son potentiel à changer notre façon de vivre, de travailler et de jouer. Elle a été utilisée efficacement dans les entreprises pour automatiser les tâches effectuées par les humains, notamment le service à la clientèle, la génération de prospects, la détection des fraudes et le contrôle de la qualité. Dans un certain nombre de domaines, l'IA peut accomplir des tâches bien mieux que les humains. En particulier lorsqu'il s'agit de tâches répétitives et détaillées, comme l'analyse d'un grand nombre de documents juridiques pour s'assurer que les champs pertinents sont correctement remplis, les outils d'IA accomplissent souvent le travail rapidement et avec relativement peu d'erreurs. Grâce aux ensembles de données massives qu'elle peut traiter, l'IA peut également fournir aux entreprises des informations sur leurs opérations dont elles n'auraient peut-être pas eu connaissance. La population d'outils d'IA générative, qui se développe rapidement, sera importante dans des domaines allant de l'éducation et du marketing à la conception de produits.

En effet, les progrès des techniques d'IA ont non seulement contribué à alimenter une explosion de l'efficacité, mais ont également ouvert la porte à des opportunités commerciales entièrement nouvelles pour certaines grandes entreprises. Avant la vague actuelle d'IA, il aurait été difficile d'imaginer l'utilisation d'un logiciel informatique pour mettre en relation des passagers et des taxis, mais Uber est devenue une entreprise classée au Fortune 500 en faisant exactement cela.

L'IA est devenue essentielle pour de nombreuses entreprises parmi les plus grandes et les plus prospères d'aujourd'hui, notamment Alphabet, Apple, Microsoft et Meta, où les technologies de l'IA sont utilisées pour améliorer les opérations et devancer les concurrents. Chez Google, filiale d'Alphabet, par exemple, l'IA est au cœur de son moteur de recherche, des voitures autonomes de Waymo et de Google Brain, qui a inventé l'architecture de réseau neuronal transformateur qui sous-tend les récentes percées dans le traitement du langage naturel.

Quels sont les avantages et les inconvénients de l'intelligence artificielle ?

Les réseaux de neurones artificiels et les technologies d'apprentissage profond de l'IA évoluent rapidement, principalement parce que l'IA peut traiter de grandes quantités de données beaucoup plus rapidement et faire des prédictions plus précises qu'il n'est humainement possible de le faire.

Alors que l'énorme volume de données créées quotidiennement aurait de quoi décourager un chercheur humain, les applications d'IA utilisant l'apprentissage automatique peuvent prendre ces données et les transformer rapidement en informations exploitables. À ce jour, l'un des principaux inconvénients de l'IA est que le traitement des grandes quantités de données que la programmation de l'IA requiert est coûteux. À mesure que les techniques d'IA sont intégrées dans un plus grand nombre de produits et de services, les organisations doivent également être attentives au potentiel de l'IA à créer des systèmes biaisés et discriminatoires, intentionnellement ou par inadvertance.

Avantages de l'IA

Voici quelques avantages de l'IA.

- Ils sont doués pour les tâches minutieuses. L'IA s'est révélée aussi bonne, voire meilleure, que les médecins pour diagnostiquer certains cancers, notamment le cancer du sein et le mélanome.

- Réduction du temps consacré aux tâches nécessitant beaucoup de données. L'IA est largement utilisée dans les secteurs à forte densité de données, notamment dans la banque et les valeurs mobilières, l'industrie pharmaceutique et l'assurance, afin de réduire le temps nécessaire à l'analyse des grands ensembles de données. Les services financiers, par exemple, utilisent couramment l'IA pour traiter les demandes de prêt et détecter les fraudes.

- Économie de main-d'œuvre et augmentation de la productivité. L'automatisation des entrepôts en est un exemple : elle s'est développée pendant la pandémie et devrait s'intensifier avec l'intégration de l'IA et de l'apprentissage automatique.

- Des résultats cohérents. Les meilleurs outils de traduction assistée par ordinateur offrent des niveaux élevés de cohérence, permettant même aux petites entreprises de toucher leurs clients dans leur langue maternelle.

- Elle peut améliorer la satisfaction des clients grâce à la personnalisation. L'IA peut personnaliser le contenu, les messages, les publicités, les recommandations et les sites web en fonction des clients.

- Les agents virtuels alimentés par l'IA sont toujours disponibles. Les programmes d'IA n'ont pas besoin de dormir ou de faire des pauses, ce qui leur permet d'offrir un service 24 heures sur 24 et 7 jours sur 7.

Inconvénients de l'IA

Voici quelques inconvénients de l'IA.

- Coûteux.

- Nécessite une expertise technique approfondie.

- L'offre limitée de travailleurs qualifiés pour construire des outils d'IA.

- Reflète les biais de ses données d'apprentissage, à grande échelle.

- Manque de capacité à généraliser d'une tâche à l'autre.

- Élimine les emplois humains, augmentant ainsi les taux de chômage.

IA forte contre IA faible

L'IA peut être classée comme faible ou forte.

- L'IA faible, également connue sous le nom d'IA étroite, est conçue et formée pour accomplir une tâche spécifique. Les robots industriels et les assistants personnels virtuels, tels que Siri d'Apple, utilisent l'IA faible.

- L'IA forte, également connue sous le nom d'intelligence générale artificielle (AGI), décrit une programmation capable de reproduire les capacités cognitives du cerveau humain. Lorsqu'il est confronté à une tâche inconnue, un système d'IA forte peut utiliser la logique floue pour appliquer les connaissances d'un domaine à un autre et trouver une solution de manière autonome. En théorie, un programme d'IA forte devrait être capable de réussir à la fois le test de Turing et l'argument de la chambre chinoise.

Quels sont les 4 types d'intelligence artificielle ?

Arend Hintze, professeur adjoint de biologie intégrative, d'informatique et d'ingénierie à l'université d'État du Michigan, a expliqué que l'IA peut être classée en quatre catégories, en commençant par les systèmes intelligents spécifiques à une tâche qui sont largement utilisés aujourd'hui et en progressant jusqu'aux systèmes sensibles, qui n'existent pas encore. Les catégories sont les suivantes.

- Type 1 : machines réactives. Ces systèmes d'IA n'ont pas de mémoire et sont spécifiques à une tâche. Deep Blue, le programme d'échecs d'IBM qui a battu Garry Kasparov dans les années 1990, en est un exemple. Deep Blue peut identifier les pièces d'un échiquier et faire des prédictions, mais comme il n'a pas de mémoire, il ne peut pas utiliser ses expériences passées pour éclairer ses expériences futures.

- Type 2 : Mémoire limitée. Ces systèmes d'IA disposent d'une mémoire, ce qui leur permet d'utiliser les expériences passées pour éclairer les décisions futures. Certaines fonctions de prise de décision dans les voitures autonomes sont conçues de cette manière.

- Type 3 : Théorie de l'esprit. La théorie de l'esprit est un terme de psychologie. Appliqué à l'IA, il signifie que le système possède l'intelligence sociale nécessaire pour comprendre les émotions. Ce type d'IA sera capable de déduire les intentions humaines et de prédire le comportement, une compétence nécessaire pour que les systèmes d'IA deviennent des membres à part entière des équipes humaines.

- Type 4 : conscience de soi. Dans cette catégorie, les systèmes d'IA ont un sens de soi, ce qui leur confère une conscience. Les machines dotées d'une conscience de soi comprennent leur propre état actuel. Ce type d'IA n'existe pas encore.

Quels sont les exemples de technologies d'IA et comment sont-elles utilisées aujourd'hui ?

L'IA est intégrée dans différents types de technologies. En voici sept exemples.

L'automatisation. Associés aux technologies de l'IA, les outils d'automatisation peuvent accroître le volume et les types de tâches effectuées. L'automatisation des processus robotiques (RPA), un type de logiciel qui automatise les tâches de traitement de données répétitives et basées sur des règles, traditionnellement effectuées par des humains, en est un exemple. Associée à l'apprentissage automatique et aux outils d'IA émergents, l'APR peut automatiser de plus grandes parties des tâches de l'entreprise, ce qui permet aux robots tactiques de l'APR de transmettre l'intelligence de l'IA et de répondre aux changements de processus.

Apprentissage automatique. Il s'agit de la science qui permet à un ordinateur d'agir sans programmation. L'apprentissage en profondeur est un sous-ensemble de l'apprentissage automatique qui, en termes très simples, peut être considéré comme l'automatisation de l'analyse prédictive. Il existe trois types d'algorithmes d'apprentissage automatique :

- Apprentissage supervisé. Les ensembles de données sont étiquetés de manière à ce que des modèles puissent être détectés et utilisés pour étiqueter de nouveaux ensembles de données.

- Apprentissage non supervisé. Les ensembles de données ne sont pas étiquetés et sont triés en fonction des similitudes ou des différences.

- Apprentissage par renforcement. Les ensembles de données ne sont pas étiquetés mais, après avoir effectué une ou plusieurs actions, le système d'IA reçoit un retour d'information.

La vision industrielle. Cette technologie donne à une machine la capacité de voir. La vision industrielle capture et analyse les informations visuelles à l'aide d'une caméra, d'une conversion analogique-numérique et d'un traitement du signal numérique. Elle est souvent comparée à la vue humaine, mais la vision industrielle n'est pas liée à la biologie et peut être programmée pour voir à travers les murs, par exemple. Elle est utilisée dans une série d'applications allant de l'identification de signatures à l'analyse d'images médicales. La vision par ordinateur, qui se concentre sur le traitement d'images par des machines, est souvent confondue avec la vision industrielle.

Traitement du langage naturel (NLP). Il s'agit du traitement du langage humain par un programme informatique. L'un des exemples les plus anciens et les plus connus de traitement du langage naturel est la détection du spam, qui examine l'objet et le texte d'un courrier électronique et détermine s'il s'agit d'un courrier indésirable. Les approches actuelles du NLP sont basées sur l'apprentissage automatique. Les tâches de NLP comprennent la traduction de textes, l'analyse des sentiments et la reconnaissance vocale.

Robotique. Ce domaine de l'ingénierie se concentre sur la conception et la fabrication de robots. Les robots sont souvent utilisés pour effectuer des tâches que les humains ont du mal à réaliser ou à exécuter de manière cohérente. Par exemple, les robots sont utilisés dans les chaînes de montage des voitures ou par la NASA pour déplacer de gros objets dans l'espace. Les chercheurs utilisent également l'apprentissage automatique pour construire des robots capables d'interagir dans des contextes sociaux.

Les voitures auto-conduites. Les véhicules autonomes utilisent une combinaison de vision artificielle, de reconnaissance d'images et d'apprentissage profond pour développer des compétences automatisées afin de piloter un véhicule tout en restant dans une voie donnée et en évitant les obstacles inattendus, tels que les piétons.

Génération de textes, d'images et de sons. Les techniques d'IA générative, qui créent divers types de médias à partir de textes, sont largement appliquées dans les entreprises pour créer une gamme apparemment illimitée de types de contenu, de l'art photoréaliste aux réponses aux courriels en passant par les scénarios.

Quelles sont les applications de l'IA ?

L'intelligence artificielle s'est imposée dans un grand nombre de marchés. En voici 11 exemples.

L'IA dans les soins de santé. Les plus gros paris portent sur l'amélioration des résultats pour les patients et la réduction des coûts. Les entreprises appliquent l'apprentissage automatique pour établir des diagnostics médicaux meilleurs et plus rapides que ceux des humains. L'une des technologies les plus connues dans le domaine de la santé est IBM Watson. Il comprend le langage naturel et peut répondre aux questions qui lui sont posées. Le système exploite les données du patient et d'autres sources de données disponibles pour formuler une hypothèse, qu'il présente ensuite avec un système de notation de la confiance. D'autres applications de l'IA comprennent l'utilisation d'assistants de santé virtuels en ligne et de chatbots pour aider les patients et les clients du secteur de la santé à trouver des informations médicales, à prendre des rendez-vous, à comprendre le processus de facturation et à effectuer d'autres démarches administratives. Un ensemble de technologies d'IA est également utilisé pour prédire, combattre et comprendre les pandémies telles que COVID-19.

L'IA dans les entreprises. Les algorithmes d'apprentissage automatique sont intégrés dans les plateformes d'analyse et de gestion de la relation client (CRM) afin de découvrir des informations sur la manière de mieux servir les clients. Des chatbots ont été incorporés dans des sites web pour fournir un service immédiat aux clients. Les progrès rapides de la technologie d'IA générative telle que le ChatGPT devraient avoir des conséquences considérables : suppression d'emplois, révolution de la conception des produits et perturbation des modèles commerciaux.

L'IA dans l'éducation. L'IA peut automatiser la notation, ce qui permet aux éducateurs de consacrer plus de temps à d'autres tâches. Elle peut évaluer les élèves et s'adapter à leurs besoins, en les aidant à travailler à leur propre rythme. Les tuteurs de l'IA peuvent apporter un soutien supplémentaire aux élèves, en veillant à ce qu'ils restent sur la bonne voie. La technologie pourrait également modifier le lieu et la manière dont les élèves apprennent, voire remplacer certains enseignants. Comme le démontrent ChatGPT, Google Bard et d'autres grands modèles linguistiques, l'IA générative peut aider les éducateurs à élaborer des travaux de cours et d'autres supports pédagogiques et à impliquer les étudiants d'une nouvelle manière. L'arrivée de ces outils oblige également les éducateurs à repenser les devoirs et les tests des élèves et à revoir les politiques en matière de plagiat.

L'IA dans la finance. L'IA dans les applications financières personnelles, telles que Intuit Mint ou TurboTax, perturbe les institutions financières. Ces applications collectent des données personnelles et fournissent des conseils financiers. D'autres programmes, comme IBM Watson, ont été appliqués au processus d'achat d'une maison. Aujourd'hui, les logiciels d'intelligence artificielle effectuent une grande partie des transactions à Wall Street.

L'IA en droit. Dans le domaine juridique, le processus de recherche de documents (discovery) est souvent écrasant pour les humains. L'utilisation de l'IA pour automatiser les processus à forte intensité de main-d'œuvre du secteur juridique permet de gagner du temps et d'améliorer le service à la clientèle. Les cabinets d'avocats utilisent l'apprentissage automatique pour décrire les données et prédire les résultats, la vision par ordinateur pour classer et extraire les informations des documents, et le langage naturel pour interpréter les demandes d'information.

L'IA dans le divertissement et les médias. Le secteur du divertissement utilise des techniques d'IA pour la publicité ciblée, la recommandation de contenu, la distribution, la détection des fraudes, la création de scénarios et la réalisation de films. Le journalisme automatisé aide les salles de rédaction à rationaliser les flux de travail des médias en réduisant le temps, les coûts et la complexité. Les salles de rédaction utilisent l'IA pour automatiser les tâches de routine, telles que la saisie de données et la relecture, ainsi que pour rechercher des sujets et aider à la rédaction des titres. La question de savoir comment le journalisme peut utiliser de manière fiable le ChatGPT et d'autres IA génératives pour générer du contenu reste ouverte.

L'IA dans le codage des logiciels et les processus informatiques. De nouveaux outils d'IA générative peuvent être utilisés pour produire du code d'application à partir d'invites en langage naturel, mais ces outils n'en sont qu'à leurs débuts et il est peu probable qu'ils remplacent bientôt les ingénieurs en logiciel. L'IA est également utilisée pour automatiser de nombreux processus informatiques, notamment la saisie de données, la détection des fraudes, le service client, la maintenance prédictive et la sécurité.

Sécurité. L'IA et l'apprentissage automatique figurent en tête de la liste des mots à la mode que les fournisseurs de sécurité utilisent pour commercialiser leurs produits, de sorte que les acheteurs doivent faire preuve de prudence. Néanmoins, les techniques d'IA sont appliquées avec succès à de nombreux aspects de la cybersécurité, notamment la détection des anomalies, la résolution du problème des faux positifs et l'analyse des menaces comportementales. Les organisations utilisent l'apprentissage automatique dans les logiciels de gestion des informations et des événements de sécurité (SIEM) et les domaines connexes pour détecter les anomalies et identifier les activités suspectes qui indiquent des menaces. En analysant les données et en utilisant la logique pour identifier les similitudes avec des codes malveillants connus, l'IA peut fournir des alertes sur les attaques nouvelles et émergentes bien plus tôt que les employés humains et les itérations technologiques précédentes.

L'IA dans l'industrie manufacturière. L'industrie manufacturière a été à l'avant-garde de l'intégration des robots dans le flux de travail. Par exemple, les robots industriels qui étaient autrefois programmés pour effectuer des tâches uniques et séparés des travailleurs humains, fonctionnent de plus en plus comme des cobots : Des robots plus petits et multitâches qui collaborent avec les humains et assument la responsabilité d'un plus grand nombre de tâches dans les entrepôts, les usines et d'autres espaces de travail.

L'IA dans le secteur bancaire. Les banques utilisent avec succès les chatbots pour sensibiliser leurs clients aux services et aux offres et pour traiter les transactions qui ne nécessitent pas d'intervention humaine. Les assistants virtuels d'IA sont utilisés pour améliorer et réduire les coûts de mise en conformité avec les réglementations bancaires. Les organismes bancaires utilisent l'IA pour améliorer leur prise de décision en matière de prêts, fixer des limites de crédit et identifier les opportunités d'investissement.

L'IA dans les transports. Outre le rôle fondamental de l'IA dans le fonctionnement des véhicules autonomes, les technologies de l'IA sont utilisées dans les transports pour gérer le trafic, prévoir les retards des vols et rendre le transport maritime plus sûr et plus efficace. Dans les chaînes d'approvisionnement, l'IA remplace les méthodes traditionnelles de prévision de la demande et des perturbations, une tendance accélérée par le COVID-19 lorsque de nombreuses entreprises ont été prises au dépourvu par les effets d'une pandémie mondiale sur l'offre et la demande de marchandises.

Intelligence augmentée et intelligence artificielle

Certains experts du secteur ont fait valoir que le terme "intelligence artificielle" est trop étroitement lié à la culture populaire, ce qui a conduit le grand public à avoir des attentes improbables sur la façon dont l'IA va changer le lieu de travail et la vie en général. Ils ont suggéré d'utiliser le terme "intelligence augmentée" pour faire la distinction entre les systèmes d'IA qui agissent de manière autonome - les exemples de la culture populaire comprennent Hal 9000 et Terminator - et les outils d'IA qui assistent les humains.

- L'intelligence augmentée. Certains chercheurs et spécialistes du marketing espèrent que le terme "intelligence augmentée", qui a une connotation plus neutre, aidera les gens à comprendre que la plupart des applications de l'IA seront faibles et ne feront qu'améliorer les produits et les services. Parmi les exemples, citons l'apparition automatique d'informations importantes dans les rapports de veille stratégique ou la mise en évidence d'informations importantes dans les documents juridiques. L'adoption rapide de ChatGPT et de Bard dans l'industrie indique une volonté d'utiliser l'IA pour soutenir la prise de décision humaine.

- L'intelligence artificielle. La véritable IA, ou AGI, est étroitement associée au concept de singularité technologique, un avenir régi par une superintelligence artificielle qui dépasse de loin la capacité du cerveau humain à la comprendre ou à comprendre comment elle façonne notre réalité. Cela reste du domaine de la science-fiction, bien que certains développeurs travaillent sur le problème. Beaucoup pensent que des technologies telles que l'informatique quantique pourraient jouer un rôle important pour faire de l'AGI une réalité et que nous devrions réserver l'utilisation du terme "IA" à ce type d'intelligence générale.

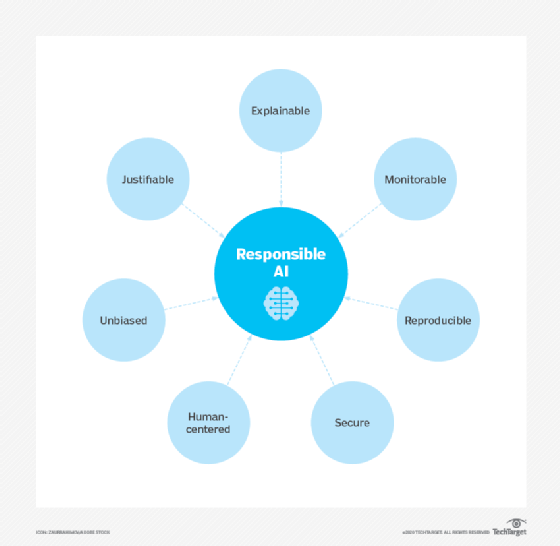

Utilisation éthique de l'intelligence artificielle

Si les outils d'IA offrent une série de nouvelles fonctionnalités aux entreprises, l'utilisation de l'IA soulève également des questions éthiques car, pour le meilleur ou pour le pire, un système d'IA renforcera ce qu'il a déjà appris.

Cela peut être problématique car les algorithmes d'apprentissage automatique, qui sont à la base de la plupart des outils d'IA les plus avancés, ne sont pas plus intelligents que les données qui leur sont fournies lors de la formation. Comme c'est un être humain qui sélectionne les données utilisées pour former un programme d'IA, le risque de biais liés à l'apprentissage automatique est inhérent et doit être surveillé de près.

Toute personne souhaitant utiliser l'apprentissage automatique dans le cadre de systèmes réels en production doit tenir compte de l'éthique dans ses processus de formation à l'IA et s'efforcer d'éviter les préjugés. Cela est particulièrement vrai lors de l'utilisation d'algorithmes d'IA qui sont intrinsèquement inexplicables dans les applications d'apprentissage profond et de réseaux adversaires génératifs (GAN).

L'explicabilité est un obstacle potentiel à l'utilisation de l'IA dans les secteurs qui sont soumis à des exigences strictes en matière de conformité réglementaire. Par exemple, les institutions financières aux États-Unis sont soumises à des réglementations qui les obligent à expliquer leurs décisions en matière d'octroi de crédit. Or, lorsqu'une décision de refus de crédit est prise par un programme d'IA, il peut être difficile d'expliquer comment la décision a été prise, car les outils d'IA utilisés pour prendre de telles décisions fonctionnent en établissant des corrélations subtiles entre des milliers de variables. Lorsque le processus de prise de décision ne peut être expliqué, le programme peut être qualifié d'IA "boîte noire".

En résumé, les défis éthiques de l'IA sont les suivants :

- Biais dus à des algorithmes mal formés et à des biais humains.

- Mauvais usage dû aux "deepfakes" et à l'hameçonnage.

- Préoccupations juridiques, y compris les questions de diffamation et de droits d'auteur en matière d'IA.

- Suppression d'emplois en raison des capacités croissantes de l'IA.

- les préoccupations relatives à la confidentialité des données, en particulier dans les secteurs de la banque, des soins de santé et du droit.

Gouvernance et réglementation de l'IA

Malgré les risques potentiels, il existe actuellement peu de réglementations régissant l'utilisation des outils d'IA, et lorsque des lois existent, elles concernent généralement l'IA de manière indirecte. Par exemple, comme indiqué précédemment, la réglementation américaine sur les prêts équitables exige que les institutions financières expliquent les décisions de crédit aux clients potentiels. Cela limite la mesure dans laquelle les prêteurs peuvent utiliser des algorithmes d'apprentissage profond qui, par nature, sont opaques et ne peuvent être expliqués.

Le règlement général sur la protection des données (RGPD) de l'Union européenne envisage des réglementations en matière d'IA. Les limites strictes du GDPR sur la façon dont les entreprises peuvent utiliser les données des consommateurs limitent déjà la formation et la fonctionnalité de nombreuses applications d'IA orientées vers le consommateur.

Les décideurs politiques américains n'ont pas encore publié de législation sur l'IA, mais cela pourrait bientôt changer. Un "Blueprint for an AI Bill of Rights" publié en octobre 2022 par l'Office of Science and Technology Policy (OSTP) de la Maison Blanche guide les entreprises sur la manière de mettre en œuvre des systèmes d'IA éthiques. La Chambre de commerce des États-Unis a également appelé à une réglementation de l'IA dans un rapport publié en mars 2023.

Il ne sera pas facile d'élaborer des lois pour réglementer l'IA, en partie parce que l'IA comprend une variété de technologies que les entreprises utilisent à des fins différentes, et en partie parce que les réglementations peuvent se faire au détriment des progrès et du développement de l'IA. L'évolution rapide des technologies d'IA est un autre obstacle à l'élaboration d'une réglementation significative de l'IA, tout comme les défis posés par le manque de transparence de l'IA, qui fait qu'il est difficile de voir comment les algorithmes parviennent à leurs résultats. En outre, les percées technologiques et les nouvelles applications telles que ChatGPT et Dall-E peuvent rendre les lois existantes instantanément obsolètes. Et, bien sûr, les lois que les gouvernements parviennent à élaborer pour réglementer l'IA n'empêchent pas les criminels d'utiliser la technologie à des fins malveillantes.

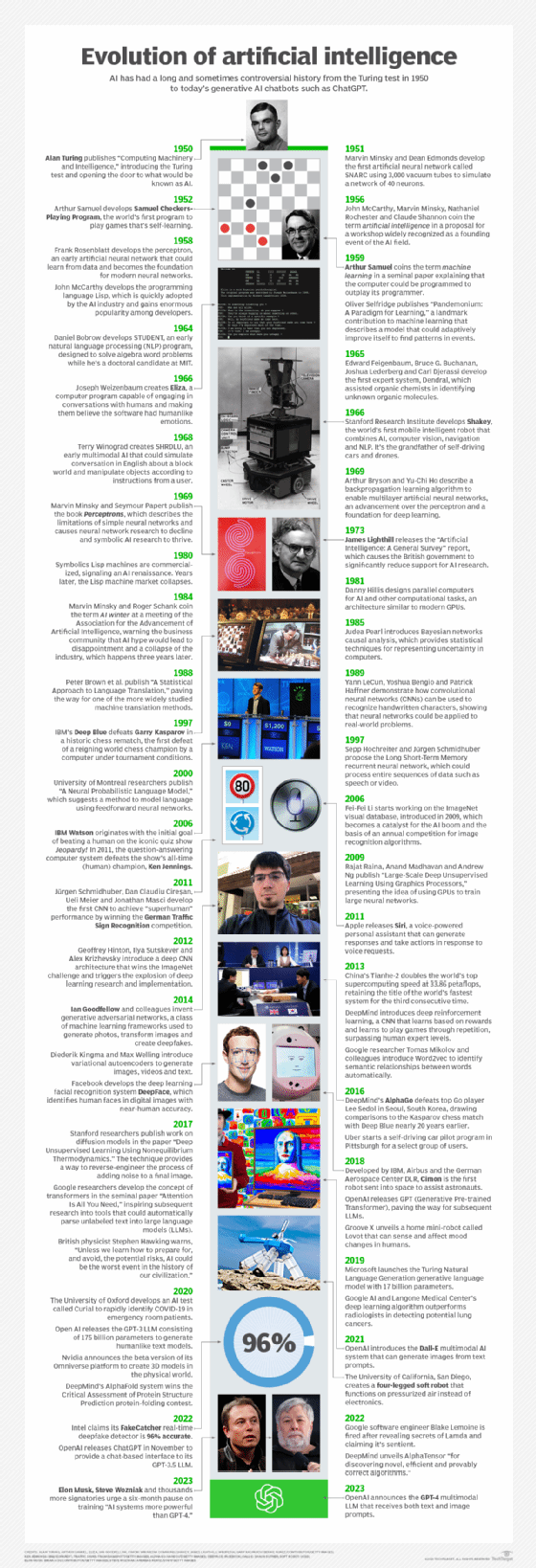

Quelle est l'histoire de l'IA ?

Le concept d'objets inanimés dotés d'intelligence existe depuis l'Antiquité. Dans les mythes, le dieu grec Héphaïstos était représenté en train de forger des serviteurs robotisés à partir d'or. Les ingénieurs de l'Égypte ancienne construisaient des statues de dieux animées par des prêtres. Au fil des siècles, des penseurs, d'Aristote au théologien espagnol du XIIIe siècle Ramon Llull, en passant par René Descartes et Thomas Bayes, ont utilisé les outils et la logique de leur époque pour décrire les processus de pensée humaine sous forme de symboles, jetant ainsi les bases de concepts d'intelligence artificielle tels que la représentation des connaissances générales.

La fin du XIXe siècle et la première moitié du XXe siècle ont vu naître les travaux fondamentaux qui allaient donner naissance à l'ordinateur moderne. En 1836, Charles Babbage, mathématicien de l'université de Cambridge, et Augusta Ada King, comtesse de Lovelace, ont inventé le premier modèle de machine programmable.

1940s. Le mathématicien de Princeton John Von Neumann a conçu l'architecture de l'ordinateur à programmes stockés, c'est-à-dire l'idée que le programme d'un ordinateur et les données qu'il traite peuvent être conservés dans la mémoire de l'ordinateur. Warren McCulloch et Walter Pitts ont quant à eux jeté les bases des réseaux neuronaux.

1950s. Avec l'avènement des ordinateurs modernes, les scientifiques ont pu tester leurs idées sur l'intelligence des machines. L'une des méthodes permettant de déterminer si un ordinateur est intelligent a été mise au point par le mathématicien britannique et décrypteur de codes pendant la Seconde Guerre mondiale, Alan Turing. Le test de Turing portait sur la capacité d'un ordinateur à tromper les personnes qui l'interrogeaient en leur faisant croire que les réponses qu'il donnait étaient celles d'un être humain.

1956. Le domaine moderne de l'intelligence artificielle est largement cité comme ayant débuté cette année lors d'une conférence d'été au Dartmouth College. Parrainée par la Defense Advanced Research Projects Agency (DARPA), la conférence a rassemblé dix sommités du domaine, dont les pionniers de l'intelligence artificielle Marvin Minsky, Oliver Selfridge et John McCarthy, à qui l'on attribue la paternité du terme "intelligence artificielle". Allen Newell, informaticien, et Herbert A. Simon, économiste, politologue et psychologue cognitif, étaient également présents. Les deux hommes ont présenté leur révolutionnaire Logic Theorist, un programme informatique capable de prouver certains théorèmes mathématiques et considéré comme le premier programme d'intelligence artificielle.

Années 1950 et 1960. À la suite de la conférence du Dartmouth College, les leaders du domaine naissant de l'IA ont prédit qu'une intelligence artificielle équivalente au cerveau humain était sur le point de voir le jour, ce qui a attiré un soutien important de la part des gouvernements et de l'industrie. Par exemple, à la fin des années 1950, Newell et Simon ont publié l'algorithme GPS (General Problem Solver), qui ne permettait pas de résoudre des problèmes complexes, mais qui a jeté les bases du développement d'architectures cognitives plus sophistiquées ; et McCarthy a développé Lisp, un langage de programmation de l'IA encore utilisé aujourd'hui. Au milieu des années 1960, Joseph Weizenbaum, professeur au MIT, a mis au point ELIZA, un des premiers programmes de NLP qui a jeté les bases des chatbots d'aujourd'hui.

Les années 1970 et 1980. La réalisation de l'intelligence artificielle générale s'est avérée insaisissable, et non imminente, entravée par les limites du traitement informatique et de la mémoire, ainsi que par la complexité du problème. Les pouvoirs publics et les entreprises ont renoncé à soutenir la recherche sur l'IA, ce qui a entraîné une période de jachère de 1974 à 1980, connue sous le nom de premier "hiver de l'IA". Dans les années 1980, la recherche sur les techniques d'apprentissage profond et l'adoption par l'industrie des systèmes experts d'Edward Feigenbaum ont suscité une nouvelle vague d'enthousiasme pour l'IA, qui a été suivie d'un nouvel effondrement du financement public et du soutien de l'industrie. Le deuxième hiver de l'IA a duré jusqu'au milieu des années 1990.

1990s. L'augmentation de la puissance de calcul et l'explosion des données ont déclenché une renaissance de l'IA à la fin des années 1990, qui a ouvert la voie aux progrès remarquables de l'IA que nous connaissons aujourd'hui. La combinaison des données volumineuses et de l'augmentation de la puissance de calcul a permis des percées dans les domaines du langage naturel, de la vision par ordinateur, de la robotique, de l'apprentissage automatique et de l'apprentissage profond. En 1997, alors que les progrès de l'IA s'accéléraient, Deep Blue d'IBM a battu le grand maître russe des échecs Garry Kasparov, devenant ainsi le premier programme informatique à battre un champion du monde d'échecs.

2000s. De nouvelles avancées dans les domaines de l'apprentissage automatique, de l'apprentissage profond, du NLP, de la reconnaissance vocale et de la vision par ordinateur ont donné naissance à des produits et services qui ont façonné notre mode de vie actuel. On peut citer le lancement en 2000 du moteur de recherche de Google et le lancement en 2001 du moteur de recommandation d'Amazon. Netflix a développé son système de recommandation de films, Facebook a introduit son système de reconnaissance faciale et Microsoft a lancé son système de reconnaissance vocale pour transcrire la parole en texte. IBM a lancé Watson et Google a lancé son initiative de conduite autonome, Waymo.

2010s. La décennie 2010-2020 a été marquée par un flux constant de développements dans le domaine de l'IA. On peut citer le lancement des assistants vocaux Siri d'Apple et Alexa d'Amazon, les victoires d'IBM Watson au jeu Jeopardy, les voitures autonomes, le développement du premier réseau accusatoire génératif, le lancement de TensorFlow, le cadre d'apprentissage profond open source de Google, la fondation du laboratoire de recherche OpenAI, qui a développé le modèle de langage GPT-3 et le générateur d'images Dall-E, la défaite du champion du monde de Go Lee Sedol par AlphaGo de Google DeepMind, et la mise en œuvre de systèmes basés sur l'IA qui détectent les cancers avec un haut degré de précision.

2020s. La décennie actuelle a vu l'avènement de l'IA générative, un type de technologie d'intelligence artificielle capable de produire de nouveaux contenus. L'IA générative commence par une demande qui peut prendre la forme d'un texte, d'une image, d'une vidéo, d'un dessin, de notes de musique ou de toute autre donnée que le système d'IA peut traiter. Divers algorithmes d'IA renvoient ensuite un nouveau contenu en réponse à l'invite. Il peut s'agir d'essais, de solutions à des problèmes ou d'imitations réalistes créées à partir d'images ou de sons d'une personne. Les capacités des modèles de langage tels que ChatGPT-3, Bard de Google et Megatron-Turing NLG de Microsoft ont séduit le monde entier, mais la technologie n'en est qu'à ses débuts, comme en témoigne sa tendance à halluciner ou à fausser les réponses.

Outils et services d'IA

Les outils et services d'IA évoluent rapidement. Les innovations actuelles en matière d'outils et de services d'IA remontent au réseau neuronal AlexNet de 2012, qui a marqué le début d'une nouvelle ère d'IA haute performance reposant sur les GPU et les grands ensembles de données. Le principal changement a été la possibilité d'entraîner des réseaux neuronaux sur des quantités massives de données à l'aide de plusieurs cœurs de GPU en parallèle, de manière plus évolutive.

Au cours des dernières années, la relation symbiotique entre les découvertes de Google, Microsoft et OpenAI en matière d'IA et les innovations matérielles lancées par Nvidia ont permis d'exécuter des modèles d'IA de plus en plus vastes sur des GPU plus connectés, ce qui a entraîné des améliorations révolutionnaires en termes de performances et d'évolutivité.

La collaboration entre ces sommités de l'IA a été cruciale pour le récent succès de ChatGPT, sans parler de dizaines d'autres services d'IA révolutionnaires. Voici un aperçu des principales innovations en matière d'outils et de services d'IA.

Transformateurs. Google, par exemple, a ouvert la voie en trouvant un processus plus efficace de provisionnement de l'entraînement à l'IA sur une grande grappe de PC de base équipés de GPU. Cela a ouvert la voie à la découverte de transformateurs qui automatisent de nombreux aspects de la formation à l'IA sur des données non étiquetées.

Optimisation du matériel. Tout aussi important, les fournisseurs de matériel comme Nvidia optimisent également le microcode pour qu'il s'exécute en parallèle sur plusieurs cœurs de GPU pour les algorithmes les plus populaires. Nvidia affirme que la combinaison d'un matériel plus rapide, d'algorithmes d'IA plus efficaces, d'un réglage fin des instructions GPU et d'une meilleure intégration des centres de données permet de multiplier par un million les performances de l'IA. Nvidia travaille également avec tous les fournisseurs de centres de cloud computing pour rendre cette capacité plus accessible en tant qu'AI-as-a-Service via les modèles IaaS, SaaS et PaaS.

Transformateurs génératifs pré-entraînés. La pile d'IA a également évolué rapidement au cours des dernières années. Auparavant, les entreprises devaient former leurs modèles d'IA à partir de zéro. De plus en plus, des fournisseurs tels que OpenAI, Nvidia, Microsoft, Google et d'autres proposent des transformateurs génératifs pré-entraînés (GPT), qui peuvent être affinés pour une tâche spécifique à un coût, une expertise et un temps considérablement réduits. Alors que certains des plus grands modèles sont estimés à 5 à 10 millions de dollars par exécution, les entreprises peuvent affiner les modèles résultants pour quelques milliers de dollars. Cela permet d'accélérer la mise sur le marché et de réduire les risques.

les services d'IA dans le cloud. Parmi les principaux obstacles qui empêchent les entreprises d'utiliser efficacement l'IA dans leurs activités figurent les tâches d'ingénierie et de science des données nécessaires pour intégrer les capacités de l'IA dans de nouvelles applications ou pour en développer de nouvelles. Tous les principaux fournisseurs de cloud computing déploient leurs propres offres d'IA en tant que service pour rationaliser la préparation des données, le développement de modèles et le déploiement d'applications. Parmi les principaux exemples, citons AWS AI Services, Google Cloud AI, la plateforme Microsoft Azure AI, les solutions IBM AI et Oracle Cloud Infrastructure AI Services.

Modèles d'IA de pointe en tant que service. Les principaux développeurs de modèles d'IA proposent également des modèles d'IA de pointe sur ces services cloud. OpenAI possède des dizaines de grands modèles de langage optimisés pour le chat, le NLP, la génération d'images et la génération de code, qui sont fournis via Azure. Nvidia a adopté une approche plus agnostique en vendant une infrastructure d'IA et des modèles fondamentaux optimisés pour le texte, les images et les données médicales, disponibles auprès de tous les fournisseurs de services cloud. Des centaines d'autres acteurs proposent également des modèles personnalisés pour divers secteurs et cas d'utilisation.

George Lawton a également contribué à cet article.