Intel dévoile la 3ème génération de Xeon SP

Multipliant par deux la bande passante entre les sockets et disposant d’attributs qui favorisent l’intelligence artificielle, ces nouveaux Xeon équiperont les serveurs à quatre et huit processeurs.

Intel dévoile ces jours-ci sa nouvelle génération de Xeon, ses processeurs pour serveurs. Leurs améliorations sont similaires à celles vues en avril dernier sur les gammes Core pour PC portables : on conserve encore et toujours une gravure en 14 nm avec un maximum de 28 cœurs, mais la fréquence augmente – la plupart font des pointes à 4,3 GHz contre 3,8 sur la génération précédente – et de nouveaux attributs font leur apparition pour accélérer les algorithmes d’intelligence artificielle.

Par ailleurs, ces Xeon sont lancés cette semaine s’accompagnent d’un lot de nouveaux équipements périphériques. Il s’agit des mémoires Optane DC PMM 200 de seconde génération, 25% plus véloces que les précédentes. Mais aussi des SSD NVMe D7-P5500 et D7-P5600 avec 96 couches de NAND 3D TLC, qui atteignent 70 Go/s en lecture quand on les branche sur un bus PCIe 4.0. Et enfin d’une carte accélératrice Stratix 10NX à base de FPGA qui exécuterait des algorithmes de Machine Learning 15 plus rapidement que la précédente carte Stratix 10MX à base de DSP.

Des Xeon toujours en PCIe 3.0 pour les serveurs haut de gamme

Concernant les nouveaux Xeon eux-mêmes, le marketing d’Intel parle de performances globales multipliées par 1,9. Mais attention : pas par rapport aux précédents Xeon, par rapport aux performances des Xeon E5v4 sortis il y a cinq ans. Selon le fournisseur, les entreprises préféreraient que l’on fasse cette comparaison-là, car les Xeon E5v4 sont censés équiper les serveurs qui arriveraient aujourd’hui en fin de vie et qu’il faudrait justement remplacer par des machines de dernière génération.

En parlant de marketing, attention aux appellations plus ou moins créatives d’Intel. Ces nouveaux Xeon sont officiellement la troisième génération de Xeon à porter l’appellation Scalable Platform (ou Xeon SP), c’est-à-dire la quatrième génération parmi les Xeon de type Skylake en 14 nm (en comptant le Xeon E3v5), soit environ la 8ème génération de Xeon depuis qu’Intel a basculé dans la nomenclature Core/Xeon, mais il est aussi autorisé de dire qu’ils sont englobés dans la 10ème génération des Core.

Un point plus important, dont parle beaucoup moins le marketing d’Intel, est que ces nouveaux Xeon ne sont toujours pas équipés de bus PCIe 4.0, lesquels sont pourtant très attendus car ils promettent, entre autres, de faire fonctionner deux fois plus rapidement les disques NVMe. Sans eux, les nouveaux SSD D7-P5500 et D7-P5600 d’Intel plafonnent à 32 Go/s ne lecture. En réalité, les bus PCIe 4.0 arriveront d’ici à la fin de l’année sur de nouveaux Xeon de type Ice Lake, cette fois-ci gravés en 10 nm.

Le marketing d’Intel précise que ces prochains Xeon, qui n’auront plus rien à voir, seront contre toute attente aussi des Xeon SP de troisième génération. LeMagIT croit comprendre qu’il était sans doute intéressant, sur le plan commercial, de donner une impression de famille unique. En effet, les Xeon lancés cette semaine ne peuvent équiper que les serveurs haut de gamme à 4 ou 8 sockets, tandis que les prochains équiperont ceux d’entrée de gamme à 1 ou 2 sockets.

Oui, c’est incompréhensible, mais reconnaissons à Intel une certaine logique : sur PC aussi, les Core Ice Lake gravés en 10nm appartiennent à la même dixième génération que les Core Skylake en 14 nm.

Avant de clore ce chapitre, voici un dernier avertissement essentiel : attention à ne pas confondre les générations de gravure Skylake et Ice Lake, avec Cooper Lake, le nom de code des nouveaux Xeon, Cascade Lake, celui des Xeon précédents, ou encore Sunny Cove, celui des prochains.

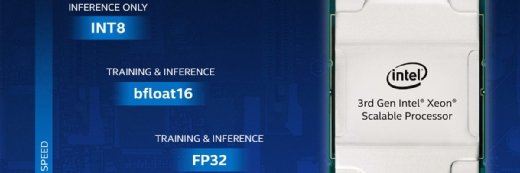

Deux fois plus de bande passante entre sockets

Dans le détail, les Xeon SP de troisième génération apportent trois nouveautés. La première est la manipulation de nombres au format bfloat16, ou BF16, dans les opérations arithmétiques. Ce format, issu de l’ASIC Nervana NNP racheté par Intel en 2016, sert à traiter des valeurs 32 bits aussi rapidement que s’il s’agissait de valeurs 16 bits, mais avec une précision deux fois moindre après la virgule.

Ce format présenterait, selon Intel, un avantage décisif dans la rapidité des algorithmes de Machine Learning, où l’on se soucie peu de ce qui se trouve après la virgule. Facebook est déjà un adepte de cette technique, au travers de sa plateforme d’entraînement Zion. De son côté, le fabricant de GPU Nvidia vient d’implanter un format numérique similaire dans son processeur de calcul A100.

La seconde nouveauté est que chaque processeur dispose de six canaux UPI pour communiquer avec ses trois congénères les plus proches, contre trois canaux précédemment. La bande passante entre deux processeurs passe donc de 10,4 GT/s à 20,8 GT/s (milliards de transferts par seconde).

Enfin, les nouveaux Xeon SP acceptent les barrettes de mémoire DDR4 en 3200 MHz, contre 2933 MHz précédemment. Selon les tests menés par Intel, cela signifie que la vitesse de lecture en RAM passe de 23,46 Go/s à 25,60 Go/s sur chacun des six canaux DDR4 d’un Xeon, soit une augmentation d’environ 9%. Toutefois, cela ne fonctionne que si une seule barrette DIMM est insérée par canal. Si deux sont installées, soit un maximum de douze par processeur, la vitesse maximale retombe à 2933 MHz.

Sur les trois Xeon qui portent la mention HL, chaque canal supporte au maximum une barrette DIM de 256 Go de RAM, plus une barrette Optane DC PMM-200 de 512 Go de capacité, soit 768 Go par canal, ce qui revient à 4,5 To de mémoire par socket et à 18 ou 36 To de mémoire par serveur. Sur les huit Xeon qui portent uniquement la mention H, la mémoire adressable par socket tombe à 1,125 To. On notera que les nouvelles barrettes Optane ont les mêmes capacités que les précédentes : 128, 256 ou 512 Go. Seule leur vitesse est meilleure : elle est 25% plus élevée.

Platinum pour 8 sockets et Gold pour 4

Un Xeon SP de troisième génération peut lire ou écrire ses données sur 48 lignes PCIe 3.0. Toutefois, le chipset développé par Intel pour accompagner les 4 ou 8 Xeon d’un serveur ne donne accès qu’à 20 lignes PCIe en simultané avec une bande passante de 8 GT/s par ligne. Les autres lignes sont routées vers les ports subalternes, comme le SATA (14 ports possibles) ou l’USB (10 ports possibles).

Onze modèles de nouveaux Xeon SP sont proposés. Les six qui portent la référence « Platinum 83xx » sont destinées aux cartes mères octosocket, tandis que les trois « Gold 63xx » et les deux « Golds 53xx » sont réservés aux serveurs quadrisocket. Les fréquences de base s’échelonnent de 2,4 à 2,9 GHz et les vitesses de pointe vont de 3,8 à 4,3 GHz. On ignore toujours combien de temps un serveur est censé tenir en vitesse de pointe : à la fréquence maximale, le processeur surchauffe et se ralentit de lui-même au bout de quelques instants.

Le nombre de cœurs varie de 16 à 28 et l’enveloppe thermique de 150 à 250 Watts. Chaque cœur étant associé à 1,375 Mo de mémoire cache, celle-ci va de 22 Mo à 38,5 Mo par processeur, selon le modèle.