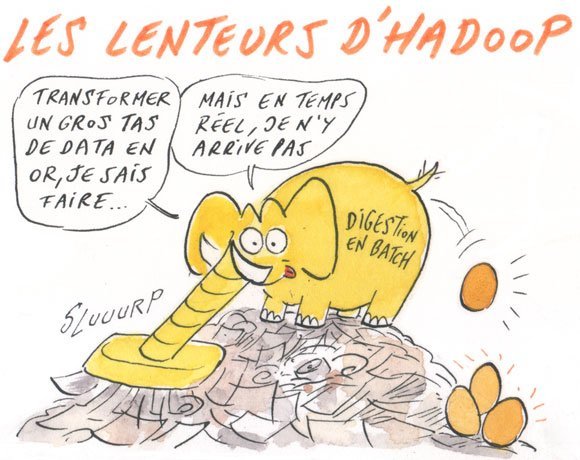

Clusters Hadoop : avantages et limites pour l'analyse des Big Data

Avec Brien Posey, découvrez les avantages substantiels des clusters Hadoop dans la prise en charge de grands volumes de données non structurées et leurs limites dans d’autres environnements.

Depuis quelques années, l’analyse du Big Data a le vent en poupe. Pourtant, de nombreuses organisations commencent à se rendre compte que leurs techniques d’exploration et d’analyse des données sont insuffisantes dans ce domaine.

Si la mise en place de clusters Hadoop est une des solutions à ce problème, elle ne convient pas à toutes les situations. Examinons quelques-uns des avantages et des inconvénients de ce type d’architecture.

Qu’est-ce qu’un cluster Hadoop ?

Un cluster Hadoop est un type de cluster spécialement conçu pour le stockage et l’analyse d’énormes volumes de données non structurées.

Fondamentalement, ce cluster informatique distribue la charge de travail de l’analyse des données sur plusieurs noeuds qui traitent les données en parallèle.

Clusters Hadoop : les avantages

Le principal atout des clusters Hadoop est leur adéquation à l’analyse de gros volumes de données. Le Big Data est le plus souvent non structuré et largement distribué.

Si le framework Hadoop convient bien à l’analyse de ce type de données, c’est en raison de son mode de fonctionnement : il fractionne les données en éléments et attribue chacun de ces éléments à un noeud donné de cluster pour analyse. Les données n’ont pas à être uniformes : chaque élément de donnée est traité par un processus distinct d’un noeud distinct du cluster.

Sur le sujet

Un autre avantage des clusters Hadoop réside dans leur évolutivité. Un des problèmes de l’analyse du Big Data est, comme pour tous les types de données, sa croissance continue.

De plus, le Big Data est surtout utile s’il est analysé en temps réel ou dans un délai aussi proche que possible du temps réel. Les capacités de traitement en parallèle de Hadoop participent à la rapidité de l’analyse (encore plus avec des projets qui visent à améliorer ses capacités "temps réel"), mais à mesure que le volume de données à analyser augmente, la puissance de traitement du cluster peut devenir insuffisante. Heureusement, l’ajout de noeuds permet de faire évoluer le framework.

Un troisième avantage de ce type d’architecture réside dans son coût. Cette affirmation peut surprendre : l’analyse du Big Data fait partie de l’informatique d’entreprise qui est traditionnellement coûteuse. Pourtant, les clusters Hadoop peuvent s’avérer une solution économique.

Ceux-ci sont généralement peu onéreux pour deux raisons. D’abord, le logiciel requis est open source. La distribution Apache Hadoop est même proposée gratuitement au téléchargement. De plus, l’utilisation de matériel standard contribue à limiter les coûts d'un projet Hadoop. On peut ainsi construire un cluster puissant sans dépenser une fortune en serveurs.

Un autre avantage de ces clusters est leur résistance aux pannes. Quand un élément de donnée est envoyé à un noeud pour analyse, les données sont également copiées vers d’autres noeuds : en cas de défaillance sur un noeud, d’autres copies existent ailleurs dans le cluster et il est toujours possible de les analyser.

Argumentaire contre les clusters Hadoop

Malgré ses nombreux avantages, la solution des clusters Hadoop ne convient pas aux besoins d’analyse de données de toutes les organisations.

Pour les petits volumes de données, ses bénéfices seront inexistants, même s’il est besoin d’une analyse poussée de ces dernières.

Et aussi

Un autre inconvénient des clusters Hadoop réside dans le principe même de la solution de clustering, qui suppose que les données puissent être fractionnées et analysées par des processus parallèles exécutés sur des noeuds de cluster distincts. Si l’analyse ne peut pas se dérouler dans un environnement de traitement parallèle, un cluster Hadoop n’est tout simplement pas le bon outil pour ce travail.

Mais le plus grand obstacle à l’utilisation d’un cluster Hadoop reste probablement la courbe d’apprentissage considérable associée à la construction, au fonctionnement et à la prise en charge de la solution. À moins que votre service informatique ne compte un spécialiste de cette technologie dans ses rangs, il vous faudra quelque temps pour apprendre à construire le cluster et réaliser l’analyse requise des données. Ou alors choisir une distribution qui propose des scénarios pré-packagés.

Alors, devez-vous envisager de construire un cluster Hadoop ?

Cela dépend si vos besoins d’analyse des données correspondent aux capacités offertes par ce type d’architecture. Vous hésitez ? Vous ne savez pas si un cluster Hadoop vous serait utile ? Alors téléchargez une copie d'une distribution Hadoop (Cloudera, Hortonworks, MapR par exemple) et installez-la sur du matériel disponible pour en appréhender le fonctionnement avant de prendre la décision de construire un cluster à grande échelle.