Dossier Déduplication : faites faire une cure d’amaigrissement à vos données

La déduplication des données a fait couler beaucoup d’encre au cours des dernières années. Alors que les volumes de données primaires des entreprises continuent à progresser à un rythme rapide et que les exigences de continuité et la réglementation se traduisent par un accroissement des volumes de données sauvegardées, la déduplication apparaît comme la seule technologie à même de limiter la course à la capacité à laquelle se livrent fournisseurs et entreprises depuis plusieurs années. LeMagIT fait un point sur la technologie et ses usages ainsi que sur les principaux fournisseurs du marché.

Au sommaire de notre dossier :

1 - Déduplication : aujourd’hui pour la sauvegarde, demain pour les données primaires ?

2 - Déduplication : une appellation, plusieurs technologies

3 - La déduplication de données permet de réduire l’impact de la prolifération des machines virtuelles

4 - NetApp va revendre les appliances de déduplication et de VTL de Fujitsu

5 - Déduplication : les forces en présence

[Pour consulter l’ensemble de ce dossier téléchargez-le !]

Déduplication : Aujourd’hui pour la sauvegarde, demain pour les données primaires ?

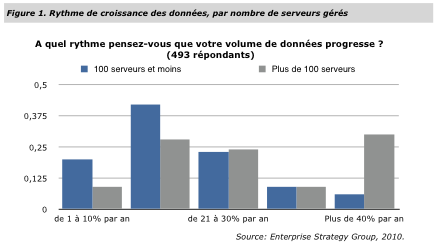

Confrontées à la croissance exponentielle de leurs données, de plus en plus d'entreprises s'intéressent de près à la déduplication une technologie qui dans ses différentes incarnations permet de supprimer les doublons dans les données stockées et résulte dans d'important gains d'espace. Aujourd'hui la déduplication tend à se généraliser dans les applications de sauvegarde mais elle ambitionne aussi d'étendre son champ d'action aux données primaires.

Même si la technologie n'est pas nouvelle, elle n'est devenue populaire que récemment du fait de la conjonction de plusieurs facteurs et notamment la crise économique, qui a amené les entreprises à tenter de réduire le coût de leur stockage, la croissance continue et exponentielle des volumes de données à stocker et l'arrivée d'une nouvelle généraiton de processeurs offrant les capacités nécessaires pour rendre les performances de la déduplication acceptables par les utilisateurs. Subitement tous les grands du stockage se sont mis à s'intéresser à la technologie à commencer par EMC, avec le rachat d'Avamar en 2006 - avant celui de DataDomain en 2009 -, puis Netapp, avec l'introduction de la déduplication à des fins d'archivage dans ses baies en mars 2007, puis IBM avec son rachat de Diligent en 2008, HP avec le lancement de StoreOnce en juin 2010 et enfin Dell avec le rachat d'Ocarina en 2010. et c'est sans compter sur Hitachi qui après avoir revendu la technologie de Diligent a récemment signé avec Falconstor, ou avec Fujitsu qui revend en OEM la technologie de Quantum dans ses appliance de sauvegarde Eternus CS.

Principale cible de ces constructeurs : le marché de la sauvegarde et de l'archivage. Du fait de la nature de ces processus qui visent à créer de multiples copie des données primaires pour se prémunir d'éventuelles pannes ou pertes de données, la déduplication se révèle particulièrement efficace sur les flux de backup (et ce d'autant plus s'il s'agit de Full backup). Mais d'autres scénarios d'utilisation de la déduplication émergent, notamment appliqués aux environnements serveurs virtualisés et aux déploiements à grande échelle de poste de travail virtualisés. Ces scénarios, qui touchent des données primaires actives et non plus des données dormantes

Retrouvez la fin de cet article et l’intégralité de notre dossier au format PDF