IA et ML : NVidia dévoile sa plate-forme d'accélération haut de gamme HGX-2

Le constructeur a profité de sa conférence développeurs de Taïwan pour dévoiler le HGX-2 sa plate-forme d'accélération de dernière génération dérivée du DGX-2 et capable d'accueillir jusqu'à 16 GPU Nvidia V100 reliés via son bus à haute performance NVLink.

Nvidia a profité de sa GPU Technology Conference de Taïwan pour annoncer la seconde génération de son châssis d’accélération HGX-1 rebaptisé pour l'occasion HGX-2. Selon NVidia, le HGX-2 est conçu pour répondre à des besoins sophistiqués en matière de calcul, d’apprentissage machine et d’intelligence artificielle des entreprises et des acteurs du cloud.

Le système se présente sous la forme d’un châssis 4U capable d’accueillir jusqu’à 16 GPU de génération Volta reliés entre eux par des commutateurs NVLink Nvidia. Le HGX-2 n’est toutefois pas un système autonome. Il est conçu pour être connecté à un serveur bi-socket Xeon pour lequel il agit comme un accélérateur à très hautes performances.

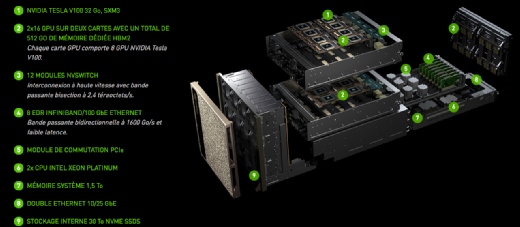

Concrètement, le HGX-2 se compose de deux châssis superposés, chacun équipé de 8 GPU Nvidia V100 interconnectés entre eux via 6 commutateurs NVSwitch. Les cartes mères des deux châssis sont elles-mêmes reliées par 48 ports NVLink. Cette architecture permet à chacun des 16 accélérateurs GPU de la plate-forme de communiquer avec les autres à un débit de 300 Go/s, soit un débit bien supérieur à celui permis par le bus PCIe.

Pour les utilisateurs familiers des architectures de NVidia, le HGX-2 n'est autre que la déclinaison désagrégée du DGX-2, un système intégré qui associe une carte mère bi-socket Xeon avec la même plate-forme que celle du HGX-2.

Nvidia offre ainsi aux utilisateurs la possibilité de choisir entre un système intégré prêt à l’emploi, le DGX-2, et un système composable combinant le HGX-2 avec le serveur x86 de leur choix. Pour les applications de machine learning, les 10 240 tensor cores du HGX-2 délivrent une performance de deux pétaflops (en opérations tensor), tandis que 81 920 cœurs CUDA produisent jusqu’à 125 teraflops (en calcul double précision - FP64).

Le HGX-2 consomme environ 10 000 W à pleine puissance et devrait être commercialisé à partir de 400 000 $.