Grace, le processeur ARM de Nvidia enfin dévoilé

Le constructeur annonce deux produits pour 2023 : le Grace CPU Superchip qui contiendra deux processeurs totalisant 144 cœurs, tandis que le Grace Hopper Superchip aura un processeur accolé à un nouveau GPU.

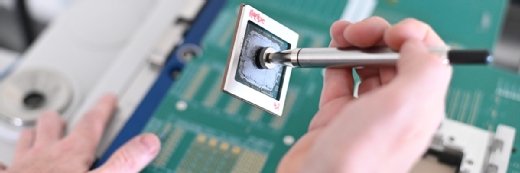

Nvidia a dévoilé la famille de processeurs ARM Grace qu’il avait annoncée il y a un an. Deux modèles, attendus pour l’année prochaine, ont été présentés sous la forme d’une cartouche qui se clipperait sur le socket dédié d’une carte mère. Le premier, appelé Grace CPU Superchip, contient deux processeurs Grace qui totalisent 144 cœurs Neoverse N2, ces cœurs qu’ARM a spécialement dessinés pour exécuter des algorithmes de supercalcul. Le second, appelé Grace Hopper Superchip, réunit un processeur Grace de 72 cœurs et un GPU appelé Hopper.

Dans les deux cas, les deux composants sont gravés avec une finesse de 5 nm et communiquent entre eux via un bus NVLink-Chip-2-Chip (C2C) propriétaire. Celui-ci serait capable de véhiculer 900 Go/s. Nividia avance que son nœud de supercalcul DGX A100 équipé d’un CPU Superchip serait 50 % plus performant que l’actuel DGX A100 haut de gamme équipé de deux processeurs AMD Epyc 7742 (qui totalisent, ensemble, 128 cœurs). Chaque processeur Grace pourrait accéder à 512 Go de RAM LPDDR5X (en l’occurrence 8 blocs de 64 Go chacun) et le GPU Hopper serait pour sa part capable d’adresser 80 Go de RAM HBM3.

Nvidia n’a ni communiqué sur la fréquence en GHz de ses nouveaux modules de calcul ni sur leurs performances en teraFLOPs. Ces annonces ont été formulées lors de l’événement GTC 2022 organisé cette semaine par le constructeur.

Des cœurs Neoverse N2

Les cœurs Neoverse N2 sont des cœurs ARM 64 bits qui supportent le dernier jeu d’instruction Arm v9, lequel apporte notamment des instructions de calculs en matrices, utiles dans les algorithmes de simulation et de Machine Learning. L’implémentation de ces instructions directement dans les circuits permettrait d’exécuter entre 40 et 50 % plus rapidement ce type d’applicatifs comparativement aux cœurs Neoverse 1.

Les cœurs Neoverse N1 équipent à l’heure actuelle les processeurs ARM Graviton 2 qu’AWS a lui-même fabriqués pour les serveurs de son cloud public et les processeurs Ampere Altra qu’Oracle et Azure utilisent sur les serveurs de leurs clouds respectifs. On devrait par ailleurs retrouver des cœurs Neoverse au sein du Rhea, le futur processeur « made in Europe » que l’entreprise SiPearl a dessiné pour équiper les supercalculateurs de l’UE avec un ARM souverain. Selon les dernières informations connues, il s’agirait dans ce cas de la déclinaison Neoverse V1, contemporaine de la révision Neoverse N2. À date, seul AWS a annoncé qu’il utiliserait des cœurs Neoverse N2 pour son futur processeur Graviton 3.

Les autres innovations des cœurs Neoverse N2 concernent une optimisation des accès mémoire, favorisant à la fois les échanges en parallèle et l’économie d’énergie. De ce que LeMagIt croit comprendre, les cœurs Neoverse N2 se gêneraient mutuellement moins pour accéder aux données en mémoire et auraient moins besoin de mémoire cache, comparativement à un processeur x86.

Enfin, les cœurs Neoverse N2 sont les premiers ARM compatibles avec les mémoires DDR5 et les bus PCIe 5.0. La bande passante de la mémoire DDR5 sera de 300 Go/s par bloc, contre environ 200 Go/s par bloc de DDR4. Le bus PCIe 5.0 supporterait quant à lui 2,5 Go/s par canal, contre 1,25 Go/s par canal en PCIe 4.0. Une carte GPU utilise généralement 16 canaux en parallèle et un SSD NVMe utilise 2 ou 4 canaux en parallèle.

Un GPU à 700 watts

Concernant le GPU Hopper. Également fabriqué par TSMC avec une finesse de gravure de 5 nanomètres – que TSMC appelle un peu trompeusement « N4 » – ce GPU contient 16 896 unités de traitement CUDA et 528 unités Tensor, plus 50 Mo de mémoire cache. Ces éléments sont répartis sur 132 circuits gravés côte à côte.

Le GPU Hopper succède au GPU Ampere (rien à voir avec le fabricant des processeurs Astra) que l’on trouvait sur les cartes accélératrices A100, notamment utilisées dans les nœuds de supercalcul DGX A100 de Nvidia. Comparativement, l’A100 est constitué de 108 circuits qui totalisent 6 912 unités de traitement CUDA, 432 unités Tensor et 40 Mo de cache.

Selon les premières informations livrées par Nvidia, Hopper aurait le défaut de consommer bien plus d’énergie que son prédécesseur, soit 700 watts contre 400 watts pour l’A100. Il serait toutefois prévu un mode économique en 350 watts où une vingtaine de circuits seraient désactivés, ramenant le nombre d’unités CUDA et Tensor à 14 592 et 456, respectivement, et la puissance globale à 24 teraFLOPS.

Il est à noter que Nvidia compte commercialiser d’ici à la fin de l’année ce GPU sur une carte dépourvue de processeur Grace, la H100. Cette carte a vocation à remplacer l’A100 dans de nouveaux nœuds de supercalcul qui seraient rebaptisés DGX H100. À date, on ignore si le DGX H100 reposera aussi sur le Grace CPU Superchip, ou s’il s’agira d’autre chose.

Un bus d’interconnexion à 900 Go/s entre huit puces

Le CPU Superchip composé de deux processeurs Grace embarquerait 396 Mo de mémoire cache et communiquerait avec la RAM DDR5 à la vitesse cumulée de 1 To/s. Selon un benchmark SPECrate_2017_int_base effectué par NVidia lui-même, le Superchip atteindrait le score de 740, ce qui correspond effectivement 1,5 fois le score de deux AMD Epyc 7742 de seconde génération. Pour autant, les Epyc ont entretemps évolué en une troisième génération qui, selon AMD, atteindrait un score de 420 pour un seul processeur.

Le bus NVLink-C2C mis au point pour l’occasion devrait à terme se standardiser sur tous les produits Nvidia, notamment sur ses cartes GPU, mais aussi ses cartes DPU. Le constructeur aurait même l’intention d’en partager les spécifications afin que des tiers puissent assembler des cartes accélératrices comprenant une puce Nvidia et d’autres composants spécialisés (ASIC, FPGA…). On notera que le NVLink-C2C vient concurrencer la tentative de standard UCIe sur laquelle Intel, AMD, Samsung et ARM se sont mis d’accord pour interconnecter des puces.

Selon les premières informations de Nvidia, il serait possible d’enchaîner jusqu’à 8 puces – processeur Grace, GPU Hopper, ou autres – autour d’un même bus NVLink-C2C, avant de passer par une interconnexion sur bus PCIe 5.0.

Le bus NVLink-C2C succède en l’occurrence au bus NVLink 3 qui servait à connecter jusqu’à huit cartes A100 dans le nœud de supercalcul DGX A100. La bande passante du NVLink 3 était de 600 Go/s. On trouve aussi le NVLink 3 sur le module HGX A100, en l’occurrence un nœud DGX dépourvu de processeur et qui s’ajoute à un serveur via une connexion PCIe 4.0. Il est probable que NVLink-C2C serve de la même manière à construire des modules HGX H100 comprenant huit GPU Hoper à connecter en PCIe 5.0, sur des serveurs qui supporteront ce bus.