Qualité des données

Qu'est-ce que la qualité des données ?

La qualité des données est une mesure de l'état d'un ensemble de données basée sur des facteurs tels que l'exactitude, l'exhaustivité, la cohérence, la fiabilité et la validité. La mesure de la qualité des données peut aider les organisations à identifier les erreurs et les incohérences dans leurs données et à évaluer si les données correspondent à l'objectif visé.

Les organisations se préoccupent de plus en plus de la qualité des données, car elles ont pris conscience du rôle important que jouent les données dans les opérations commerciales et les analyses avancées, qui sont utilisées pour prendre des décisions. La gestion de la qualité des données est un élément essentiel de la stratégie globale de gouvernance des données d'une organisation.

La gouvernance des données garantit que les données sont correctement stockées, gérées, protégées et utilisées de manière cohérente dans l'ensemble de l'organisation.

Pourquoi la qualité des données est-elle si importante ?

Des données de mauvaise qualité peuvent avoir des conséquences importantes pour une organisation. Les mauvaises données sont souvent à l'origine de problèmes opérationnels, d'analyses inexactes et de stratégies commerciales mal conçues. Elles peuvent, par exemple, être à l'origine des problèmes suivants :

- Expédition de produits à des adresses erronées.

- Manquer des opportunités de vente en raison de dossiers clients erronés ou incomplets.

- être condamné à une amende pour avoir établi des rapports financiers ou de conformité réglementaire inappropriés.

En 2021, le cabinet de conseil Gartner a déclaré que la mauvaise qualité des données coûtait en moyenne 12,9 millions de dollars par an aux organisations. Un autre chiffre encore souvent cité provient d'IBM, qui a estimé que les problèmes de qualité des données aux États-Unis ont coûté 3,1 billions de dollars en 2016. Et dans un article qu'il a écrit pour la MIT Sloan Management Review en 2017, le consultant en qualité des données Thomas Redman a estimé que la correction des erreurs de données et la gestion des problèmes commerciaux causés par les mauvaises données coûtent aux entreprises en moyenne 15 à 25 % de leur chiffre d'affaires annuel.

En outre, le manque de confiance dans les données de la part des dirigeants d'entreprise et des chefs d'entreprise est souvent cité comme l'un des principaux obstacles à l'utilisation des outils de veille stratégique et d'analyse pour améliorer la prise de décision dans les organisations. Dans le même temps, les volumes de données augmentent à une vitesse stupéfiante et les données sont plus diversifiées que jamais. Il n'a jamais été aussi important pour une organisation de mettre en œuvre une stratégie efficace de gestion de la qualité des données.

Quels sont les six éléments de la qualité des données ?

Des données de mauvaise qualité peuvent entraîner des problèmes de traitement des transactions dans les systèmes opérationnels et des résultats erronés dans les applications analytiques. Ces données doivent être identifiées, documentées et corrigées pour garantir que les dirigeants d'entreprise, les analystes de données et les autres utilisateurs travaillent avec des informations de qualité. Les données de haute qualité doivent posséder les six caractéristiques suivantes :

- Exactitude. Les données représentent correctement les entités ou les événements qu'elles sont censées représenter, et elles proviennent de sources vérifiables et dignes de confiance.

- Cohérence. Les données sont uniformes d'un système à l'autre et d'un ensemble de données à l'autre, et il n'y a pas de conflit entre les mêmes valeurs de données dans différents systèmes ou ensembles de données.

- Validité. Les données sont conformes aux règles et paramètres définis par l'entreprise, qui garantissent que les données sont correctement structurées et contiennent les valeurs qu'elles devraient contenir.

- L'exhaustivité. Les données comprennent toutes les valeurs et tous les types de données qu'elles sont censées contenir, y compris toutes les métadonnées qui devraient accompagner les ensembles de données.

- L'actualité. Les données sont à jour (par rapport à leurs exigences spécifiques) et peuvent être utilisées au moment voulu.

- Unicité. Les données ne contiennent pas de doublons au sein d'un même ensemble de données et chaque enregistrement peut être identifié de manière unique.

Un ensemble de données qui répond à toutes ces mesures est beaucoup plus fiable et digne de confiance qu'un ensemble qui n'y répond pas. Toutefois, ce ne sont pas nécessairement les seules normes que les organisations utilisent pour évaluer leurs ensembles de données. Par exemple, elles peuvent également prendre en compte des qualités telles que l'adéquation, la crédibilité, la pertinence, la fiabilité ou la facilité d'utilisation. L'objectif est de s'assurer que les données correspondent à l'objectif visé et qu'elles sont dignes de confiance.

Les avantages d'une bonne qualité des données

D'un point de vue financier, le maintien d'une qualité élevée des données permet aux organisations de réduire les coûts liés à l'identification et à la correction des données erronées lorsqu'un problème lié aux données survient. Le maintien de la qualité des données permet également d'éviter les erreurs opérationnelles et les ruptures de processus, qui peuvent augmenter les dépenses d'exploitation et réduire les revenus.

En outre, une bonne qualité des données augmente la précision des analyses, y compris celles qui s'appuient sur les technologies d'intelligence artificielle (IA). Cela peut conduire à de meilleures décisions commerciales, qui à leur tour peuvent conduire à l'amélioration des processus internes, à des avantages concurrentiels et à une augmentation des ventes. Des données de bonne qualité améliorent également les informations disponibles dans les tableaux de bord BI et autres outils d'analyse. Si les utilisateurs professionnels considèrent que les analyses sont dignes de confiance, ils seront plus enclins à s'y fier plutôt que de fonder leurs décisions sur leur intuition ou sur de simples feuilles de calcul.

Une gestion efficace de la qualité des données permet également aux équipes chargées des données de se concentrer sur des tâches plus productives, plutôt que sur la résolution des problèmes et le nettoyage des données lorsque des problèmes surviennent. Par exemple, elles peuvent consacrer plus de temps à aider les utilisateurs professionnels et les analystes de données à tirer profit des données disponibles tout en promouvant les meilleures pratiques en matière de qualité des données dans les activités de l'entreprise.

Évaluer la qualité des données

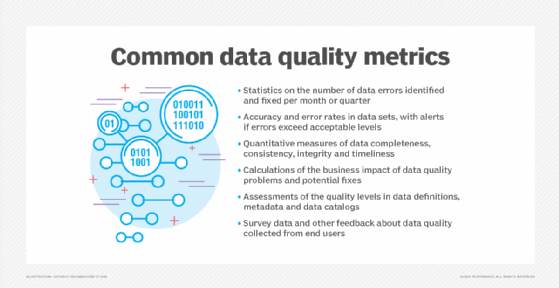

Pour commencer à évaluer la qualité des données, les organisations dressent généralement l'inventaire de leurs données et mènent des études de référence pour mesurer la précision, l'unicité et la validité relatives de chaque ensemble de données. Les bases établies peuvent ensuite être comparées aux données sur une base continue afin de s'assurer que les problèmes existants sont traités et d'identifier de nouveaux problèmes de qualité des données.

Diverses méthodologies ont été développées pour évaluer la qualité des données. Par exemple, les gestionnaires de données de la filiale de services de santé Optum du UnitedHealth Group ont créé le Data Quality Assessment Framework (DQAF) en 2009 afin de formaliser une méthode d'évaluation de la qualité des données. Le DQAF fournit des lignes directrices pour mesurer la qualité des données sur la base de quatre dimensions : l'exhaustivité, l'actualité, la validité et la cohérence. Optum a publié les détails de ce cadre en tant que modèle possible pour d'autres organisations.

Le Fonds monétaire international (FMI), qui supervise le système monétaire mondial et prête de l'argent aux pays en difficulté économique, a également défini une méthode d'évaluation portant le même nom que celle d'Optum. Son cadre se concentre sur l'exactitude, la fiabilité, la cohérence et d'autres attributs de qualité des données statistiques que les pays membres doivent soumettre au FMI. En outre, l'Office of the National Coordinator for Health Information Technology du gouvernement américain a détaillé un cadre de qualité des données pour les données démographiques des patients collectées par les organisations de soins de santé.

Traiter les problèmes de qualité des données

Dans de nombreuses organisations, les analystes, les ingénieurs et les responsables de la qualité des données sont les premiers responsables de la correction des erreurs de données et des autres problèmes liés à la qualité des données. Ils sont collectivement chargés de trouver et de nettoyer les mauvaises données dans les bases de données et autres référentiels de données, souvent avec l'aide et le soutien d'autres professionnels de la gestion des données, notamment les gestionnaires de données et les responsables de programmes de gouvernance des données.

Une initiative de qualité des données peut également impliquer les utilisateurs professionnels, les scientifiques des données et d'autres analystes dans le processus afin de réduire le nombre de problèmes liés à la qualité des données. La participation peut être facilitée, du moins en partie, par le programme de gouvernance des données de l'organisation. En outre, de nombreuses entreprises proposent des formations aux utilisateurs finaux sur les meilleures pratiques en matière de qualité des données. Un mantra courant parmi les gestionnaires de données est que chacun dans une organisation est responsable de la qualité des données.

Pour résoudre les problèmes de qualité des données, une équipe de gestion des données crée souvent un ensemble de règles de qualité des données basées sur les exigences de l'entreprise pour les données opérationnelles et analytiques. Ces règles définissent les niveaux de qualité requis et la manière dont les données doivent être nettoyées et normalisées pour garantir l'exactitude, la cohérence et d'autres attributs de qualité des données.

Une fois les règles mises en place, une équipe de gestion des données procède généralement à une évaluation de la qualité des données, en documentant les erreurs et autres problèmes - une procédure qui peut être répétée à intervalles réguliers pour garantir la meilleure qualité de données possible.

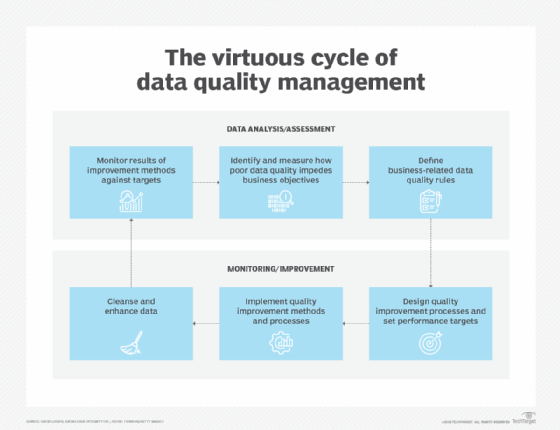

Toutes les équipes de gestion des données n'abordent pas la qualité des données de la même manière. Par exemple, David Loshin, consultant en gestion des données, a décrit un cycle de gestion de la qualité des données qui commence par l'identification et la mesure de l'impact des mauvaises données sur les activités de l'entreprise. L'équipe définit ensuite des règles de qualité des données et fixe des objectifs de performance pour améliorer les mesures de qualité des données.

Ensuite, l'équipe conçoit et met en œuvre des processus spécifiques d'amélioration de la qualité des données. Ces processus comprennent le nettoyage des données, la correction des erreurs et l'amélioration des ensembles de données en ajoutant les valeurs manquantes ou en fournissant des informations plus récentes ou des enregistrements supplémentaires.

Les résultats sont ensuite contrôlés et mesurés par rapport aux objectifs de performance. Les lacunes qui subsistent dans la qualité des données servent de point de départ à la prochaine série d'améliorations planifiées. Ce cycle vise à garantir que les efforts d'amélioration de la qualité globale des données se poursuivent après l'achèvement des projets individuels.

Outils et techniques de gestion de la qualité des données

Les organisations se tournent souvent vers des outils de gestion de la qualité des données pour rationaliser leurs efforts. Ces outils permettent de faire correspondre les enregistrements, de supprimer les doublons, de valider les nouvelles données, d'établir des politiques de remédiation et d'identifier les données personnelles dans les ensembles de données. Certains produits permettent également d'établir des profils de données, c'est-à-dire d'examiner, d'analyser et de résumer des ensembles de données.

Bon nombre de ces outils comprennent désormais des fonctions de qualité des données augmentées qui automatisent les tâches et les procédures, souvent grâce à l'utilisation de l'apprentissage automatique et d'autres technologies d'IA. La plupart des outils comprennent également des consoles ou des portails centralisés permettant d'effectuer des tâches de gestion. Par exemple, les utilisateurs peuvent être en mesure de créer des règles de traitement des données, d'identifier les relations entre les données ou d'automatiser les transformations de données par le biais de l'interface centrale.

Les responsables de la qualité des données et les gestionnaires de données peuvent également utiliser des outils de collaboration et de flux de travail qui fournissent des vues partagées des référentiels de données de l'organisation et leur permettent de superviser des ensembles de données spécifiques. Ces outils de gestion des données, ainsi que d'autres, peuvent être sélectionnés dans le cadre de la stratégie globale de gouvernance des données d'une organisation. Les outils peuvent également jouer un rôle dans les initiatives de gestion des données de référence (MDM) de l'organisation, qui établissent des registres de données de référence sur les clients, les produits, les chaînes d'approvisionnement et d'autres domaines de données.

Nouveaux défis en matière de qualité des données

Pendant de nombreuses années, les efforts en matière de qualité des données se sont concentrés sur les données structurées stockées dans des bases de données relationnelles, qui constituaient la technologie dominante pour la gestion des données. Mais les préoccupations en matière de qualité des données ont pris de l'ampleur avec la généralisation du "cloud computing" et des initiatives "big data". Outre les données structurées, les gestionnaires de données doivent désormais prendre en compte les données non structurées et les données semi-structurées, telles que les fichiers texte, les enregistrements de flux de clics sur Internet, les données de capteurs et les journaux de réseau, de système et d'application.

Un certain nombre d'autres facteurs jouent aujourd'hui un rôle dans la qualité des données, ce qui ajoute à la complexité de la gestion des données :

- Aujourd'hui, de nombreuses organisations utilisent à la fois des systèmes sur site et des systèmes en cloud.

- Un nombre croissant d'organisations intègrent l'apprentissage automatique et d'autres technologies d'IA dans leurs opérations et leurs produits.

- De nombreuses organisations ont mis en place des plateformes de flux de données en temps réel qui acheminent continuellement de grands volumes de données vers les systèmes de l'entreprise.

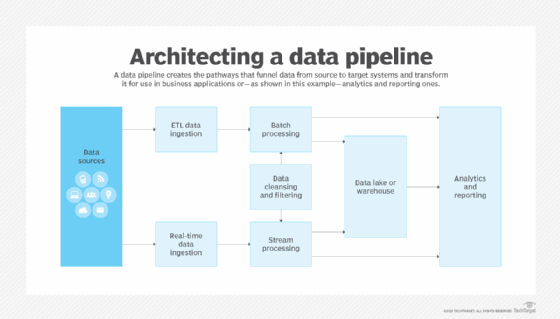

- Les data scientists mettent en œuvre des pipelines de données complexes pour soutenir leurs recherches et leurs analyses avancées.

Les préoccupations relatives à la qualité des données augmentent également en raison de la mise en œuvre de lois sur la confidentialité et la protection des données, telles que le règlement général sur la protection des données (RGPD) de l'Union européenne et la loi californienne sur la protection de la vie privée des consommateurs (CCPA). Ces deux mesures donnent aux personnes le droit d'accéder aux données personnelles que les entreprises collectent à leur sujet, ce qui signifie que les organisations doivent être en mesure de trouver tous les enregistrements relatifs à une personne dans leurs systèmes sans en oublier aucun en raison de données inexactes ou incohérentes.

Qualité des données vs. intégrité des données

Les termes de qualité et d'intégrité des données sont parfois utilisés de manière interchangeable, bien qu'ils aient des significations différentes. Certains considèrent l'intégrité des données comme une facette de la qualité des données ou la qualité des données comme une composante de l'intégrité des données. D'autres considèrent que la qualité et l'intégrité des données font partie d'un effort plus large de gouvernance des données, tandis que d'autres encore considèrent que l'intégrité des données est un concept plus large qui combine la qualité des données, la gouvernance des données et la protection des données dans un effort unifié pour traiter l'exactitude, la cohérence et la sécurité des données.

Dans une perspective plus large, l'intégrité des données se concentre sur la validité logique et physique des données. L'intégrité logique comprend les mesures de qualité des données et les attributs de base de données tels que l'intégrité référentielle, qui garantit la validité des éléments de données liés dans différentes tables de la base de données.

L'intégrité physique concerne les contrôles d'accès et les autres mesures de sécurité destinées à empêcher la modification ou l'altération des données par des utilisateurs non autorisés. Elle concerne également les protections telles que les sauvegardes et la reprise après sinistre. En revanche, la qualité des données se concentre davantage sur la capacité des données à remplir leur fonction spécifique.