Qu'est-ce que la gouvernance de l'intelligence artificielle (IA) ?

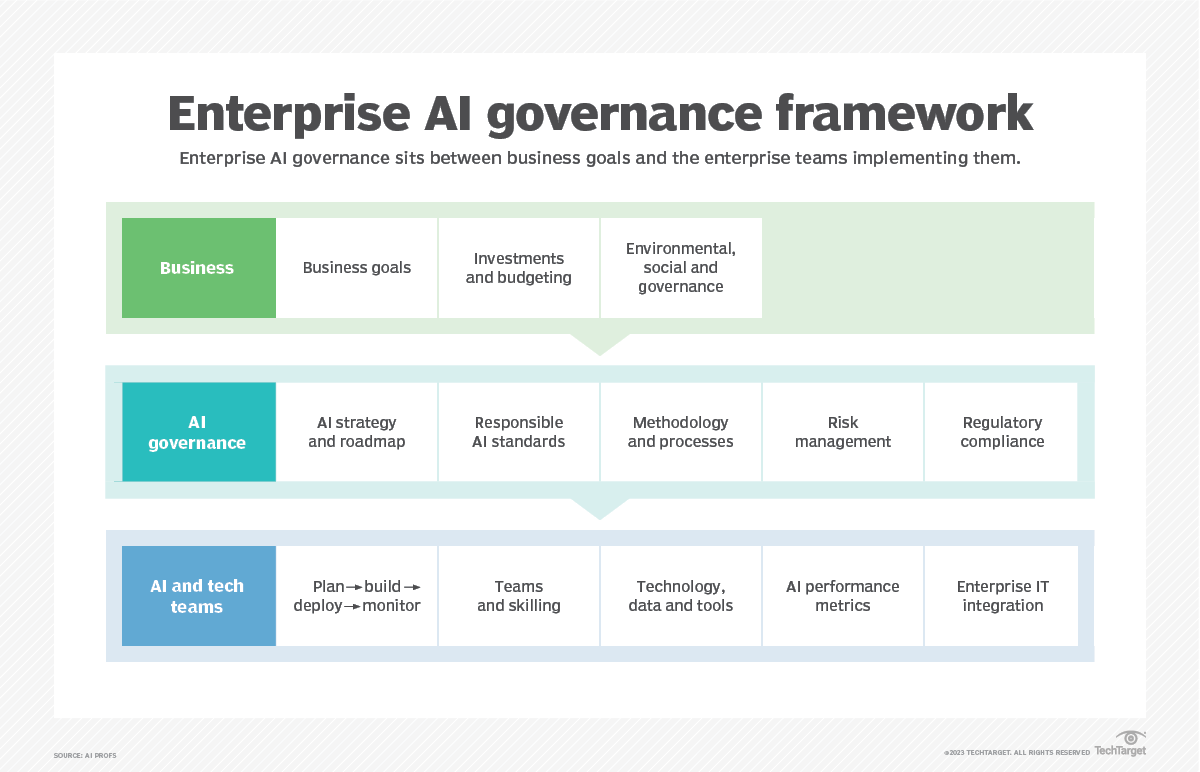

La gouvernance de l'intelligence artificielle est le cadre juridique qui garantit que les technologies d'IA et d'apprentissage automatique sont étudiées et développées dans le but d'aider l'humanité à adopter et à utiliser ces systèmes de manière éthique et responsable. La gouvernance de l'IA vise à combler le fossé qui existe entre la responsabilité et l'éthique dans le domaine du progrès technologique.

L'utilisation de l'IA connaît une croissance rapide dans presque tous les secteurs, notamment les soins de santé, les transports, le commerce de détail, les services financiers, l'éducation et la sécurité publique. En conséquence, la gouvernance joue désormais un rôle important et fait l'objet d'une attention croissante.

La gouvernance de l'IA se concentre principalement sur l'IA, en termes de justice, de qualité des données et d'autonomie. Dans l'ensemble, la gouvernance de l'IA détermine dans quelle mesure les algorithmes peuvent influencer la vie quotidienne et qui contrôle le fonctionnement de l'IA. Voici quelques-uns des principaux domaines abordés par la gouvernance :

- Sécurité et utilisation abusive de l'IA.

- Secteurs adaptés à l'automatisation par l'IA.

- Structures juridiques et institutionnelles relatives à l'utilisation et à la technologie de l'IA.

- Contrôle et accès aux données personnelles.

- Questions morales et éthiques liées à l'IA.

- Biais de l'IA.

Pourquoi la gouvernance de l'IA est-elle nécessaire ?

La gouvernance de l'IA est nécessaire lorsque des algorithmes d'apprentissage automatique sont utilisés pour prendre des décisions, en particulier lorsque ces décisions peuvent avoir des conséquences négatives pour les êtres humains. Par exemple, la gouvernance de l'IA détermine la meilleure façon de gérer les scénarios dans lesquels les décisions basées sur l'IA pourraient être injustes ou violer les droits de l'homme. Les biais de l'apprentissage automatique, notamment en termes de profilage racial, peuvent identifier de manière erronée des informations de base sur les utilisateurs. Cela peut conduire à refuser injustement à des personnes l'accès aux soins de santé et aux prêts, ou induire en erreur les forces de l'ordre dans l'identification de suspects criminels.

L'adoption rapide des outils, systèmes et technologies d'IA dans divers secteurs a également soulevé des questions concernant l'éthique, la transparence et la conformité avec d'autres réglementations, telles que le règlement général sur la protection des données (RGPD). Sans une gouvernance adéquate, les systèmes d'IA pourraient présenter des risques tels que des décisions biaisées, des violations de la vie privée et une utilisation abusive des données. La gouvernance de l'IA vise à faciliter l'utilisation constructive des technologies d'IA tout en protégeant les droits des utilisateurs et en prévenant tout préjudice.

Les piliers de la gouvernance de l'IA

Le Bureau des sciences et technologies de la Maison Blanche a élaboré un projet de charte des droits relatifs à l'IA qui définit cinq principes directeurs et pratiques pour la conception, le déploiement et l'utilisation des systèmes d'IA. L'objectif de ce projet est de contribuer à protéger les droits du public américain en matière d'utilisation de l'IA. Ces principes sont les suivants :

- Des systèmes sûrs et efficaces. Ce principe stipule que les systèmes d'IA doivent être minutieusement testés et surveillés afin de garantir leur sécurité et leur bon fonctionnement, et qu'ils ne doivent pas être conçus de manière à mettre en danger des personnes.

- Protections contre la discrimination algorithmique. Ce principe stipule que les systèmes d'IA ne doivent pas faire preuve de discrimination injuste fondée sur la race, la couleur, l'origine ethnique, le sexe, la religion, l'âge, la nationalité ou d'autres classifications protégées par la loi.

- Confidentialité des données. Ce principe stipule que les individus doivent avoir le contrôle de leurs données et être protégés contre les pratiques abusives en matière de données grâce à des protections intégrées.

- Avis et explication. Ce principe stipule que les individus doivent savoir quand un système d'IA ou automatisé est utilisé et doivent être informés de son fonctionnement.

- Alternatives humaines, prise en compte et solution de repli. Ce principe stipule que les individus doivent pouvoir choisir de ne pas utiliser un système d'IA ou automatisé au profit d'une alternative humaine lorsque cela est approprié.

Parmi les autres éléments constitutifs d'un cadre solide de gouvernance de l'IA, on peut citer les suivants :

- Innovation. Faciliter les efforts dans les domaines des affaires et des sciences afin d'exploiter et d'optimiser les avantages de l'IA.

- Une IA digne de confiance. Veiller à ce que l'IA soit transparente et ne porte pas atteinte aux libertés civiles, à l'État de droit ou à la confidentialité des données.

- Éducation et formation. Encourager l'utilisation de l'IA pour élargir les opportunités et l'accès à de nouveaux emplois, industries, innovations et formations.

- Infrastructure. Se concentrer sur l'élargissement de l'accès éthique aux données, aux modèles, à l'infrastructure informatique et à d'autres éléments d'infrastructure.

- Coopération internationale. Promouvoir la collaboration et les partenariats internationaux fondés sur des approches factuelles, la recherche analytique et l'engagement de multiples parties prenantes.

- Prise de décision et explicabilité. L'explicabilité, ou la capacité à comprendre les raisons qui sous-tendent les résultats de l'IA, est importante pour instaurer la confiance et la responsabilité.

- Conformité réglementaire. Les organisations doivent respecter les exigences en matière de confidentialité des données, les normes d'exactitude et les restrictions de stockage afin de protéger les informations sensibles. La réglementation de l'IA contribue à protéger les données des utilisateurs et à garantir une utilisation responsable de l'IA.

- Gestion des risques. La gouvernance de l'IA garantit une utilisation responsable de l'IA et des stratégies efficaces de gestion des risques, telles que la sélection d'ensembles de données d'entraînement appropriés, la mise en œuvre de mesures de cybersécurité et la prise en compte des biais ou erreurs potentiels dans les modèles d'IA.

- Implication des parties prenantes. Il est essentiel d'impliquer les parties prenantes, telles que les PDG, les responsables de la protection des données et les utilisateurs, pour garantir une gouvernance efficace de l'IA. Les parties prenantes contribuent à la prise de décision, assurent la supervision et veillent à ce que les technologies d'IA soient développées et utilisées de manière responsable tout au long de leur cycle de vie.

Comment les organisations devraient aborder la gouvernance de l'IA

Une organisation peut prendre de nombreuses mesures pour mettre en œuvre des pratiques efficaces et durables en matière de gouvernance de l'IA. Parmi celles-ci, on peut citer :

- Culture de l'IA. Chaque membre d'une organisation doit avoir le sentiment d'avoir un rôle à jouer dans la gouvernance de l'IA. Ce processus s'inscrit dans la durée et nécessite des programmes de formation pour les employés afin de créer une culture d'apprentissage continu autour de la gouvernance de l'IA.

- Communication. En particulier, les employeurs devraient toujours communiquer aux employés les risques liés à des systèmes d'IA mal gérés.

- Comité de gouvernance de l'IA. La création d'un comité de surveillance et de gouvernance composé de membres possédant une expertise dans ce domaine peut garantir le respect des politiques en matière d'IA dans l'ensemble d'une organisation.

- Amélioration continue. La collecte des commentaires des employés et des clients à l'aide d'outils et de systèmes d'IA permet à une organisation d'améliorer continuellement ses applications et ses produits d'IA. Il est également important de surveiller en permanence l'utilisation de l'IA, d'identifier les problèmes et de les corriger.

- Évaluation des risques. Des organismes tiers spécialisés dans l'évaluation et l'audit des risques liés à l'IA peuvent offrir une perspective différente sur la manière d'améliorer l'utilisation et la gouvernance de l'IA et de minimiser les risques associés.

- Indicateurs de gouvernance. L'utilisation d'indicateurs et d'indicateurs clés de performance (KPI) permet de vérifier si une organisation respecte les politiques de gouvernance en matière d'IA. L'IA peut se dégrader avec le temps, il est donc également important de surveiller et de gérer ces politiques au fil du temps. Les KPI liés à l'IA peuvent être quantitatifs ou qualitatifs et doivent inclure ceux qui mesurent la provenance, la véracité et la qualité des données, ainsi que la sécurité des données, la valeur financière et les biais algorithmiques.

- Impact environnemental. Le processus d'entraînement et d'exécution continue de l'IA au fil du temps peut avoir un impact considérable sur l'environnement. Une organisation doit en prendre note et mettre tout en œuvre pour atténuer son impact sur l'environnement.

Qu'est-ce que la gouvernance des modèles d'IA ?

La gouvernance des modèles d'IA est un sous-ensemble de la gouvernance de l'IA qui traite spécifiquement de la manière dont les organisations doivent développer et utiliser les modèles d'IA et d'apprentissage automatique de manière sûre et responsable. Les organisations qui développent et utilisent ces modèles doivent tenir compte des considérations suivantes :

- Propriété du modèle. Le développement de l'IA implique généralement des équipes de personnes travaillant sur un modèle. Le suivi du travail accompli par chaque membre de l'équipe est essentiel pour garantir le succès du modèle, améliorer la collaboration et éviter des problèmes tels que les doublons inutiles.

- Règles et réglementations. La mise en œuvre d'un ensemble de règles garantit que les aspects du développement du modèle, tels que la qualité des données, l'ingénierie des fonctionnalités et la documentation, sont exempts d'erreurs et conformes aux lois et réglementations qui atténuent les risques liés à l'IA.

- Qualité des données. Des normes doivent être mises en place pour garantir la qualité et la sécurité des ensembles de données utilisés pour entraîner les modèles d'IA. Les données doivent être exactes et impartiales afin que le modèle qui apprend à partir de ces données fonctionne correctement et produise les résultats souhaités.

- Surveillance continue. Une fois qu'un modèle passe à la phase de postproduction, il doit être surveillé en permanence afin de s'assurer qu'il fonctionne comme prévu. La gouvernance des modèles garantit la mise en place de mesures permettant de former et de surveiller en permanence un modèle selon les besoins.

L'avenir de la gouvernance de l'IA

L'avenir de la gouvernance de l'IA dépend de la collaboration entre les gouvernements, les organisations et les parties prenantes. Son succès repose sur l'élaboration de politiques et de réglementations globales en matière d'IA qui protègent le public tout en favorisant l'innovation. Le respect des règles de gouvernance des données et des réglementations en matière de confidentialité, ainsi que la priorité accordée à la sécurité, à la fiabilité et à la transparence, sont également importants pour l'avenir de la gouvernance de l'IA.

Plusieurs entreprises se concentrent sur l'avenir de la gouvernance de l'IA. Par exemple, en 2022, Microsoft a publié la version 2 de sa « norme d'IA responsable », un guide destiné aux organisations qui gèrent les risques liés à l'IA et intègrent une gouvernance éthique de l'IA dans leurs stratégies. Parmi les autres entreprises qui se sont engagées à mettre en œuvre des normes et des garde-fous en matière de gouvernance, on peut citer Amazon, Anthropic, Google, IBM et Inflection.

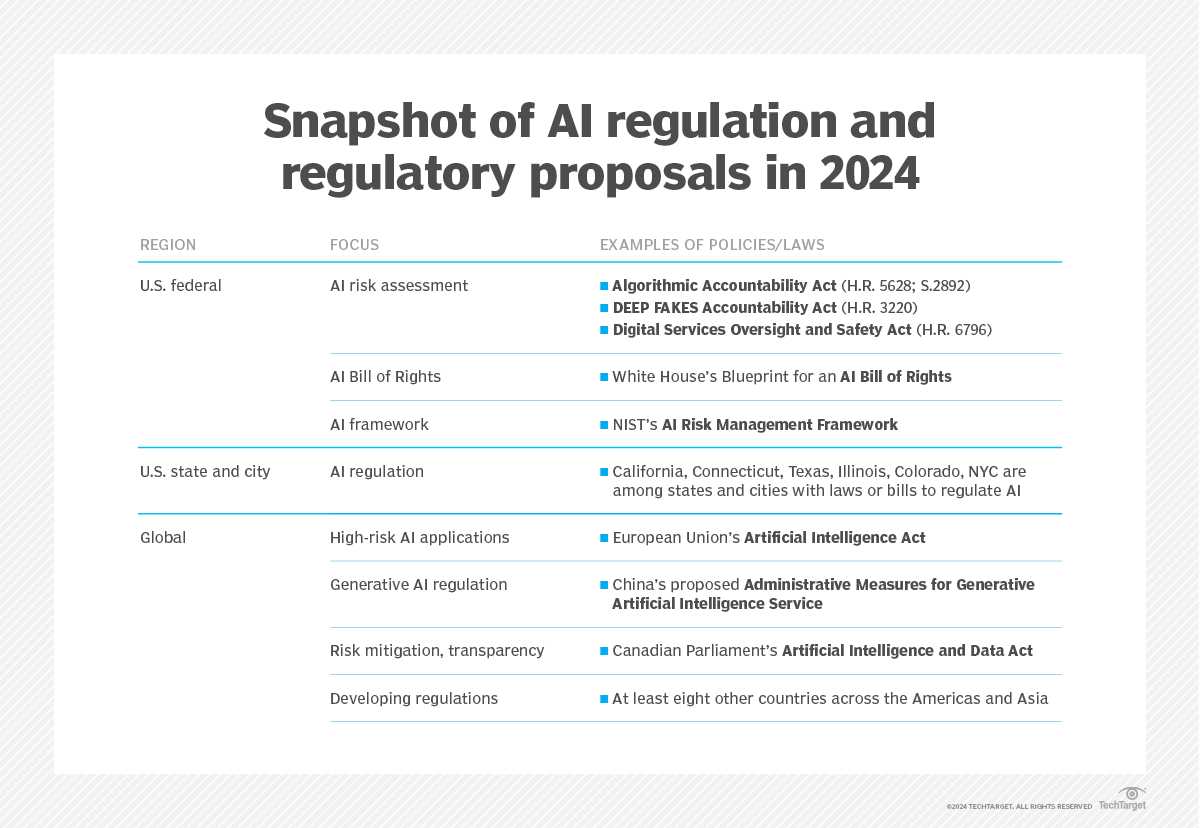

Parmi les organismes gouvernementaux américains travaillant dans ce domaine figure le Bureau national pour l'initiative en matière d'intelligence artificielle du Bureau de la politique scientifique et technologique de la Maison Blanche, lancé en 2021. Le Comité consultatif national sur l'intelligence artificielle a été créé en 2022 dans le cadre de l'Initiative nationale sur l'IA afin de conseiller le président sur les questions liées à l'IA. En outre, en collaboration avec les secteurs public et privé, l'Institut national des normes et des technologies a élaboré un cadre qui recommande certaines approches de gestion des risques à ceux qui travaillent avec l'IA.

Certains experts en IA continuent toutefois d'affirmer qu'il existe une lacune dans le cadre juridique régissant la responsabilité et l'intégrité de l'IA. En mars 2023, des leaders technologiques et des experts en IA tels qu'Elon Musk et Steve Wozniak ont signé une lettre ouverte appelant à un arrêt temporaire de la recherche sur l'IA et à la codification de réglementations juridiques. En mai, le PDG d'OpenAI, Sam Altman, a témoigné devant le Congrès pour demander instamment une réglementation de l'IA. Elon

Plus récemment, en 2024, Musk et OpenAI se sont retrouvés au cœur d'une controverse concernant l'emplacement de l'IA générative Grok de Musk, son impact environnemental et son fonctionnement peu éthique, tandis qu'OpenAI aurait privilégié le profit au détriment de la sécurité.

D'autres entreprises ont également repoussé les limites en matière de gouvernance de l'IA. Adobe, par exemple, a mis à jour ses conditions d'utilisation en 2024 afin de permettre à l'entreprise d'accéder au contenu généré par les utilisateurs pour former son logiciel d'apprentissage automatique. Après avoir essuyé de vives critiques, Adobe a fait marche arrière et mis à jour ses conditions d'utilisation, s'engageant à ne pas former son IA à partir du contenu des utilisateurs.

À mesure que l'adoption de l'IA continue de progresser et que la technologie s'améliore, les entreprises sont susceptibles de continuer à repousser les limites éthiques liées à l'IA dans leurs offres de produits, et la mise en œuvre appropriée de la gouvernance de l'IA deviendra de plus en plus pertinente. Cela signifie que le domaine de l'IA fera probablement l'objet d'appels publics en faveur d'une surveillance réglementaire. Le projet de charte des droits de l'IA de la Maison Blanche va dans ce sens, mais il manque de détails concrets sur la manière dont chaque principe devrait être mis en œuvre et n'oblige pas les organisations à le respecter.

La gouvernance de l'IA consiste à réglementer de manière responsable l'intelligence artificielle dans les secteurs privé et public. Découvrez ce que les entreprises doivent savoir sur la réglementation de l'IA.