Qu'est-ce que l'IA boîte noire ?

Une IA « boîte noire » désigne tout système d'intelligence artificielle dont les entrées et les opérations ne sont pas visibles pour l'utilisateur ou toute autre partie intéressée. Une boîte noire, au sens général, est un système impénétrable.

Les modèles d'IA de type « boîte noire » parviennent à des conclusions ou prennent des décisions sans fournir aucune explication sur la manière dont ils y sont parvenus.

Au fur et à mesure de l'évolution de la technologie IA, deux grands types de systèmes IA ont vu le jour : l'IA « boîte noire » et l'IA « explicable » (ou « boîte blanche »). Le terme « boîte noire » désigne les systèmes qui ne sont pas transparents pour les utilisateurs. En termes simples, les systèmes IA dont le fonctionnement interne, les processus décisionnels et les facteurs contributifs ne sont pas visibles ou restent inconnus des utilisateurs humains sont appelés systèmes IA « boîte noire ».

Le manque de transparence rend difficile pour les humains de comprendre ou d'expliquer comment le modèle sous-jacent du système arrive à ses conclusions. Les modèles d'IA de type « boîte noire » peuvent également créer des problèmes liés à la flexibilité (mise à jour du modèle en fonction de l'évolution des besoins), aux biais (résultats incorrects pouvant offenser ou nuire à certains groupes de personnes), à la validation de la précision (difficulté à valider ou à se fier aux résultats) et à la sécurité (des failles inconnues rendent le modèle vulnérable aux cyberattaques).

Comment fonctionnent les modèles d'apprentissage automatique de type « boîte noire » ?

Lorsqu'un modèle d'apprentissage automatique est développé, l'algorithme d'apprentissage prend en entrée des millions de points de données et met en corrélation des caractéristiques spécifiques des données afin de produire des résultats.

Le processus comprend généralement les étapes suivantes :

- Des algorithmes d'IA sophistiqués examinent des ensembles de données volumineux afin d'y trouver des modèles. Pour ce faire, l'algorithme ingère un grand nombre d'exemples de données, ce qui lui permet d'expérimenter et d'apprendre par lui-même, par essais et erreurs. À mesure que le modèle reçoit davantage de données d'entraînement, il apprend de manière autonome à modifier ses paramètres internes jusqu'à ce qu'il atteigne un point où il peut prédire le résultat exact pour de nouvelles entrées.

- À l'issue de cette formation, le modèle est enfin prêt à faire des prédictions à partir de données réelles. La détection des fraudes à l'aide d'un score de risque est un exemple d'utilisation de ce mécanisme.

- Le modèle adapte sa méthode, ses approches et son ensemble de connaissances, puis produit des résultats de plus en plus performants à mesure que des données supplémentaires sont collectées et intégrées au fil du temps.

Dans de nombreux cas, le fonctionnement interne des modèles d'apprentissage automatique de type « boîte noire » n'est pas facilement accessible et est en grande partie autonome. C'est pourquoi il est difficile pour les scientifiques des données, les programmeurs et les utilisateurs de comprendre comment le modèle génère ses prédictions ou de se fier à l'exactitude et à la véracité de ses résultats.

Comment fonctionnent les modèles d'apprentissage profond de type « boîte noire » ?

De nombreux modèles d'IA de type « boîte noire » sont basés sur l'apprentissage profond, une branche de l'IA (et plus particulièrement une branche de l'apprentissage automatique) qui utilise des réseaux neuronaux multicouches ou profonds pour imiter le cerveau humain et simuler sa capacité de prise de décision. Les réseaux neuronaux sont composés de plusieurs couches de nœuds interconnectés appelés neurones artificiels.

Dans les modèles de boîte noire, ces réseaux profonds de neurones artificiels dispersent les données et la prise de décision entre des dizaines de milliers, voire plus, de neurones. Les neurones travaillent ensemble pour traiter les données et identifier des modèles, permettant ainsi au modèle d'IA de faire des prédictions et d'aboutir à certaines décisions ou réponses.

Ces prédictions et décisions entraînent une complexité qui peut être aussi difficile à comprendre que celle du cerveau humain. Comme pour les modèles d'apprentissage automatique, il est difficile pour les humains d'identifier le « comment » d'un modèle d'apprentissage profond, c'est-à-dire les étapes spécifiques qu'il a suivies pour faire ces prédictions ou arriver à ces décisions. Pour toutes ces raisons, ces systèmes d'apprentissage profond sont connus sous le nom de systèmes d'IA « boîte noire ».

Problèmes liés à l'IA de type « boîte noire »

Si les modèles d'IA de type « boîte noire » sont appropriés et très utiles dans certaines circonstances, ils peuvent également poser plusieurs problèmes.

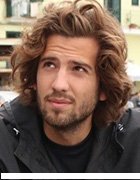

1. Biais de l'IA

Les biais liés à l'IA peuvent être introduits dans les algorithmes d'apprentissage automatique ou les réseaux neuronaux d'apprentissage profond, reflétant les préjugés conscients ou inconscients des développeurs. Les biais peuvent également s'introduire par le biais d'erreurs non détectées ou à partir des données d'entraînement lorsque les détails du jeu de données ne sont pas reconnus. En général, les résultats d'un système d'IA biaisé seront faussés, voire carrément incorrects, et pourront être offensants, injustes ou carrément dangereux pour certaines personnes ou certains groupes.

Exemple

Un système d'IA utilisé pour le recrutement dans le domaine informatique peut s'appuyer sur des données historiques pour aider les équipes RH à sélectionner les candidats à convoquer en entretien. Cependant, comme l'histoire montre que la plupart des employés informatiques étaient autrefois des hommes, l'algorithme d'IA peut utiliser cette information pour ne recommander que des candidats masculins, même si le vivier de candidats potentiels comprend des femmes qualifiées. En d'autres termes, il affiche un biais en faveur des candidats masculins et discrimine les candidates féminines. Des problèmes similaires peuvent se poser avec d'autres groupes, tels que les candidats issus de certaines minorités ethniques ou religieuses ou les populations immigrées.

Avec l'IA de type « boîte noire », il est difficile d'identifier d'où provient le biais ou si les modèles du système sont impartiaux. Si le biais inhérent entraîne des résultats systématiquement biaisés, cela peut nuire à la réputation de l'organisation qui utilise le système. Cela peut également donner lieu à des poursuites judiciaires pour discrimination. Les biais dans les systèmes d'IA de type « boîte noire » peuvent également avoir un coût social, conduisant à la marginalisation, au harcèlement, à l'emprisonnement injustifié, voire à des blessures ou à la mort de certains groupes de personnes.

Pour éviter de telles conséquences néfastes, les développeurs d'IA doivent intégrer la transparence dans leurs algorithmes. Il est également important qu'ils se conforment à la réglementation en matière d'IA, qu'ils assument la responsabilité de leurs erreurs et qu'ils s'engagent à promouvoir le développement et l'utilisation responsables de l'IA.

Dans certains cas, des techniques telles que l'analyse de sensibilité et la visualisation des caractéristiques peuvent être utilisées pour donner un aperçu du fonctionnement des processus internes du modèle d'IA. Malgré cela, dans la plupart des cas, ces processus restent opaques.

2. Manque de transparence et de responsabilité

La complexité des modèles d'IA de type « boîte noire » peut empêcher les développeurs de les comprendre et de les auditer correctement, même s'ils produisent des résultats précis. Certains experts en IA, même ceux qui ont participé à certaines des réalisations les plus révolutionnaires dans le domaine de l'IA, ne comprennent pas entièrement le fonctionnement de ces modèles. Ce manque de compréhension entraîne une réduction de la transparence et minimise le sentiment de responsabilité.

Ces problèmes peuvent être extrêmement préoccupants dans des domaines à haut risque tels que la santé, la banque, l'armée et la justice pénale. Étant donné que les choix et les décisions pris par ces modèles ne sont pas fiables, les conséquences sur la vie des gens peuvent être considérables, et pas toujours dans le bon sens. Il peut également être difficile de tenir les individus responsables des jugements de l'algorithme s'il utilise des modèles flous.

3. Manque de flexibilité

Un autre problème majeur lié à l'IA de type « boîte noire » est son manque de flexibilité. Si le modèle doit être modifié pour un cas d'utilisation différent (par exemple, pour décrire un objet différent mais physiquement comparable), la détermination des nouvelles règles ou des paramètres globaux pour la mise à jour peut nécessiter beaucoup de travail.

4. Difficulté à valider les résultats

Les résultats générés par l'IA de type « boîte noire » sont souvent difficiles à valider et à reproduire. Comment le modèle est-il parvenu à ce résultat particulier ? Pourquoi est-il parvenu uniquement à ce résultat et à aucun autre ? Comment savoir s'il s'agit de la meilleure réponse ou de la réponse la plus correcte ? Il est presque impossible de trouver les réponses à ces questions et de se fier aux résultats générés pour étayer les actions ou les décisions humaines. C'est l'une des raisons pour lesquelles il n'est pas conseillé de traiter des données sensibles à l'aide d'un modèle d'IA de type « boîte noire ».

5. Failles de sécurité

Les modèles d'IA de type « boîte noire » contiennent souvent des failles que les acteurs malveillants peuvent exploiter pour manipuler les données d'entrée. Par exemple, ils pourraient modifier les données afin d'influencer le jugement du modèle et lui faire prendre des décisions incorrectes, voire dangereuses. Comme il n'existe aucun moyen de procéder à une ingénierie inverse du processus décisionnel du modèle, il est pratiquement impossible de l'empêcher de prendre de mauvaises décisions.

Il est également difficile d'identifier d'autres failles de sécurité affectant le modèle d'IA. Une faille courante est créée par des tiers qui ont accès aux données d'entraînement du modèle. Si ces tiers ne respectent pas les bonnes pratiques de sécurité pour protéger les données, il est difficile de les soustraire aux cybercriminels, qui pourraient obtenir un accès non autorisé pour manipuler le modèle et fausser ses résultats.

Quand faut-il utiliser l'IA de type « boîte noire » ?

Bien que les modèles d'IA de type « boîte noire » posent de nombreux défis, ils offrent également tous ces avantages :

- Précision accrue. Les systèmes complexes de type « boîte noire » peuvent offrir une précision de prédiction supérieure à celle des systèmes plus interprétables, en particulier dans les domaines de la vision par ordinateur et du traitement du langage naturel, car ils sont capables d'identifier des modèles complexes dans les données qui ne sont pas facilement perceptibles par l'œil humain. Cependant, la précision des algorithmes les rend très complexes, ce qui peut également les rendre moins transparents.

- Conclusions rapides. Les modèles de boîte noire sont souvent basés sur un ensemble fixe de règles et d'équations, ce qui les rend rapides à exécuter et faciles à optimiser. Par exemple, le calcul de l'aire sous une courbe à l'aide d'un algorithme d'ajustement par moindres carrés peut générer la bonne réponse même si le modèle ne comprend pas parfaitement le problème.

- Puissance de calcul minimale. De nombreux modèles de boîte noire sont assez simples, ils ne nécessitent donc pas beaucoup de ressources informatiques.

- Automatisation. Les modèles d'IA de type « boîte noire » peuvent automatiser des processus décisionnels complexes, réduisant ainsi le besoin d'intervention humaine. Cela permet d'économiser du temps et des ressources tout en améliorant l'efficacité de processus auparavant exclusivement manuels.

En général, l'approche IA « boîte noire » est généralement utilisée dans les réseaux neuronaux profonds, où le modèle est entraîné sur de grandes quantités de données et où les poids et paramètres internes des algorithmes sont ajustés en conséquence. Ces modèles sont efficaces dans certaines applications, notamment la reconnaissance d'images et de la parole, où l'objectif est de classer ou d'identifier les données avec précision et rapidité.

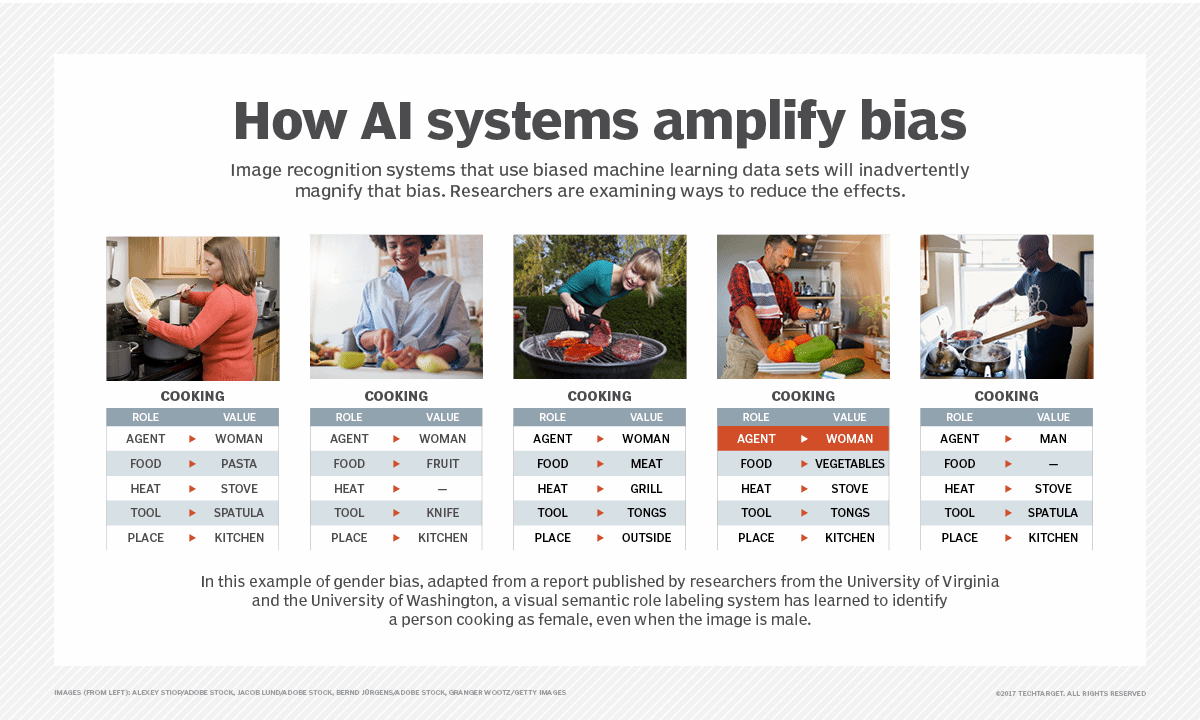

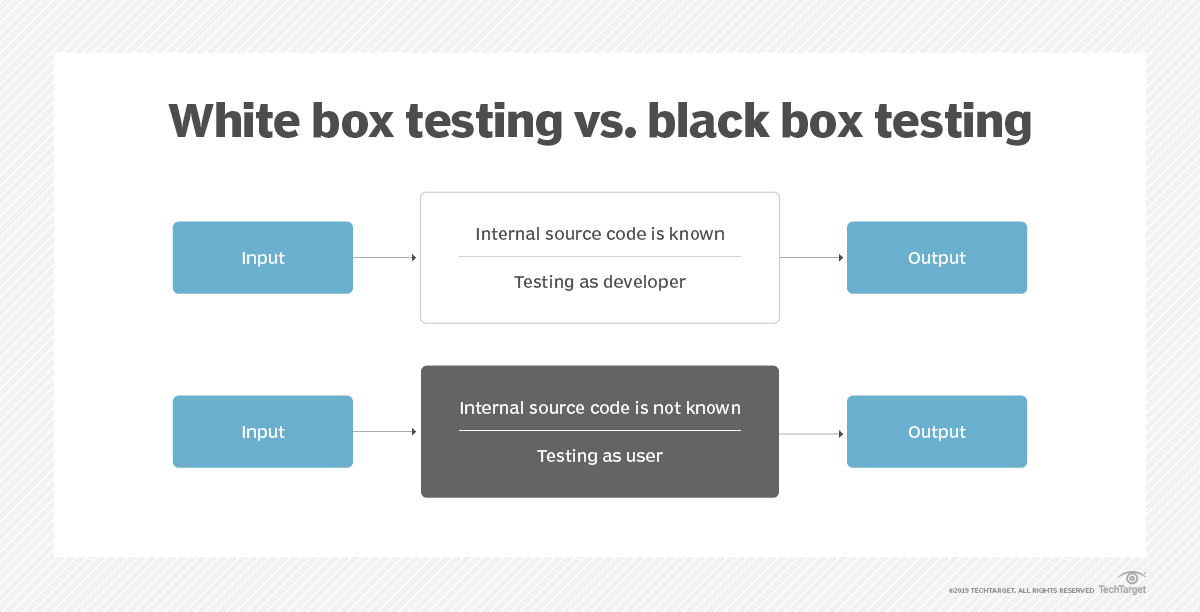

IA boîte noire vs IA boîte blanche

L'IA boîte noire et l'IA boîte blanche sont deux approches différentes du développement des systèmes d'IA. Le choix d'une approche particulière dépend des applications et des objectifs spécifiques du système final. L'IA boîte blanche est également connue sous le nom d'IA explicable ou XAI.

La XAI est conçue de manière à ce qu'une personne lambda puisse comprendre sa logique et son processus décisionnel. Outre le fait de comprendre comment le modèle d'IA fonctionne et parvient à des réponses particulières, les utilisateurs humains peuvent également avoir confiance dans les résultats du système d'IA. Pour toutes ces raisons, la XAI est l'antithèse de l'IA « boîte noire ».

Si les entrées et les sorties d'un système d'IA de type « boîte noire » sont connues, son fonctionnement interne n'est ni transparent ni facile à comprendre. L'IA de type « boîte blanche » est transparente quant à la manière dont elle parvient à ses conclusions. Ses résultats sont également interprétables et explicables, ce qui permet aux scientifiques des données d'examiner un algorithme de type « boîte blanche » afin de déterminer son comportement et les variables qui influencent son jugement.

Étant donné que le fonctionnement interne d'un système « boîte blanche » est accessible et facilement compréhensible par les utilisateurs, cette approche est souvent utilisée dans les applications décisionnelles, telles que le diagnostic médical ou l'analyse financière, où il est important de savoir comment l'IA est parvenue à ses conclusions.

L'IA explicable ou « boîte blanche » est le type d'IA le plus souhaitable pour de nombreuses raisons.

Premièrement, cela permet aux développeurs, ingénieurs et scientifiques des données du modèle d'auditer ce dernier et de confirmer que le système d'IA fonctionne comme prévu. Si ce n'est pas le cas, ils peuvent déterminer les modifications nécessaires pour améliorer les résultats du système.

Deuxièmement, un système d'IA explicable permet à ceux qui sont concernés par ses résultats ou ses décisions de contester ces derniers, en particulier s'il existe une possibilité que ces résultats soient le fruit d'un biais inhérent au modèle d'IA.

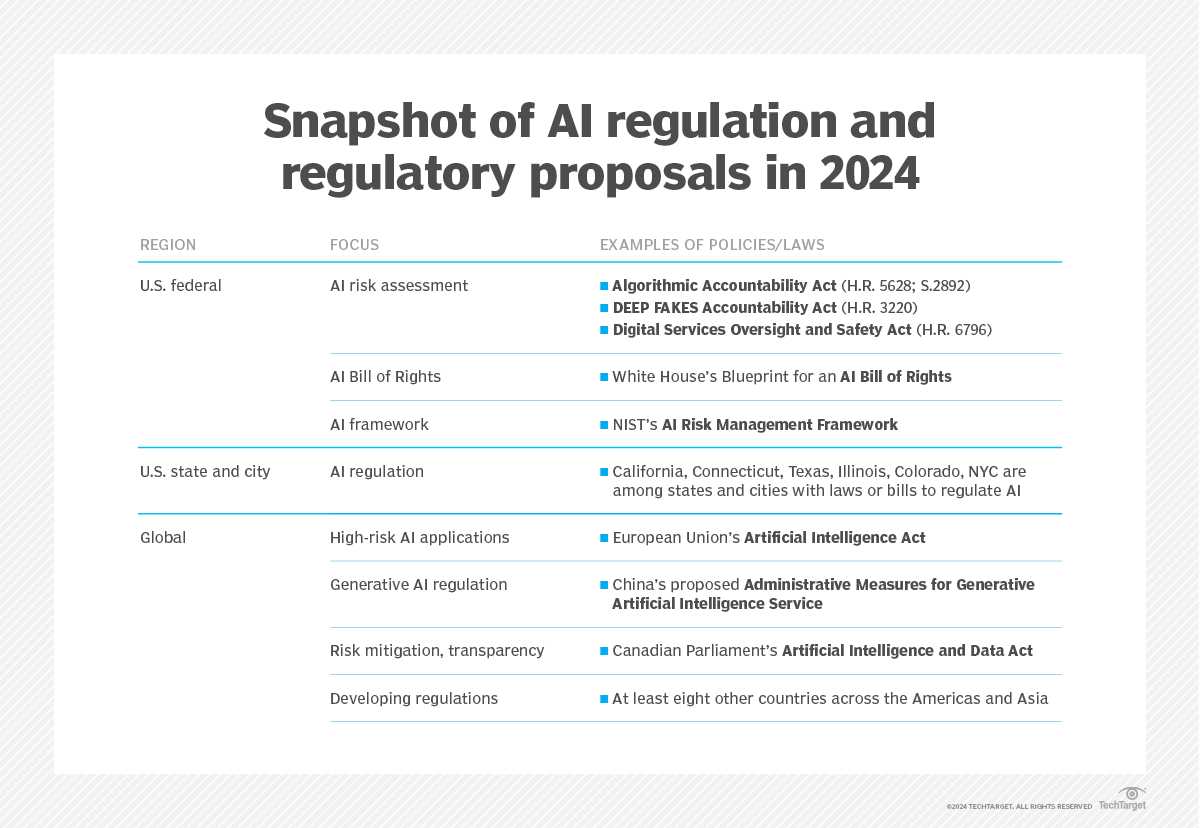

Troisièmement, l'explicabilité permet de s'assurer plus facilement que le système est conforme aux normes réglementaires, dont beaucoup ont vu le jour ces dernières années (la loi européenne sur l'IA en est un exemple bien connu), afin de minimiser les répercussions négatives de l'IA. Il s'agit notamment des risques liés à la confidentialité des données, des hallucinations de l'IA entraînant des résultats erronés, des violations de données affectant les gouvernements ou les entreprises, et de la propagation de deepfakes audio ou vidéo conduisant à la diffusion de fausses informations.

Enfin, l'explicabilité est essentielle à la mise en œuvre d'une IA responsable. L'IA responsable désigne les systèmes d'IA qui sont sûrs, transparents, responsables et utilisés de manière éthique afin de produire des résultats fiables et dignes de confiance. L'objectif de l'IA responsable est de générer des résultats bénéfiques et de minimiser les dommages.

Voici un résumé des différences entre l'IA boîte noire et l'IA boîte blanche :

- L'IA de type « boîte noire » est souvent plus précise et plus efficace que l'IA de type « boîte blanche ».

- L'IA « boîte blanche » est plus facile à comprendre que l'IA « boîte noire ».

- Les modèles de boîte noire comprennent les modèles de renforcement et les modèles de forêt aléatoire, qui sont de nature hautement non linéaire et plus difficiles à expliquer.

- L'IA blanche est plus facile à déboguer et à dépanner en raison de sa nature transparente et interprétable.

- Les modèles linéaires, les arbres de décision et les arbres de régression sont tous des modèles d'IA de type « boîte blanche ».

En savoir plus sur l'IA responsable

Une IA développée et utilisée de manière moralement irréprochable et socialement responsable est appelée « IA responsable ». L'IA responsable consiste à rendre l'algorithme d'IA responsable avant qu'il ne génère des résultats. Les principes directeurs et les meilleures pratiques de l'IA responsable visent à réduire les risques financiers, éthiques et de réputation que peut engendrer une IA de type « boîte noire ». Ce faisant, l'IA responsable peut aider à la fois les producteurs et les consommateurs d'IA.

Les pratiques d'IA sont considérées comme responsables si elles respectent les principes suivants :

- Équité. Le système d'IA traite toutes les personnes et tous les groupes démographiques de manière équitable et ne renforce ni n'exacerbe les préjugés ou la discrimination préexistants.

- Transparence. Le système est facile à comprendre et à expliquer tant pour ses utilisateurs que pour les personnes concernées. De plus, les développeurs d'IA doivent divulguer la manière dont les données utilisées pour former un système d'IA sont collectées, stockées et utilisées.

- Responsabilité. Les organisations et les personnes qui créent et utilisent l'IA doivent être tenues responsables des jugements et des décisions pris par le système d'IA.

- Développement continu. Une surveillance continue est nécessaire pour garantir que les résultats soient toujours conformes aux concepts d'IA morale et aux normes sociétales.

- Supervision humaine. Chaque système d'IA doit être conçu de manière à permettre une surveillance et une intervention humaines lorsque cela s'avère nécessaire.

Lorsque l'IA est à la fois explicable et responsable, elle est plus susceptible d'avoir un impact bénéfique pour l'humanité.

Les réseaux neuronaux gagnent en popularité, car ils offrent un haut niveau de responsabilité et de transparence. Découvrez les possibilités offertes par l'IA « boîte blanche », ses cas d'utilisation et l'orientation qu'elle est susceptible de prendre à l'avenir. Découvrez comment aborder le débat sur l'IA « boîte noire » dans le domaine de la santé et comment résoudre le problème de l'IA « boîte noire » grâce à la transparence.