Qu'est-ce que l'éthique de l'IA ?

L'éthique de l'IA est un système de principes moraux et de techniques visant à informer le développement et l'utilisation responsable de la technologie de l'intelligence artificielle. L'IA étant devenue partie intégrante des produits et des services, les organisations commencent également à élaborer des codes d'éthique en matière d'IA.

Un code d'éthique de l'IA, également appelé plate-forme de valeurs de l'IA, est une déclaration politique qui définit formellement le rôle de l'intelligence artificielle dans le cadre du développement et du bien-être des êtres humains. L'objectif d'un code d'éthique de l'IA est de fournir des conseils aux parties prenantes lorsqu'elles sont confrontées à une décision éthique concernant l'utilisation de l'intelligence artificielle.

Isaac Asimov, écrivain de science-fiction, a anticipé les dangers potentiels des agents d'intelligence artificielle autonomes en 1942, bien avant le développement des systèmes d'intelligence artificielle. Il a créé les trois lois de la robotique pour limiter ces risques. Dans le code d'éthique d'Asimov, la première loi interdit aux robots de nuire activement aux humains ou de permettre qu'un mal soit fait aux humains en refusant d'agir. La deuxième loi ordonne aux robots d'obéir aux humains, à moins que les ordres ne soient pas conformes à la première loi. La troisième loi ordonne aux robots de se protéger dans la mesure où cela est conforme aux deux premières lois.

Aujourd'hui, les dangers potentiels des systèmes d'IA comprennent le remplacement des emplois humains par l'IA, les hallucinations de l'IA, les "deepfakes" et les biais de l'IA. Ces problèmes pourraient être à l'origine de licenciements humains, d'informations trompeuses, de fausses imitations d'images ou de voix d'autrui, ou de décisions préjudiciables susceptibles d'avoir des répercussions négatives sur la vie des êtres humains.

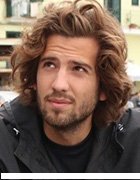

Les progrès rapides de l'IA au cours des dix dernières années ont incité des groupes d'experts à élaborer des mesures de protection contre les risques de l'IA pour l'homme. L'un de ces groupes est le Future of Life Institute, un organisme à but non lucratif fondé par Max Tegmark, cosmologiste au Massachusetts Institute of Technology, Jaan Tallinn, cofondateur de Skype, et Victoria Krakovna, chercheuse chez Google DeepMind. L'institut a collaboré avec des chercheurs et des développeurs en IA, ainsi qu'avec des universitaires de nombreuses disciplines, pour élaborer les 23 lignes directrices aujourd'hui connues sous le nom de principes d'Asilomar en matière d'IA.

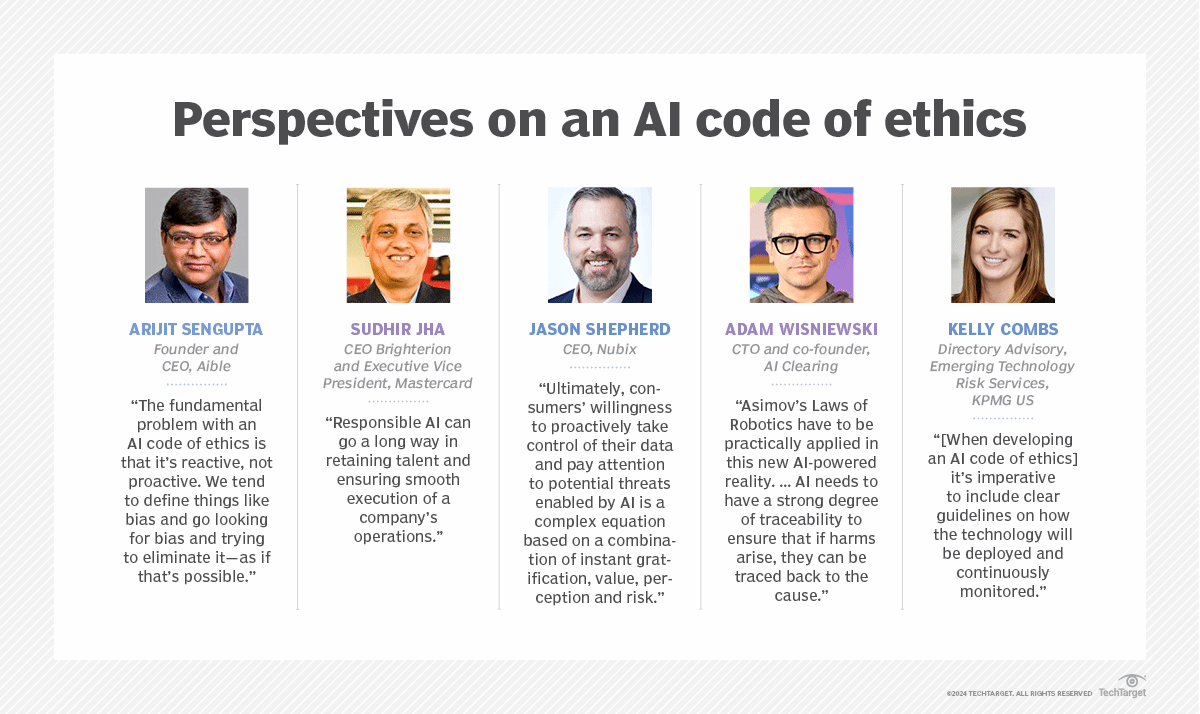

Kelly Combs, directrice consultative de Emerging Technology Risk Services pour KPMG US, a déclaré que, lors de l'élaboration d'un code d'éthique de l'IA, "il est impératif d'inclure des lignes directrices claires sur la façon dont la technologie sera déployée et surveillée en permanence". Ces politiques devraient prévoir des mesures de protection contre les biais involontaires dans les algorithmes d'apprentissage automatique, de détection continue des dérives dans les données et les algorithmes, et de suivi de la provenance des données et de l'identité de ceux qui forment les algorithmes.

Principes de l'éthique de l'IA

Il n'existe pas d'ensemble de principes définis d'éthique de l'IA que l'on puisse suivre lors de la mise en œuvre d'un système d'IA. Certains principes, par exemple, suivent l'exemple du rapport Belmont. Le rapport Belmont est un document publié en 1979 par la Commission nationale pour la protection des sujets humains dans la recherche biomédicale et comportementale. Il fait référence aux trois principes directeurs suivants pour le traitement éthique des sujets humains :

- Le respect des personnes. Il reconnaît l'autonomie des personnes et est lié à l'idée de consentement éclairé.

- La bienfaisance. Elle est liée à l'idée de ne pas nuire.

- La justice. Ce principe est axé sur l'équité et l'égalité.

Bien que le rapport Belmont ait été élaboré à l'origine pour la recherche sur les êtres humains, il a récemment été appliqué au développement de l'IA par des chercheurs universitaires et des instituts politiques. Le premier point concerne le consentement et la transparence relatifs aux droits individuels lors de l'utilisation de systèmes d'IA. Le deuxième point concerne la garantie que les systèmes d'IA ne causent pas de dommages, comme l'amplification des préjugés. Enfin, le troisième point concerne la répartition équitable de l'accès à l'IA.

D'autres idées courantes concernant les principes d'éthique de l'IA sont les suivantes :

- Transparence et responsabilité.

- Développement et utilisation axés sur l'homme.

- La sécurité.

- Durabilité et impact.

Pourquoi l'éthique de l'IA est-elle importante ?

L'IA est une technologie conçue par des humains pour reproduire, augmenter ou remplacer l'intelligence humaine. Ces outils s'appuient généralement sur de grands volumes de données de différents types pour développer des connaissances. Des projets mal conçus, basés sur des données erronées, inadéquates ou biaisées, peuvent avoir des conséquences imprévues et potentiellement néfastes. En outre, les progrès rapides des systèmes algorithmiques signifient que, dans certains cas, la manière dont l'IA est parvenue à ses conclusions n'est pas claire, de sorte que les humains s'appuient essentiellement sur des systèmes qu'ils ne peuvent pas expliquer pour prendre des décisions susceptibles d'avoir une incidence sur la société.

Un cadre éthique pour l'IA est important car il met en évidence les risques et les avantages des outils d'IA et établit des lignes directrices pour leur utilisation responsable. L'élaboration d'un système de principes moraux et de techniques permettant d'utiliser l'IA de manière responsable exige que l'industrie et les parties intéressées examinent des questions sociales majeures et, en fin de compte, la question de savoir ce qui fait de nous des êtres humains.

Quels sont les enjeux éthiques de l'IA ?

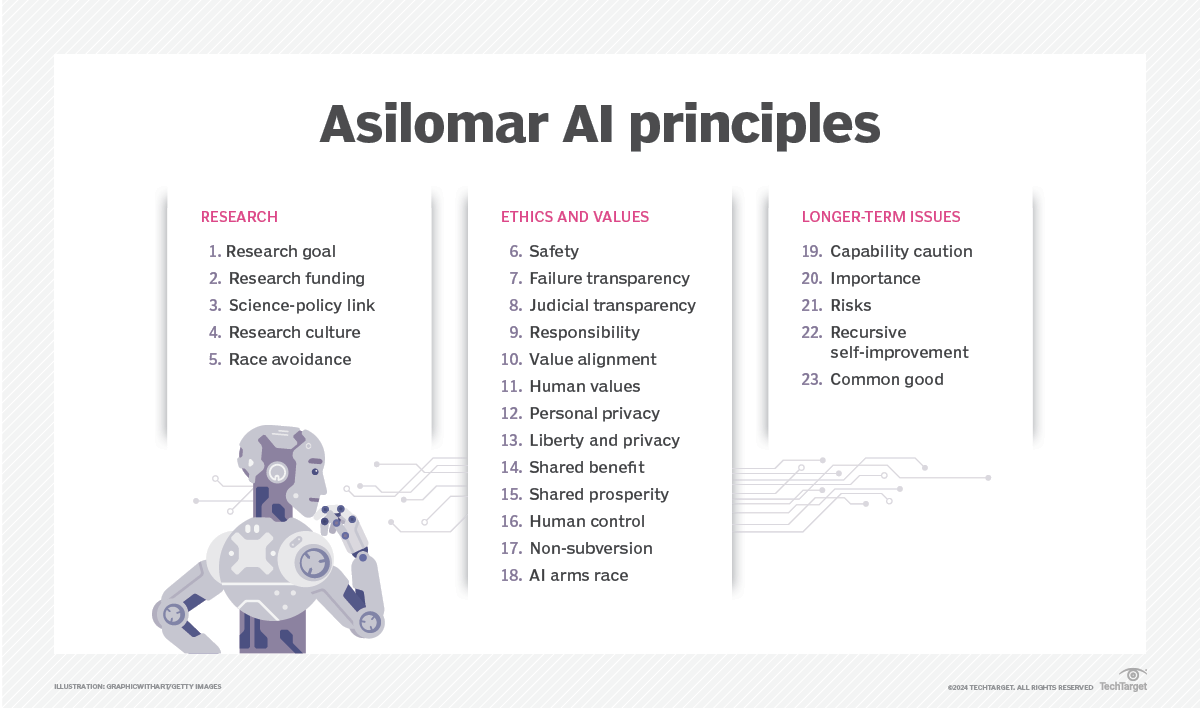

Les entreprises sont confrontées aux défis éthiques suivants dans leur utilisation des technologies de l'IA :

- Explicabilité. Lorsque les systèmes d'IA ne fonctionnent pas correctement, les équipes doivent être en mesure de remonter une chaîne complexe de systèmes algorithmiques et de processus de données pour en trouver la raison. Les organisations qui utilisent l'IA doivent être en mesure d'expliquer les données sources, les données résultantes, ce que font leurs algorithmes et pourquoi ils le font. "L'IA doit avoir un fort degré de traçabilité pour garantir que, si des dommages surviennent, ils peuvent être remontés jusqu'à la cause", a déclaré Adam Wisniewski, directeur technique et cofondateur d'AI Clearing.

- Responsabilité. La société est encore en train de déterminer les responsabilités lorsque les décisions prises par les systèmes d'IA ont des conséquences catastrophiques, notamment la perte de capital, de santé ou de vie. Le processus d'examen de la responsabilité des conséquences des décisions prises par l'IA devrait impliquer une série de parties prenantes, notamment des juristes, des régulateurs, des développeurs d'IA, des organismes de déontologie et des citoyens. L'un des défis consiste à trouver le juste équilibre dans les cas où un système d'IA pourrait être plus sûr que l'activité humaine qu'il reproduit, mais qu'il pose tout de même des problèmes, comme lorsqu'il s'agit d'évaluer les mérites des systèmes de conduite autonome qui causent des accidents mortels, mais beaucoup moins que les humains.

- L'équité. Dans les ensembles de données impliquant des informations personnellement identifiables, il est extrêmement important de s'assurer qu'il n'y a pas de préjugés en termes de race, de sexe ou d'ethnicité.

- L'éthique. Les algorithmes d'IA peuvent être utilisés à des fins autres que celles pour lesquelles ils ont été créés. Par exemple, des personnes pourraient utiliser la technologie pour créer des copies conformes d'autres personnes ou pour manipuler d'autres personnes en diffusant de fausses informations. M. Wisniewski a déclaré que ces scénarios devraient être analysés au stade de la conception afin de minimiser les risques et d'introduire des mesures de sécurité pour réduire les effets négatifs dans de tels cas.

- La protection de la vie privée. Étant donné que l'apprentissage de l'IA nécessite d'énormes quantités de données, certaines entreprises utilisent des données publiques, telles que des données provenant de forums en ligne ou de publications sur les médias sociaux, pour l'apprentissage. D'autres entreprises comme Facebook, Google et Adobe ont également ajouté dans leurs politiques qu'elles pouvaient utiliser les données des utilisateurs pour entraîner leurs modèles d'IA, ce qui a donné lieu à des controverses sur la protection des données des utilisateurs.

- Déplacement d'emplois. Au lieu d'utiliser l'IA pour faciliter le travail des humains, certaines organisations peuvent choisir d'utiliser des outils d'IA pour remplacer complètement des emplois humains. Cette pratique a été controversée, car elle affecte directement ceux qu'elle remplace, et les systèmes d'IA sont encore sujets à des hallucinations et à d'autres imperfections.

- L'environnement. Les modèles d'IA nécessitent beaucoup d'énergie pour leur formation et leur fonctionnement, ce qui laisse une empreinte carbone importante. Si l'électricité qu'ils utilisent est principalement produite à partir de charbon ou de combustibles fossiles, elle est encore plus polluante.

La diffusion publique et l'adoption rapide d'applications d'IA générative, telles que ChatGPT et Dall-E, qui sont formées à partir de données existantes pour générer de nouveaux contenus, amplifient les questions éthiques liées à l'IA, en introduisant des risques liés à la désinformation, au plagiat, à la violation des droits d'auteur et aux contenus préjudiciables.

Quels sont les avantages de l'IA éthique ?

L'accélération rapide de l'adoption de l'IA dans les entreprises a coïncidé avec - et, dans de nombreux cas, a contribué à alimenter - deux tendances majeures : la montée de la centricité sur le client et la montée de l'activisme social.

"Les entreprises sont récompensées non seulement pour la fourniture de produits et de services personnalisés, mais aussi pour le respect des valeurs des clients et la contribution à la société dans laquelle elles opèrent", a déclaré Sudhir Jha, PDG de Brighterion et vice-président exécutif de Mastercard.

L'IA joue un rôle considérable dans la manière dont les consommateurs interagissent avec une marque et la perçoivent. Une utilisation responsable est nécessaire pour garantir un impact positif. Outre les consommateurs, les employés veulent se sentir bien dans les entreprises pour lesquelles ils travaillent. "L'IA responsable" peut contribuer grandement à retenir les talents et à assurer la bonne exécution des opérations d'une entreprise", a déclaré M. Jha.

Qu'est-ce qu'un code d'éthique de l'IA ?

Selon Jason Shepherd, directeur général d'Atym, une approche proactive de l'IA éthique passe par la prise en compte des trois domaines clés suivants :

- Politique. Il s'agit notamment d'élaborer le cadre approprié pour favoriser la normalisation et établir des réglementations. Des documents tels que les principes d'Asilomar en matière d'IA peuvent être utiles pour entamer la conversation. Les agences gouvernementales aux États-Unis, en Europe et ailleurs ont lancé des efforts pour garantir une IA éthique, et une série de normes, d'outils et de techniques provenant d'organismes de recherche, de fournisseurs et d'institutions universitaires sont disponibles pour aider les organisations à élaborer une politique en matière d'IA. Voir la section "Ressources pour le développement d'une IA éthique" ci-dessous. Les politiques d'éthique en matière d'IA doivent prévoir la manière de traiter les questions juridiques en cas de problème. Les entreprises devraient envisager d'intégrer les politiques d'IA dans leurs propres codes de conduite. Mais l'efficacité dépend du respect des règles par les employés, ce qui n'est pas toujours réaliste lorsque l'argent ou le prestige sont en jeu.

- Éducation. Les dirigeants, les "data scientists", les employés de première ligne et les consommateurs doivent tous comprendre les politiques, les considérations clés et les effets négatifs potentiels de l'IA contraire à l'éthique et des fausses données. L'une des grandes préoccupations est le compromis entre la facilité d'utilisation autour du partage des données et de l'automatisation de l'IA et les répercussions négatives potentielles d'un partage excessif ou d'une automatisation néfaste. "En fin de compte, la volonté des consommateurs de prendre proactivement le contrôle de leurs données et de prêter attention aux menaces potentielles permises par l'IA est une équation complexe basée sur une combinaison de gratification instantanée, de valeur, de perception et de risque", a déclaré M. Shepherd.

- Technologie. Les dirigeants doivent également concevoir des systèmes d'IA capables de détecter automatiquement les données falsifiées et les comportements contraires à l'éthique. Il ne s'agit pas seulement d'examiner l'IA propre à l'entreprise, mais aussi de vérifier que les fournisseurs et les partenaires n'utilisent pas l'IA à des fins malveillantes. Parmi les exemples, on peut citer le déploiement de vidéos et de textes falsifiés pour nuire à un concurrent ou l'utilisation de l'IA pour lancer des cyberattaques sophistiquées. Ce problème s'aggravera à mesure que les outils d'IA se banaliseront. Pour lutter contre cet effet boule de neige potentiel, les organisations doivent investir dans des mesures défensives ancrées dans une infrastructure d'IA ouverte, transparente et fiable. Shepherd pense que cela donnera lieu à l'adoption de la confiance qui fournit une approche au niveau du système pour automatiser l'assurance de la protection de la vie privée, garantir la confiance dans les données et détecter l'utilisation non éthique de l'IA.

Exemples de codes d'éthique de l'IA

Un code d'éthique de l'IA peut énoncer les principes et fournir la motivation nécessaire à un comportement approprié. Par exemple, le code d'éthique de Mastercard en matière d'IA est résumé ci-dessous :

- Un système d'IA éthique doit être inclusif, explicable, positif par nature et utiliser les données de manière responsable.

- Un système d'IA inclusif n'est pas biaisé. Les modèles d'IA doivent être formés à l'aide d'ensembles de données vastes et diversifiés afin d'atténuer les préjugés. Ils doivent également faire l'objet d'une attention et d'une mise au point constantes afin de modifier les attributs problématiques appris au cours du processus de formation.

- Un système d'IA explicable doit être gérable pour que les entreprises puissent le mettre en œuvre de manière éthique. Les systèmes doivent être transparents et explicables.

- Un système d'IA doit avoir et conserver une finalité positive. Dans de nombreux cas, il peut s'agir d'aider les humains dans leur travail, par exemple. Les systèmes d'IA doivent être mis en œuvre de manière à ce qu'ils ne puissent pas être utilisés à des fins négatives.

- Les systèmes d'IA éthiques doivent également respecter les droits relatifs à la confidentialité des données. Même si les systèmes d'IA ont généralement besoin d'une grande quantité de données pour s'entraîner, les entreprises ne devraient pas sacrifier les droits à la confidentialité des données de leurs utilisateurs ou d'autres personnes pour y parvenir.

Des entreprises telles que Mastercard, Salesforce et Lenovo se sont engagées à signer un code de conduite volontaire en matière d'IA, ce qui signifie qu'elles s'engagent à développer et à gérer de manière responsable les systèmes d'IA générative. Ce code s'appuie sur l'élaboration d'un code d'éthique canadien concernant l'IA générative, ainsi que sur les contributions recueillies auprès d'un ensemble de parties prenantes.

Google a également établi ses propres principes directeurs en matière d'IA, qui mettent l'accent sur la responsabilité, les avantages potentiels, l'équité, la protection de la vie privée, la sécurité, les valeurs sociales et autres valeurs humaines de l'IA.

Ressources pour le développement d'une IA éthique

Voici un échantillon du nombre croissant d'organisations, de décideurs politiques et de normes réglementaires qui se concentrent sur le développement de pratiques éthiques en matière d'IA :

- Institut AI Now. L'institut se concentre sur les implications sociales de l'IA et sur la recherche politique en matière d'IA responsable. Les domaines de recherche comprennent la responsabilité algorithmique, les préoccupations antitrust, la biométrie, les droits des travailleurs en matière de données, les modèles d'IA à grande échelle et la protection de la vie privée. Le rapport "AI Now 2023 Landscape : Confronting Tech Power" propose une analyse approfondie de nombreuses questions éthiques qui peuvent être utiles à l'élaboration de politiques éthiques en matière d'IA.

- Berkman Klein Center for Internet & Society à l'université de Harvard. Le centre encourage la recherche sur les grandes questions liées à l'éthique et à la gouvernance de l'IA. Les recherches soutenues par le centre ont abordé des sujets tels que la qualité de l'information, les algorithmes dans la justice pénale, le développement de cadres de gouvernance de l'IA et la responsabilité algorithmique.

- Comité technique mixte 21 du CEN-CENELEC sur l'intelligence artificielle. Le JTC 21 est une initiative permanente de l'Union européenne (UE) pour diverses normes responsables en matière d'intelligence artificielle. Le groupe produit des normes pour le marché européen et informe la législation, les politiques et les valeurs de l'UE. Il spécifie également des exigences techniques pour caractériser la transparence, la robustesse et la précision des systèmes d'IA.

- Manuel de l'Institut pour la technologie, l'éthique et la culture. Le manuel ITEC est le fruit d'une collaboration entre le Markkula Center for Applied Ethics de l'université de Santa Clara et le Vatican, qui vise à élaborer une feuille de route pratique et progressive pour l'éthique des technologies. Le manuel ITEC comprend un modèle de maturité en cinq étapes avec des mesures spécifiques et mesurables que les entreprises peuvent prendre à chaque niveau de maturité. Il promeut également une approche opérationnelle pour la mise en œuvre de l'éthique en tant que pratique continue, semblable à DevSecOps pour l'éthique. L'idée de base est de réunir les équipes juridiques, techniques et commerciales au cours des premières phases de l'IA éthique afin d'éliminer les bogues à un moment où il est beaucoup moins coûteux de les corriger qu'après un déploiement responsable de l'IA.

- ISO/IEC 23894:2023 IT-AI-Guidance sur la gestion des risques. L'Organisation internationale de normalisation et la Commission électrotechnique internationale décrivent comment une organisation peut gérer les risques spécifiquement liés à l'IA. Les orientations peuvent aider à normaliser le langage technique caractérisant les principes sous-jacents et la manière dont ils s'appliquent au développement, à l'approvisionnement ou à l'offre de systèmes d'IA. Elles couvrent également les politiques, les procédures et les pratiques d'évaluation, de traitement, de surveillance, d'examen et d'enregistrement des risques. Il s'agit d'un document très technique qui s'adresse à des ingénieurs plutôt qu'à des experts commerciaux.

- Cadre de gestion des risques liés à l'IA du NIST. Ce guide du National Institute of Standards and Technology, destiné aux agences gouvernementales et au secteur privé, se concentre sur la gestion des nouveaux risques liés à l'IA et sur la promotion d'une IA responsable. Abhishek Gupta, fondateur et chercheur principal de l'Institut d'éthique de l'IA de Montréal, a souligné la profondeur du cadre du NIST, en particulier sa spécificité dans la mise en œuvre de contrôles et de politiques visant à mieux régir les systèmes d'IA dans différents contextes organisationnels.

- Nvidia NeMo Guardrails. Cette boîte à outils fournit une interface flexible pour définir des rails comportementaux spécifiques que les robots doivent suivre. Elle prend en charge le langage de modélisation Colang. Un responsable de la science des données a déclaré que son entreprise utilisait la boîte à outils open source pour empêcher un chatbot d'assistance sur le site web d'un avocat de fournir des réponses qui pourraient être interprétées comme des conseils juridiques.

- Institut Stanford pour l'intelligence artificielle centrée sur l'homme. La mission de l'HAI est de fournir des recherches et des conseils continus sur les meilleures pratiques en matière d'intelligence artificielle centrée sur l'homme. Une des premières initiatives en collaboration avec Stanford Medicine est "Responsible AI for Safe and Equitable Health" (IA responsable pour une santé sûre et équitable), qui aborde les questions d'éthique et de sécurité liées à l'IA dans les domaines de la santé et de la médecine.

- "Towards Unified Objectives for Self-Reflective AI" (Vers des objectifs unifiés pour une IA auto-réfléchissante). Rédigé par Matthias Samwald, Robert Praas et Konstantin Hebenstreit, ce document adopte une approche socratique pour identifier les hypothèses sous-jacentes, les contradictions et les erreurs par le biais d'un dialogue et d'un questionnement sur la véracité, la transparence, la robustesse et l'alignement des principes éthiques. L'un des objectifs est de développer des métasystèmes d'IA dans lesquels deux ou plusieurs modèles d'IA se complètent, se critiquent et améliorent leurs performances mutuelles.

- Recommandations du Forum économique mondial sur l'IA générative responsable (The Presidio Recommendations on Responsible Generative AI). Ces 30 recommandations orientées vers l'action aident à naviguer dans les complexités de l'IA et à exploiter son potentiel de manière éthique. Ce livre blanc comprend également des sections sur le développement et la diffusion responsables de l'IA générative, l'innovation ouverte, la collaboration internationale et le progrès social.

Ces organisations fournissent une série de ressources qui constituent une base solide pour le développement de pratiques éthiques en matière d'IA. L'utilisation de ces ressources comme cadre peut aider les organisations à s'assurer qu'elles développent et utilisent l'IA d'une manière éthique.

L'avenir de l'IA éthique

Certains affirment qu'un code d'éthique de l'IA peut rapidement devenir obsolète et qu'une approche plus proactive est nécessaire pour s'adapter à un domaine qui évolue rapidement. Arijit Sengupta, fondateur et PDG d'Aible, une plateforme de développement de l'IA, a déclaré : "Le problème fondamental d'un code d'éthique de l'IA est qu'il est réactif et non proactif. Nous avons tendance à définir des choses comme la partialité, à chercher la partialité et à essayer de l'éliminer - comme si c'était possible."

Une approche réactive peut avoir des difficultés à traiter les préjugés intégrés dans les données. Par exemple, si les femmes n'ont jamais obtenu de prêts au taux approprié, cela se retrouve dans les données de multiples façons. "Si l'on supprime les variables liées au sexe, l'intelligence artificielle se contentera de relever d'autres variables qui servent de substitut au sexe", explique M. Sengupta.

Il estime que l'avenir de l'IA éthique doit porter sur la définition de l'équité et des normes sociétales. Ainsi, par exemple, dans une banque de prêt, la direction et les équipes d'IA devraient décider s'ils veulent viser une considération égale, comme des prêts traités à un taux égal pour toutes les races ; des résultats proportionnels, où le taux de réussite pour chaque race est relativement égal ; ou un impact égal, qui garantit qu'un montant proportionnel de prêts est accordé à chaque race. L'accent doit être mis sur un principe directeur plutôt que sur quelque chose à éviter, a affirmé M. Sengupta.

La plupart des gens s'accordent à dire qu'il est plus facile et plus efficace d'enseigner aux enfants quels devraient être leurs principes directeurs plutôt que d'énumérer toutes les décisions possibles auxquelles ils pourraient être confrontés et de leur dire ce qu'il faut faire et ce qu'il ne faut pas faire. "C'est l'approche que nous adoptons avec l'éthique de l'IA", a déclaré M. Sengupta. "Nous disons à un enfant tout ce qu'il peut et ne peut pas faire, au lieu de lui fournir des principes directeurs et de lui permettre de trouver ses propres solutions.

Pour l'instant, les humains développent des règles et des technologies qui favorisent une IA responsable. Selon M. Shepherd, il s'agit notamment de programmer des produits et des offres qui protègent les intérêts humains et n'ont pas de préjugés à l'encontre de certains groupes, tels que les minorités, les personnes ayant des besoins particuliers et les pauvres. Ce dernier point est particulièrement préoccupant, car l'IA a le potentiel de déclencher une guerre sociale et économique massive, creusant davantage le fossé entre ceux qui peuvent s'offrir la technologie - y compris l'augmentation humaine - et ceux qui ne le peuvent pas.

La société doit également prévoir de toute urgence l'utilisation non éthique de l'IA par de mauvais acteurs. Les systèmes d'IA actuels vont des moteurs de règles fantaisistes aux modèles de ML qui automatisent des tâches simples, en passant par les systèmes d'IA générative qui imitent l'intelligence humaine. "Il faudra peut-être attendre des décennies avant de voir apparaître des IA plus sensibles, capables d'automatiser leurs propres comportements contraires à l'éthique à une échelle que les humains ne seraient pas en mesure de suivre", a déclaré M. Shepherd. Mais compte tenu de l'évolution rapide de l'IA, il est temps de mettre au point les garde-fous qui permettront d'éviter ce scénario.

L'avenir pourrait voir une augmentation des procès, comme celui que le New York Times a intenté contre OpenAI et Microsoft concernant l'utilisation d'articles du Times comme données d'entraînement à l'IA. L'OpenAI s'est également retrouvée dans d'autres controverses qui pourraient influencer l'avenir, comme le fait qu'elle envisage de passer à un modèle d'entreprise à but lucratif. Elon Musk a également annoncé un modèle d'IA qui a suscité la controverse tant pour les images qu'il peut créer que pour l'impact environnemental et social de l'emplacement physique dans lequel il est placé. L'avenir de l'IA pourrait continuer à voir les entreprises d'IA repousser les limites de l'éthique, ainsi que les préoccupations éthiques, sociales et économiques, et les gouvernements et les citoyens réclamer des mises en œuvre plus éthiques.

Les progrès récents de l'IA générative ont également soulevé la question de la mise en œuvre éthique de ces systèmes. En savoir plus sur l'éthique de l'IA et l'IA générative.