Windows Server 2008 R2 : l’accent est mis sur la virtualisation, mais pas seulement

Le dernier OS serveur de Microsoft mise sur ses fonctions de virtualisation, sur son intégration avec Windows 7 et sur une multitude d'améliorations en matière d'administration pour séduire. Il s'agit de notamment de réduire les coûts d'exploitation par rapport aux versions existantes, de simplifier l'intégration avec les parcs Windows 7, mais aussi d'offrir une réponse efficace et économique à VMware. L'enjeu est important pour Microsoft : 65% de la base installée Windows Server en France utiliserait encore Windows 2000 Server et Windows Server 2003.

AU SOMMAIRE...

- Windows 2008 Server R2 joue la carte de la virtualisation et de la filiation avec Windows 7

- Remote Desktop Services : virtualiser les applications et les postes de travail

- Fin de la route pour Windows sur Itanium

- Hyper-V arrive à maturité dans Windows Server 2008 R2

- Remote Desktop Services : virtualiser les applications et les postes de travail

- Fin de la route pour Windows sur Itanium

- Des fonctions spécifiquement conçues pour les postes clients Windows 7

Comme Windows 7, Windows Server 2008 R2, la dernière version du système d’exploitation serveur de Microsoft, est arrivé dans les bacs des revendeurs le 22 octobre 2009. L’arrivée de cette nouvelle mouture est importante pour l'éditeur, notamment en France, où malgré le support que rencontre le libre, l'activité serveur de Microsoft est florissante. Ainsi alors que les ventes de Microsoft sont largement en recul dans le monde, l'activité serveur en France a poursuivi sa marche en avant en 2009. L'Hexagone compterait près de 1,2 million de serveurs en activité sous Windows Server, dont 60% dans les grandes entreprises et 40% dans les PME. Environ 15% de ces machines fonctionneraient encore sous Windows 2000 Server, et une bonne moitié sous Windows Server 2003 (SP2 et R2). Ces "vieilles" moutures sont en fin de support. La fin de vie de Windows Server 2000 sera ainsi prononcée en juillet 2010, date à laquelle Microsoft prononcera aussi la fin de la phase de support standard de Windows Server 2003. Pour les entreprises, Windows Server 2008 R2 est donc l'occasion de réfléchir à la migration des "vieux" Windows.

Afin de les séduire, Microsoft met en avant le support par Windows Server 2008 R2 des dernières technologies processeurs (virtualisation, économies d'énergie…). Il met aussi en avant le soin apporté aux mises à jour et à la fourniture d'outils de migration pour faciliter la migration des rôles serveurs les plus importants vers Windows Server 2008 R2. Microsoft fait aussi du nouvel OS le fer de lance de ses efforts sur le marché de la virtualisation de serveur et met enfin en avant les gains de productivité attendus des nouveaux outils d'administration ainsi que l'intégration de certaines fonctions de l'OS serveur avec Windows 7.

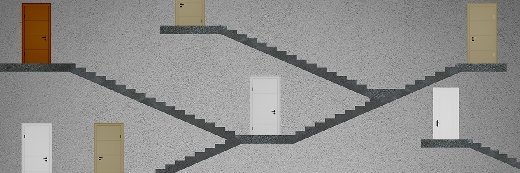

Remote Desktop Services : virtualiser les applications et les postes de travail

Windows 2008 Server R2 apporte aussi une refonte en profondeur des fonctions de virtualisation d’application et de «déport d’écran». Sans égaler les services spécialisés de Citrix et de son XenApp, les Remote Desktop Services (ex-Terminal Services) permettent comme auparavant de centraliser l’exécution des applications des utilisateurs sur un ou plusieurs serveurs et d’en déporter l’affichage sur leur poste (services RemoteApp). Mais grâce à l’inclusion d’un nouveau broker de session, ils peuvent aussi distribuer des environnements de travail virtualisés complets (technologie dite VDI ou Virtual Desktop Infrastructure).

Ces « PC virtuels » sont idéalement hébergés sur un serveur Hyper-V et ils peuvent fonctionner sous Windows XP, Windows Vista ou Windows 7. Leur affichage est là encore déporté sur le poste client via RDP. Sur le poste client, l'intégration étroite du client RDP dans Windows 7 signifie que grâce aux services Bureau à distance, les ressources virtuelles, y compris les applications, les suites d'applications et des bureaux virtuels entiers, sont accessibles de la même façon que les applications locales. Les performances d'affichage des applications déportées sont également dopées et désormais proches, selon Microsoft, de celles observées sur un ordinateur local.

Et elles devraient encore s’en rapprocher un peu plus avec l’arrivée du SP1 de l’OS grâce à la technologie RemoteFX issue du rachat, l’an passé, de Calista. RemoteFX doit notamment permettre de profiter, à distance, de tous les enrichissements visuels des interfaces graphiques : vidéo avec audio totalement synchronisée, Silverlight, graphismes 3D (jusqu’à certaines applications OpenGL), et bien sûr Aero, comme l’indique Max Hermann, membre de l’équipe marketing de Windows Server Remote Desktop Services chez Microsoft.

Optimisé pour tirer parti des serveurs 64 bit

Pour la première fois, Windows Server ne supporte plus les machines à base de puces 32 bit, mais seulement les serveurs équipés de processeurs 64 bit AMD ou Intel. Cela ne devrait guère occasionner de problèmes matériel. Intel et AMD proposent des processeurs 64 bit depuis 2003 et la majorité des serveurs en activité en sont équipés. En revanche, il faudra bien tester la compatibilité des applications avant toute migration. Le support de ces puces 64 bit a été raffiné pour permettre notamment une bien meilleure gestion de l'énergie. ?Selon des tests menés conjointement par Intel et Microsoft, Windows Server 2008 R2 permet des gains de consommation de l'ordre de 10 à 15% sur un serveur Xeon récent par rapport à Windows Server 2003. HP et Microsoft ont mesuré des gains pouvant atteindre 18% avec les dernières générations de puces Opteron. Les gains sont encore plus impressionnants en environnement virtualisé, puisqu'un serveur Xeon 5540 sous Windows Server 2008 R2 avec Hyper-V 2.0 en mode "idle" se montre entre 30 et 37% plus économe en énergie que le même serveur sous Windows Server 2008 et Hyper-V.?Il est toutefois à noter que pour profiter pleinement des fonctions de virtualisation de l'OS, il faudra veiller à ce que le serveur soit équipé de puces 64 bit récentes dotées d’extensions d’accélération de la virtualisation (VT chez Intel ou AMD-V chez AMD). Ces extensions sont en effet nécessaires pour la couche de virtualisation intégrée à Windows 2008 Server R2, Hyper V 2.0 (voir à ce propos l’article sur Hyper-V en page 5).

Poursuivant dans la lignée des efforts initiés avec Windows Server 2008, cette mouture de l'OS renforce les outils d'administration et d'automatisation destinés à simplifier au quotidien l'administration des rôles serveurs de Windows. C'est par exemple le cas avec les nouvelles consoles d'administration des services d'annuaire et du nouveau centre d’administration Active Directory, qui unifie en une seule et même interface plusieurs outils d’administration d’annuaire jusqu’alors éclatés.

Une administration simplifiée

Microsoft a aussi multiplié les analyseurs de meilleures pratiques de telle sorte que chaque rôle dispose désormais de son analyseur afin d’assurer que les configurations appliquées par l’administrateur sont conformes aux meilleures pratiques du moment. Enfin, Microsoft fournit avec Windows Server 2008 R2 un nouvel outil de backup qui permet de paramétrer de façon très granulaire ses sauvegardes mais aussi de préserver l’état du système d’exploitation dans les sauvegardes.

Une autre grande nouveauté est l'arrivée de PowerShell 2.0 désormais utilisé en arrière plan de la plupart des consoles d'administration graphiques de Windows. PowerShell est à la fois un interpréteur de lignes de commande et un langage de script, une sorte de mariage à la sauce Windows entre un Bash et un Perl. Il permet de piloter localement ou à distance l'ensemble des services de l'OS. Avec cette version 2.0, PowerShell s'enrichit de plus de 240 nouvelles applets de commande (baptisées Cmdlets), ainsi que d'un environnement de développement intégré de bon niveau destiné à simplifier la création de scripts.

Du fait de l'intégration du noyau .Net dans l'ensemble des éditions de Windows Server 2008 R2, y compris l'édition coeur (ou Windows Core), PowerShell est désormais accessible dans les versions coeur. Cela permet aux administrateurs Windows de construire des piles système compactes n'utilisant que les services et rôles requis pour une tâche donnée et de les piloter localement ou à distance en mode ligne de commande (dite Server Core).

De nouveaux outils de gestion du stockage

Alors que le volume des données non structurées continue de croitre à une vitesse exponentielle dans les entreprises et que la gestion de ces données devient de plus en plus consommatrice de temps et de ressources, Windows Server 2008 R2 tente d’apporter une solution pragmatique avec FCI (File Classification Infrastructure), un ensemble de services dont la vocation est de faciliter la classification des fichiers et ce faisant, leur administration. FCI est d’autant plus utile que Windows Server est toujours fréquemment utilisé pour servir de serveur de fichiers soit sur un serveur doté de ses propres ressources de stockage soit en frontal de baies SAN.

FCI s’installe de façon optionnelle avec le rôle de partage de fichiers du système d’exploitation pour serveurs de Microsoft - il faut en fait installer l’option Gestionnaire de ressources du serveur de fichiers (FSRM). Comme son nom l’indique, FCI a pour objectif de faciliter la classification des fichiers présents sur un serveur en fournissant des outils automatisés de classification et de marquage de fichiers. Par exemple, FCI peut servir à marquer tous les fichiers contenant le texte «confidentiel», dans une catégorie particulière. FSRM, de son côté, apporte les outils et les moteurs de règles nécessaires pour agir en fonction de ces classifications.Il peut par exemple déplacer automatiquement les fichiers en fonction de leur classification, mais aussi de leur âge ou de leur emplacement vers un espace de stockage moins coûteux, ou sur un espace de stockage compressé...

La bonne nouvelle est que les services FSRM et FCI sont gratuits à l’usage, quand les grands du stockage font payer une fortune leurs outils de gestion de ressources de stockage...

Fin de la route pour Windows sur Itanium

Annoncée début avril, la décision de Microsoft d'abandonner le développement de Windows Server pour les puces Intel Itanium au-delà de Windows Server 2008 R2 marque la fin des ambitions de l’éditeur d’étendre sa plate-forme serveur à d’autres architectures que x86. Certes Windows n’a jamais connu un succès de masse sur la plate-forme Itanium. Selon Intel, l’OS comptait pour environ 5% des déploiements (souvent liés à SQL Server) soit très loin derrière le principal OS Itanium, HP-UX. Microsoft n’est d’ailleurs pas le premier à quitter le navire Itanium sur le même constat. Red Hat a lui aussi annoncé son intention de ne plus supporter les plates-formes IA-64 à compter du prochain Red Hat Entreprise Linux 6. Le problème est que certaines entreprises avaient fait le pari de Windows sur Itanium notamment pour déployer des bases SQL Server à des tarifs bien plus raisonnables que ceux des concurrents Unix. Et pour ceux-là, la déception est grande. Comme l’explique Joan Jacobs, le président et directeur exécutif de l'Alliance Itanium Solutions, un groupe d’utilisateurs de systèmes Itanium, "d’après ce que disent nos membres, les clients exécutant Windows sur Itanium sont aujourd'hui déçus par la décision de Microsoft".

Un soutien déclinant pour les systèmes Itanium

Microsoft met fin à son soutien Itanium, car l'architecture x86 a énormément progressé, explique Dan Reger l’un des chef de projets seniors de l’éditeur. Intel a récemment lancé ses Xeon 7500 «Nehalem-EX», tandis qu’AMD dévoilait une puce à 12-coeurs, l’Opteron 6100 «Magny-Cours». Aux yeux de Microsoft, les capacités des processeurs x86 ont rattrapé Itanium. "L'évolution naturelle de l’architecture x86 64-bit (ou «x64») a abouti à la création de processeurs et de serveurs qui offrent l'évolutivité et la fiabilité nécessaires pour les applications critiques», indique Reger. Microsoft qui avait espéré faire de Windows sur Itanium une alternative aux grands Unix, ne voit donc sans doute plus d’intérêt de maintenir ce portage et mise sur les grands serveurs x86 sous Windows pour accomplir la même mission. Seul lot de consolation pour les utilisateurs Windows sur Itanium, Microsoft a annoncé qu'il offrira un support étendu pour Windows Server 2008 R2 sur la plate-forme IA-64 jusqu'au 10 Juillet 2018.

Windows Server 2008 R2 apporte plusieurs améliorations à la technologie Hyper-V qui étaient attendues depuis sa sortie initiale. Ces mises à jour de la plate-forme de virtualisation de Microsoft portent notamment sur la disponibilité des VM et sur le stockage des machines virtuelles. Pour les utilisateurs Windows qui attendaient la mise à jour d’Hyper-V pour faire le pas vers la virtualisation, Windows 2008 R2 est la réponse.

La nouveauté la plus attendue dans Hyper-V 2.0 est sans conteste la mise en oeuvre de la migration à chaud des machines virtuelles, qui vient supplanter le mécanisme existant de «Quick Migration» jusqu’alors intégré à Hyper-V.

Enfin des migrations à chaud

Microsoft n’avait peut-être pas tord de dire que la plupart des entreprises n’ont pas besoin du déplacement à chaud. Mais l’absence de cette fonction était devenu une source de railleries pour beaucoup, alors que XenServer et ESX en disposaient depuis longtemps. Microsoft a donc fini par revoir sa copie.

D’un point de vue technique, la refonte de l’architecture requise pour permettre à Hyper-V de supporter la migration en direct a pas mal d’implications. Ainsi Hyper-V 1.0 plaçait une VM en état enregistré (basiquement la VM sauvegarde le contenu de sa mémoire sur disque) avant de la déplacer sur un nouveau serveur, qui devait alors recharger l’état du disque en mémoire pour reprendre à son compte la VM. D’où le temps de plusieurs secondes nécessaire à la bascule. Pour éliminer ce délai, Microsoft a dû développer une sorte de mécanisme de pré-copie qui migre la majorité de l’état la machine virtuelle, tout en lui permettant de continuer à fonctionner normalement.

Une fois cette copie initiale terminée, Live Migration met en pause la machine virtuelle source, copie les dernières modifications effectuées, et transfère le contrôle au nouvel hôte qui redémarre la VM quasi instantanément. Le fait que l’architecture combine pause et copie différentielle implique considérablement moins de transfert de données, se traduit par une vraie migration en direct, tout comme dans les autres plates-formes de virtualisation.

Des améliorations pour Hyper-V au menu de Windows Server 2008 R2 SP1

Alors qu'Hyper-V commence à séduire les grands comptes (la Maaf présentait ainsi, lors de la seconde journée des Techdays 2010, un projet massif de virtualisation sous Hyper V 2.0 couplé à une solution SAN répliquée fournie par Hitachi Data Systems), Microsoft a profité de sa conférence pour évoquer quelques-unes des améliorations attendues pour le premier Service Pack de Windows Server 2008 R2, dont on présume qu'il devrait faire son apparition d'ici l'été ou l'automne.

Ceux qui espéraient un éventuel support de la virtualisation d'entrées-sorties (VT-d chez Intel et IOMMU chez AMD) devront patienter un peu plus longtemps et l'arrivée d'Hyper-V 3.0, sans doute, avec la prochaine mouture du noyau Windows, attendue avec le futur "Windows Server 8" (mi ou fin 2011, si Microsoft suit son rythme habituel de développement, soit 18 à 24 mois entre les versions de Windows Server).

En revanche, le premier Service Pack devrait apporter de sensibles améliorations du côté de la gestion mémoire avec le support de l'allocation dynamique de mémoire, une technologie qui permettra d'allouer à la volée de la mémoire supplémentaire à des machines virtuelles qui en auraient besoin en "empruntant" de la mémoire non utilisée par d'autres VM.

Petit bémol toutefois, la technologie supposera que les OS clients dans les VM supportent l'ajout et le retrait à chaud de mémoire vive (ce qui est toutefois le cas de la plupart des versions récentes de Windows et des distributions Linux récentes de Red Hat et Novell).

Pour permettre la migration à chaud des VM, Microsoft a aussi du repenser la façon dont Windows Failover Clustering interagit avec les ressources de stockage. Tant dans la version originale de Windows Server 2008 que dans R2, Hyper-V s’appuie sur les fonctions de Failover Clustering de Windows. Dans la première mouture toutefois, l'architecture de Failover de Microsoft ne prévoyait rien en matière de stockage, ce qui fait qu’en cas de défaillance d’une VM, les fonctions de cluster basculaient l’intégralité des ressources de stockage sur lesquelles était localisée cette VM vers un autre serveur. En raison de cette limitation, Microsoft préconisait dans les scénarios de haute disponibilité avec Hyper-V 1.0 de limiter le nombre de machines virtuelles à une par LUN. Un vrai casse-tête d’administration pour les responsables système et stockage.

Un mécanisme de cluster pour le stockage

Dans Hyper-V 2.0, Microsoft a ajouté une nouvelle fonction baptisée Cluster Shared Volumes (CSV) . Les CSV s’appuient sur le système de fichier NTFS et permettent à plusieurs hôtes d’accéder simultanément à la même ressource disque. Mais comme NTFS n'a pas de mécanisme de verrouillage pour permettre à plusieurs hôtes l’accès simultané à un volume, une couche supplémentaire de gestion a été ajoutée pour garantir que tous les nœuds du cluster sont conscients de qui est propriétaire - et donc gère et modifie - quels fichiers et dossiers. Les différents noeuds du cluster (en fait les serveurs hôtes virtualisés avec Hyper-V) interrogent la couche de gestion CSV avant d'apporter des modifications aux fichiers et dossiers permettant un véritable accès concurrent par plusieurs serveurs à un seul volume NTFS.

Le bénéfice immédiat est qu’il est désormais possible d’héberger plusieurs machines virtuelles sur un LUN unique, ce qui réduit considérablement le nombre d’unités logiques et simplifie grandement l’administration. Le cluster peut en effet effectuer une opération de failover sur une unique VM sans affecter l’intégralité d’une ressource disque. Il est à noter que l’usage des services de clusters présente d'autres avantages notamment en matière de haute disponibilité. La solution assure ainsi la redirection dynamique des entrées/sorties (SAN et LAN) en cas de défaillance d'un lien réseau.

Réduire les coûts de la virtualisation

Avec la sortie de vSphere 4.0, VMware a considérablement élevé le niveau technique de sa plate-forme, mais également dopé singulièrement le coût de la virtualisation, en particulier pour les petites et moyennes entreprises. La réponse de Microsoft est particulièrement agressive dans la mesure où, pour les comptes Windows, Hyper-V est un rôle gratuit. Et ce avec l’ensemble de ses fonctions dont la haute disponibilité et la migration à chaud (il faut toutefois s’acquitter des licences adéquates de System Center VMM pour gérer des environnements à plusieurs serveurs et piloter simplement les fonctions de migration. Le résultat est une plate-forme de virtualisation à un prix défiant toute concurrence, en tout cas pour les comptes Windows.

Microsoft a également ajouté plusieurs améliorations bienvenues à Hyper-V 2.0. La première a pour nom Dynamic Virtual Machine Storage et permet l’ajout et le retrait à chaud de ressources disques dans une machine virtuelle.

L’éditeur de Redmond a également ajouté à cette mouture le support des extensions de virtualisation des dernières puces Intel et AMD et notamment les fonctions de gestion de pages mémoires EPT (Intel) et RVI (AMD). La fonction dite de «Core Parking» permet, quant à elle, de réduire la consommation des serveurs virtualisés en concentrant les VM sur les coeurs processeurs actifs, ce qui permet de mettre en sommeil les coeurs non utilisés. Côté réseau, le support des Jumbo Frames Ethernet dans Hyper-V améliore également les performances de transfert pour certains types d’applications. Bref, c’est un nombre conséquent d’améliorations qu’apporte Hyper-V 2.0.?Bien sûr, cela ne suffit pas encore à faire de la plate-forme de Microsoft l’égale de celle de VMware, ne serait-ce que parce que l’offre d’outils d’administration de Microsoft reste encore inférieure à celle de VMware.

Mais Hyper-V 2.0 est bien suffisant pour la plupart des besoins de virtualisation de services d'infrastructure et il peut encore être amélioré via des outils tiers comme Citrix Essentials, qui ajoute des fonctions précieuses d’administration du stockage, de lab management ou de reprise après désastre, et ce pour un coût sensiblement inférieur à celui des offres de VMware. De quoi faire réfléchir en ces temps de disette budgétaire. Notons pour terminer que les limitations de licence restent inchangées par rapport à Windows Server 2008 et qu’il est fortement recommandé d'opter pour Windows Server Datacenter Edition pour bénéficier d'un nombre illimité de machines virtuelles Windows par serveur physique. A défaut, l'acquisition d’une licence de Windows Server 2008 R2 édition entreprise donne le droit d'héberger jusqu'à 4 VM.

System Center Essentials 2010 : un compagnon idéal pour l'administration d'Hyper-V dans les PME

Si Windows Server 2008 R2 a apporté un véritable coup de fouet à la virtualisation sous Windows grâce à l’inclusion d’Hyper-V, il manquait encore à Microsoft une solution simple et économique pour administrer la virtualisation pour les PME. Avec System Center Essentials 2010, l’éditeur dispose sans aucun doute de quoi combler ce vide. SCE 2010 vise les environnements intégrant quelques dizaines de serveurs (avec un maximum de 50 serveurs physiques ou logiques) et pour la partie gestion des postes de travail, jusqu’à 500 PC. Il est donc bien adapté aux besoins des PME de taille moyenne.

Cette nouvelle édition est une refonte en profondeur par rapport à l’édition précédente, notamment en terme d’interface. Si elle reprend les fonctions de gestion du cycle de vie de la mouture antérieure (gestion et application des correctifs, télédistribution et téléinstallation de logiciels sur les postes serveurs et clients), de même que les fonctions de supervision de serveurs et d’applications (empruntées à System Center Operations Manager 2007), elle ajoute (enfin) la gestion des environnements virtuels.

Des fonctions de gestion des environnements virtuels...

Ce support des environnements virtuels a été obtenu grâce à l’intégration des principales fonctions de System Center Virtual Machine Manager 2008 R2 - à l’exception notable de la gestion des environnements VMware.

Cette intégration permet de gérer et déployer des environnements virtuels sous Hyper-V R2 à un coût très raisonnable. Depuis la console d’administration de SCE 2010, l’administrateur peut ainsi activer très simplement le rôle Hyper-V sur un serveur physique, puis déployer et administrer des machines virtuelles. Parmi les fonctions disponibles figurent bien sûr la création de nouvelles VM (manuellement ou depuis un modèle existant), ou la conversion d’une machine physique en machine virtuelle grâce aux outils de P2V (migration du physique vers le virtuel) intégrés. SCE 2010 permet aussi d’effectuer en quelques clics la migration d’une machine virtuelle d’un serveur physique à un autre et inclut des fonctions d’optimisation du placement des machines virtuelles en fonction de la charge des serveurs.

Microsoft a aussi intégré à SCE 2010 la notion de « PRO Tips » (Performance and Ressource Optimisation Tips), un système de conseil qui permet à l’administrateur de bénéficier de conseils ou de recettes prêtes à l’emploi, en cas d’incident (comme la saturation des ressources CPU ou mémoire d’un serveur)... L'intégration entre les fonctions d'administration de SCE et de VMM a été soignée et il est très facile de voir les liens entre les machines virtuelles et leurs hôtes ce qui permet de mieux s’y retrouver entre physique et virtuel.

... qui s’ajoutent à celles de supervision et d’administration des serveurs et postes clients

Si SCE 2010 s’enrichit de fonctions de gestion des machines virtuelles, il n’en oublie pas pour autant ses fonctions premières de gestion des environnements systèmes. On retrouve ainsi les fonctions d’inventaire de serveurs (physiques et virtuels) ainsi que les fonctions de supervision. Des agents s’installent automatiquement pour permettre de superviser tout serveur (virtuel ou physique) et tout poste client Windows raccordé au réseau. Il est ainsi très simple d'obtenir une vue synthétique de l’état d’un serveur, des applications installées et des correctifs qui ont été appliqués. SCE 2010 permet aussi de concevoir des packages applicatifs et de les télédistribuer sur les serveurs ou sur les postes clients.

Windows Server 2008 R2 et Windows 7 partagent déjà le même noyau, mais Microsoft n’entend pas s’arrêter en si bon chemin. Avec son dernier opus serveur, l’éditeur de Redmond a ainsi cherché à renforcer les liens avec Windows 7. Les plus optimistes y verront une façon d’optimiser les liens entre serveur et clients, tandis que les plus pessimistes y verront une n-ième tentative de profiter de la position dominante de Windows sur les postes clients d’entreprises pour imposer un peu plus l’OS Serveur. Comme à l’accoutumée, la vérité est sans doute à chercher entre ces deux analyses...

Direct Access : l’accès nomade transparent pour les postes Windows 7

La première fonctionnalité de Windows Server 2008 R2 liée à Windows 7 a pour nom Direct Access et elle permet un accès distant transparent et sécurisé au réseau interne depuis des postes nomades, et ce, quel que soit le type de la connexion. Direct Access est en fait une combinaison de plusieurs technologies de tunneling intégrées à l'OS qui permet aux usagers nomades d’accéder de façon transparente aux ressources de l’entreprise sans avoir à recourir à une connexion VPN traditionnelle et à un client logiciel. Concrètement, Direct Access s’appuie sur des technologies introduites avec Windows Server 2008, mais que Microsoft a rendu simple d’accès avec Windows Server 2008 R2. L'éditeur a ainsi ajouté des agents de configuration qui permettent aux administrateurs de configurer les protocoles SSTP et IPv6 sur les clients Windows Server 2008 R2 et Windows 7 afin d’activer les connexions Direct Access basiques puis de les enrichir avec les outils de management et de gestion de la sécurité tels que NAP.

Microsoft abandonne Windows Essential Business Server

Essential Business Server (EBS), l'offre de serveur Windows pour le mid-market de Microsoft, s'éteindra le 30 juin prochain, après un peu plus de 18 mois d'existence. Lancé en novembre 2008 à l'occasion de Tech Ed 2008 à Barcelone et basé sur Windows Server 2008, Essential Business Server s'était vu assigner pour objectif de séduire les grosses PME disposant d'un maximum de 300 utilisateurs (contre 75 pour l'offre Small Business Server), en intégrant dans un seul package prêt à l'emploi Windows Server, Exchange et System Center Essentials 2007.

Las, ce nouveau packaging n'a pas réussi à convaincre des PME plutôt à la recherche d'une solution plus économique pour déployer les solutions Microsoft que d'une n-ième variante technique. ?A l'heure où Microsoft tente d'accélérer la migration des PME vers ses offres Online et de cloud, EBS était aussi sans doute perçu par l'éditeur comme anachronique. Et il a sans doute été d'autant plus facile de le tuer que son succès ne semble pas avoir été spectaculaire.

Pour les entreprises qui avaient choisi EBS, Microsoft va toutefois faire un geste : l'éditeur s'engage à fournir gratuitement aux clients touchés par l'arrêt du produit des versions complètes des logiciels composant la suite (c'est-à-dire Windows Server 2008, Exchange Server 2007 et System Center Essentials 2007). Les clients ont jusqu'au 31 décembre 2010 pour en faire la demande sur le site EBS. Notons toutefois qu'il aurait sans doute été moins mesquin de la part de l'éditeur de proposer les versions actuelles de ces produits à savoir Windows Server 2008 R2, Exchange 2010 et System Center Essentials 2010, ou de proposer un chemin de migration à tarif préférentiel vers ces versions.

Avec Direct Access, chaque utilisateur est par défaut considéré comme nomade et il n’est plus fait de distinction entre connexions locales et distantes. Direct Access gère ces différences en tâche de fond tout en permettant aux administrateurs de conserver un contrôle complet et précis sur la sécurité périmètrique. Direct Access a des pré-requis assez précis si on veut le déployer de façon optimum, notamment le besoin de plusieurs serveurs physiques ou logiques (voir à ce propos le blog de Stanislas Quastana de Microsoft) .

BranchCache : améliorer les performances en agences

Un second service est encore plus intéressant pour les PME multi-sites ou pour les collectivités locales. Il s'agit de BranchCache. Il permet d'optimiser les performances réseaux entre un site distant et le « siège » via la mise en place d'un mécanisme de cache de contenus. Le principe de fonctionnement est simple. Dans une agence, le premier poste qui requiert un contenu stocké au siège agit comme cache pour les autres postes de l'agence. Ainsi, si un autre poste demande le même contenu, il sera servi directement depuis l'agence sans consommer de bande passante WAN. Bien sûr, des mécanismes s'assurent que la version stockée en cache est à jour par rapport à celle du serveur central.

Cette approche distribuée pour les petites agences peut être améliorée avec l'installation d'un serveur de cache pour les agences plus importantes. Un serveur Windows 2008 Server R2, configuré en « BranchCache », agit alors comme serveur de cache pour l'ensemble des postes de l'agence. Windows Server 2008 R2 permet enfin de contrôler de façon plus fine l'exécution d'applications sur les postes Windows. Signalons enfin que si Microsoft a rénové l’édition standard de son OS serveur, il faudra sans doute encore attendre quelques trimestres pour voir Windows Server 2008 R2 arriver dans Small Business Server (Enhanced Business Server a été purement et simplement abandonné). A ce jour, Microsoft n'a communiqué aucun calendrier de mise à jour vers R2 pour ces solutions. En toute logique, cela ne devrait toutefois pas intervenir avant la rentrée 2010.

Télécharger l'intégralité de

ce dossier au format PDF

Téléchargez ce dossier au format PDF (nécessite la saisie d'un formulaire)

Pour approfondir sur Windows

-

![]()

Windows Server 2016 : évitez les interruptions avec les mises à niveau progressives

-

![]()

Windows Server 10 : les principales nouveautés dans Hyper-V

-

![]()

Quelles sont les différences entre VMware vMotion et Microsoft Live Migration

-

![]()

Windows Server 2012 R2 améliore la virtualisation de l'OS pour serveurs de Microsoft