Avant-première : HPE dévoile ses serveurs les plus puissants

À l’occasion de son salon Discover 2023 à Barcelone, le constructeur a montré des machines à base de Nvidia Grace Hopper et d’AMD MI300a qu’il n’annoncera officiellement que l’année prochaine.

Plein la vue. Le fabricant de serveurs HPE a profité de l’édition européenne de sa conférence Discover 2023, qui se tenait début décembre à Barcelone, pour dévoiler en avant-première ses prochaines machines les plus puissantes. La future lame Cray EX254n sera la première à implémenter la nouvelle superpuce Grace Hopper GH200 de Nvidia, qui intègre un processeur ARM (Grace) et un GPU (Hopper). La future lame Cray EX255a sera quant à elle la première à être équipée de la puce APU MI300a d’AMD, qui intègre des cœurs de processeurs Zen 4 et des cœurs de GPU CDNA 3.

Ont également été présentés sur les stands du salon, le dernier switch Ethernet Slingshot qui traite désormais 12,8 Tbit de données par seconde, le Cray EX670 qui permet aux entreprises plus traditionnelles d’entraîner des modèles d’IA et le dernier Proliant DL380 équipé de cartes Nvidia L40s pour exécuter des modèles préentraînés.

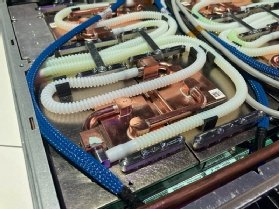

Les machines Cray sont des lames serveur pour supercalculateurs, initialement appelées Apollo et rebaptisées à l’occasion de la dernière génération Gen11 de ses serveurs. Leur caractéristique principale est qu’ils sont nativement prévus pour fonctionner avec un refroidissement à eau. Ici, les gros dissipateurs thermiques et ventilateurs habituels sont remplacés par de fines plaques de cuivre parcourues d’un tuyau qui prend de l’eau à 14 degrés Celsius en entrée et la ressort à environ 60 degrés.

Ces lames s’installent dans des étagères rack particulières. L’armoire EX4000 fournit toute la plomberie pour acheminer l’eau et l’EX2500, qui correspond à un modèle hybride, supporte aussi des ventilateurs.

« Je ne sais pas si ce design va être décliné dans les serveurs HPE pour datacenters, d’autant que les datacenters traditionnels ne sont pas conçus à l’heure actuelle pour faire passer de l’eau dans les racks de serveurs. Mais mon opinion est que l’on voit arriver tellement de nouveaux équipements avec une enveloppe de chaleur importante que nous devrions voir de plus en plus de systèmes refroidis à l’eau dans les datacenters », dit Ben Bennett (en photo en haut de cet article), le directeur Stratégie des produits HPC chez HPE.

Pour mémoire, HPE peut se targuer d’être actuellement en première place du Top500, le palmarès des machines les plus performantes de la planète, avec le supercalculateur Frontier. Celui-ci est basé sur près de 68 000 lames EX235a. Ces lames se composent de deux nœuds avec, sur chacun, quatre GPU AMD M250X et un processeur AMD Epyc 7003 de 64 cœurs.

La lame Cray EX254n basée sur huit Grace Hopper

Une lame Cray EX254n se compose de deux nœuds, chacun équipé de quatre puces Grace Hopper GH200. Ces puces sont constituées de deux circuits électroniques, le processeur et le GPU, assemblés ensemble sur un support commun qui les connecte aux autres puces. Les deux circuits ont chacun leur propre plaque de cuivre refroidie à l’eau.

Le processeur Grace comprend 72 cœurs ARM Neoverse V2, tandis que le GPU Hopper est tout simplement le GPU H100 haut de gamme que Nvidia propose déjà en carte autonome depuis cet été, en remplacement de l’A100 majoritairement installé dans les supercalculateurs actuels.

Les deux puces sont reliées via un lien NVLink-C2C qui leur permet de communiquer à 900 Go/s (450 Go/s dans chaque direction). À titre comparatif, c’est 7 fois plus que la bande passante entre un processeur x86 et un H100, qui communiquent via 16 canaux sur un slot PCIe dans un serveur traditionnel.

Le GPU Hopper embarque sa propre mémoire HBM3 de 96 Go avec laquelle il communique à la vitesse de 4 To/s. Une future version avec mémoire HBM3e atteindra 144 Go et offrira une bande passante de 4,9 To/s. Le processeur Grace dispose d’une bande passante de 500 Go/s vers une RAM LPDDR5X externe, mais dédiée, qui peut grimper à 480 Go de capacité. Les deux puces peuvent chacune accéder à la RAM de l’autre, pour former une unité de calcul dont la capacité mémoire atteint 624 Go.

« Certes, mettre des processeurs ARM à la place de traditionnels x86 peut sembler inédit dans les supercalculateurs HPE. Mais, en vérité, cela fait cinq ans que nous préparons les scientifiques et les développeurs à l’arrivée de cette machine, via un programme appelé Catalyst et qui comprenait de serveurs prototypes à base de processeurs ARM avec GPU Nvidia », indique Ben Bennett.

Le switch Slingshot

Ben Bennett ne dit pas à quelle vitesse les puces Grace Hopper communiquent entre elles. La configuration Cray EX254n présentée n’étant pas encore commercialisée, il faudra attendre le début de l’année prochaine pour en connaître tous les détails.

Cependant, on sait que les armoires EX2500 et EX4000 interconnectent huit lames avec quatre switches HPE Slingshot, également refroidis à l’eau. Ces switches, qui sont basés sur un ASIC maison de HPE (et non de Nvidia) supportent chacun une bande passante de 12,8 Tbit/s. Cette bande passante est répartie en 64 ports de 200 Gbit/s chacun. Un switch Slingshot dispose de huit connecteurs propriétaires, côté serveurs, et vingt-quatre connecteurs QSFP-DD standards vers d’autres switches réseau à l’arrière. Chaque connecteur transporte deux ports. Le switch en lui-même supporte de router les informations entre 250 000 ports cibles.

Les quatre switches Slingshot se connectent directement à l’arrière des huit lames, perpendiculairement à elles, sans câbles. De fait, chaque lame dispose d’une bande passante de 1,6 Tbit/s, soit 200 Gbit/s par puce GH200 (environ 25 Go/s).

La lame Cray EX255a à base d’APU AMD MI300a

De son côté, la lame Cray EX255a intègre huit APU MI300a d’AMD. Quatre orientés dans un sens, quatre orientés dans l’autre, pour faciliter la circulation de l’eau. APU signifie ici « Accelerated Processing Unit ».

L’APU MI300a est un assemblage particulièrement complexe de différents circuits dans une même puce. On dénombre trois circuits CCD qui comprennent chacun huit cœurs de processeurs Zen 4 (il s’agit des mêmes CCDs que ceux du dernier Epyc 9004), six circuits XCD qui comprennent 228 cœurs GPU CDNA 3 et huit circuits mémoire HBM3 qui totalisent 128 Go de capacité.

AMD avait déjà présenté un APU MI250 basé sur des cœurs Zen 3. Le MI300a serait huit fois plus performant pour une consommation électrique à peine supérieure, ce qui le rendrait cinq fois plus rentable que son prédécesseur.

« Ces lames serviront à construire El Capitan, notre prochain supercalculateur qui sera basé sur la même architecture que Frontier, c’est-à-dire avec des codes optimisés pour AMD. L’avantage de cette version est qu’il n’y a plus de CPU en plus des GPU. Chaque lame a seulement huit APU », dit notre interlocuteur en évoquant une baisse importante de la consommation électrique.

Les lames Cray EX255a sont également interconnectées avec des switches Slingshot.

« Nous avons aussi en projet un supercalculateur Aurora, basé sur des lames Intel, avec processeur Xeon et GPU Ponte Vecchio. Mais il est trop tôt pour la dévoiler », indique Ben Bennett.

Les Cray EX670 et ProLiant 380a

Enfin, le Cray EX670 est le seul serveur dit de supercalcul qui est nativement conçu pour être refroidi à l’air, c’est-à-dire dans des datacenters classiques, avec des étagères rack classiques. Il est doté de deux processeurs Xeon de dernière génération qui communiquent en PCIe avec huit cartes GPU H100. Celles-ci, en réseau SXM, sont logées dans un compartiment dédié sous la carte mère. La machine, de type HGX dans la nomenclature Nvidia, est très proche du serveur Dell XE9680 lancé cet été.

HPE devrait sous peu décliner ce serveur en une version plus économique, l’EX665, qui ne présente que quatre cartes H100.

« Cette machine est destinée à permettre aux entreprises d’entraîner des modèles d’IA dans leurs propres datacenters. Les entreprises qui le feront sont les grands comptes, les banques. Mais nos études montrent que les entreprises de moindre taille n’entraîneront pas leurs modèles. Elles exécuteront leurs propres données sur ceux déjà entraînés en amont. Dans cette situation, vous n’avez pas besoin d’autant de puissance. C’est tout l’intérêt de notre nouveau serveur Proliant DL380a Gen11 avec GPU Nividia L40s », intervient un autre démonstrateur de HPE, dont LeMagIT n’a pas réussi à voir le nom.

Dans un format de seulement 2U, le DL380a comprend un ou deux processeurs Xeon et jusqu’à quatre GPU connectés en PCIe 5.0 (16 canaux).