cookiecutter - Fotolia

Comparez les avantages d’une architecture de serveur lame à l’hyperconvergence

Pour déterminer si une architecture à base de lames serveurs est adaptée à vos besoin de densification d'infrastructure au sein du datacenter, évaluez ses bénéfices par rapport à l'hyperconvergence.

Les approchent modernes d’infrastructure de datacenters visent à simplifier les plates-formes matérielles tout en augmentant l’agilité opérationnelle. Jusqu’à récemment, certaines équipes informatiques avaient sur des architectures à base de serveurs lames pour optimiser leur infrastructure. Mais la pression pour inclure le stockage dans ces systèmes a donné naissance aux infrastructures hyperconvergées.

L’infrastructure hyperconvergée et les serveurs lames offrent des systèmes plus denses, mais il peut être difficile de faire un choix entre les deux. Avant de se décider, il est important de regarder les attributs des deux approches pour comprendre leurs avantages et les compromis qu’ils imposent.

Comparer une architecture de serveur lame à des systèmes hyperconvergés

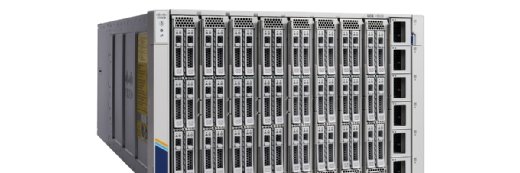

En moins de 20 ans, les serveurs lames ont progressivement évolué pour inclure des périphériques de commutation et de stockage. Généralement, une configuration de serveur lame consiste en un châssis avec un ensemble de lames de calcul installées côte à côte dans un fond de panier remplaçable à chaud, avec des alimentations redondantes et une paire de modules de commutation Ethernet et/ou Fibre Channel. Des lames de stockage sont aussi disponibles dans les offres lames modernes, mais la plupart des serveurs lames ne disposent pas d’un mécanisme de mutualisation à même de délivrer un stockage partageable par toutes les lames. Il est à noter que dans les architectures de serveurs lames, la puissance des processeurs est souvent limitée aux modèles intermédiaires du fait de la densité de ces systèmes et de leurs capacités limitées de dissipation thermique. L’espace limite également la capacité de mémoire vive disponible.

D’un point de vue format, les systèmes hyperconvergés dérivent des serveurs rack traditionnels. Ces systèmes combinent des fonctions de stockage et de calcul au point que ces fonctions deviennent essentiellement indiscernables. Alors que le stockage traditionnel nécessitait de grandes baies de disques durs pour atteindre des performances adéquates, les appliances SSD actuelles ne comprennent généralement que 8 à 12 disques SSD.

Le principal facteur de différenciation entre une infrastructure hyperconvergée et une architecture de serveur lame réside dans le fait que, dans les systèmes hyperconvergés, le stockage des serveurs est mis en commun via une technologie de stockage distribuée pour créer un réseau SAN virtuel gigantesque. Les innovations telles que l’infrastructure définie par logiciel vont plus loin, au point que le pool de stockage et les réseaux reliant les appliances sont virtualisés et contrôlés automatiquement par un logiciel d’orchestration. Cela permet aux utilisateurs d’une infrastructure HCI d’ajouter et de soustraire à leurs configurations en utilisant des scripts et des stratégies, sans intervention des administrateurs.

Comment créer une infrastructure hyperconvergée avec des serveurs lames

Étant donné que la principale différence entre les serveurs lames et l’infrastructure hyperconvergée est le logiciel, est-il raisonnable de croire qu’une architecture de serveur lame peut être utilisée comme infrastructure hyperconvergée ?

Il n’y a pas de réel obstacle technique à la création d’une infrastructure hyperconvergée utilisant des serveurs lames. Il est important d’examiner la maturité de chaque produit, car les technologies de serveur, de réseau et de stockage évoluent rapidement. La souplesse de configuration va de pair avec cela. Un système capable de gérer le changement et les mises à jour est nécessaire.

La configuration affecte fortement les exigences de stockage. Un serveur typique aura besoin d’au moins deux disques SSD locaux pour fonctionner et de disques durs additionnels pour la capacité. Les serveurs hyperconvergés sont conçus autour de ces prérequis, mais les serveurs lame actuels sont généralement moins richement dotés, avec un seul disque par serveur, ou parfois moins. Il est néanmoins possible d’étendre cette capacité en allouant des disques supplémentaires provenant d’une lame de stockage connectée via SAS (Serial-Attached SCSI).

Une possibilité émergente pour déployer une approche hyperconvergée sur les serveurs lames est de s’appuyer sur des technologies de pointe, telles que des tiroirs de disques NVMe over fabrics reliés aux lames via des adaptateurs Ethernet RDMA ou des modules de mémoire NVDIMM.

Les facteurs de coût

La question des coûts se pose du fait de la nature propriétaire des châssis et des lames. Ce sont des articles coûteux et le verrouillage vis-à-vis du fournisseur est fort. Le caractère propriétaire des lames empêchent la concurrence directe et ralentit l’adoption de nouvelles versions de disques et de cartes d’interface réseau. Avec l’accélération de l’innovation, cela devient plus problématique.

Un autre facteur de coût est qu’il ne reste plus que quelques fournisseurs de serveurs lames, alors que le nombre de fabricants de systèmes hyperconvergés ne cesse de croître. Ce niveau de concurrence pourrait contribuer à une baisse des prix de l’infrastructure hyperconvergente par rapport aux lames.

Le débat entre infrastructures lames et approche hyperconvergée n’est toutefois pas terminé. Attendez-vous à ce que la densité des lames continue à évoluer avec l’arrivée de technologies comme Gen-Z (qui va permettre de déporter la mémoire hors des serveurs) ou avec la miniaturisation croissante des SSD. Des formats de SSD comme M2 ou la banalisation des modules SSD au format NVDIMM pourraient permettre de doper la capacité de stockage des lames. Cela pourrait contribuer à l’émergence de systèmes hyperconvergés plus proches des facteurs de forme actuels des serveurs lames.