Les cinq piliers de l’observabilité des données

L’observabilité des données doit assurer une surveillance holistique des pipelines de données d’une organisation. Voici les cinq piliers de cette pratique devant garantir, in fine, l’efficacité et la précision des traitements de données.

Si les volumes et les sources de données ne cessent d’augmenter en entreprise, il est évident que maintenir les pipelines de données devient de plus en plus complexe.

En effet, les méthodes d’intégration et de transformation sont de plus en plus diverses. Les flux ETL croisent les approches ELT ainsi que les architectures orientées événements sans oublier la prolifération des API. Mais il faut aussi compter sur de nouvelles approches, comme la fédération de requêtes, qui promettent de simplifier les phases d’ingestion.

Les data engineers et les responsables de l’intégration sont donc à la recherche de solutions pour superviser ces flux. Les outils d’observabilité des données contribuent à ces efforts en surveillant les problèmes potentiels tout au long des pipelines et en alertant les équipes chargées des données sur les interventions nécessaires. Plus loin, il faut que les données demeurent cohérentes lors des phases de transformation.

L’observabilité des données est une approche qui permet aux organisations de superviser de bout en bout l’ensemble des pipelines de données. Il s’agit d’obtenir une évaluation chiffrée de la santé globale du système. S’il identifie des erreurs ou des problèmes, le logiciel est configuré pour alerter les bonnes personnes au sein de l’organisation sur le domaine à traiter.

« Les projets analytiques et de traitements de données dépendent très fortement des processus de préparation et des pipelines de données », rappelle David Menninger, vice-président senior et directeur de recherche chez Ventana Research. « Nous avons suffisamment d’informations pour savoir à quoi les données devraient ressembler. Si l’exécution actuelle de ce pipeline ne correspond pas à cette forme, c’est une indication qu’il y a peut-être un problème ».

L’observabilité des données est un aspect relativement nouveau. Il est directement inspiré des efforts pour unifier les pratiques de supervision au sein des organisations. Cette pratique se nomme l’observabilité. Elle a provoqué une brèche commerciale et marketing dans laquelle l’ensemble des éditeurs se sont engouffrés.

En parallèle, l’observabilité des données a pris de l’importance au cours des quatre dernières années. Les éditeurs tels que Monte Carlo, conçoivent des outils classés dans cette catégorie et de nouveaux acteurs apparaissent à mesure que les pratiques de surveillance de pipelines de données se modernisent.

Il y a toutefois des distinctions à opérer. Ainsi, les trois principaux piliers de l’observabilité des systèmes sont :

– Les métriques. Une représentation numérique des données.

– Les logs. Enregistrements d’événements, généralement sous forme de texte ou d’artefacts lisibles par un humain. Les logs peuvent provenir d’éléments d’infrastructure ou de logiciels. Ils sont généralement historiques ou rétrospectifs, mais certains systèmes offrent des capacités de collecte d’événements ou de données de télémétrie en temps réel.

– Les traces. Les empreintes de l’information ou des flux de travail à travers chaque processus pour une requête ou une action, telles qu’une transaction.

Qu’est-ce que l’observabilité des données ?

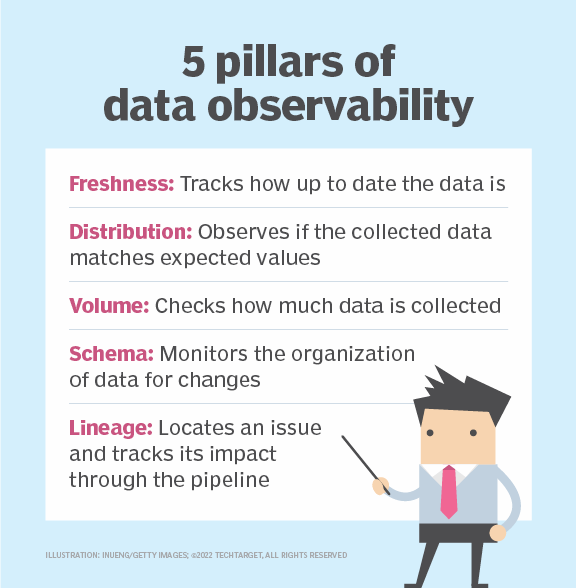

L’observabilité des données s’appuie sur ses propres piliers. Ces piliers se complètent pour couvrir l’ensemble d’un pipeline de données. En clair, s’il y a toujours des traces, des métriques et des logs, cette pratique s’accompagne de son propre lot de paramètres. Voici les cinq piliers de l’observabilité des données :

– La Fraîcheur

– La Distribution

– Le Volume

– Le Schéma

– Le (data) lineage

1. Fraîcheur

La fraîcheur permet de savoir dans quelle mesure les données sont à jour et à quelle fréquence elles sont mises à jour. La fraîcheur est l’une des formes de surveillance les plus demandées par les clients de la plateforme d’observabilité des données Bigeye, selon Kyle Kirwan, PDG et cofondateur de Bigeye.

« Si j’ai un pipeline qui alimente un tableau de bord analytique, la première question que je me pose – les données sont censées être réinitialisées toutes les six heures – est-ce qu’elles sont rafraîchies à temps, ou est-ce qu’elles sont retardées ? », illustre-t-il.

Confirmer que les données sont à la fois mises à jour et qu’elles arrivent au rythme approprié est particulièrement utile en ce qui concerne la gouvernance des données et les catalogues de données.

« La fraîcheur des données est un indicateur brut de l’existence d’un problème », remarque David Menninger. « Les catalogues de données sont devenus très populaires... et renseigne généralement la fraîcheur »

Utiliser des chiffres biaisés ou ne pas savoir pourquoi certaines valeurs ont un impact négatif sur les modèles d’apprentissage automatique nuit à la prise de décision.

L’utilisation d’un outil d’observabilité des données qui peut automatiser le processus de vérification de la fraîcheur, la réduction des coûts, tant en matière de consommation de ressources que de temps humain. Le service d’achat de voitures Peddle LLC a créé un processus interne pour faciliter et automatiser les créations de métriques, dont ils ont plusieurs milliers à surveiller.

« La fraîcheur est le critère le plus important. C’est celui sur lequel nous comptons le plus. Il nous permet de savoir si un pipeline ETL (extraction, transformation et chargement) a fonctionné au moment prévu », explique Tim Williamson, ingénieur principal chargé de l’entrepôt de données chez Peddle, un client de Bigeye. « Si nous avions dû construire cela à la main, je n’ose imaginer le temps que cela aurait pris ».

2. Distribution

La distribution correspond aux valeurs attendues des données recueillies par les organisations. Si les données ne correspondent pas aux valeurs attendues, cela peut indiquer qu’il y a un problème de fiabilité. Une variance extrême des données indique également des problèmes de précision.

Les outils d’observabilité peuvent surveiller certaines métriques pour détecter les erreurs ou les valeurs aberrantes qui sortent de la fourchette prévue. Ensuite, les équipes configurent des alertes pour prévenir les parties concernées sur les incohérences afin de résoudre rapidement les problèmes avant qu’ils n’affectent d’autres parties du pipeline.

La qualité des données est un élément essentiel du pilier « distribution », car une qualité médiocre peut provoquer les problèmes que la distribution surveille. Des données inexactes – champs erronés ou manquants – qui entrent dans le pipeline peuvent se propager dans différentes parties de l’organisation et compromettre la prise de décision. La distribution aide à traiter les éléments problématiques si l’outil d’observabilité des données détecte une mauvaise qualité.

3. Volume

La notion de volume doit permettre d’identifier non seulement la quantité de données, mais également si elles sont complètes par rapport aux inventaires d’une organisation. Selon David Menninger, quand les entreprises surveillent des jeux de données critiques, elles savent d’où proviennent les données, pendant quelles périodes elles sont collectées et quelles sont les informations sur les produits, les comptes et les données clients. Par exemple, si un tableau contient les 50 États des États-Unis et qu’il se réduit à 25 États, quelque chose ne va pas.

La notion de volume est l’une des principales priorités de Tim Williamson. Le responsable indique qu’il peut aussi avoir plus de données que prévu, ce qui révèle aussi des problèmes.

« À l’heure actuelle, les clés primaires que nous utilisons sont des éléments tels que le nombre de lignes. Nous cherchons à savoir si le nombre de lignes est différent qu’auparavant. Si oui, nous recherchons les doublons de clés primaires », déclare-t-il.

4. Schéma

Dans le cadre de l’observabilité des données, surveiller les schémas est essentiel. Plus largement, il s’agit de superviser et d’auditer les changements d’organisation, de structures des tables. Les rangées ou les colonnes peuvent être changées, déplacées, modifiées ou supprimées, ce qui provoque des perturbations dans les applications qui exploitent ces informations. Plus les bases de données utilisées sont volumineuses, plus il peut être difficile pour les équipes « data » de déterminer là où se trouve un problème.

« Les défauts dans un schéma sont un indicateur que vos pipelines doivent être modifiés », avance David Menninger. « Les informations pourraient être utilisées pour une certaine quantité de remédiation automatisée ».

Par exemple, Bigeye a intégré des contrôles d’identification de format et de schéma, des valeurs numériques et des distributions aberrantes couvertes par plus de 70 métriques. Lors de l’utilisation du schéma Information de Snowflake pour identifier les tests de l’ETL dbt ciblant les tables dont le nombre de lignes est supérieur à zéro, Bigeye aide Tim Williamson à surveiller la vue et à identifier immédiatement les tests qui ont échoué.

« Bigeye m’a notifié que le nombre de rangées était anormal pour une table spécifique », ajoute-t-il. « Nous avons trouvé un bug dans notre code de pipeline ETL. Nous avons pu le corriger ».

5. Lineage

Le lineage englobe l’intégralité du pipeline de données. Il s’agit de documenter et de comprendre l’ensemble des données de l’organisation, y compris les sources de données en amont, les systèmes cibles en aval et les personnes qui interagissent avec les données et à quels stades.

Le lineage permet à une organisation d’examiner chaque étape du pipeline de données et la façon dont il est relié à l’autre, révélant ainsi l’impact des problèmes d’une partie sur les autres domaines. En cas d’erreur dans le pipeline, ce diagramme fournit une vue d’ensemble qui permet à l’équipe IT ou à l’équipe chargée des données de se pencher sur les erreurs localisées à certains endroits.

« Le data lineage est plus difficile à évaluer », affirme David Menninger. « Si le type de transformation change, est-ce un problème ? Cela peut l’être ou non. Il peut y avoir un nouveau produit qui est introduit, alors le processus de lineage doit être modifié pour reconnaître le nouveau code produit ».

Dans certains cas, le lineage peut également aider à suivre les coûts d’infrastructure et à répondre aux questions de documentation, ainsi qu’à identifier les métiers qui utilisent les données et à quelle fréquence.

L’observabilité est un outil précieux qui permet aux organisations de détecter les problèmes. Cependant, la détection du problème n’apporte qu’une partie de la solution. Toute alerte devrait déclencher le processus de résolution du problème.

« C’est bien d’observer un problème, mais cela ne suffit pas en soi », rappelle David Menninger. « L’observabilité doit inclure la remédiation. Nous devrions être en mesure d’automatiser une partie de ce travail de réparation ».

Aujourd’hui, la plupart de ces processus de remédiation demeurent manuels.