tonda55 - Fotolia

L’hyperconvergence à l’assaut des datacenters

De plus en plus populaires auprès des entreprises, les technologies d’hyperconvergence permettent de simplifier l’architecture des datacenters et l’exploitation au quotidien.

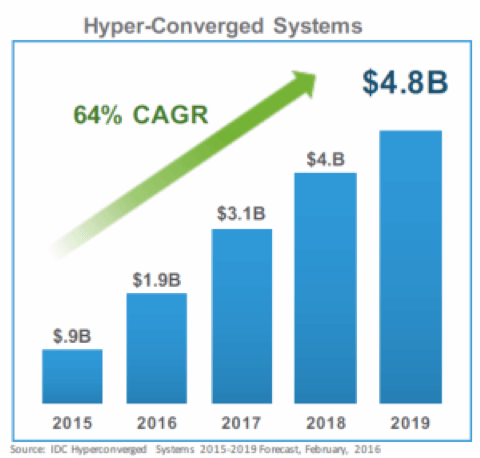

Selon Gartner, le marché des systèmes hyperconvergés devrait progresser de 79% en 2016 pour atteindre près de 2 milliards de dollars, une prédiction en ligne avec celle d’IDC, qui estime de son côté que les achats de systèmes hyperconvergés par les entreprises devraient atteindre 1,9 Md$ sur l’ensemble de l’année 2016. Selon le cabinet d’étude, ce chiffre devrait passer à 4,8 Md$ à l’horizon 2019.

Clairement, les architectures hyperconvergentes ont le vent en poupe. On le voit au travers du succès de pionniers comme Nutanix ou Simplivity ou via la montée en puissance des architectures hyperconvergées basées sur la technologie VSAN de VMware (comme VxRail chez EMC ou UCP HC chez Hitachi). Mais on le voit aussi avec l’arrivée de multiples acteurs sur ce marché, comme Cisco (avec SpringPath), Microsoft (avec Azure Stack), Hedwig, Pivot3, Scale Computing, etc.

Le marché de l'hyperconvergence selon IDC

Le marché de l'hyperconvergence selon IDC

Il faut toutefois garder raison et remettre les choses en perspectives. Le marché mondial des serveurs est un marché de 55 milliards de dollars par an et celui du stockage d’entreprise pèse environ 37 Md$. Les 4,8 Md$ estimés par IDC à l’horizon 2019 ne représentent donc qu’environ 5% du marché de l’infrastructure. C’est significatif, mais pas encore une révolution.

Le marché de l’infrastructure IT est en effet un marché historiquement conservateur. Il se vend ainsi toujours pour près de 4 Md$ de systèmes Mainframe par an, des machines dont l’héritage remonte à plus de cinquante ans avec le System/360. On ne bouscule donc pas l’ordre établi dans les datacenters du jour au lendemain. Ne serait-ce que parce les processus et les compétences des humains gouvernant ces infrastructures n’évoluent pas aussi rapidement que la technologie. Et puis, vu de la fenêtre de nombre de responsables IT, tout changement dans une architecture est potentiellement un risque. Et l’entreprise moderne, malgré tout ses discours sur la transformation numérique, a horreur du risque…

L’hyperconvergence : des atouts qui séduisent

Pour en revenir à l’hyperconvergence, les raisons de ses premiers succès tiennent à plusieurs facteurs clés. Tout d’abord, la simplicité. Là où les architectures traditionnelles requièrent l’assemblage plus ou moins complexe de solutions de fournisseurs multiples ou l’acquisition de systèmes convergés coûteux, les appliances hyperconvergées séduisent par leur mise en œuvre rapide et par leur facilité d’administration et d’exploitation.

Un autre argument fort en faveur des systèmes convergés est leur évolutivité. Pour accroître la capacité de stockage ou de traitement, il suffit en général d’ajouter un nœud supplémentaire et de le relier au cluster. Cette évolutivité ne porte pas que sur la capacité. Avec la plupart des offres hyperconvergées, le passage d’une architecture mono-datacenter à une architecture multi-datacenter avec PRA n’est souvent qu’une question de quelques clics, alors que c’est en général un casse-tête avec une approche plus traditionnelle en matière de serveurs et de stockage.

Le dernier argument est économique. Les premiers utilisateurs de l’hyperconvergence témoignent tous de la réduction des coûts engendrée par la simplification de leurs architectures (et notamment la suppression du SAN et des baies de stockage), mais aussi de la baisse des frais d’exploitation liée à la facilité de mise en œuvre de ces architectures. Et c’est encore sans parler des fonctions additionnelles apportées par certains fournisseurs (comme le backup et le PRA intégré chez Simplivity), qui peuvent être source de substantielles économies surtout pour les PME ou pour les déploiements dans de multiples agences ou sites distants.

Qu’est-ce qu’un système hyperconvergé

On qualifie d’hyperconvergés, des systèmes qui combinent serveur, stockage et virtualisation en une seule et unique appliance. Pour bâtir un système hyperconvergé, la clé est bien évidemment le logiciel embarqué. Il assure, a minima, la convergence sur une même machine des fonctions de calcul et de stockage et permet de simplifier considérablement l’architecture matérielle du datacenter.

Dans la pratique, un système hyperconvergé est souvent un serveur x86 banalisé ou un châssis comprenant plusieurs nœuds x86. Ces serveurs intègrent leurs propres disques durs ou SSD. Mais la clé de l’ensemble, la sauce secrète propre à chaque fournisseur, est le logiciel embarqué qui fédère l’ensemble avec la couche de virtualisation retenue (en général vSphere ou Hyper-V, mais parfois aussi KVM). La fonction primaire de cette couche logicielle est d’agréger la capacité disque de l’ensemble des nœuds et de la sécuriser pour la présenter comme un pool partagé consommable par les différents serveurs. Grâce à cette couche logicielle, chaque machine du cluster est à la fois un élément de « compute » virtualisé et de stockage. Il participe à un système distribué, dont la puissance et la capacité s’accroissent avec le nombre de nœuds.

Par exemple, chez Nutanix, la sauce secrète est un système de fichiers distribué, baptisé NDFS, qui permet d’agréger la capacité de stockage des nœuds en un espace de stockage unique à haute performance, mis à la disposition des machines virtuelles installées sur le cluster. Sans ce « filesystem », il n’y aurait tout simplement pas de Nutanix. De même dans les appliances VMware de VCE, Hitachi ou HPE, la magie repose sur le système de fichiers maison VSAN (virtual SAN).

Chez Simplivity, c’est le logiciel DVP (Data Virtualization Platform) qui joue ce rôle. En fait, chaque fournisseur, qu’il s’agisse d’Hedwig, de Scale Computing, de Pivot3 ou de SpringPath a développé sa propre technologie de stockage distribuée et sa propre couche d’administration pour rendre possible la convergence du stockage et du calcul sur un seul et même serveur.

Mais la convergence ne s’arrête pas au stockage. Tous les fournisseurs proposent aussi une console unifiée permettant d’exploiter depuis un écran unique l’ensemble des composants d’une infrastructure hyperconvergée. Et chacun a également ajouté ses propres fonctions additionnelles. Nutanix et Simplivity par exemple se livrent une bataille rangée impitoyable autour des fonctions de backup, de stretched cluster et de protection de données. La richesse des outils d’administration de chacun est aussi un terrain d’affrontement acharné. Microsoft entend se différencier avec Azure Stack en proposant une partie des services d’Azure en local sur son architecture hyperconvergée Azure Stack (Nutanix, avec l’acquisition de Calm, a lui aussi des vues sur le PaaS et le DevOps). EMC de son côté promet de combiner le meilleur des capacités serveurs de Dell, avec le meilleur de la pile VMware et avec son propre savoirfaire en matière de logiciels de stockage et de protection de données pour faire évoluer son offre VxRail…

Cette intégration de fonctions logicielles avancées dans les plates-formes hyperconvergées constitue une vraie innovation par rapport aux architectures convergées, qui n’innovaient pour l’essentiel que dans le packaging et le support. Et elle contribue grandement à la simplification du datacenter.

De fait, un datacenter hyperconvergé n’est rien d’autre qu’une pile de serveurs x86 bourrés de disques durs et de SSD, reliés entre eux par des commutateurs 10Gigabit. On supprime ainsi les baies de stockage, le SAN et sa connectique dédiée. On élimine aussi la multiplicité de fournisseurs nécessaires pour assembler et valider une solution fonctionnelle — constructeur de baie de stockage, fournisseur de SAN, fournisseur de HBA et fabricant de serveurs. Cerise sur le gâteau, le pilotage de l’ensemble des composants se fait depuis une interface unique, en général intégrée à la console d’administration de l’hyperviseur - qu’il s’agisse de vSphere ou Hyper-V... Et le support est le fait d’un seul et même fournisseur.

Cette unification a aussi des conséquences organisationnelles. Le stockage devenant un service comme un autre, délivré de façon transparente par la plate-forme, il n’est plus forcément nécessaire de maintenir une expertise pointue en matière de stockage (une tendance aussi amplifiée par l’adoption rapide de la Flash comme support de stockage dans les datacenters). C’est a priori une bonne nouvelle pour les PME, dont les équipes IT sont, le plus sosuvent, composées de généralistes et qui jusqu’alors devaient s’appuyer sur l’expertise coûteuse d’intégrateurs. Mais c’est sans doute une très mauvaise nouvelle, pour certains spécialistes du stockage dans les grands comptes.

Des architectures évolutives

Une autre caractéristique intéressante des systèmes hyperconvergés est leur aptitude à évoluer avec les besoins. Le logiciel qui motorise ces plates-formes est en effet par nature conçu pour fonctionner en mode scale-out. Ce qui veut dire que l’on dope la capacité de stockage et de calcul par simple ajout de nœud. Et une fois cette nouvelle capacité ajoutée, le cluster redistribue automatiquement les workloads pour optimiser les performances.

A leurs débuts, on a beaucoup reproché aux systèmes hyperconvergés leur manque de flexibilité de leures premières configurations. Aujourd’hui, la plupart des fournisseurs proposent de multiples choix en matière de CPU et de capacité disque. On peut également combiner des systèmes asymétriques au sein d’un même cluster, moyennant le respect de certaines règles de bon sens. Si la capacité du cluster peut évoluer par ajout de nœuds additionnels, il est à noter que la capacité des nœuds elle-même ne peut en général être étendue au-delà de la capacité initiale. Les raisons ont souvent trait aux mécanismes de protection de données mis en œuvre sur chaque nœud, qui se prêtent mal à l’ajout à chaud de ressources disques sur le nœud. C’est un « inconvénient » aujourd’hui bien documenté et il convient là encore de faire preuve d’un peu de bon sens et d’anticipation lorsque l’on planifie son cluster.

Hyperconvergence : « Do-it-Yourself » ou appliances ?

L’un des débats en cours autour de l’hyperconvergence est de savoir s’il faut opter pour un mode de déploiement de type appliance (le mode de déploiement préconisé par Cisco, Nutanix, Scale Computing, Simplivity ou VCE, la division systèmes hyperconvergés d’EMC, ou s’il faut s’intéresser à un mode plus « Do-it-yourself ».

Pour certains, le principal atout de l’hyperconvergence est la convergence des couches stockage et serveur et non pas les scories plus ou moins propriétaires ajoutées par chacun pour enrober sa plate-forme. Des technologies de stockage distribuées comme celle de ScaleIO ou comme celle d’Hedwig permettent par exemple de converger stockage et serveur tout en gardant une liberté quasi totale en matière de plate-forme OS supportée et de mode de déploiement [physique, virtuel ou conteneur]. D’une certaine façon, n’importe quelle entreprise peut aussi mettre en œuvre la pile hyperconvergée de VMware sans passer par la case appliance. Il suffit pour cela de respecter les prescriptions d’architectures de l’éditeur.

Cette question se posera aussi bientôt avec les solutions open source. La prochaine déclinaison de Red Hat Virtualization pourra par exemple être déployée conjointement avec la couche de stockage distribuée Gluster de l’éditeur et une intégration validée avec Ceph est aussi promise à plus long terme. De quoi permettre à chaque entreprise de choisir comment elle souhaite entrer dans l’ère de l’hyperconvergence, si ce mode de déploiement lui convient.