Qu'est-ce que GPT-3 ? Tout ce qu'il faut savoir

Traduction Qu'est-ce que le GPT-3 ? Tout ce qu'il faut savoir

GPT-3, ou Generative Pre-trained Transformer de troisième génération, est un modèle d'apprentissage machine (ML) à réseau neuronal entraîné à l'aide de données internet pour générer n'importe quel type de texte. Développé par OpenAI, il nécessite une petite quantité de texte en entrée pour générer de grands volumes de textes pertinents et sophistiqués générés par la machine.

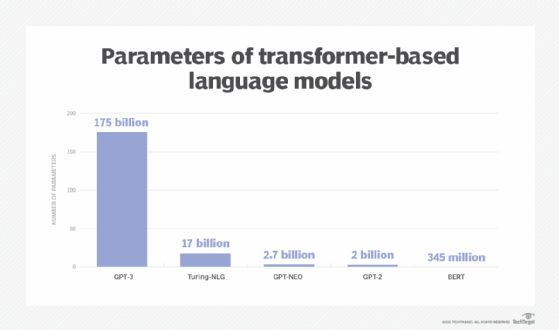

Le réseau neuronal d'apprentissage profond de GPT-3 est un modèle comportant plus de 17 milliards de paramètres ML. Pour mettre les choses en perspective, le plus grand modèle de langage entraîné avant GPT-3 était le modèle Turing de génération de langage naturel (NLG) de Microsoft, qui comptait 17 milliards de paramètres. Début 2021, GPT-3 sera le plus grand réseau neuronal jamais produit. Par conséquent, GPT-3 est meilleur que n'importe quel modèle antérieur pour produire des textes qui semblent avoir été écrits par un être humain.

Le GPT-3 et les modèles de traitement du langage similaires sont communément appelés grands modèles de langage (LLM). Les experts du secteur ont critiqué le développeur de GPT-3, OpenAI, et son ancien PDG, Sam Altman, pour être passé d'une approche open source à une approche fermée en 2019. Parmi les autres développeurs de LLM figurent Google DeepMind, Meta AI, Microsoft, Nvidia et X.

Que peut faire le GPT-3 ?

Le GPT-3 traite le texte d'entrée pour effectuer une variété de tâches en langage naturel. Il utilise à la fois le NLG et le traitement du langage naturel pour comprendre et générer des textes en langage humain naturel. Générer un contenu compréhensible pour les humains a toujours été un défi pour les machines qui ne connaissent pas les complexités et les nuances du langage. Le GPT-3 a été utilisé pour créer des articles, des poèmes, des histoires, des rapports d'actualité et des dialogues, en utilisant une petite quantité de texte d'entrée pour produire de grandes quantités de copies.

Le GPT-3 peut créer tout ce qui possède une structure textuelle, et pas seulement des textes en langage humain. L'une des principales capacités du GPT-3 est de comprendre et de générer des réponses cohérentes et pertinentes en fonction du contexte à un large éventail de questions. Il est très polyvalent dans des tâches telles que la rédaction d'essais et d'histoires, la réponse à des questions, le résumé de textes, la composition de poèmes et la génération de codes de programmation.

La grande taille du GPT-3 lui permet de capturer des modèles complexes dans les données textuelles et de générer des résultats fluides et adaptés au contexte. Il est donc très utile pour automatiser la création de contenu et améliorer les tâches de compréhension du langage naturel. La capacité du GPT-3 à comprendre et à générer des textes semblables à ceux d'un être humain ouvre la voie à des applications dans les domaines du service à la clientèle, de la création de contenu, de la traduction et de l'éducation.

Exemples et cas d'utilisation du GPT-3

Le modèle linguistique ChatGPT de l'OpenAI est un cas d'utilisation notable du GPT-3. ChatGPT est une variante du modèle GPT-3, optimisé pour le dialogue humain, qui peut poser des questions complémentaires, admettre ses erreurs et contester des prémisses incorrectes. ChatGPT a été mis gratuitement à la disposition du public pendant sa phase de recherche afin de recueillir les réactions des utilisateurs. Il a été conçu en partie pour réduire la possibilité de réponses nuisibles ou trompeuses.

Un autre exemple courant est Dall-E d'OpenAI, un réseau neuronal d'IA générateur d'images construit sur une version de 12 milliards de paramètres de GPT-3. Dall-E a été entraîné sur un ensemble de données de paires texte-image et peut générer des images à partir de textes envoyés par l'utilisateur.

En utilisant seulement quelques bribes de texte de code d'exemple, GPT-3 peut également créer un code utilisable qui peut être exécuté sans erreur, puisque le code de programmation est une forme de texte. En utilisant un peu de texte suggéré, un développeur a combiné l'outil de prototypage d'interface utilisateur Figma avec GPT-3 pour créer des sites web en les décrivant en une ou deux phrases. GPT-3 a même été utilisé pour cloner des sites web en fournissant une URL comme texte suggéré. Les développeurs utilisent GPT-3 de plusieurs manières, notamment pour générer des extraits de code, des expressions régulières, des tracés et des graphiques à partir de descriptions textuelles, de fonctions Excel et d'autres applications de développement.

Le GPT-3 commence à être utilisé dans le domaine de la santé. Une étude réalisée en 2022 a exploré la capacité du GPT-3 à faciliter le diagnostic de maladies neurodégénératives telles que la démence. Il détecte des symptômes courants, tels que les troubles du langage chez les patients, dans le cadre du processus de diagnostic.

Les outils d'IA basés sur le GPT-3 sont également utilisés pour les applications suivantes :

- Création de mèmes, de quiz, de recettes, de bandes dessinées, d'articles de blog et de textes publicitaires.

- Écrire de la musique, des blagues et des messages sur les médias sociaux.

- Automatiser les tâches conversationnelles en répondant à tout texte saisi par une personne dans l'ordinateur par un nouveau texte adapté au contexte.

- Traduire un texte en commandes programmatiques.

- Traduire les commandes programmatiques en texte.

- Effectuer une analyse des sentiments.

- Extraire des informations des contrats.

- Génération d'une couleur hexadécimale à partir d'une description textuelle.

- Écrire du code passe-partout.

- Trouver des bogues dans le code existant.

- Maquette de sites web.

- Générer des résumés simplifiés de textes.

- Traduire entre les langages de programmation.

- Exécuter des attaques malveillantes de type "prompt engineering" et "phishing".

Comment fonctionne le GPT-3 ?

Le GPT-3 est un modèle de prédiction linguistique. Cela signifie qu'il dispose d'un modèle de réseau neuronal qui peut prendre un texte en entrée et le transformer en ce qu'il prédit être le résultat le plus utile. Ces systèmes sont entraînés à l'aide d'un vaste corpus de textes Internet afin de repérer des modèles dans le cadre d'un processus appelé pré-entraînement génératif. GPT-3 a été entraîné sur plusieurs ensembles de données, chacun avec des poids différents, y compris Common Crawl, WebText2 et Wikipedia.

GPT-3 est d'abord formé par le biais d'une phase de test supervisé, puis d'une phase de renforcement. Lors de la formation de ChatGPT, une équipe de formateurs pose une question au modèle linguistique en ayant à l'esprit une réponse correcte. Si le modèle répond de manière incorrecte, les formateurs le modifient pour lui apprendre la bonne réponse. Le modèle peut également donner plusieurs réponses que les formateurs classent de la meilleure à la pire.

GPT-3 compte plus de 175 milliards de paramètres ML et est nettement plus grand que ses prédécesseurs, y compris les LLM antérieurs tels que Bidirectional Encoder Representations from Transformers (BERT). Les paramètres sont les parties d'un LLM qui définissent ses compétences sur un problème, tel que la génération de texte. Les performances d'un LLM augmentent généralement au fur et à mesure que des données et des paramètres sont ajoutés au modèle.

Lorsqu'un utilisateur saisit un texte, le système analyse la langue et utilise un prédicteur de texte basé sur sa formation pour créer le résultat le plus probable. Le modèle peut être affiné, mais même sans beaucoup de réglages ou d'entraînements supplémentaires, il génère un texte de sortie de haute qualité qui ressemble à ce que les humains produiraient.

Lorsqu'un utilisateur saisit un texte, le système analyse la langue et utilise un prédicteur de texte basé sur sa formation pour créer le résultat le plus probable. Le modèle peut être affiné, mais même sans beaucoup de réglages ou d'entraînements supplémentaires, il génère un texte de sortie de haute qualité qui ressemble à ce que les humains produiraient.

Quels sont les avantages du GPT-3 ?

Les avantages du GPT-3 sont les suivants

- Entrée et formation limitées. Lorsqu'une grande quantité de texte doit être générée par une machine sur la base d'une petite quantité de texte en entrée, GPT-3 constitue une bonne solution. Les LLM, comme le GPT-3, sont capables de fournir des résultats décents lorsqu'on leur donne une poignée d'exemples d'apprentissage.

- Large éventail d'applications. Le GPT-3 dispose également d'un large éventail d'applications en matière d'intelligence artificielle. Il est agnostique, ce qui signifie qu'il peut effectuer de nombreuses tâches sans réglage précis.

- Des résultats rapides et automatisés. Comme pour toute automatisation, le GPT-3 peut prendre en charge des tâches rapides et répétitives, ce qui permet à l'homme de s'occuper de tâches plus complexes exigeant un degré plus élevé de réflexion critique. Il existe de nombreuses situations dans lesquelles il n'est pas pratique ou efficace de faire appel à un humain pour générer un texte, ou dans lesquelles il peut être nécessaire de générer automatiquement un texte qui semble humain. Par exemple, les centres de service à la clientèle utilisent GPT-3 pour répondre aux questions des clients et soutenir les chatbots. Les équipes de vente l'utilisent pour entrer en contact avec des clients potentiels. Et les équipes marketing rédigent des textes à l'aide de GPT-3. Ce type de contenu nécessite une production rapide et présente peu de risques, ce qui signifie qu'en cas d'erreur dans le texte, les conséquences sont relativement mineures.

- Léger. Le GPT-3 est également facile à utiliser et fait un usage efficace de la puissance de calcul, de sorte qu'il peut fonctionner sur des ordinateurs portables et des smartphones grand public.

Quels sont les risques et les limites du GPT-3 ?

Bien que le GPT-3 soit remarquablement vaste et puissant, il présente plusieurs limites et risques liés à son utilisation.

Limites

- Pré-entraînement. Le GPT-3 n'est pas en apprentissage permanent. Il a été préformé, ce qui signifie qu'il ne dispose pas d'une mémoire permanente à long terme qui apprend à chaque interaction.

- Taille d'entrée limitée. Les architectures de transformateurs telles que GPT-3 ont une taille d'entrée limitée. L'utilisateur ne peut pas fournir beaucoup de texte en entrée de la sortie, ce qui peut limiter certaines applications. Le GPT-3 a une limite d'invite d'environ 2 048 tokens.

- Temps d'inférence lent. Le GPT-3 souffre également d'un temps d'inférence lent, car il faut beaucoup de temps pour que le modèle génère des résultats.

- Manque d'explicabilité. Le GPT-3 est sujet aux mêmes problèmes que de nombreux réseaux neuronaux, notamment le manque de capacité à expliquer et à interpréter pourquoi certaines entrées produisent des sorties spécifiques.

Risques

- Le mimétisme. Les modèles linguistiques tels que le GPT-3 deviennent de plus en plus précis et le contenu généré par les machines pourrait devenir difficile à distinguer du contenu généré par l'homme. Cela pourrait poser des problèmes de droits d'auteur et de plagiat.

- Précision. Bien qu'il soit capable d'imiter le format d'un texte généré par l'homme, le GPT-3 a du mal à être précis dans de nombreuses applications.

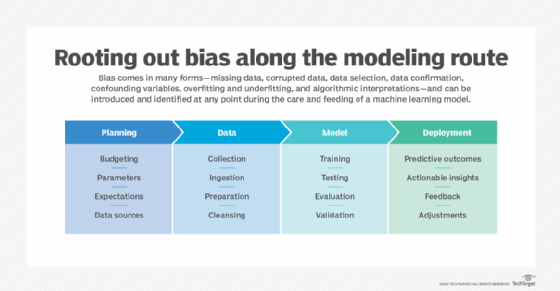

- Biais. Les modèles linguistiques sont sujets à des biais liés à l'apprentissage automatique. Étant donné que le modèle a été formé sur du texte Internet, il est susceptible d'apprendre et de présenter de nombreux biais que les humains présentent en ligne. Par exemple, deux chercheurs du Middlebury Institute of International Studies de Monterey ont découvert que le modèle GPT-2, prédécesseur du modèle GPT-3, est capable de générer des textes radicaux, y compris des discours imitant les théoriciens du complot et les suprémacistes blancs. Il est donc possible d'amplifier et d'automatiser les discours haineux, mais aussi d'en générer par inadvertance. ChatGPT, qui s'appuie sur une variante de GPT-3, vise à réduire la probabilité que cela se produise grâce à une formation plus intensive et au retour d'information des utilisateurs.

Modèles GPT-3

OpenAI, le développeur original de GPT-3, possède plusieurs modèles GPT-3. Les algorithmes de chaque modèle d'IA GPT-3 ont été développés à l'aide de données d'entraînement différentes et sont conçus pour des tâches spécifiques. Les plus importants sont les suivants :

- Text-ada-001. Il s'agit du modèle le plus rapide de la série GPT-3. Il est idéal pour les tâches simples nécessitant des réponses rapides, telles que l'extraction de mots-clés, l'exploration de textes et la génération de textes de base.

- Texte-babbage-001. Ce modèle offre des performances modérées, idéales pour des tâches simples telles que la réponse à des questions de base et l'analyse de données.

- Texte-curie-001. Il s'agit d'un modèle intermédiaire qui concilie vitesse et qualité. Il est particulièrement adapté aux robots interactifs et aux robots de conversation, à la traduction et à la génération de contenu de base.

- Texte-davinci-003. Il s'agit du modèle le plus complexe utilisé pour la rédaction professionnelle, l'IA conversationnelle et l'analyse des sentiments.

Industries utilisant le GPT-3

Le GPT-3 est utilisé par une série d'industries telles que les suivantes :

- Soins de santé, pour l'analyse de la littérature médicale et l'aide au diagnostic.

- Commerce électronique et vente au détail, y compris la création de recommandations et de descriptions de produits.

- Finance, pour l'assistance à la clientèle et la production de rapports financiers.

- Marketing, pour l'assistance à l'optimisation des moteurs de recherche et l'analyse des tendances du marché.

L'histoire de la GPT-3

Créée en 2015 en tant qu'organisation à but non lucratif, OpenAI a développé GPT-3 dans le cadre de ses projets de recherche. Son objectif est de promouvoir et de développer une "IA conviviale" qui profite à l'ensemble de l'humanité.

La première version de GPT a été publiée en 2018 et contenait 117 millions de paramètres. La deuxième version du modèle, GPT-2, a été publiée en 2019 avec environ 1,5 milliard de paramètres. GPT-3 a largement dépassé GPT-2 avec plus de 175 milliards de paramètres - plus de 100 fois son prédécesseur et 10 fois plus que des programmes comparables.

Des modèles pré-entraînés antérieurs, tels que BERT, ont démontré la viabilité de la méthode du générateur de texte et la capacité des réseaux neuronaux à générer de longues chaînes de texte qui semblaient auparavant irréalisables.

L'OpenAI a donné accès au GPT-3 de manière progressive afin de voir comment il serait utilisé et d'éviter les problèmes potentiels. Le modèle a été publié au cours d'une période bêta pendant laquelle les utilisateurs devaient s'inscrire pour l'utiliser, initialement sans frais. Toutefois, la période bêta a pris fin en octobre 2020 et l'entreprise a publié un modèle de tarification basé sur un système de crédits à plusieurs niveaux, allant d'un niveau d'accès gratuit pour 100 000 crédits ou trois mois d'accès à des centaines de dollars par mois pour un accès à plus grande échelle. En 2020, Microsoft a investi 1 milliard de dollars dans OpenAI pour devenir le détenteur exclusif de la licence du modèle GPT-3. Cela signifie que Microsoft a un accès exclusif au modèle sous-jacent de GPT-3.

ChatGPT a été lancé en novembre 2022 et son utilisation était gratuite pour le public pendant sa phase de recherche. Le GPT-3 a ainsi attiré davantage l'attention du grand public qu'il ne l'avait fait auparavant, donnant à de nombreux utilisateurs non techniques l'occasion d'essayer la technologie. GPT-4 a été lancé en mars 2023 et est estimé à 1,76 trillion de paramètres. OpenAI n'a toutefois pas indiqué publiquement le nombre exact de paramètres de GPT-4.

L'avenir du GPT-3

De nombreux efforts sont déployés pour fournir un modèle gratuit et sans licence afin de contrebalancer le statut de détenteur de licence exclusive de Microsoft pour le GPT-3. De nouveaux modèles linguistiques sont publiés fréquemment sur la plateforme Hugging Face.

On ne sait pas exactement comment le GPT-3 se développera à l'avenir, mais il est probable qu'il continuera à trouver des utilisations dans le monde réel et qu'il sera intégré dans diverses applications d'IA générative. De nombreuses applications utilisent déjà le GPT-3, notamment l'assistant virtuel Siri d'Apple. Dans la mesure du possible, le GPT-4 est intégré là où le GPT-3 a été utilisé.

GPT-3 est un modèle d'IA générative. Découvrez la différence entre l'IA générative et l'IA prédictive.