Qu'est-ce que le biais d'apprentissage automatique (biais d'IA)

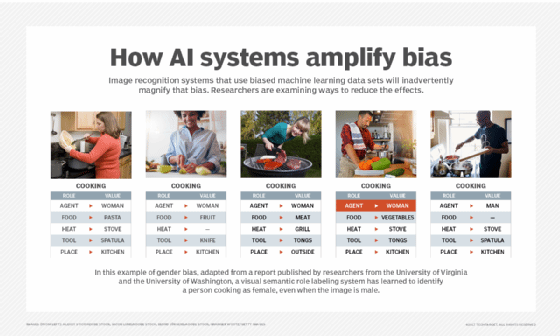

Le biais d'apprentissage automatique, également connu sous le nom de biais d'algorithme ou de biais d'IA, est un phénomène qui se produit lorsqu'un algorithme produit des résultats qui sont systématiquement préjudiciables en raison d'hypothèses erronées dans le processus d'apprentissage automatique (ML).

L'apprentissage automatique, un sous-ensemble de l'intelligence artificielle (IA), dépend de la qualité, de l'objectivité, de la portée et de la taille des données de formation utilisées pour l'enseigner. Des données d'apprentissage défectueuses, médiocres ou incomplètes entraînent des prédictions faussées ou inexactes, reflétant l'admonestation "garbage in, garbage out" utilisée en informatique pour transmettre le concept selon lequel la qualité de la sortie est déterminée par la qualité de l'entrée.

Les biais de ML proviennent généralement de problèmes introduits par les personnes qui conçoivent et forment les systèmes de ML. Ces personnes peuvent créer des algorithmes qui reflètent des biais cognitifs involontaires ou des préjugés réels. Elles peuvent également introduire des biais dans les modèles de ML parce qu'elles utilisent des ensembles de données incomplets, erronés ou préjudiciables pour former et valider les systèmes de ML.

Les types de biais cognitifs susceptibles d'affecter involontairement les algorithmes de ML comprennent les stéréotypes, l'effet de bande, l'amorçage, la perception sélective et le biais de confirmation.

Bien que ces biais soient souvent involontaires, les conséquences de leur présence dans les systèmes de ML peuvent être importantes. Selon la manière dont les systèmes de ML sont utilisés, ces biais peuvent entraîner de mauvaises expériences en matière de service à la clientèle, une réduction des ventes et des recettes, des actions injustes, voire illégales, et des conditions potentiellement dangereuses.

Pour éviter les modèles biaisés, les organisations doivent vérifier que les données utilisées pour former les modèles de ML ne sont pas incomplètes et ne présentent pas de biais cognitifs. Les données doivent être représentatives des différentes races, sexes, origines et cultures susceptibles d'être affectées. Les data scientists qui développent les algorithmes devraient façonner les échantillons de données de manière à minimiser les biais algorithmiques et autres types de biais de ML, et les décideurs devraient évaluer quand il est approprié ou inapproprié d'appliquer la technologie de ML.

Types de biais d'apprentissage automatique

Il existe plusieurs façons d'introduire des biais dans un système de ML. Les scénarios les plus courants, ou types de biais, sont les suivants :

- Biais d'algorithme. Cela se produit lorsqu'il y a un problème au sein de l'algorithme qui effectue les calculs ou d'autres traitements qui alimentent les calculs de ML.

- Biais d'automatisation. Ce phénomène se produit lorsque les résultats des systèmes automatisés sont préférés à ceux des systèmes humains ou d'autres systèmes non automatisés, même si le système automatisé n'est pas nécessairement plus précis. En d'autres termes, les utilisateurs font davantage confiance à l'IA.

- Biais d'échantillonnage. Cela se produit lorsqu'il y a un problème avec les données utilisées pour former le modèle ML. Dans ce type de biais, les données utilisées ne sont pas assez nombreuses ou représentatives pour apprendre au système. Par exemple, l'utilisation de données de formation ne comportant que des enseignantes entraîne le système à conclure que tous les enseignants sont des femmes.

- Préjugés. Dans ce cas, les données utilisées pour former le système reflètent les préjugés, les stéréotypes et les hypothèses sociétales erronées existants, introduisant ainsi ces mêmes préjugés du monde réel dans l'apprentissage automatique lui-même. Par exemple, l'utilisation de données sur les professionnels de la santé qui ne comprennent que des infirmières et des médecins masculins pourrait perpétuer un stéréotype de genre réel sur les travailleurs de la santé dans le système informatique.

- Préjugés implicites. À l'instar des préjugés, les préjugés implicites se produisent lorsque les modèles sont conçus ou que les données sont traitées en fonction des modes de pensée ou des expériences personnelles du concepteur humain, qui peuvent ne pas correspondre entièrement ou précisément à la tâche à accomplir.

- Le biais d'attribution au groupe. Il se produit lorsque les caractéristiques d'un individu ou d'un échantillon unique sont appliquées de manière inappropriée à un ensemble plus large d'individus ou à un groupe de points de données. De telles généralisations faites à propos d'un groupe entier peuvent négliger les nuances des échantillons individuels.

- Biais de mesure. Comme son nom l'indique, ce biais est dû à des problèmes sous-jacents liés à l'exactitude des données et à la manière dont elles ont été mesurées ou évaluées. L'utilisation de photos de travailleurs heureux pour former un système destiné à évaluer l'environnement de travail pourrait être biaisée si les travailleurs figurant sur les photos savaient qu'on mesurait leur bonheur ; un système formé pour évaluer précisément le poids est biaisé si les poids contenus dans les données de formation ont été systématiquement arrondis vers le haut ou vers le bas.

- Le biais d'exclusion ou de déclaration. Cela se produit lorsqu'un point de données important n'est pas pris en compte dans les données utilisées. Cela peut se produire si les modélisateurs ne reconnaissent pas l'importance de ce point de données. Par exemple, les incidents signalés dans les analyses de la criminalité policière peuvent être faussés lorsque les incidents ne sont pas signalés ou ne sont pas suffisamment signalés parce que les victimes ne signalent pas les incidents.

- Biais de sélection. Il se produit lorsque les données utilisées pour la formation ne sont pas assez nombreuses ou représentatives, ce qui fausse et diminue les résultats et les performances en matière de précision. Il existe plusieurs variantes du biais de sélection, notamment le biais de couverture lorsque les données ne sont pas représentatives, le biais de participation lorsque les non-réponses laissent des lacunes dans les données, et le biais d'échantillonnage lorsque la randomisation statistique n'est pas utilisée.

- Biais de rappel. Ce biais de qualité des données se développe au stade de l'étiquetage des données, lorsque les étiquettes sont données de manière incohérente par le biais d'observations subjectives. Le rappel est mesuré en fonction du nombre de points étiquetés avec précision par rapport au nombre total d'observations dans un modèle.

Biais et variance

Les data scientists et autres personnes impliquées dans la construction, l'entraînement et l'utilisation de modèles de ML doivent tenir compte non seulement des biais, mais aussi de la variance lorsqu'ils cherchent à créer des systèmes capables de fournir des résultats toujours exacts.

Comme le biais, la variance est une erreur qui survient lorsque l'apprentissage automatique produit des hypothèses erronées sur la base des données d'apprentissage. Contrairement au biais, la variance est une réaction à des fluctuations réelles et légitimes dans les ensembles de données. Ces fluctuations, ou bruit, ne devraient pas affecter le modèle prévu, mais le système peut quand même utiliser ce bruit pour la modélisation. En d'autres termes, la variance est une sensibilité problématique à de petites fluctuations dans l'ensemble de données d'apprentissage, qui, comme le biais, peut produire des résultats inexacts.

En d'autres termes, la variance est la différence entre les résultats obtenus à partir de sous-ensembles ou de parties des données d'apprentissage. Par exemple, si le modèle est entraîné à l'aide d'un sous-ensemble des données totales et qu'on lui demande ensuite d'effectuer des déterminations, la variance correspondra à la différence entre les résultats obtenus pour chaque sous-ensemble d'entraînement. Idéalement, la variance devrait être faible ou nulle. Des ensembles de données mal sélectionnés peuvent entraîner une variance inutilement ou inacceptablement élevée.

La variance peut être réduite par une application minutieuse des méthodologies de la science des données, notamment la validation croisée des données, la limitation de la sélection des caractéristiques dans les données, la comparaison des résultats de modèles similaires ou d'ensemble, la simplification des modèles et la prévention de l'ajustement excessif.

Bien que le biais et la variance soient différents, ils sont liés en ce sens qu'un niveau de variance peut contribuer à réduire le biais et qu'un niveau de biais peut contribuer à réduire la variance. Si la population de données est suffisamment variée, les biais devraient être noyés dans la variance. La sensibilité aux biais et à la variance est souvent influencée par les types d'algorithmes de ML utilisés. Voici quelques exemples :

- Les algorithmes de regroupement peuvent apporter un biais faible et une variance élevée.

- Les algorithmes d'arbres de décision peuvent apporter un biais faible et une variance élevée.

- Les algorithmes de régression linéaire peuvent entraîner un biais élevé et une faible variance.

- Les algorithmes de forêt aléatoire peuvent apporter un biais faible et une variance élevée.

En tant que tel, l'objectif de l'apprentissage automatique est de trouver un compromis, ou un équilibre, entre les deux afin de développer un système qui produise un nombre minimal d'erreurs.

Comment les biais se produisent à chaque étape du pipeline de ML/du cycle de vie du développement ML

Les biais représentent un ensemble d'erreurs insidieuses qui résultent généralement d'une connaissance humaine imparfaite, de mauvaises hypothèses ou d'algorithmes faibles, et parfois d'une intention malveillante. Bien que les biais soient souvent considérés comme un problème de données, les experts en IA doivent apprendre à reconnaître le potentiel de biais aux points suivants du pipeline de ML :

- Les données. Les données sont souvent biaisées au début du cycle de vie du ML. Les biais peuvent survenir lors de la phase de collecte des données, lorsque les données brutes sont mal sélectionnées, incomplètes ou fausses sous quelque forme que ce soit. Des biais peuvent également apparaître lors de la phase de préparation des données, lorsque les données sont nettoyées et transformées avant d'être intégrées dans un modèle pour l'entraînement, comme des valeurs manquantes ou des erreurs d'arrondi. Enfin, les biais peuvent apparaître lors de la phase de sélection des caractéristiques, lorsque les spécialistes des données sélectionnent les détails pertinents des données nécessaires à la réussite de la prédiction du modèle.

- Modèle. Les biais peuvent être amplifiés lors de la sélection des modèles ou des algorithmes tels que la classification ou la régression ; certains algorithmes sont plus sensibles aux biais et à la variance que d'autres. Certaines plateformes d'IA utilisent plusieurs modèles contradictoires pour contrebalancer le risque d'erreurs ou de biais de modèle.

- Développement. Les biais peuvent être exacerbés pendant la phase de développement, lorsque les modèles sont codés, si nécessaire, et subissent une formation et des tests. Les erreurs dans les algorithmes peuvent avoir un impact sur les biais à ce stade. De mauvaises pratiques de formation, telles qu'un retour d'information humain inadéquat ou absent et une validation insuffisante avec un ensemble de données de test restreint ou insuffisant, auront un effet négatif sur le modèle.

- Opérations. Des biais peuvent également survenir après le déploiement, lorsqu'un modèle fonctionne en production. Un retour d'information humain inapproprié peut entraîner des erreurs dans le modèle, réduisant ainsi son efficacité. En outre, les humains doivent appliquer certaines de leurs propres interprétations et opinions sur les résultats du modèle. Les utilisateurs qui n'ont pas confiance dans les prédictions ou qui ne les "aiment" pas peuvent insérer leurs propres erreurs et préjugés après coup, ce qui réduit la valeur du modèle.

Comment prévenir les préjugés

La sensibilisation et la gouvernance peuvent contribuer à prévenir les biais liés à l'apprentissage automatique. Une organisation qui reconnaît le potentiel de biais peut mettre en œuvre et instituer des meilleures pratiques pour le combattre, qui comprennent les étapes suivantes :

- Sélectionnez des données d'entraînement suffisamment représentatives, vastes et diversifiées pour contrecarrer les types courants de biais de ML, tels que le biais d'échantillonnage et le biais de préjugé. Rien ne peut remplacer l'examen humain et la collaboration dans les activités de qualité des données telles que l'étiquetage des données.

- Tester et valider pour s'assurer que les résultats des systèmes de ML ne reflètent pas de biais dus aux algorithmes ou aux ensembles de données.

- Surveiller les systèmes de ML pendant qu'ils effectuent leurs tâches pour s'assurer que les biais ne s'insinuent pas au fil du temps, car les systèmes continuent d'apprendre au fur et à mesure qu'ils travaillent.

- Utilisez des ressources supplémentaires, telles que l'outil d'analyse d'hypothèses de Google ou la boîte à outils open source AI Fairness 360 d'IBM, pour examiner et inspecter les modèles.

- Créez une méthode de collecte de données qui tienne compte des différentes opinions. Un point de données peut avoir plusieurs options valables pour les étiquettes. Lors de la collecte initiale des données, la prise en compte de ces options augmente la flexibilité du modèle.

- Comprendre toutes les données d'entraînement utilisées, car ces ensembles de données d'entraînement peuvent contenir des classes ou des étiquettes susceptibles d'introduire des biais. Ne négligez pas l'importance d'un étiquetage et d'une annotation cohérents et de haute qualité des données.

- Examiner en permanence le modèle ML et prévoir des améliorations au fur et à mesure des retours d'information.

- Éviter l'imputation, qui est un biais introduit lorsque des humains remplissent des entrées manquantes ou incomplètes dans des ensembles de données.

Histoire de l'apprentissage automatique

Le terme "biais algorithmique" a été défini pour la première fois par Trishan Panch et Heather Mattie dans le cadre d'un programme de la Harvard T.H. Chan School of Public Health. Le biais algorithmique est un risque connu depuis des décennies, mais il reste un problème complexe qu'il est difficile de contrer.

En fait, les biais du ML ont déjà été impliqués dans des cas réels, certains biais ayant des conséquences importantes, voire mortelles.

Le COMPAS en est un exemple. L'algorithme COMPAS - abréviation de Correctional Offender Management Profiling for Alternative Sanctions - utilisait le ML pour prédire le potentiel de récidive des accusés criminels. Plusieurs États ont déployé ce logiciel au début du XXIe siècle, avant que ses préjugés à l'égard des personnes de couleur ne soient révélés et rendus publics par la suite dans des articles de presse.

En 2018, Amazon, un géant de l'embauche dont les politiques de recrutement influencent celles d'autres entreprises, a supprimé son algorithme de recrutement après avoir constaté qu'il identifiait des schémas de mots. Plutôt que des compétences pertinentes, l'algorithme pénalisait par inadvertance les CV contenant certains mots, y compris ceux des femmes - un biais qui favorisait les candidats masculins par rapport aux candidates en réduisant les CV des femmes.

La même année, des chercheurs universitaires ont annoncé que les systèmes commerciaux d'IA pour la reconnaissance faciale comportaient des biais liés au sexe et au type de peau.

Les biais de ML sont également apparus dans le domaine médical. Par exemple, en 2019, une étude a dévoilé que des préjugés raciaux ont été trouvés dans un système basé sur l'IA qui a décidé quels patients avaient besoin de soins dans plusieurs hôpitaux. L'algorithme d'IA a montré un biais racial, car les patients noirs ont été étiquetés comme étant plus malades que les patients blancs recommandés pour les mêmes soins.

Le document de recherche 2024 intitulé "How Much Does Racial Bias Affect Mortgage Lending ? Evidence from Human and Algorithmic Credit Decisions" de la Federal Reserve Bank de Philadelphie a montré que les biais de l'IA étaient responsables en 2018 et 2019 du refus de 18 % des demandeurs de prêts hypothécaires noirs. De même, un article rapporté par The Markup et distribué par l'Associated Press en août 2021 montre que les prêteurs étaient 40 % plus susceptibles de refuser des candidats latinos, 50 % plus susceptibles de refuser des candidats asiatiques/insulaires du Pacifique, 70 % plus susceptibles de refuser des candidats amérindiens et 80 % plus susceptibles de refuser des candidats noirs, par rapport à des candidats blancs similaires.

En savoir plus sur les moyens de réduire les biais liés à l'apprentissage automatique sous ses différentes formes.