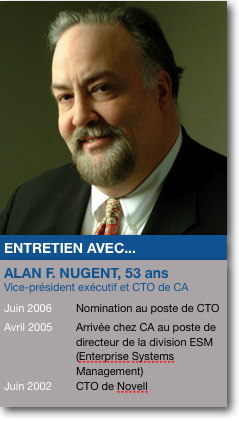

Alan Nugent, CA : « automatiser l'administration de l'IT pour éviter l'implosion de la DSI »

La rédaction du MagIT a pu s'entretenir avec le directeur technique (CTO) de CA (ex Computer Associates), à l'occasion du lancement par l'éditeur de huit nouveaux produits d'administration. L'occasion de faire un point général sur la façon dont CA approche l'administration de systèmes, mais aussi sur l'impact de la virtualisation, l'évolution des mainframe, le poids d'Itil ou l'irruption de CA dans de nouveaux marchés comme la gestion de risques.

Si l'on regarde ce qu'il s'est passé il y a dix ans avec les grands outils de supervision (les framework Tivoli, OpenView, Unicenter), on ne peut que dresser un constat d'échec. Le niveau d'intégration avec les produits qu'ils étaient censés administrer était pour le moins léger…

Si l'on regarde ce qu'il s'est passé il y a dix ans avec les grands outils de supervision (les framework Tivoli, OpenView, Unicenter), on ne peut que dresser un constat d'échec. Le niveau d'intégration avec les produits qu'ils étaient censés administrer était pour le moins léger…

Al Nugent : Vous êtes trop bon.

Qu'est qui a changé dans vos produits modernes d'administration et d'automatisation et qui pourrait éviter une répétition de l'histoire ?

A.N. : On a assisté à un effort concerté au sein de l'industrie pour fournir des informations et des événements normalisés directement depuis les plates-formes systèmes. Nous avons aussi clarifié ce qui relève du domaine de la gestion des fautes, de la remédiation et de la gestion des performances. (…) Une des raisons qui fera le succès à long terme de notre stratégie EITM (Entreprise IT Management) : les vendeurs, consciemment ou non, fournissent aux éditeurs comme nous les outils nécessaires pour rendre nos produits plus efficaces et plus pertinents. La bonne nouvelle, c'est que nos produits peuvent tirer parti de ces données, la mauvaise, c'est que toute la partie qui concerne l'administration de base des produits se banalise rapidement. Autant dire que, dans ces conditions, CA serait fou de se concentrer sur cette partie, qui relève de plus en plus des fournisseurs de plates-formes. Notre valeur ajoutée réside dans une approche plus globale où nous agrégeons les événements collectés et fournissons la meilleure aide à la décision possible.

On voit de plus en plus de nouvelles technologies de script au niveau de l'OS, chez Microsoft (ce qui est nouveau), mais aussi chez Novell ou des technologies d'analyse approfondies de l'OS et de ses composants (via l'instrumentation MOM chez Microsoft ou Dtrace chez Sun). N'est-ce pas l'occasion d'une intégration plus forte avec les plates-formes plutôt que de passer par des protocoles mous de types services web ?

A.N. : Vous avez raison, il y a un intérêt à tirer parti des capacités natives des plates-formes. Avec ces technologies, l'opportunité existe de fournir de meilleures données aux outils qui traitent et réagissent aux événements générés par le système d'information. Les techniques de scripting facilitent aussi l'intégration avec la plate-forme pour permettre aux outils d'administration de participer à des processus automatisés. La différence entre il y a 10 ans et aujourd'hui réside dans cet effort concerté chez les fournisseurs, afin d'éviter ce qui a bloqué les anciens hyperviseurs de CA, IBM ou HP. De plus en plus, nous avons l'aptitude à accéder aux événements bruts et non pas uniquement aux informations filtrées par tel ou tel outil ou agent. Avec Dtrace par exemple, on peut collecter des événements très pointus ou faire une analyse à spectre large. C'est une première pour des éditeurs comme nous.

On assiste aussi à un effort pour normaliser les événements à un format XML Standard approuvé par l'OASIS (WEF ou WSDM Event Format). Cela simplifie notre travail. Nos outils n'ont plus à décoder des flux de données d'administration propriétaires, et ils peuvent se concentrer sur le contenu du message, la corrélation des événements, l'automatisation des réponses. Autre bonne nouvelle : avec WEF, on n'obtient pas une information prédigérée par un outil tiers et qui aurait pu perdre de sa substance. On accède aux événements bruts, ce qui nous permet d'appliquer nos propres algorithmes de traitement, de corrélation et d'analyse… Il y a dix ans les frameworks étaient capables de capturer un nombre très élevé d'événements, mais il n'y avait pas vraiment de façon homogène de les coordonner, de les corréler et encore moins de les relier à un processus métier. C'est ce que font nos outils aujourd'hui et nous aurons d'ailleurs une démonstration avancée lors du prochain CA World (qui se tiendra du 16 au 20 novembre prochain, à Las Vegas).

C'est l'un de ces cas où l'obtention de plus d'information permet une meilleure décision ?

A.N. : Absolument et le processus de prise de décision s'en trouve amélioré par le fait que l'on accède à une information de qualité. Ce n'est qu'en ayant une information fiable et en laquelle on a confiance que l'on peut espérer inciter les utilisateurs à plus d'automatisation. La croissance des environnements IT requiert de plus en plus d'automatisation sous peine de faire imploser les équipes IT. Mais nombre de professionnels de l'IT n'accepteront d'automatiser certains processus que s'ils sont sûr de la qualité des événements collectés et satisfaits de la façon dont ils sont traités. C'est une question de confiance.

La virtualisation prend de plus en plus d'ampleur et c'est un domaine auquel CA s'intéresse, par exemple avec un produit comme ASM. Quel rôle entendez-vous jouer sur ce secteur ? S'agit-il pour vous de fournir une alternative aux consoles des éditeurs d'outils de virtualisation ou plutôt de fournir un parapluie capable de chapoter les outils d'éditeurs divers ?

A.N. : Nous travaillons de façon rapprochée avec les plus grands éditeurs du secteur, comme VMWare, Microsoft, Citrix, Red Hat ou Novell. VMWare est un exemple intéressant. Il s'est peu à peu imposé comme le Microsoft de la virtualisation. Si vous avez un environnement 100% VMWare, cela fait sens de n'opter que pour leurs outils et c'est ce que font certaines sociétés. En revanche, la plupart des clients avec lesquels nous traitons mixent du VMWare avec d'autres technologies de virtualisation, qu'il s'agisse des containers de Solaris ou des capacités de partitionnement physique des serveurs Unix. Pour ces clients, les outils de VMWare ne suffisent pas. C'est là que nous avons un rôle à jouer : pour CA, la virtualisation n'est qu'une technologie supplémentaire à administrer comme le réseau, les applications, les postes de travail. Certes, elle pose des problèmes spécifiques. Mais, malgré cela, il faut être capable de faire le lien entre ce qui est virtualisé et ce qui ne l'est pas.

La virtualisation amène une gestion plus dynamique des datacenters en permettant par exemple d'ajouter à la volée une nouvelle instance applicative en cas de charge accrue ou de la supprimer lorsque la charge diminue. Cela ouvre une nouvelle porte en termes d'administration et d'automatisation des processus IT…

A.N. : Nous sommes passés d'un scénario où l'on utilise la virtualisation pour faire de la consolidation à un mode de gestion plus dynamique du datacenter. On peut effectivement penser qu'il est plus simple d'instancier une nouvelle image système dans VMWare ou Hyper-V que de monter un nouveau serveur et de pousser une image système dessus avant de le démarrer. Nous tentons de rester agnostiques : nos outils d'automatisation peuvent provisionner automatiquement un nouveau serveur virtuel comme provisionner un serveur matériel, c'est à l'administrateur de définir le scénario le plus adapté à ses impératifs de SLA (accords de niveaux de service, ndlr). Il n'en reste pas moins que nous surveillons de près le secteur de la virtualisation, ne ce serait-ce que pour comprendre l'impact que pourront avoir à terme des technologies comme la virtualisation d'entrées/sorties et adapter nos produits en conséquence.

Le mainframe est toujours vivant chez CA…

A.N. : Oui, c'est une activité importante.

Le traitez-vous comme un silo à part ou comme une forme de serveur "comme les autres" ?

A.N. : Mon équipe considère que le mainframe est un composant à part entière du datacenter moderne. Lors du dernier CA World, nous avions d'ailleurs montré un scénario où nos outils collectaient des événements normalisés de plusieurs plates-formes, y compris un mainframe. Nous lancerons encore de nouveaux produits pour les mainframes, même si leur cycle de développement et de test est plus long que celui des autres produits, pour des raisons évidentes. Le mainframe n'est donc pas dans un silo chez CA, c'est un serveur important parmi tous les autres.

De plus en plus de vos produits, par exemple les outils de gestion de risque, dépassent le cadre strict de l'IT. Est-ce un segment que vous tentez de développer ?

A.N. : Notre GRC (Gouvernance, gestion des risques et conformité, ndlr) Manager est le début d'un nouveau business pour nous. Il y a 18 mois, nous nous sommes rendus compte que certains de nos clients utilisaient les produits de Clarity (un éditeur racheté par CA, ndlr) pour des activités hors du domaine de l'informatique. Coca Cola par exemple gérait le processus de développement de ses nouveaux produits dans Clarity. Ce constat nous a incité à appliquer des technologies issues de la gestion de service IT à d'autres domaines. C'est ce qui a donné naissance à GRC Manager. Ce secteur devrait d'ailleurs donner naissance à de nouveaux produits de gouvernance dont le spectre va s'étendre hors de l'IT. C'est une évolution naturelle. Si notre métier d'origine se banalise, il nous faut trouver de nouveaux segments générateurs de revenus. Nous sommes bien positionnés d'un point de vue technique et marché pour tirer parti de l'intérêt des organisations pour la gestion des risques, la gouvernance et la gestion d'événements non IT par exemple dans la santé, mais aussi au sein d'équipements en réseau.

Cette mutation passe-t-elle par un regain d'intérêt pour des secteurs verticaux ?

A.N. : Oui

Certains parlent d'une approche à base de processus à propos d'Itil et considèrent que l'on va voir émerger des PGI pour gérer l'informatique d'entreprise. Est-ce l'objet de votre stratégie EITM ?

A.N. : J'aime l'analogie d'une approche intégrée pour résoudre les problèmes de supervision et de gouvernance. Ceci dit, il y a eu tellement d'implémentations catastrophiques de PGI… Je crois que beaucoup de problèmes sont venus d'une approche "Rip and replace" (littéralement, virer l'existant pour tout remplacer, ndlr). Certains ont aussi commis l'erreur de vouloir remplacer les processus câblés dans les outils par leurs propres processus. 200 M$ de développement plus loin, ils n'avaient toujours rien qui marchait ! Dans le climat économique actuel, ce n'est pas une démarche acceptable. Il faut comprendre comment apporter de la valeur aux clients plutôt que de les convaincre de tout changer. L'homogénéisation des processus IT peut être une démarche positive, si elle permet aux entreprises de se concentrer sur les processus qui leur apportent de la valeur.