IA locale : Microsoft veut confier le paramétrage de Windows 11 à un SLM

Le petit modèle de langage Mu (à peine 330 millions de paramètres) a été entraîné pour effectuer de petites tâches en local, sur un NPU. Par exemple, pour régler les options de Windows 11.

Microsoft poursuit sa stratégie consacrée à l’IA locale. Après avoir présenté Windows AI Foundry, Windows AI Dev Gallery et le modèle Phi Silica, la firme de Redmond a présenté la semaine dernière Mu, un petit langage de modèle adapté pour s’exécuter sur un processeur « neuronal » (NPU).

Les PC+Copilot du fournisseur sont équipés d’une puce IA à la puissance limitée : jusqu’à 45 TOPS. Sachant que ses clients et ceux de ses partenaires (Dell, HP, Lenovo, etc.) entendent conserver ces machines plus longtemps qu’à l’accoutumée, le fournisseur sait qu’il doit réduire l’empreinte des LLM.

330 millions de paramètres, plus 100 tokens/seconde

Mu répond à cette contrainte : le modèle « text-to-text » ne dispose que de 330 millions de paramètres. Pour autant, même chargé sur un NPU, il serait capable de répondre à une vitesse supérieure à 100 tokens par seconde. Comme certains LLM basés sur une architecture SMoE (Sparse Mixture of Experts).

Mu s’appuie sur un transformer, mais contrairement à la majorité des modèles du marché, il n’est pas uniquement un décodeur. Les chercheurs de Microsoft ont choisi l’approche encodeur-décodeur, à l’instar de Google avec BERT.

Avec l’approche encodeur-décodeur, un encodeur est chargé de convertir les textes tokenisés en entrée en « une représentation de taille fixe » – un embedding ou vecteur de taille unique. Le décodeur génère des tokens à partir de cet embedding.

« En séparant les tokens d’entrée des tokens de sortie, l’encodage unique de Mu réduit considérablement les frais de calcul et de mémoire », écrivent les chercheurs. « Dans la pratique, cela se traduit par une latence plus faible et un débit plus élevé sur du hardware spécialisé ».

En comparaison avec un autre SLM de même taille basé sur une architecture « decoder only », déployée sur le même équipement (une puce Hexagon de Qualcomm), Mu produirait son premier token avec une latence 47 % inférieure et décoderait les données 4,7 fois plus rapidement.

Mu, un SLM optimisé pour l’architecture des NPU

Les chercheurs de Microsoft assurent avoir adapté les couches du réseau de neurones sous-jacent et les opérations effectuées par Mu afin de s’adapter à l’architecture particulière des NPU. Ainsi, le modèle dispose de 32 couches dédiées à l’encodage et 12 au décodage. Les poids associés aux embeddings en entrée et en sortie sont partagés : un seul jeu de paramètres est utilisé pour représenter un élément textuel présenté par l’utilisateur et généré par le modèle. « Cela permet non seulement d’économiser de la mémoire (ce qui est important pour les NPU à mémoire limitée), mais aussi d’améliorer la cohérence entre les vocabulaires d’encodage et de décodage », commentent les chercheurs de Microsoft. Tout comme le runtime de Mu ne peut qu’exécuter les opérations optimisées pour le NPU.

Microsoft s’est également appuyé sur des techniques d’optimisation répandues chez les fournisseurs de LLM : couche de normalisation duale (Dual LayerNorm), mécanisme de rotation de position des embeddings (RoPe), et mécanisme d’attention à requêtes groupées (GQA).

La phase d’entraînement divisée en trois étapes (préparation, stabilisation, décroissance) est également de la partie. Pour le reste, les chercheurs ont repris des techniques expérimentées lors du pré-entraînement des modèles Phi. Des « centaines de milliards de tokens » issus de contenus de « haute qualité » ont été utilisés (par exemple des livres de grammaire, de conjugaison, d’Histoire, etc.) dans une première étape. Ensuite, les chercheurs ont « distillé » des connaissances en provenance de Phi, en lui faisant générer du contenu lié à différentes tâches. En clair, des données synthétiques générées par ce LLM.

Mu a été entraîné sur un cluster de GPU Nvidia A100, sans que Microsoft en révèle le nombre. Le modèle a d’abord été entraîné avec une précision d’encodage FP16, puis convertit après l’entraînement en entier (Int) 8 et 16 bits. D’autres phases de quantization (compression) ont été menées avec Intel, AMD et Qualcomm pour s’adapter aux NPU cibles. « Les étapes d’optimisation se traduisent par des inférences très efficaces sur les périphériques, produisant des sorties à plus de 200 tokens/seconde sur un Surface Laptop 7 ».

Microsoft le reconnaît : s’il est rapide, en tant que modèle de base, Mu est loin d’être le plus performant, surtout en comparaison des LLM de 7 à 14 milliards de paramètres. « Mais le couplage avec des données spécifiques à une tâche, ainsi qu’une mise au point supplémentaire par le biais de méthodes d’adaptation de rang faible (LoRA), peuvent améliorer considérablement les performances du modèle », notent les chercheurs.

À ce jeu du fine-tuning léger, Mu égalerait les résultats de Phi 3,5 mini quand il est affiné dans les mêmes conditions.

Un agent infiltré dans la barre de recherche des paramètres de Windows 11

Mais Mu est-il réellement utile ? Microsoft répond que oui. Le modèle a été utilisé pour concevoir un agent IA pour manipuler les paramètres de Windows 11 à partir d’une demande en langage naturel. L’objectif est de le rendre disponible à travers les barres de recherche infusée dans l’OS. L’éditeur avait déjà testé ce cas d’usage avec Phi LoRA, avec des résultats concluants, « mais le modèle était trop gros pour répondre à nos exigences de latence ».

Sans fine-tuning, Mu serait deux fois moins précis que Phi LoRA. Après avoir ingurgité 3,6 millions d’échantillons liés à une centaine de configurations, les paramètres les plus utilisés, des données synthétiques, le voilà paré pour traiter les demandes des utilisateurs.

« Nous avons observé que le modèle était plus performant pour les requêtes de plusieurs mots qui transmettaient une intention claire, par opposition aux entrées de mots courts ou partiels, qui manquent souvent d’un contexte suffisant pour une interprétation précise », expliquent les chercheurs. En clair, comme beaucoup de LLM, il est plus difficile pour un utilisateur habitué aux requêtes par mot-clé d’obtenir une réponse pertinente. D’où l’infusion dans la barre de recherche qui permet d’obtenir des résultats sans doute moins précis, mais des résultats tout de même.

Pour la suite, Microsoft attend les retours des membres du programme insiders. La firme n’a pas précisé si elle commercialisera Mu pour les entreprises qui souhaiteraient le spécialiser.

Pour approfondir sur IA appliquée, GenAI, IA infusée

-

![]()

Fara-7B : Microsoft explore l’IA agentique pour manipuler les interfaces PC

-

![]()

Granite 4.0 : IBM veut écraser la concurrence sur le terrain de l’inférence

-

![]()

Qwen3-Omni : Alibaba mise sur une approche « tout-en-un » de la GenAI

-

![]()

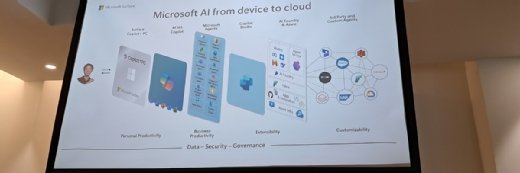

« From Chip to Cloud » et vice-versa : la stratégie de Microsoft en matière d’IA locale