Notre maison brûle, mais en 2025 les hyperscalers ont surtout regardé ailleurs

Doubles discours, opacité, refus de collaborer avec des organisations, course à la démesure. Malgré leurs postures « Green », les géants de l’IT semblent faire fi de la transition écologique, regrette le Shift Project. Alors même que la part des data centers dans la consommation énergétique explose de manière préoccupante avec l’IA, avertit le think tank indépendant.

Dans l’IT, il y a les discours, les engagements sur le « net zero » et sur la décarbonation. Et il y a la réalité. Un peu moins verte, selon le Shift Project.

« La rareté énergétique est perçue par le secteur numérique comme une contrainte à contourner, plutôt que comme une incitation à la modération de l’offre », constate le think tank apartisan de Jean-Marc Jancovici dans un rapport sur les data centers. « [Le secteur] renvoie aux systèmes énergétiques la responsabilité d’une transition vers la décarbonation ».

Pourtant, « à l’horizon 2030, la trajectoire dans laquelle se projette la filière “centres de données” est insoutenable », insiste le document d’une centaine de pages qui aura marqué l’année 2025.

Des serveurs qui consomment trois fois plus que la France entière

Le rapport pose d’abord le cadre général. Les serveurs des géants de l’IT tournent partout dans le monde. Or sur la planète, « l’énergie reste majoritairement produite par du gaz et du charbon », resitue Jean-Marc Jancovici.

D’après les estimations de son think tank, la consommation actuelle des centres de données sur la planète avoisinerait la consommation d’électricité de la France. Problème, « elle augmente de +13 % par an, et les GES associés de +9 % par an » chiffre-t-il.

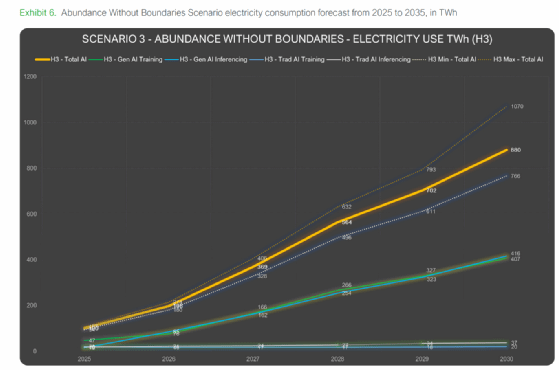

L’IA, le cloud (pro et grand public), la VOD, les réseaux sociaux, mais aussi les cryptomonnaies, expliquent cette explosion qui, sur cette tendance, amènerait à un triplement de la consommation des datacenters en 5 ans.

« Cette trajectoire n’est pas compatible avec la décarbonation puisque les émissions devraient, au contraire, baisser de 5 % par an pour limiter le réchauffement à 2 C », compare Jean-Marc Jancovici.

À l’horizon 2030, la consommation électrique mondiale des data centers pourrait ainsi atteindre 1500 TWh/an. À titre de comparaison, la France consomme aujourd’hui 450 TWh/an (chiffre EDF/RTE).

Quant aux GES, les centres de données pourraient émettre d’ici 5 ans 920 MtCO2e/an, soit deux fois les émissions annuelles de la France.

La course à la démesure

Pourtant, en 2025, les géants de l’IT se sont lancés dans une course à la démesure.

Un exemple est l’achat d’une quantité astronomique de GPU AMD par OpenAI. Pour faire tourner ces processeurs, il faudra au créateur de ChatGPT une puissance de 6 GW. Soit l’équivalent de 10 % de la production nucléaire française. Pour un seul datacenter.

Et ce n’est pas le plus gros projet. À plein régime, Stargate (OpenAI, Oracle et Softbank), voulu par Donal Trump, consommera à lui seul 10 GW.

Ces géants font-ils fi de leurs consommations énergétiques et « regardent-ils ailleurs, alors que notre maison brûle » – pour paraphraser la célèbre citation de Jacques Chirac ?

Les conclusions du Shift Project le laissent penser. Les géants, eux, s’en défendent. Ils mettent en avant leurs efforts pour optimiser la performance de leurs produits. Et c’est vrai.

« Il y a très peu de secteurs qui peuvent dire qu’ils ont fait autant de gain d’efficacité que le numérique », concède Marlène De Bank, ingénieure de recherche numérique au Shift Project et co-autrice du rapport. « Des gains, il y en a eu partout, du hardware au software, en passant par l’architecture des datacenters ».

De fait, les PUE des centres de données sont toujours plus proches de 1. OpenAI revendique d’avoir diminué par un facteur de plus de 40 la consommation énergétique de ses modèles.

Mais… Mais il y aurait beaucoup de « mais » pour les porte-parole du Shift Project.

Rebond des usages et opacité des chiffres

Mais… « le problème, c’est que [ces gains d’efficacité] ne compensent pas l’explosion de l’offre créée en parallèle », constate Marlène De Bank. Son rapport note que l’IA est de plus en plus intégrée par les éditeurs dans leurs applications, de gré ou de force. Elle créerait aujourd’hui un « rebond induit » des usages qui effacent ces optimisations.

Mais… ces géants ne joueraient pas la carte de la transparence et entretiendraient un flou sur leurs chiffres. « Ce serait bien d’avoir plus d’informations pour arbitrer », appelle de ses vœux Jean-Marc Jancovici.

« Malheureusement les services [clouds américains] ne nous informent pas. Ce serait bien d’avoir un peu de transparence environnementale », renchérit Marlène De Bank. « Que l’on sache par exemple dans quel data center le modèle a tourné avec quelle quantité d’émission. Ce sont des informations que l’on n’a pas ».

Quand un citoyen utilise sa voiture, il sait combien d’essence elle consomme et donc l’empreinte carbone de son trajet. L’experte appelle à ce qu’il en soit de même pour l’IA.

Même dans l’écosystème, des voix s’élèvent pour demander cette transparence. « Pour faire notre bilan carbone, nous sommes contraints de prendre les chiffres que [notre partenaire cloud] nous donne sur les consommations de nos calculs. Quand on les interroge pour comprendre ce chiffre, nous n’avons pas plus d’infos », regrette Laurent Felix, General Manager France d’Ekimetrics, société spécialisée dans les projets d’IA à grande échelle.

Pourtant, des méthodologies communes sont proposées pour lever les suspicions. « Mais pour l’instant, ils ne veulent pas trop jouer le jeu », cingle Marlène De Bank.

Un Shifter chez AWS

Contactés par LeMagIT, les hyperscalers ont réagi très différemment.

AWS assure qu’il partage « de manière transparente [ses] données d’émissions – y compris des scopes 1, 2 et 3 » au travers d’un outil qui a, par ailleurs, été récemment mis à jour justement pour fournir des informations plus granulaires. « Ces données exhaustives sont vérifiées par une tierce partie », ajoute le numéro 1 du cloud.

AWS possède également un référent en France sur les questions de durabilité, Philippe Desmaison… Qui est un « Shifter » (bénévole du Shift Project).

Google France possède un poste similaire occupé par Vincent Poncet, qui s’exprimait début décembre au Green IO. Bien que visiblement impliquée dans cette problématique, la filiale semble gênée aux entournures et n’a pas souhaité commenter sa manière de partager ses chiffres ni « préciser son organisation interne » (sic).

Quant à Microsoft France, il n’a pas tout simplement pas souhaité répondre pour Azure.

Langage « green » devant, « charbon » derrière

Mais… les investissements promis par les géants IT dans la production d’énergie verte seraient à prendre avec recul. Petits réacteurs nucléaires modulaires, géothermie, fusion nucléaire : « il n’y aura rien avant 2030 », anticipe Marlène De Bank. D’ici là, pour elle, l’énergie supplémentaire consommée sera nécessairement fossile.

« Deux centrales à charbons aux États-Unis devaient être fermées et ne l’ont pas été. L’Agence Internationale de l’Énergie indique que la production de turbines à gaz pour les datacenters monte en flèche. On voit aussi des extensions de pipelines gaziers », liste l’experte. « On recrée une dépendance aux énergies fossiles. On crée même spécifiquement des infrastructures pour cela. Il y a donc beaucoup de chances que ces infrastructures restent après 2030 ». Et que les promesses des géants de l’IT pour une décarbonation, dans un second temps, après 2030, ne soient pas non plus tenues.

Ces faits semblent en tout cas montrer un double discours. Le courrier de l’administration Trump, envoyé à Bruxelles, pour demander d’exempter les entreprises américaines – dont celles du numérique – de mesurer l’impact environnemental de leur supply chain, avec la menace de remettre à plat l’accord sur les droits de douane, semble, là encore, donner raison au Shift Project.

Mais… enfin, et quand bien même cette électricité serait verte, « nous aurons besoin de cette énergie pour décarboner d’autres domaines, comme le transport, le logement, l’industrie », souligne Jean-Marc Jancovici qui rappelle que les capacités de production ne sont pas infinies. « C’est dommage d’affecter cette énergie décarbonée à des usages moins essentiels ».

Il y aurait cependant des raisons d’espérer. L’écosystème français se montrerait plus enclin à collaborer avec des organismes comme le Shift Projet. « Les signes sont plutôt bons », vante Marlène De Bank.

Des pistes pour inverser la tendance existent également. Au niveau macroéconomique : attribuer des quotas de CO2 aux centres de données pour inciter à la réduction de la consommation énergétique, mais aussi de l’empreinte carbone de la fabrication des équipements IT (proposition du Shift Project).

Et au niveau technologique, utiliser des IA plus spécialisées et des modèles plus petits, avec une plus grande frugalité des usages.

De ChatGPT à Chat Perché

L’IA, justement. Elle représenterait aujourd’hui 15 % de la consommation énergétique des data centers. En 2030, ce sera minimum 35 %, selon les ingénieurs du think tank.

Les clients de ces géants auraient bien conscience du problème, même si la situation est ambivalente. D’une part, les décideurs ont tendance à tous vouloir leur « GPT interne ». D’autre part, 75 % d’entre eux disent que la durabilité est au cœur de leurs stratégies (dixit un rapport de Capgemini).

« Nous avons vu beaucoup de professionnels se poser des questions sur leur empreinte à différents niveaux (parc de voitures à moteur thermique, etc.). Mais dès que c’est l’IA, c’est comme si cela ne rentrait plus dans leur bilan carbone », constate Marlène De Bank. L’experte a donné un nom à ce paradoxe : le « Chat Perché ».

Or une estimation prospective de Schneider Electrics montre que l’inférence représenterait (au moins) 50 % de l’empreinte d’un LLM. D’autres avancent un ratio de 80/20 (inférence/entraînement). Réduire l’empreinte de cette inférence ne pourrait donc pas être négligé.

Le rôle des DSI

Cela tombe bien. Des recettes existent. Comme se poser la question du « pourquoi faire » – sans induire qu’il faut forcément utiliser l’IA – en partant d’un questionnement métier et de transformation stratégique, recommande Laurent Felix d’Ekimetrics.

Quant aux responsables IT, ils pourraient utiliser leurs positions lors des déploiements pour orienter les choix vers les options technologiques les plus vertueuses.

« Ils ont un pouvoir énorme », vante Marlène De Bank. « Si les DSI du CAC 40 mettaient un peu de pression sur ces acteurs (N.D.R. : les hyperscalers), peut-être qu’il se passerait quelque chose sur la transparence environnementale », espère-t-elle.