Scanrail - Fotolia

Pourquoi et comment installer un équipement AWS Outpost

Le service Outpost d’AWS permet d’installer sur site un matériel, qui reproduit localement certaines fonctions du cloud public et facilite les déploiements en cloud hybride.

De nombreuses entreprises sont tenues de conserver les données et les services entre leurs murs pour des raisons de conformité et de réglementation. Mais elles peuvent néanmoins bénéficier des fonctions disponibles depuis le cloud public AWS en créant un cloud hybride au moyen de l’équipement Outpost, inféodé au service Outposts d’AWS. Cet équipement déporte une partie des services en ligne d’AWS au sein d’une infrastructure hyperconvergée à installer dans le datacenter.

Le service Outposts sert à réduire la complexité globale requise pour maintenir et exploiter un cloud hybride. Sa mise en place n’est cependant pas aussi simple que la création d’un nouveau compte AWS. Plusieurs étapes doivent être franchies avant qu’un équipement Outpost ne soit opérationnel.

Dans cet article, nous décrirons le fonctionnement du service Outposts, quand l’utiliser, comment installer l’équipement et comment déployer les premières instances.

Qu’est-ce que le service Outposts d’AWS et comment fonctionne-t-il ?

AWS Outposts consiste à installer sur site un équipement géré par AWS. Cet équipement apporte à un centre de données local les services en ligne d’AWS, ses API et ses consoles d’administration.

En pratique, il permet à des développeurs de créer et déployer des applications sur les ressources de calcul et de stockage locales, mais en utilisant les mêmes outils et les mêmes consoles que ceux disponibles sur AWS. Le fait de tout exécuter en local permet de maintenir une latence la plus faible possible et de répondre aux exigences réglementaires en matière de localisation des traitements sur les données.

Les services d’AWS exécutables localement comprennent la base de données relationnelle RDS, le moteur d’exécution des containers ECS, ou encore le stockage en mode bloc EBS. AWS doit bientôt ajouter à Outposts le service de stockage objet S3, qui est utile pour l’hébergement d’applications web, l’analyse de données et l’archivage de médias. Le stockage objet étant nativement conçu pour fonctionner à cheval entre plusieurs machines physiques, il est possible d’avoir un accès local aux données depuis n’importe quel endroit sécurisé. Cependant, les données, bien que bénéficiant d’un accès local, seront vraisemblablement toujours stockées dans le cloud public.

Il est important de noter qu’un équipement Outpost n’est pas conçu pour des opérations déconnectées, ou qui s’exécutent depuis des sites sans connexion Internet. L’équipement Outpost doit être connecté à un réseau capable de fournir un accès WAN vers la région AWS choisie par l’entreprise et un accès LAN vers le réseau local où s’exécutent les applications susceptibles d’être conjuguées avec les services d’AWS.

Les entreprises qui disposent déjà d’une excellente connectivité depuis leur site de production IT ont tout intérêt à intégrer et à communiquer avec AWS via le service Direct Connect, ou via Amazon VPC. L’interface d’administration d’Outpost permet de créer des sous-réseaux, afin d’assurer une certaine étanchéité lorsque la machine Outpost locale se connecte aux ressources en cloud que l’entreprise aura par ailleurs déployées dans le cloud public AWS.

Cas d’utilisation possibles

L’existence même du service Outposts démontre que le cloud public ne répond pas à tous les besoins d’un SI. Les équipements Outposts conviendront aux entreprises qui souhaitent étendre leurs serveurs ou leurs capacités de stockage, avec des ressources de type AWS mais sur site. Voici quelques scénarios compatibles avec l’emploi d’un équipement Outpost :

- Exécuter localement des applications cloud qui ont besoin d’accéder de manière intensive aux données, afin de réduire le nombre de transmissions inutiles et coûteuses vers et depuis le cloud.

- Déployer localement des GPU pour le traitement graphique, le rendu vidéo et le déchiffrement audio.

- Exécuter toutes les applications cloud de traitement de données sur le réseau de collecte local des données, afin que ces applications puissent communiquer en temps réel avec des applications clientes et/ou avec des objets connectés.

- Réduire le laps de temps entre les équipements d’une usine et leurs fonctions de pilotage et/ou traitement en cloud, en exécutant ces dernières directement sur le site de production.

- Utiliser les services d’apprentissage et d’analyse d’AWS, afin que les systèmes de maintenance automatisés bénéficient pour leurs traitements d’une réactivité en temps réel et d’un stockage local des relevés critiques.

- Déporter sur chaque site un agent pour l’orchestration, le redimensionnement, l’administration et la mise à jour des fonctions télécoms.

Ajoutons qu’une variante VMware de Outposts devrait être disponible d’ici à la fin 2020. Elle sera compatible avec toutes les fonctions d’une infrastructure virtualisée par vSphere, dite Software-Defined Datacenter.

Les ressources apportées par le service Outposts

Avec Outposts, vous pouvez utiliser depuis votre site les API AWS et vous connecter directement à tous les outils et services disponibles depuis le cloud public AWS. Mais comme dit précédemment, seuls certains services s’exécuteront directement sur l’équipement Outpost. Voici quelques cas d’usage qui utilisent les ressources de l’équipement :

- Utiliser des nœuds Kubernetes EKS pour exécuter des charges de travail qui s’interfacent avec des applications et des données sur site afin d’obtenir des temps de réponse les plus courts possible.

- Créer des clusters EMR pour exécuter des applications qui manipulent des données locales sans sortir de la fiabilité du réseau interne.

- Administrer depuis le cloud, avec les consoles et outils habituels d’AWS RDS, des bases de données installées sur l’un de vos sites.

- Utilisez un proxy ou un conteneur App Mesh Envoy pour exécuter diverses charges de travail à faible latence, afin de gérer les centres de données et les applications sur site via une connexion réseau à faible latence.

Terminologie

Voici quelques termes que vous devez connaître avant d’administrer un équipement Outpost.

Outpost Site. Un environnement physique, géré par l’entreprise, où AWS déploiera et installera un équipement Outpost.

Outpost Configuration. Chaque machine Outpost a des caractéristiques uniques en termes de poids, de besoins de refroidissement et d’alimentation. Elles sont définies au cas par cas. La configuration comprend également des caractéristiques réseau, des capacités de calcul EC2 et du stockage EBS.

Outpost Equipment. L’ensemble du matériel sur site, comprenant commutateurs, serveurs, racks et câblage, qui établit l’accès aux services AWS Outpost.

Outpost Capacity. Les ressources de stockage et de calcul disponibles dans votre Outpost, accessibles et gérées à partir de la console du service Outposts.

Local Gateway. La passerelle de routage virtuelle qui communique entre votre réseau local et l’équipement Outpost.

Service Link. Le routage réseau utilisé pour communiquer entre l’équipement Outpost et la région AWS choisie.

Comment passer commande d’un équipement Outpost

Avant de passer commande pour un Outpost, assurez-vous que votre site répond aux exigences physiques détaillées nécessaires pour accueillir l’appareil. Elles sont toutes spécifiées sur le site web d’AWS. Vous devrez également passer par un plan d’accompagnement AWS (AWS Enterprise Support Plan). Une fois que vous avez coché toutes ces options, suivez les étapes suivantes pour commander, installer et lancer votre Outpost.

1/ Créer un compte Outpost

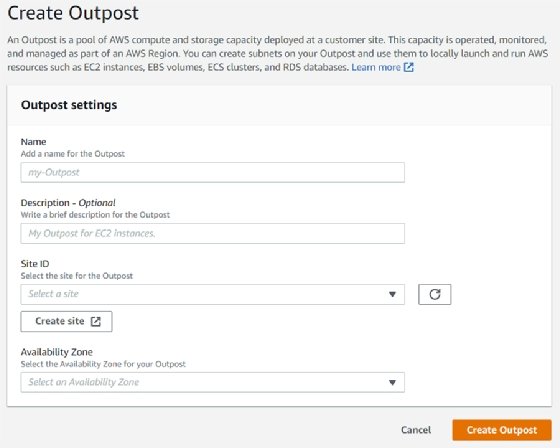

- Accédez à la console Outposts depuis l’adresse https://console.aws.amazon.com/outposts/. Puis, sélectionnez l’option Créer un Outpost.

- Saisissez un nom et une description pour la mise en place de l’Outpost.

- Sélectionnez l’option Créer un site. Remplissez le formulaire et soumettez-le. Ensuite, sélectionnez un site géographique et choisissez une zone de disponibilité, alias Availability Zone.

- Enfin, cliquez sur Créer un Outpost.

2/ Définir la capacité de l’Outpost

- Retournez à la console Outposts et trouvez l’option Catalogue Outposts dans le panneau de navigation.

- Choisissez la capacité adaptée à vos besoins, qui comprendra un mélange de volumes EBS, d’instances EC2 et de vitesses réseau. Si les configurations de capacité ne correspondent pas à votre projet, demandez une configuration personnalisée depuis l’option adéquate du panneau de navigation.

- Sélectionnez ensuite l’option Passer commande. Choisissez l’Outpost précédemment créé et cliquez à nouveau sur Passer commande sur la page suivante.

À ce stade, la commande a été soumise et vous pouvez accéder à son suivi via la console Outposts. Il devrait y être indiqué « commande reçue ». Un représentant d’AWS vous contactera sous trois jours et vous recevrez également un e-mail stipulant que la commande a été modifiée en « commande en cours de traitement ».

Pour compléter la commande, AWS vous fixera un rendez-vous afin que vous puissiez vous entretenir avec l’un de ses conseillers. Avant cet appel, AWS vous donnera une liste de points importants à vérifier pour l’installation. Une fois que toutes ces étapes seront franchies, des techniciens AWS viendront vous livrer l’équipement à la date prévue.

L’équipe AWS installera le rack à l’endroit que vous souhaitez. Votre électricien pourra alors brancher le courant au rack, puis l’équipe AWS établira la connexion au réseau que vous lui aurez fourni.

Ensuite, l’équipe AWS configurera la capacité du rack. Dès que vous aurez validé que la capacité EBS et la quantité d’instances EC2 sont disponibles via votre compte, l’installation sera terminée.

Lancez votre première instance

Maintenant que votre Outpost est installé, lancez vos premiers volumes EBS et instances EC2, en utilisant un sous-réseau Outpost.

1/ Création du sous-réseau

Dès lors que vous créez un sous-réseau Outpost pour le relier directement au réseau du cloud privé virtuel (VPC) que vous avez déployé dans la région AWS de votre choix, l’équipement Outpost sera géré par la console de votre VPC.

- Ouvrez votre console de gestion AWS.

- Trouvez l’option Outposts dans le panneau de navigation et sélectionnez l’Outpost installé.

- Choisissez Actions, puis cliquez sur Créer un sous-réseau.

- Sélectionnez votre VPC et déterminez une plage d’IP pour le sous-réseau.

- Sélectionnez Créer.

Le sous-réseau a été créé, et nous pouvons commencer à configurer le routage.

2/ Configuration du routage

Vous êtes tenu de relier un VPC existant à la table de routage de votre passerelle, de sorte qu’il y ait un lien établi entre le VPC et votre réseau local.

Lorsque vous créez le routage, vous avez la possibilité de sélectionner toutes les passerelles locales, passerelles internet, adresses IP et connexions de peering qui puissent être désignées comme destinations.

- Cliquez sur Tables de routage de la passerelle locale dans le panneau de navigation.

- Sélectionnez une table de routage et cliquez sur Actions et Associer un VPC.

- Choisissez le VPC dédié et cliquez sur Associer un VPC.

Le routage est maintenant configuré.

3/ Lancement de l’instance

Au sein du sous-réseau Outpost, le groupe de sécurité pour le contrôle du trafic entrant et sortant fonctionne exactement comme il le ferait pour une instance au sein d’un sous-réseau Availability Zone.

Afin de connecter l’instance EC2 dans le sous-réseau, il faut relier une paire de clés, comme vous le feriez au sein d’un sous-réseau Availability Zone.

Pour lancer l’instance, exécutez la commande run-instances dans le CLI d’AWS. À ce stade, vous pouvez dédier une adresse IP Elastic IP à partir d’un pool d’adresses IP vous appartenant et exécuter ces commandes :

describe-coip-pools ; pour recevoir des informations sur un pool d’IP appartenant à un client.

allocate-address ; afin de dédier l’adresse Elastic IP, avec l’option customer-owned-IPv4-pool pour indiquer le PoolID qui a été renvoyé dans la commande précédente.

associate-address ; pour lier l’adresse Elastic IP à l’instance Outpost.