Qu'est-ce que l'IA explicable ?

L'IA explicable (XAI) est une intelligence artificielle (IA) programmée pour décrire son objectif, sa logique et son processus décisionnel d'une manière compréhensible pour le grand public. La XAI aide les utilisateurs humains à comprendre le raisonnement qui sous-tend les algorithmes d'IA et d'apprentissage automatique (ML) afin de renforcer leur confiance.

L'IA explicable est souvent évoquée en relation avec les modèles d'apprentissage profond et joue un rôle important dans le modèle ML FAT (équité, responsabilité et transparence). La XAI est utile pour les organisations qui souhaitent adopter une approche responsable dans le développement et la mise en œuvre de modèles d'IA. La XAI aide les développeurs à comprendre le comportement d'un modèle d'IA, la manière dont une IA est parvenue à un résultat spécifique et les problèmes potentiels tels que les biais de l'IA.

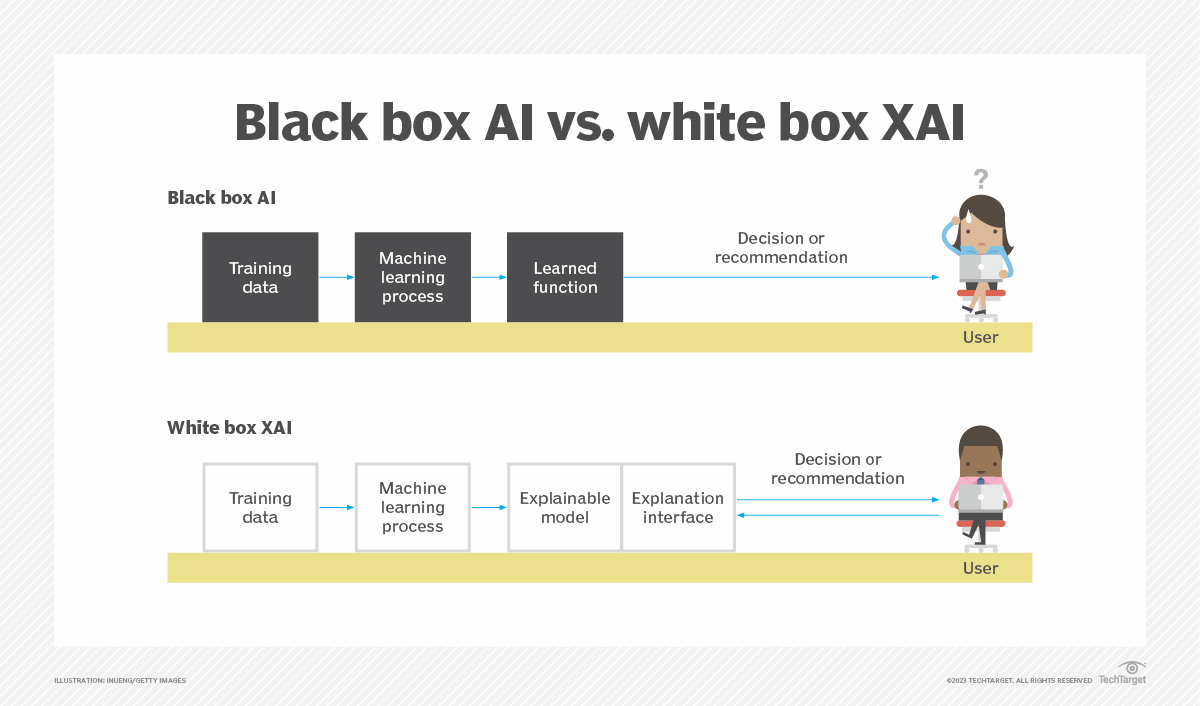

Les modèles ML sont généralement structurés sous forme de boîte blanche ou de boîte noire. Les modèles de boîte blanche offrent plus de visibilité et des résultats compréhensibles pour les utilisateurs et les développeurs. Les décisions des modèles de boîte noire, telles que celles prises par les réseaux neuronaux, sont difficiles à expliquer, même pour les développeurs d'IA.

L'intelligence artificielle explicable fournit des informations dans divers domaines sur la manière dont un programme d'IA prend ses décisions :

- Les forces et les faiblesses du programme.

- Les critères spécifiques utilisés par le programme pour prendre une décision.

- Pourquoi un programme fait une prédiction ou prend une décision particulière plutôt qu'une autre.

- Le niveau de confiance approprié pour différents types de décisions ou de prévisions.

- Les types d'erreurs que le programme est susceptible de commettre.

- Comment corriger les erreurs.

L'importance d'une IA explicable

L'un des objectifs importants de la XAI est d'assurer la responsabilité algorithmique. Les systèmes d'IA étaient autrefois principalement des boîtes noires. Même si les entrées et les sorties étaient connues, les algorithmes d'IA utilisés pour prendre des décisions étaient souvent propriétaires ou difficiles à comprendre.

L'intelligence artificielle étant utilisée dans des secteurs tels que la santé et les services financiers, il est important de s'assurer que les décisions prises par ces systèmes sont judicieuses et fiables. Elles doivent être exemptes de tout préjugé qui pourrait, par exemple, priver une personne d'un prêt hypothécaire pour des raisons sans rapport avec ses qualifications financières.

Dans le domaine des soins de santé, un système basé sur l'IA et formé à partir d'un ensemble de données limité pourrait ne pas détecter certaines maladies chez des patients de races, de sexes ou de régions géographiques différents. Il est nécessaire de comprendre comment le système d'IA prend ses décisions afin de faciliter le suivi, la détection et la gestion de ces problèmes.

À mesure que l'IA se généralise, il est plus important que jamais de divulguer comment les questions de partialité et de confiance sont traitées.

Comment fonctionne l'IA explicable ?

L'IA explicable repose sur certaines approches fondamentales en matière de conception et de déploiement de systèmes d'IA :

- Supervision. Un comité de gouvernance de l'IA peut être créé afin de définir des normes en matière d'explicabilité de l'IA et de guider les équipes de développement dans la création de modèles d'IA. En agissant ainsi dès le départ, l'explicabilité devient l'un des principes clés des directives de l'organisation en matière d'IA responsable.

- Données. Les données utilisées pour l'entraînement sont également importantes pour créer un modèle d'IA explicable. Lors de la conception d'un modèle d'IA, les développeurs doivent porter une attention particulière aux données d'entraînement afin de s'assurer qu'elles ne présentent aucun biais. Si les données sont biaisées, les développeurs doivent chercher des moyens d'atténuer ce biais. De plus, toutes les données non pertinentes doivent être exclues de l'entraînement.

- Sortie. Certains systèmes d'IA sont conçus pour expliquer d'où proviennent les informations pour chaque sortie.

- Algorithmes. Il est important de concevoir un modèle qui utilise des algorithmes explicables et produit des prédictions explicables. Un algorithme explicable a une conception en couches, de sorte que la manière dont il parvient à son résultat est claire. De même, faire une prédiction explicable signifie que les prédictions du modèle sont clairement définies.

Techniques d'IA explicables

Diverses techniques sont utilisées pour expliquer comment les modèles d'apprentissage automatique explicables utilisent les données d'entrée pour produire des résultats :

- Arbres de décision. Un arbre de décision représente le processus décisionnel d'un modèle à l'aide d'une structure arborescente dans laquelle les entrées conduisent à différentes sorties représentées par des branches.

- Importance des caractéristiques. Cette technique identifie les caractéristiques les plus influentes qui affectent le résultat d'un modèle.

- Explications contrefactuelles. Cette technique crée une liste de scénarios hypothétiques qui montrent comment de petits changements apportés aux caractéristiques d'un modèle peuvent entraîner des résultats différents.

- Explications additives de Shapley. Cette technique, également connue sous le nom de SHAP, observe comment toutes les caractéristiques du modèle influencent collectivement son résultat.

- Explications locales interprétables indépendantes du modèle. LIME modifie les entrées d'un modèle, puis observe les sorties résultant de chaque modification.

- Graphiques de dépendance partielle. Cette technique permet de représenter graphiquement les différents résultats d'un modèle en fonction de variations progressives des données d'entrée.

- Outils de visualisation. Les outils d'analyse et de visualisation des données expliquent comment les modèles parviennent à leurs prédictions à l'aide de graphiques et d'indicateurs.

Exemples d'IA explicable

On trouve des cas d'utilisation concrets de l'XAI dans divers secteurs.

Soins de santé

Les systèmes d'IA explicables aident les médecins à établir leurs diagnostics en leur fournissant des informations sur la manière dont le système parvient à un diagnostic. Par exemple, l'IA est utilisée pour identifier les fractures des patients sur des radiographies. Mais même après un investissement initial dans un outil d'IA, les médecins et les infirmières peuvent encore ne pas lui faire entièrement confiance. Un système explicable permet aux professionnels de santé d'examiner le diagnostic et d'utiliser ces informations pour établir leur pronostic.

Financier

Le XAI est utilisé pour évaluer la solvabilité financière des demandeurs de prêts ou de prêts hypothécaires et pour détecter les fraudes financières.

Militaire

Les systèmes basés sur l'IA explicable renforcent la confiance entre le personnel militaire et les systèmes qu'il utilise au combat et dans d'autres applications. L'Agence pour les projets de recherche avancée de défense (DARPA) développe actuellement l'IA explicable dans le cadre de sa troisième vague de systèmes d'IA.

Véhicules autonomes

La XAI dans les véhicules autonomes explique les décisions liées à la conduite, en particulier celles qui concernent la sécurité. Si un conducteur peut comprendre comment et pourquoi le véhicule prend ses décisions, il comprendra mieux les scénarios qu'il peut ou ne peut pas gérer.

Comment l'IA explicable améliore-t-elle la prise de décision et la confiance ?

Les modèles traditionnels d'IA de type « boîte noire » ont un fonctionnement interne complexe que de nombreux utilisateurs ne comprennent pas. Cependant, lorsque les processus décisionnels d'un modèle ne sont pas clairs, la confiance dans ce modèle peut être remise en question. Un modèle d'IA explicable vise à résoudre ce problème en décrivant les étapes de sa prise de décision et en fournissant des preuves à l'appui des résultats du modèle. Un modèle véritablement explicable offre des explications compréhensibles pour un public moins technique.

L'IA explicable permet de gagner la confiance non seulement des utilisateurs d'un modèle, qui peuvent se montrer sceptiques à l'égard de ses développeurs en cas de manque de transparence, mais aussi des parties prenantes et des organismes de réglementation. L'explicabilité permet aux développeurs de communiquer directement avec les parties prenantes afin de leur montrer qu'ils prennent la gouvernance de l'IA au sérieux. La conformité aux réglementations est également de plus en plus importante dans le développement de l'IA. Prouver cette conformité permet donc de garantir au public qu'un modèle n'est ni peu fiable ni biaisé.

Avantages de l'IA explicable

La XAI offre davantage de responsabilité et de transparence dans les systèmes d'IA. Ses avantages sont les suivants :

- Renforce la confiance. Les individus peuvent être réticents à faire confiance à un système basé sur l'IA s'ils ne comprennent pas comment il parvient à une conclusion. La XAI est conçue pour fournir aux utilisateurs finaux des explications compréhensibles sur ses décisions.

- Améliore le système dans son ensemble. Grâce à une transparence accrue, les développeurs peuvent plus facilement identifier et résoudre les problèmes.

- Identifie les cyberattaques. Les attaques ML adversaires tentent de tromper ou d'induire en erreur un modèle afin qu'il prenne des décisions incorrectes à l'aide de données malveillantes. Une attaque adverse contre un système XAI révélerait l'attaque en fournissant des explications inhabituelles ou étranges pour ses décisions.

- Protection contre les biais. L'XAI vise à expliquer les attributs et les processus décisionnels des algorithmes d'apprentissage automatique. Cela permet d'identifier les biais susceptibles d'entraîner des résultats sous-optimaux liés à la qualité des données d'entraînement ou aux préjugés des développeurs.

Limites de l'IA explicable

Malgré ses avantages, le XAI présente également les limites suivantes :

- Simplification excessive. Un système XAI peut simplifier à l'excès et déformer des modèles complexes par rapport à d'autres méthodes de transparence. Une meilleure approche pourrait consister à concevoir des systèmes d'IA avec des modèles plus interprétables ou capables d'associer plus précisément les causes et les effets.

- Performances inférieures des modèles. Les systèmes XAI ont généralement des performances inférieures à celles des modèles de type « boîte noire ».

- Problèmes liés à la formation. Créer un système d'IA qui explique son raisonnement est plus compliqué que les modèles de boîte noire.

- Manque de confidentialité. Si un système XAI traite des données confidentielles, l'approche transparente de CAI pourrait exposer ces données.

- Méfiance. Bien que la XAI devrait renforcer la confiance dans l'IA, certains utilisateurs pourraient encore se méfier d'un système, même si les décisions qu'il prend sont accompagnées d'explications compréhensibles.

IA explicable vs IA générative

L'IA explicable et l'IA générative sont deux sous-ensembles distincts de l'IA. L'IA générative englobe une liste croissante d'outils qui génèrent de nouveaux contenus, notamment textuels, audio et visuels. Dall-E, ChatGPT et Google Gemini sont des exemples d'outils d'IA générative.

L'IA explicable est un principe général qui régit le développement et l'utilisation des systèmes d'IA. Il ne s'agit pas d'une liste concrète d'outils, mais d'un concept qui couvre différents types de systèmes d'IA. Par exemple, les modèles de prédiction explicables utilisés dans les prévisions météorologiques ou financières produisent des informations à partir de données historiques, et non à partir de contenus originaux. Lorsqu'elles sont correctement conçues, les méthodologies prédictives sont clairement expliquées et les processus décisionnels qui les sous-tendent sont transparents.

Les concepts d'IA explicable peuvent être appliqués à l'IA générative, mais ils ne sont pas souvent utilisés avec ces systèmes. Les outils d'IA générative manquent souvent de transparence dans leur fonctionnement interne, et les utilisateurs ne comprennent généralement pas comment les nouveaux contenus sont produits. Par exemple, GPT-4 comporte de nombreuses couches cachées qui ne sont ni transparentes ni compréhensibles pour la plupart des utilisateurs. Si tout type de système d'IA peut être explicable lorsqu'il est conçu comme tel, ce n'est souvent pas le cas de l'IA générative.

L'histoire de l'IA explicable

Les systèmes d'IA explicables sont plus que jamais nécessaires en raison de leurs effets potentiels sur les personnes. L'explicabilité de l'IA est un aspect important de la création d'un système d'IA depuis au moins les années 1970. En 1972, le système de raisonnement symbolique MYCIN a été développé pour expliquer le raisonnement à des fins de diagnostics, tels que le traitement des infections sanguines.

Tout au long des années 1980 et 1990, des systèmes de maintenance de la vérité (TMS) ont été développés afin d'étendre les capacités de raisonnement de l'IA. Par exemple, les TMS ont été utilisés dans des systèmes d'inférence basés sur des règles et la logique. Un TMS suit le raisonnement et les conclusions de l'IA en retraçant son raisonnement à travers des opérations de règles et des inférences logiques. Ce processus génère une explication pour chaque raisonnement de l'IA.

À partir des années 2010, les systèmes d'IA explicables sont devenus plus visibles pour le grand public. Certains systèmes d'IA ont commencé à présenter des biais raciaux et autres, ce qui a conduit à mettre davantage l'accent sur le développement de systèmes d'IA plus transparents et de moyens de détecter les biais dans l'IA.

IA explicable vs IA interprétable

L'explicabilité et l'interprétabilité sont deux concepts de l'IA qui sont utilisés de manière interchangeable. Cependant, ils ont des significations différentes.

L'IA explicable est la capacité à expliquer le processus décisionnel de l'IA à l'utilisateur de manière compréhensible. L'IA interprétable fait référence à la prévisibilité des résultats d'un modèle en fonction de ses entrées. L'interprétabilité est utilisée pour comprendre le fonctionnement interne d'un modèle d'IA. L'interprétabilité est importante si une organisation a besoin d'un modèle offrant un niveau élevé de transparence et doit comprendre exactement comment le modèle génère ses résultats. Cependant, cela peut ralentir les performances.

IA explicable vs IA responsable

L'IA explicable et l'IA responsable sont deux concepts importants dans la conception d'un système d'IA transparent et fiable. L'IA responsable aborde le développement et le déploiement de l'IA d'un point de vue éthique et juridique. Son objectif est d'utiliser l'IA de manière sûre, honnête et éthique. L'interprétabilité et l'explicabilité de l'IA sont deux aspects importants du développement d'une IA responsable.

Les principes qui constituent une IA responsable comprennent les suivants :

- Responsabilité et transparence.

- Expliquabilité et interprétabilité.

- Équité.

- Confidentialité.

- Sécurité et résilience.

- Validité et fiabilité.

- Sécurité.

La transparence et l'explicabilité restent des concepts importants dans les technologies d'IA. Découvrez pourquoi la transparence dans l'IA est importante.