Qu'est-ce que l'IA responsable ?

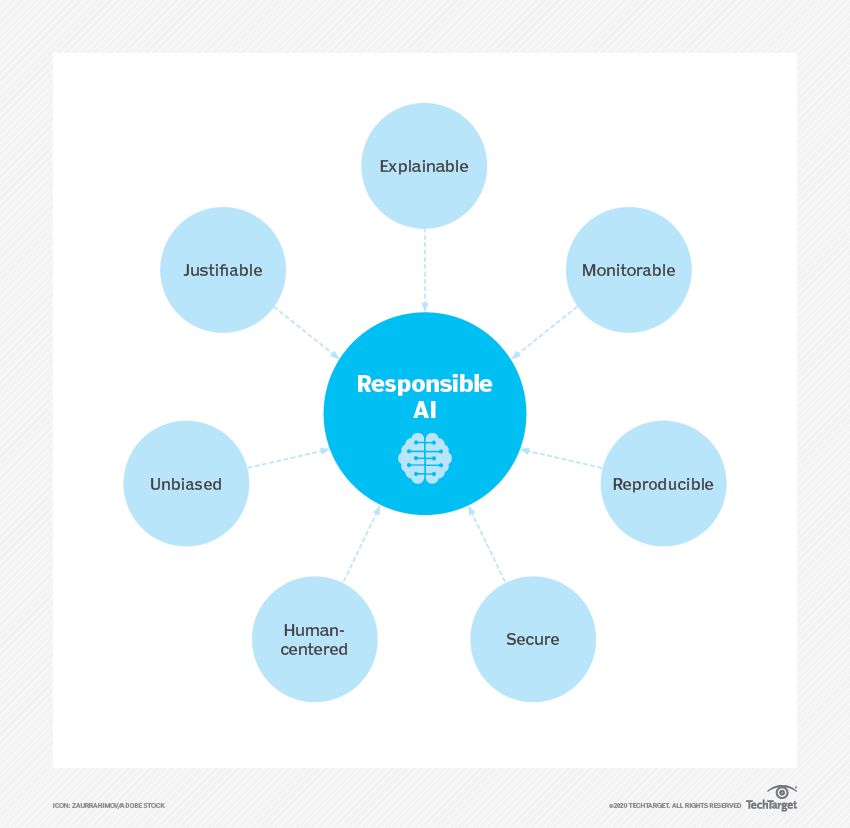

L'IA responsable est une approche du développement et du déploiement de l'intelligence artificielle (IA) d'un point de vue éthique et juridique. L'objectif de l'IA responsable est d'utiliser l'IA de manière sûre, fiable et éthique. L'utilisation responsable de l'IA devrait accroître la transparence et l'équité, et réduire les problèmes tels que les biais de l'IA.

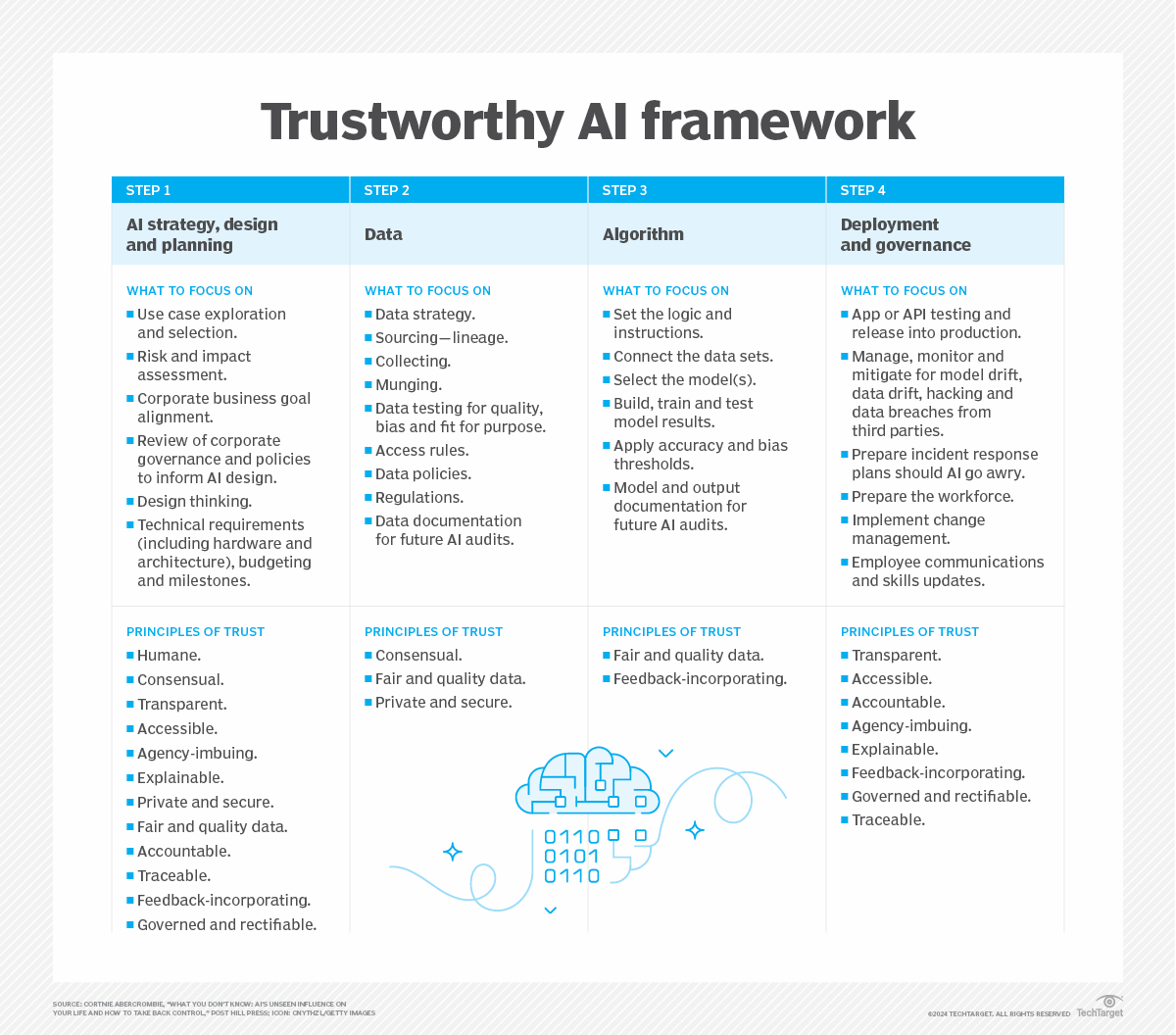

Les partisans d'une intelligence artificielle responsable estiment qu'un cadre de gouvernance des meilleures pratiques en matière d'IA largement adopté permet aux organisations de s'assurer plus facilement que leur programmation d'IA est centrée sur l'humain, interprétable et explicable. Toutefois, la garantie d'une IA digne de confiance incombe aux scientifiques des données et aux développeurs de logiciels qui écrivent et déploient les modèles d'IA d'une organisation. Cela signifie que les mesures requises pour prévenir la discrimination et garantir la transparence varient d'une entreprise à l'autre.

La mise en œuvre diffère également d'une entreprise à l'autre. Par exemple, le responsable de l'analyse ou d'autres responsables et équipes dédiés à l'IA peuvent être chargés d'élaborer, de mettre en œuvre et de contrôler le cadre d'IA responsable de l'organisation. Les organisations devraient publier sur leur site web une explication de leur cadre en matière d'IA qui documente sa responsabilité et garantit que l'utilisation de l'IA par l'organisation n'est pas discriminatoire.

Pourquoi l'IA responsable est-elle importante ?

L'IA responsable est un domaine émergent de la gouvernance de l'IA. L'utilisation du mot "responsable" est un terme générique qui couvre à la fois l'éthique et la démocratisation de l'IA.

Souvent, les ensembles de données utilisés pour former les modèles d'apprentissage machine (ML) utilisés dans l'IA introduisent des biais. Les biais s'introduisent dans ces modèles de deux manières : par des données incomplètes ou erronées, ou par les préjugés de ceux qui entraînent le modèle d'apprentissage automatique. Lorsqu'un programme d'IA est biaisé, il peut finir par affecter négativement ou blesser les humains. Par exemple, il peut refuser injustement des demandes de prêts financiers ou, dans le domaine de la santé, diagnostiquer un patient de manière inexacte.

Alors que les logiciels dotés de fonctions d'intelligence artificielle se multiplient, il est évident qu'il est nécessaire d'établir des normes d'intelligence artificielle allant au-delà des trois lois de la robotique établies par l'écrivain de science-fiction Isaac Asimov.

La mise en œuvre d'une IA responsable peut contribuer à réduire les préjugés, à créer des systèmes d'IA plus transparents et à accroître la confiance des utilisateurs dans ces systèmes.

Quels sont les principes d'une IA responsable ?

Les modèles d'IA et d'apprentissage automatique doivent respecter une liste de principes qui peuvent différer d'une organisation à l'autre.

Par exemple, Microsoft et Google suivent tous deux leur propre liste de principes. En outre, le National Institute of Standards and Technology (NIST) a publié une version 1.0 de son cadre de gestion des risques liés à l'intelligence artificielle, qui reprend bon nombre des principes énoncés dans les listes de Microsoft et de Google. Les sept principes du NIST sont les suivants :

- Valides et fiables. Les systèmes d'IA responsables doivent être capables de maintenir leurs performances sans défaillance dans des circonstances différentes et inattendues.

- Sûre. L'IA responsable doit assurer la sécurité des personnes, des biens et de l'environnement.

- Sécurité et résilience. Les systèmes d'IA responsables doivent être sûrs et résilients face aux menaces potentielles, telles que les attaques adverses. Les systèmes d'IA responsables doivent être conçus pour éviter les attaques, s'en protéger et y répondre, tout en étant capables de s'en remettre.

- Responsabilité et transparence. Une transparence accrue vise à renforcer la confiance dans le système d'IA, tout en facilitant la résolution des problèmes liés aux résultats des modèles d'IA. Ce principe exige que les développeurs assument la responsabilité de leurs systèmes d'IA.

- Explicable et interprétable. L'explicabilité et l'interprétabilité sont censées fournir des informations détaillées sur la fonctionnalité et la fiabilité d'un système d'IA. Par exemple, l'IA explicable explique aux utilisateurs pourquoi et comment le système est parvenu à ses résultats.

- Le respect de la vie privée. Le principe de protection de la vie privée impose des pratiques qui préservent l'autonomie, l'identité et la dignité de l'utilisateur final. Les systèmes d'IA responsables doivent être développés et déployés en respectant des valeurs telles que l'anonymat, la confidentialité et le contrôle.

- Équitable avec gestion des préjugés nuisibles. L'équité se concentre sur l'élimination des préjugés et des discriminations liés à l'intelligence artificielle. Elle tente de garantir l'égalité et l'équité, une tâche difficile car ces valeurs diffèrent d'une organisation à l'autre et d'une culture à l'autre.

Comment concevoir une IA responsable ?

Les modèles d'IA devraient être créés avec des objectifs concrets qui se concentrent sur la construction d'un modèle d'une manière sûre, digne de confiance et éthique. Un contrôle permanent est essentiel pour garantir qu'une organisation s'engage à fournir une technologie d'IA impartiale et digne de confiance. Pour ce faire, une organisation doit suivre un modèle de maturité lors de la conception et de la mise en œuvre d'un système d'IA.

À la base, l'IA responsable s'articule autour de normes de développement axées sur les principes de conception responsable. Ces normes de développement de l'IA à l'échelle de l'entreprise devraient inclure les mandats suivants :

- Dépôts de codes partagés.

- Architectures de modèles approuvées.

- Variables sanctionnées.

- Mise en place de méthodologies de tests de biais pour aider à déterminer la validité des tests pour les systèmes d'intelligence artificielle.

- Normes de stabilité pour les modèles actifs d'apprentissage automatique afin de garantir que la programmation de l'IA fonctionne comme prévu.

Mise en œuvre de l'IA responsable et son fonctionnement

Une organisation peut mettre en œuvre une IA responsable et démontrer qu'elle a créé un système d'IA responsable de la manière suivante :

- Utiliser des caractéristiques interprétables pour créer des données compréhensibles par tous.

- Documenter les processus de conception et de prise de décision de manière à ce qu'en cas d'erreur, il soit possible de procéder à une rétro-ingénierie pour déterminer ce qui s'est passé.

- Créez une culture professionnelle diversifiée et encouragez les discussions constructives afin d'atténuer les préjugés.

- Créer un processus de développement rigoureux qui valorise la visibilité des caractéristiques latentes de chaque application.

- Éliminer les méthodes de développement de modèles d'IA de type "boîte noire". Au lieu de cela, utilisez des méthodes d'IA à boîte blanche ou explicables qui fournissent une explication pour chaque décision prise par l'IA.

Quels sont les principaux défis à relever pour mettre en œuvre une IA responsable ?

Il n'est pas toujours facile de mettre en œuvre des politiques et des cadres d'IA responsables, car les principaux défis et préoccupations ralentissent souvent le processus. Ces défis sont notamment les suivants :

- Sécurité et protection de la vie privée. Les entreprises qui collectent des données pour l'entraînement des modèles d'IA peuvent avoir besoin de données confidentielles sur les individus. Les lignes directrices sur l'IA responsable visent à prendre en compte la confidentialité, la protection des données et la sécurité, mais il est souvent difficile de séparer les données sensibles des données publiques.

- Biais dans les données. Les données de formation doivent être correctement obtenues et examinées afin d'éviter les biais, mais ceux-ci sont souvent difficiles à détecter. Il n'existe pas d'approche parfaite ; l'élimination des biais dans les ensembles de données et les entrées nécessite du temps et des efforts.

- Conformité. Comme les lois et les réglementations continuent d'évoluer aux niveaux local, national et international, les entreprises doivent surveiller les nouvelles règles et s'assurer que leurs politiques en matière d'intelligence artificielle sont faciles à mettre à jour.

- Formation. Les chefs d'entreprise doivent savoir qui est impliqué dans la supervision des systèmes d'IA et s'assurer que ces personnes sont formées. Outre les équipes technologiques, les services juridiques, le marketing, les ressources humaines et d'autres départements et parties prenantes peuvent avoir besoin d'une formation.

Meilleures pratiques pour des principes d'IA responsables

Lors de la conception d'une IA responsable, les processus de développement et de déploiement doivent être systématiques et reproductibles. Parmi les meilleures pratiques, on peut citer les suivantes :

- Mettre en œuvre les meilleures pratiques en matière d'apprentissage automatique.

- Créer une culture de soutien diversifiée. Il s'agit notamment de créer des équipes diversifiées sur le plan du genre et de la race qui travaillent à l'élaboration de normes d'IA responsables. Permettre à cette culture de s'exprimer librement sur les concepts éthiques liés à l'IA et aux préjugés.

- Promouvoir la transparence pour créer un modèle d'IA explicable, de sorte que toutes les décisions prises soient visibles et faciles à corriger en cas de problème.

- Rendre le travail aussi mesurable que possible. Le traitement de la responsabilité est subjectif, il faut donc s'assurer que des processus mesurables sont en place, tels que la visibilité et l'explicabilité, et qu'il existe des cadres techniques et éthiques vérifiables.

- Utiliser des outils d'intelligence artificielle responsables pour inspecter les modèles.

- Identifier des paramètres pour la formation et le suivi afin de réduire au minimum les erreurs, les faux positifs et les préjugés.

- Documenter les meilleures pratiques et les comparer à un ou plusieurs cadres de gouvernance de l'IA existants. Une fois que ces approches sont jugées conformes aux principes des cadres existants, cette documentation peut servir de cadre de gouvernance de l'IA efficace pour une organisation.

- Effectuer des tests tels que les tests de partialité et la maintenance prédictive afin de produire des résultats vérifiables et d'accroître la confiance de l'utilisateur final.

- Contrôler après le déploiement. Cela permet de s'assurer que le modèle d'IA continue à fonctionner de manière responsable et impartiale.

- Restez attentif et tirez des enseignements du processus. Une organisation en découvre davantage sur l'IA responsable lors de la mise en œuvre, des pratiques d'équité aux références techniques et aux documents relatifs à l'éthique technique.

Meilleures pratiques pour une gouvernance responsable de l'IA

Du point de vue de la surveillance, les organisations devraient disposer d'une politique de gouvernance de l'IA réutilisable pour chaque système d'IA qu'elles développent ou mettent en œuvre. Les politiques de gouvernance pour une IA responsable devraient inclure les meilleures pratiques suivantes :

- Transparence. Les organisations doivent clairement indiquer comment elles utilisent l'IA pour développer, déployer et maintenir des algorithmes, des produits et des services.

- Responsabilité. Une structure de gouvernance doit être mise en place pour assurer un suivi et une surveillance efficaces.

- Utilisation éthique des données. Les équipes d'IA doivent comprendre les implications de l'entraînement d'un modèle d'IA sur des données sensibles et comment éviter les données biaisées ou empoisonnées. Une politique de gouvernance permet à ces développeurs de garder à l'esprit le concept d'IA responsable, en veillant à ce qu'ils examinent attentivement les sources de données.

- Conformité. Une politique doit demander aux équipes juridiques et de conformité de travailler avec les développeurs d'IA pour s'assurer que le développement est conforme aux lois et réglementations locales, nationales et fédérales.

- Formation. Chaque responsable et employé impliqué dans le développement, le déploiement et l'utilisation de l'IA doit suivre une formation sur la politique de gouvernance et son fonctionnement.

- Participation de plusieurs équipes. En fonction des besoins de l'entreprise, plusieurs équipes peuvent être impliquées dans le développement, la mise en œuvre et la maintenance d'un nouveau produit ou outil d'IA. Par exemple, lorsqu'un modèle d'IA est développé pour traiter des informations de santé personnelles, des équipes d'experts en santé travailleront probablement aux côtés des développeurs.

Exemples d'entreprises adoptant l'IA responsable

Parmi les entreprises qui poursuivent des stratégies d'IA responsable et des cas d'utilisation, on trouve Microsoft, FICO et IBM.

Microsoft

Microsoft a créé un cadre de gouvernance de l'IA responsable avec l'aide de ses groupes AI, Ethics and Effects in Engineering and Research Committee et Office of Responsible AI (ORA). Ces deux groupes collaborent au sein de Microsoft pour diffuser et défendre les valeurs de l'IA responsable.

L'ORA est chargée d'établir des règles à l'échelle de l'entreprise en matière d'IA responsable par la mise en œuvre de travaux de gouvernance et de politique publique. Microsoft a mis en œuvre plusieurs lignes directrices, listes de contrôle et modèles en matière d'IA responsable, dont les suivants :

- Lignes directrices relatives à l'interaction entre l'homme et l'intelligence artificielle.

- Lignes directrices sur l'IA conversationnelle.

- Lignes directrices pour une conception inclusive.

- Listes de contrôle de l'équité de l'IA.

- Modèles de fiches de données.

- Conseils en matière d'ingénierie de la sécurité de l'IA.

FICO

L'organisme d'évaluation du crédit FICO a créé des politiques de gouvernance responsable de l'IA pour aider ses employés et ses clients à comprendre le fonctionnement et les limites des modèles de ML utilisés par l'entreprise. Les scientifiques des données de FICO sont chargés de prendre en compte l'ensemble du cycle de vie de ses modèles de ML. Ils testent en permanence leur efficacité et leur équité. FICO a développé les méthodologies et initiatives suivantes pour la détection des biais :

- Construire, exécuter et contrôler des modèles explicables pour l'IA.

- Utiliser la blockchain comme outil de gouvernance pour documenter le fonctionnement d'une solution d'IA.

- Partager une boîte à outils d'IA explicable avec les employés et les clients.

- Utiliser des tests complets pour détecter les préjugés.

IBM

IBM dispose de son propre comité d'éthique dédié aux questions relatives à l'intelligence artificielle. Le comité d'éthique de l'intelligence artificielle d'IBM est un organe central qui soutient la création d'une intelligence artificielle responsable et éthique dans l'ensemble de l'entreprise. Les lignes directrices et les ressources utilisées par IBM sont notamment les suivantes :

- Confiance et transparence de l'IA.

- Considérations éthiques quotidiennes pour l'IA.

- Ressources communautaires à source ouverte.

- Recherche sur l'IA de confiance.

Le rôle de la blockchain dans l'IA responsable

La blockchain est une technologie populaire de registre distribué utilisée pour le suivi des données transactionnelles des crypto-monnaies. C'est également un outil précieux pour créer un enregistrement inviolable qui documente les raisons pour lesquelles un modèle de ML a fait une prédiction particulière. C'est pourquoi certaines entreprises utilisent la technologie blockchain pour documenter leur utilisation de l'IA.

Avec la blockchain, chaque étape du processus de développement - y compris les personnes qui ont pris, testé et approuvé chaque décision - est enregistrée dans un format lisible par l'homme et inaltérable.

Normalisation responsable de l'IA

Des dirigeants de grandes entreprises, telles qu'IBM, ont publiquement appelé à une réglementation de l'IA. Aux États-Unis, aucune loi ou norme fédérale n'a encore vu le jour, malgré l'essor récent des modèles d'IA générative, tels que ChatGPT. Toutefois, la loi européenne sur l'IA de 2024 fournit un cadre permettant d'éradiquer les systèmes d'IA à haut risque et de protéger les données sensibles contre l'utilisation abusive de ces systèmes.

Les États-Unis n'ont pas encore adopté de législation fédérale régissant l'IA et les avis sont partagés quant à l'éventualité d'une réglementation de l'IA. Toutefois, le NIST et l'administration Biden ont publié des lignes directrices générales pour l'utilisation de l'IA. Le NIST a publié son cadre de gestion des risques liés à l'intelligence artificielle. L'administration Biden a publié des projets de charte des droits de l'IA, de cadre de gestion des risques liés à l'IA et de feuille de route pour la création d'une ressource nationale de recherche sur l'IA.

En mars 2024, le Parlement européen a ratifié la loi sur l'IA de l'UE, qui comprend un cadre réglementaire pour des pratiques responsables en matière d'IA. Il adopte une approche fondée sur le risque, divisant les applications d'IA en quatre catégories différentes : risque minimal, risque limité, risque élevé et risque inacceptable. Les systèmes d'IA à risque élevé et inacceptable doivent être atténués au fil du temps. Cette loi s'applique aux entreprises de l'UE et des pays tiers qui traitent les données des citoyens de l'UE.

La loi européenne sur l'IA a des implications claires sur la façon dont les entreprises mettent en œuvre et utilisent l'IA dans le monde réel. Découvrez ce que vous devez savoir pour vous conformer à la loi européenne sur l'IA.