Qu'est-ce que la chaîne de pensée (CoT) ? Exemples et avantages

La technique Chain-of-thought (CoT) est une technique d'ingénierie des invites (prompts) qui vise à améliorer les performances des modèles linguistiques dans les tâches nécessitant de la logique, des calculs et des prises de décision, en structurant l'invite d'entrée de manière à imiter le raisonnement humain.

Pour créer un prompt CoT, l'utilisateur ajoute généralement une instruction telle que « Décrivez votre raisonnement étape par étape » ou « Expliquez votre réponse étape par étape » à la fin de sa requête adressée à un modèle linguistique à grande échelle (LLM). En substance, cette technique d'invite demande au LLM non seulement de générer un résultat, mais aussi de détailler la série d'étapes intermédiaires qui ont conduit à cette réponse.

Guider le modèle pour articuler ces étapes intermédiaires a donné des résultats prometteurs. « Chain-of-Thought Prompting Elicits Reasoning in Large Language Models » est un article fondateur rédigé par l'équipe de recherche Google Brain (aujourd'hui DeepMind) et présenté lors de la conférence NeurIPS 2022. Les chercheurs ont découvert que la technique CoT surpassait les techniques standard dans une série de tests de raisonnement arithmétique, symbolique et de bon sens.

Comment fonctionne le prompt CoT ?

Le prompt CoT tire parti des capacités des LLM, telles que leur aptitude sophistiquée à générer un langage fluide. Elle le fait afin de simuler des techniques issues du traitement cognitif humain, telles que la planification et le raisonnement séquentiel.

Lorsque les gens sont confrontés à un problème difficile, ils le décomposent souvent en éléments plus petits et plus faciles à gérer. Par exemple, la résolution d'une équation mathématique complexe implique généralement plusieurs sous-étapes, chacune étant essentielle pour arriver à la bonne réponse finale. Le prompt CoT demande à un LLM d'imiter ce processus de décomposition d'un problème et de le traiter étape par étape, en demandant essentiellement au modèle de « penser à voix haute » plutôt que de simplement fournir une solution.

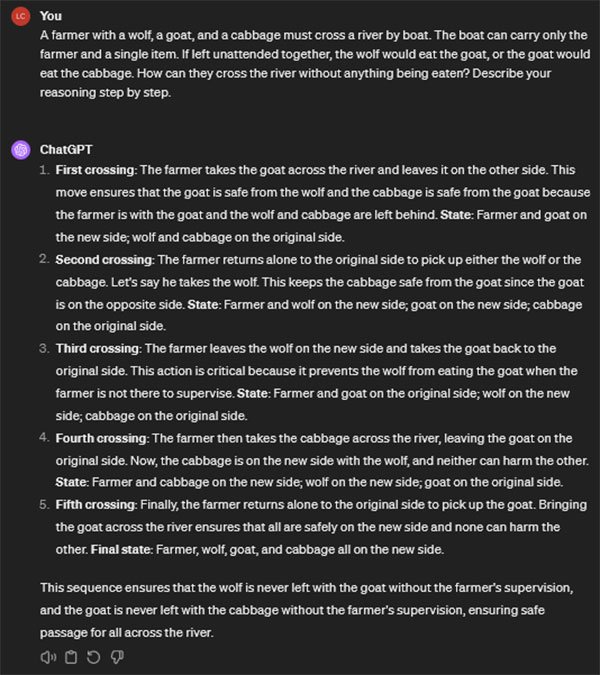

La capture d'écran ci-dessous montre un exemple du fonctionnement de la chaîne de raisonnement. L'utilisateur présente à ChatGPT d'OpenAI un casse-tête logique classique consistant à traverser une rivière, en ajoutant la phrase « Décrivez votre raisonnement étape par étape » à la fin de la question. Lorsque le chatbot répond, il résout le problème de manière séquentielle, en décrivant chaque traversée menant à la réponse finale.

Voici d'autres exemples de prompts CoT :

- « John a une pizza coupée en huit parts égales. John mange trois parts et son ami en mange deux. Combien de parts reste-t-il ? Expliquez votre raisonnement étape par étape. »

- « Alice a laissé un verre d'eau dehors pendant la nuit alors que la température était inférieure à zéro. Le lendemain matin, elle a trouvé le verre fissuré. Expliquez étape par étape pourquoi le verre s'est fissuré. »

- « Si toutes les roses sont des fleurs et que certaines fleurs se fanent rapidement, peut-on en conclure que certaines roses se fanent rapidement ? Expliquez votre raisonnement étape par étape. »

- « Une salle de classe compte deux chaises bleues pour trois chaises rouges. S'il y a au total 30 chaises dans la salle, combien y a-t-il de chaises bleues ? Décrivez votre raisonnement étape par étape. »

Différentes approches pour inciter à la CoT

Le prompt CoT comporte plusieurs variantes, chacune utilisant une approche différente pour amener les LLM à expliquer leurs résultats :

- Auto-CoT. Dans le CoT automatique, l'utilisateur crée quelques exemples d'entrées et de sorties souhaitées pour qu'un LLM les apprenne, y compris les étapes intermédiaires nécessaires pour obtenir ces sorties. Le LLM apprend ensuite à partir de ces exemples et applique automatiquement le même raisonnement aux interactions futures avec l'utilisateur.

- CoT multimodal. Les LLM capables de traiter des entrées autres que du texte, telles que des fichiers audio, des images et des vidéos, constituent une IA multimodale. Un exemple de CoT multimodal serait de demander à un LLM d'examiner des images lorsqu'il explique et justifie ses résultats.

- CoT zéro coup. Avec cette approche, l'utilisateur ne fournit pas d'exemples à LLM pour qu'il s'y réfère, mais lui demande plutôt de « montrer son travail » et d'expliquer comment il est parvenu à son résultat. Ce processus est efficace, mais moins performant pour les entrées complexes ; la chaîne de pensée zéro coup est mieux adaptée aux problèmes plus simples.

- CoT du plus petit au plus grand. Avec cette approche, l'utilisateur divise un problème complexe en plusieurs sous-problèmes plus petits et les envoie séquentiellement au LLM. Le LLM peut alors résoudre plus facilement chaque sous-problème en utilisant les réponses aux sous-problèmes précédents comme référence.

Le prompt à quelques essais (few-shot) et le prompt traditionnel ou standard sont similaires au CoT, mais ne sont pas considérés comme du CoT. Le prompt standard n'exige pas des LLM qu'ils fournissent un raisonnement complexe et justifient leurs résultats ; dans l'approche standard, seul le résultat produit importe. Le few-shot prompt signifie qu'un utilisateur fournit des exemples de résultats souhaités pour des entrées similaires, tels que des réponses à des problèmes mathématiques similaires, afin d'aider à guider le LLM. Cependant, cela ne relève pas d'une approche CoT.

Avantages du prompt CoT

Le prompt CoT offre plusieurs avantages :

- De meilleures réponses. Les LLM ne peuvent traiter qu'une quantité limitée d'informations à la fois. Décomposer les problèmes complexes en sous-tâches plus simples permet d'atténuer ce problème. Cela permet aux LLM de traiter ces éléments plus petits individuellement, ce qui conduit à des réponses plus précises et plus exactes.

- Base de connaissances élargie. Les prompts CoT tirent parti du vaste réservoir de connaissances générales des LLM. Les LLM sont exposés à un large éventail d'explications, de définitions et d'exemples de résolution de problèmes au cours de leur formation sur de vastes ensembles de données textuelles, comprenant des livres, des articles et une grande partie de l'Internet ouvert. Les prompts CoT exploitent ce réservoir de connaissances stockées en déclenchant le modèle pour qu'il fasse appel à des informations pertinentes et les applique.

- Raisonnement logique. Cette technique cible directement une limitation courante des LLM : leur difficulté à raisonner logiquement. Bien que les LLM excellent dans la génération de textes cohérents et pertinents, ils n'ont pas été conçus à l'origine pour fournir des informations ou résoudre des problèmes. Par conséquent, ils ont souvent du mal à accomplir des tâches de raisonnement complexes et à appliquer la logique, en particulier pour les problèmes plus complexes. Le prompt CoT résout ce problème en guidant le modèle vers une approche de raisonnement structurée. Il dirige le modèle vers la construction d'un cheminement logique entre la question initiale ou l'énoncé du problème et la réponse finale, réduisant ainsi le risque d'erreurs logiques et d'omissions.

- Débogage. Les prompts CoT facilitent le débogage et l'amélioration des modèles en apportant de la transparence au processus par lequel un modèle arrive à sa réponse. Comme les prompts demandent au modèle de décrire explicitement son processus de raisonnement, elles permettent aux testeurs et aux développeurs de mieux comprendre comment le modèle est parvenu à une conclusion particulière. Cela facilite ensuite l'identification et la correction des erreurs lors du perfectionnement du modèle.

- Réglage fin. Les développeurs peuvent combiner les prompts CoT avec un réglage fin pour améliorer les capacités de raisonnement des LLM. Par exemple, le réglage fin d'un modèle sur un ensemble de données d'entraînement contenant des exemples sélectionnés de raisonnement étape par étape et de déduction logique peut améliorer l'efficacité des invites CoT.

Limites du prompt CoT

Il est important de noter, comme l'a souligné l'équipe de recherche de Google dans son article, que le semblant de raisonnement que les CoT suscitent chez les LLM ne signifie pas que le modèle réfléchit. Il est essentiel de garder à l'esprit que le modèle est un réseau neuronal d'apprentissage profond entraîné à prédire des séquences de texte sur la base de probabilités. Rien ne prouve que les LLM soient capables de raisonner comme les humains. Cette distinction est cruciale pour que les utilisateurs comprennent les limites des LLM et gardent des attentes réalistes quant à leurs capacités.

Les LLM sont dépourvus de conscience et de métacognition, et leurs connaissances générales proviennent uniquement de leurs données d'entraînement, reflétant ainsi les erreurs, les lacunes et les biais de cet ensemble de données. Bien qu'un LLM puisse imiter avec précision la structure du raisonnement logique, cela ne signifie pas pour autant que ses conclusions sont toujours exactes. Les invites CoT constituent un mécanisme d'organisation précieux pour les résultats des LLM, mais un LLM peut néanmoins présenter un résultat cohérent et bien structuré qui contient des erreurs logiques et des oublis.

Des techniques telles que la génération augmentée par la récupération (RAG) semblent prometteuses pour pallier cette limitation. La RAG permet à un LLM d'accéder en temps réel à une source externe, telle qu'une base de données vérifiée ou Internet, lorsqu'on lui demande de fournir des informations. De cette manière, la RAG évite au LLM de dépendre uniquement de la base de connaissances interne tirée de ses données d'entraînement, qui peuvent être erronées ou incomplètes.

Cependant, si le RAG peut améliorer la précision et la rapidité des résultats d'un LLM, il ne résout pas en soi le problème du raisonnement logique. La déduction et le raisonnement exigent plus que la simple mémorisation de faits ; ils impliquent également la capacité de tirer des conclusions par le biais de la logique et de l'analyse. Ces aspects des performances de l'IA sont plus étroitement liés à l'architecture algorithmique et à l'entraînement du LLM lui-même.

De plus, l'évolutivité du prompt CoT reste incertaine. Bien que le principe sous-jacent du raisonnement séquentiel en plusieurs étapes soit applicable à l'IA et à l'apprentissage automatique, la suggestion CoT est limitée aux LLM en raison de leurs performances sophistiquées dans les tâches linguistiques.

La taille importante des LLM nécessite des données, des capacités de calcul et une infrastructure considérables, ce qui soulève des questions en matière d'accessibilité, d'efficacité et de durabilité. Pour répondre à ce problème, les chercheurs en IA ont développé des modèles linguistiques de petite taille qui, bien que moins puissants que les LLM, offrent des performances compétitives dans diverses tâches linguistiques et nécessitent moins de ressources informatiques. Cependant, il reste à voir si les avantages du CoT prompting sont transférables à des modèles plus petits, car la réduction de leurs capacités risque de compromettre leur efficacité en matière de résolution de problèmes.

Il est important de garder à l'esprit que les prompts CoT sont une technique permettant d'utiliser plus efficacement un modèle existant, et non une méthode d'entraînement. Si ces prompts peuvent aider les utilisateurs à obtenir de meilleurs résultats à partir de LLM pré-entraînés, l'ingénierie des prompts n'est pas une panacée et ne peut pas remédier aux limites du modèle qui auraient dû être traitées pendant la phase d'entraînement.

prompt CoT vs chaînage de prompts

Le prompt CoT et le chaînage de prompts semblent similaires et sont tous deux des techniques d'ingénierie de prompts , mais ils diffèrent sur certains points importants.

Le prompt CoT demande au modèle de décrire les étapes intermédiaires utilisées pour parvenir à la réponse finale dans une seule réponse. Cela est utile pour les tâches complexes qui nécessitent des explications détaillées, de la planification et du raisonnement, telles que les problèmes mathématiques et les énigmes logiques, où l'explication du processus de réflexion est essentielle pour bien comprendre la solution.

En revanche, le chaînage de prompts implique une séquence itérative de prompts et de réponses, dans laquelle chaque prompt suivant est formulé sur la base de la sortie du modèle en réponse au précédent. Cela fait du chaînage de prompts une technique utile pour les tâches plus créatives et exploratoires qui impliquent un raffinement progressif, telles que la génération de récits détaillés et le brainstorming d'idées.

La différence fondamentale entre le prompt CoT et le chaînage de prompt réside dans l'itération et l'interactivité. Le prompt CoT présente le processus de raisonnement dans une seule réponse détaillée et autonome. Le chaînage de prompt adopte une approche plus dynamique, avec plusieurs cycles d'interaction qui permettent aux utilisateurs de développer une idée au fil du temps.

Cas d'utilisation du prompt CoT

Le CoT est bien plus qu'une simple technique d'IA pour les utilisateurs de LLM et les passionnés de technologie. Il existe des applications concrètes du CoT qui aident les organisations à accomplir des tâches telles que celles-ci :

- Comprendre les réglementations. Les experts juridiques peuvent utiliser le prompt CoT pour demander à un LLM d'expliquer les réglementations nouvelles ou existantes, telles que les lois relatives à la confidentialité des données, et leur application à leur organisation. Cette approche peut également s'appliquer à la rédaction de nouvelles politiques internes.

- Former les nouveaux employés. Un LLM peut enseigner aux nouvelles recrues d'une organisation ses politiques internes. Par exemple, une nouvelle recrue peut utiliser la fonction CoT pour demander à un LLM quelles politiques s'appliquent à une situation spécifique et pourquoi.

- Répondre aux questions des clients. Les chatbots alimentés par l'IA sont couramment utilisés dans les industries pour les interactions avec les clients. Dans ce cas, un client peut avoir besoin d'effectuer un processus de dépannage complexe, et un chatbot peut lui expliquer comment et pourquoi il doit effectuer certaines actions.

- Gestion de la logistique et des chaînes d'approvisionnement. Une entreprise de logistique ou de transport pourrait s'appuyer sur cette technique lorsqu'elle demande à un LLM d'élaborer une meilleure stratégie logistique. Le LLM devrait expliquer ses réponses et la manière dont elles optimisent les opérations logistiques.

- Création de contenu original. Les outils d'IA générative pourraient rédiger et organiser des textes de manière à faciliter leur compréhension par les lecteurs, et expliquer pourquoi ils ont procédé ainsi. Les contenus longs, tels que les articles de recherche scientifique complexes, pourraient tirer profit de cette approche.

Le prompt CoT est l'une des nombreuses stratégies avancées utilisées dans l'ingénierie des prompts. Découvrez d'autres stratégies et astuces importantes.