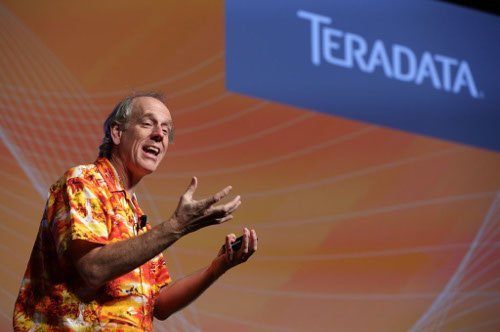

Entretien avec Stephen Brobst, CTO de Teradata

A l’occasion de la conférence Teradata Universe 2015, qui s’est tenue cette semaine à Amsterdam, le CTO du groupe Stephen Brobst s’est entretenu avec la rédaction sur la stratégie de Teradata quant à la création d’un écosystème autour de ses technologies et de la position d’Hadoop par rapport à l’entrepôt de données.

« Hadoop a de la valeur pour rendre les données consommables par l’entrepôt de données »

A l’occasion de la conférence Teradata Universe 2015, qui s’est tenue cette semaine à Amsterdam, le CTO du groupe Stephen Brobst s’est entretenu avec la rédaction sur la stratégie de Teradata quant à la création d’un écosystème autour de ses technologies et de la position d’Hadoop par rapport à l’entrepôt de données.

LeMagIT : Que pensez-vous des offres d’entrepôts de données pensées pour le Cloud, comme RedShift ?

Stephen Brobst : Tout d’abord, pour les petites entreprises et les PME, l’essentiel sera dans le Cloud. Pour les grandes entreprises, cela va prendre plus de temps ou ne va pas se passer car le coût lié au déplacement des données et les économies d’échelle dans un grand datacenter ne sont pas les mêmes que ceux d’une petite entreprises (Hermann Wimmer, le président de la division analytique, milite pour le modèle hybride, NDLR).

En revanche, il faut faire attention lorsqu’on évoque des solutions dites « Cloud-native ». RedShift repose sur une technologie de base de données de ParAccel développée à l’origine par une start-up, et non pas pour le Cloud pur. Son manque de scalabilité figeait son activité. AWS a racheté le code source et l’a mis sur son Cloud. Ce n’est pas du AWS, d’un point de vue purement technique. AWS ne place pas deux entreprises sur le même serveur RedShift, ce qui ne serait probablement pas une bonne idée. Ils allouent un Virtual Private Cloud. Vous disposez donc des serveurs alloués à votre entreprise, fonctionnant avec cette base de données ParAccel, qu’ils ont rebaptisé RedShift.

LeMagIT : Teradata se place au coeur d’un écosystème en matière d’analytique. Pouvez-vous expliquer pourquoi ?

Stephen Brosbt : Aucune unique technologie ne résout tous les problèmes. Comment faire donc fonctionner ensemble plusieurs technologies. Ces technologies appartiennent à plusieurs éditeurs, qu’ils soient propriétaires et Open Source.

Il s’agit aujourd’hui pour les entreprises d’étendre la portée de l’écosystème : la plupart des entreprises ont installé un entrepôt de données. Mais dans ce monde du Big Data, l’entrepôt de données n’a capturé qu’une sous-partie de l’ensemble des données disponibles. Grâce à l’écosystème, vous pouvez avoir accès à des données qui jusqu’alors étaient ignorées par les entreprises, comme les fichiers, textes, les fichiers vidéo ou audio, par exemple. Et certaines technologies sont plus performantes que d’autres pour réaliser cela. Comment faire fonctionner ensemble un jeu de données relationnelles avec un autre non relationnel ?

LeMagIT : Avec l’émergence de nombreuses technologies, comme SQL-On-Hadoop par exemple, nous dirigeons-nous vers un rapprochement entre Hadoop et l’entrepôt de données ?

Stephen Brosbt : Les technologies SQL-On-Hadoop sont aujourd’hui peu matures. Si vous scannez de lourds fichiers, et vous en filtrez et agrégez les données en plusieurs buckets, cela est performant. Mais si vous utilisez SQL-On-Hadoop pour effectuer des jointures complexes sur d’importants jeux de données, Hadoop est extrêmement inefficace. Ce n’est pas la bonne solution pour cela.

Le principal cas d’usage d’Hadoop porte sur les données avec une structure non relationnelle. Du texte, des weblogs, des fichiers vocaux, qui étaient jusqu’alors jetés par les entreprises.

Mais au final, aucune donnée n’est extraite de l’entrepôt de données pour aller dans Hadoop. C’est en fait l’inverse qui se passe. Les données sont placées dans Hadoop avant de migrer dans l’entrepôt de données. Certains sous-ensembles de ces données que l’on estime à valeur sont sélectionnés et placées dans l’entrepôt de données.

Les enregistrements vocaux peuvent être convertis en fichier texte. Le fichier vocal reste dans Hadoop. Il serait trop couteux de le placer dans l’entrepôt de données. Cette transformation voix - texte est effectuée dans Hadoop et le volume du ficher est réduit d’un facteur de 100. Je pourrais placer ce fichier dans une base relationnelle, mais sans gros intérêt. Mais si à partir du fichier texte, je réalise une extraction d’information dans Hadoop, le résultat est propice au relationnel, et peut migrr vers l’entrepôt de données.. Et cela est encore beaucoup moins volumineux que le texte de base. Seulement ces données, dont la taille a été réduite, sont placées dans l’entrepôt de données.

Hadoop a de la valeur pour rendre les données consommables par l’entrepôt de données et les rendre plus structurées. Tout ce travail clé est réalisé dans Hadoop. Et jusqu’alors tout cela n’était pas réalisé par les entreprises.

Sortir les données de l’entrepôt de données et les stocker dans Hadoop ne sert à rien. Ce n’est pas efficace et réduit la valeur car vous avez perdu le côté structuré. Hadoop est juste un système de fichiers, il ne dispose pas de schémas, par exemple. Hadoop a seulement de la valeur lorsque vous manipulez des données non relationnelles. Avec des données relationnelles, sa valeur est probablement négative dans la plupart des cas d’usage.

LeMagIT : Aujourd’hui, si le monde Hadoop se structure autour de seulement quelques acteurs acteurs, les clients ont toutefois du mal à s’y retrouver . Tous se disent Hadoop. Comment aider les entreprises à s’y retrouver ?

Stephen Brosbt : Il existe des différences technologiques et philosophiques entre les trois acteurs Hadoop. Par exemple, d’un point de vue philosophique, chez Hortonworks, tout va dans l’Open Source. Tout le code écrit par HortonWorks part à la communauté. Cela est très différent des autres acteurs. Chez eux, certaines parties sont bien propriétaires, jusqu’à un certain point. Chez Cloudera, tout ce qui touche le système de fichiers est Open Source et la valeur est placée sur la couche d’administration. Au lieu d’Ambari, utilisé par Hortonworks pour l’administration d’Hadoop, Cloudera propose son propre outil, mais qui n’est pas Open Source.

Il existe aussi des approches différentes entre Hive, Impala et Drill. Lequel est le mieux ? Chacun a son propre intérêt. MapR est certainement celui qui a le plus modifié cet élan Open Source pour gagner en performances, disponibilité ou temps réel. Mais au détriment d’autre chose, car ce n’est plus Open Source. Où se placer dans cet environnement : chaque client a un besoin différent.

Du point de vue de Teradata, nous voulons travailler avec la partie ouverte des APIs d’Hadoop. Et tant que cela reste ainsi, la différence des distributions a peu d’importance. Mais nous avons plus de clients sur HortonWorks. Cloudera est très proche, et MapR est derrière, mais avec des usages très sophistiqués. Je ne peux pas dire laquelle est meilleure, cela dépend de la philosophie.

Mais cela est cohérent avec le modèle Best of Breed de Teradata.

Teradata certifie de nombreux outils d’ETL, des distributions Hadoop, de nombreux outils de visualisation. Nous investissons davantage dans l’intégration avec les meilleurs acteurs plutôt de racheter ou de développer tout un environnement (comme pourrait par exemple le faire Oracle, NDLR).

Pour approfondir sur Outils décisionnels et analytiques

-

![]()

Oliver Ratzesberger, CEO de Teradata : « notre héritage nous a donnés un avantage technologique »

-

![]()

Teradata et l’Open Source : la relation se structure avec Think Big et Kylo

-

![]()

Teradata, prêt pour le déploiement multi-environnement (cloud compris)

-

![]()

L’essentiel sur Teradata Active Enterprise Data Warehouse