Dell dévoile les premiers serveurs Blackwell pour l’entreprise

Allant bien au-delà de l’unique configuration présentée par Nvidia, Dell commercialise des serveurs équipés des derniers GPU B300, qui fonctionnent avec des processeurs x86 traditionnels et peuvent même être refroidis par simple ventilation.

Les premiers serveurs Blackwell pour datacenters ont été dévoilés cette semaine à Las Vegas par Dell, lors de son événement Dell Technologies World annuel. Huit modèles ont été présentés, dont six à base de processeurs x86 classiques. Parmi eux, trois peuvent être refroidis par des systèmes de ventilation conventionnels.

Jusque-là, seul Nvidia avait montré des serveurs basés sur ses derniers GPU B200 et B300. Et il n’y avait qu’une seule configuration : des machines 2U contenant chacune deux processeurs ARM Grace et quatre GPU B200 ou B300, le tout refroidi à l’eau via des canalisations qui serpentent à la surface des puces.

Problème, ni les datacenters actuels des entreprises ni ceux des hébergeurs de proximités n’ont d’infrastructure pour le refroidissement à eau. De même, aucune application existante en entreprise n’est écrite pour les processeurs ARM. L’offre de Dell résout ces deux contraintes.

« Nous œuvrons sur deux marchés. Nous fournissons des clusters de calculs pour des centres géants d’entraînement de l’intelligence artificielle. Eux sont construits de façon à fonctionner de base avec du refroidissement liquide. Mais nous fournissons aussi plusieurs milliers d’entreprises qui veulent déployer une puissance de calcul pour l’IA dans leurs datacenters et il n’est pas question de les négliger », argumente John Roese, le directeur technologique de Dell.

« Les centres de calcul vont déployer 100 000 GPU et ont besoin de beaucoup de densité au mètre carré, ce qui n’est possible qu’avec du refroidissement liquide. Les seconds ne vont déployer que des dizaines de GPU. Dans ce cas, nous sommes les seuls à leur dire qu’il est possible de le faire sans qu’ils aient à se lancer dans des gros travaux de plomberie », ajoute-t-il.

Des machines x86 avec huit GPU au format SXM

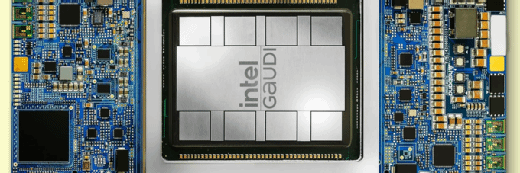

Dans les faits, Dell propose trois configurations x86. Le serveur XE9780 dispose de deux processeurs Intel Xeon et huit GPU B300 de Nvidia. Le serveur XE9785 a quant à lui deux processeurs AMD Epyc et il est disponible soit en version avec huit GPU B300, soit en version avec huit GPU MI350 de Nvidia.

« Ces trois configurations se déclinent en deux versions. La première, avec un L à la fin (par exemple XE9780L), est une unité rack large de 21 pouces et haute de 3U qui est refroidie à l’eau. La seconde, sans le L dans le nom, est une unité rack large de 19 pouces, soit compatible avec les datacenters des entreprises, et haute de 10U », explique un démonstrateur présent sur le stand de Dell consacré aux serveurs pour l’IA.

« Ce qui fait la différence est que, pour être refroidis à l’air, les serveurs hauts de 10U contiennent des radiateurs énormes. Ceux des GPU mesurent à eux seul 6U de haut et ceux des processeurs font entre 2 et 3U de haut », précise-t-il.

La hauteur inédite de ces radiateurs sert à offrir suffisamment de surface de refroidissement aux énormes ventilateurs qui soufflent de l’air en façade. Et si cette surface est si importante, c’est parce que chacun des GPU de Nvidia comme d’AMD dégage une puissance calorifique de 1200 à 1400 watts.

« Oui, physiquement, vous pouvez installer quatre serveurs de 10U dans une baie rack traditionnelle pour monter à 32 GPU par rack. Après… Il faut que vous ameniez suffisamment de puissance électrique par baie rack », dit le démonstrateur, sans annoncer de chiffre.

Selon un calcul rapide du MagIT, la puissance par baie rack nécessaire serait de l’ordre de 50 kW, en comptant 500 watts par processeur. Mais sans compter l’électricité nécessaire aux ventilateurs et à la climatisation qui refroidit l’air en amont.

Qu’ils soient refroidis par air ou par liquide, les serveurs contiennent dans tous les cas huit GPU directement installés sur leur carte mère, soit des modèles SXM dans la nomenclature de Nvidia et d’AMD. On y trouve aussi 16 SSD NVMe extractibles en façade.

Les deux autres nouveaux serveurs sont les XE9712 et XE8712. Ceux-ci sont des implémentations strictes des dernières générations de serveurs DGX de Nvidia, soit avec deux processeurs Grace par serveur et quatre GPU. Dans le XE9712, les GPU sont des B300. Dans le XE8712, ce sont des B200.

Des machines plus compactes pour l’inférence

Les serveurs XE9780/85 succèdent au serveur XE9680 lancé en 2023 et qui, lui, contenait huit GPU Nvidia H100/H200 ou AMD MI300X, sous la forme de cartes PCIe. Pour l’heure, Nvidia n’a pas lancé de version PCIe de sa dernière génération Blackwell.

Cela dit, il existe une autre nouvelle machine, le serveur XE7745, qui contient huit GPU sous la forme de carte PCIe. Son format 4U est plus compact que les 6U du modèle précédent.

« Cette machine sera équipée de tout GPU que Nvidia ou AMD pourront commercialiser au format GPU. Pour l’heure, il s’agit de huit H200 ou huit RTX 6000 Pro. Ce sont donc des machines plutôt conçues pour l’inférence », commente le démonstrateur.