Semiconducteurs : de retour en Chine, Nvidia affiche son double jeu

Le fabricant de GPU a de nouveau le droit de vendre ses accélérateurs H20 pour entraîner les IA chinoises. D’un côté, Jensen Huang dit œuvrer au succès américain face à Huawei. De l’autre, il fait tout pour que Tencent, Alibaba et ByteDance rivalisent avec les IA occidentales.

Nvidia a de nouveau le droit de vendre à la Chine ses GPU H20 pour l’entraînement des IA, et même une version spéciale de son GPU RTX Pro pour l’inférence. Plaidant que « des IA civiles plus performantes sur une technologie américaine incitent les pays du monde entier à choisir l’Amérique », le PDG Jensen Huang (en photo en haut de cet article) est parvenu à obtenir cette autorisation de l’administration Trump in extremis, juste avant de partir en tournée commerciale à Pékin.

Il s’agit du dernier épisode en date d’une succession de mesures liées aux puces de calcul et prises par les USA à l’encontre de la Chine, dans un contexte plus large de rivalité commerciale entre les deux pays. Le revirement du gouvernement américain a d’ailleurs sans doute ici plus à voir avec ce contexte plus large qu’avec les talents de persuasion de Jensen Huang.

Depuis avril, la Chine a fixé des quotas sur l’exportation de ses terres rares vers les USA. Le pays est le numéro 1 mondial de l’extraction (70% du marché) et de la transformation (90% du marché) de ces métaux indispensables aux batteries. Celles des smartphones et des véhicules électriques, notamment. En priver les industriels américains revient à leur faire revivre le scénario des pénuries lors du covid.

En attendant de pouvoir mettre la main sur les gisements qui existeraient dans les sous-sols du Groenland, de l’Ukraine et des fonds marins internationaux, l’administration Trump s’est manifestement sentie obligée de lâcher du lest parmi les restrictions qu’elle impose à Pékin. Ce sera donc des GPU contre des terres rares. C’est-à-dire de l’IA contre des batteries.

Pour autant, il existe bien un bras de fer spécifique à la vente de GPU Nvidia à la Chine. Mais il concerne moins les États que des acteurs commerciaux. D’un côté, la Chine représentait en 2024, pour Nvidia, un juteux marché de 17 milliards de dollars, soit 13% de ses ventes. Et rien que sur le premier trimestre 2025, Tencent, Alibaba et ByteDance lui auraient acheté pour 16 milliards de dollars de H20. Il s’agit du second plus important marché pour Nvidia, après les USA.

De l’autre, les éditeurs de LLM américains (OpenAI, Google, Meta, Anthropic...) subissent une forte concurrence de la part des IA chinoises (DeepSeek, Qwen...) et sont à la manœuvre pour conseiller au gouvernement américain tout ce qu’il doit interdire pour les défavoriser. En premier lieu, les GPU Nvidia qui servent à les entraîner.

Le H20, un GPU bien plus intéressant qu’il n’en a l’air

C’est en avril dernier que Washington avait interdit à Nvidia d’exporter tout GPU vers la Chine. Il s’agissait alors de durcir des quotas de quantités votés à la toute fin du mandat de Joe Biden, qui eux-mêmes durcissaient des plafonds de puissance définis dès 2022. C’est pour respecter ces plafonds de puissance que Nvidia avait mis au point, dès 2023, le H800, puis le H20. Soit, officiellement, des versions bridées de son GPU H100.

Le H20 a un nombre de cœurs Hopper réduit par rapport au H100, ce qui ne lui laisse plus qu’une puissance de calcul de 148 TFLOPS, contre 1979 ou 1513 TFLOPS selon la version de l’accélérateur d’origine. Mais en vérité, cela n’a jamais véritablement posé de problème aux utilisateurs. Ils peuvent compenser la faible puissance individuelle de la puce par un plus grand nombre de GPU montés en réseau et, ce faisant, entraîner aussi vite leurs modèles que le font les Occidentaux.

Les observateurs soupçonnent d’ailleurs Nvidia d’avoir tout fait pour que ses clients chinois ne soient pas plus lésés que les autres. Techniquement, le H20 a le même contrôleur NVLink à 900 Go/s que le H100, ce qui le rend très efficace en réseau. Industriellement parlant, le H20 n’a pas été fabriqué dans les mêmes usines que le H100 et, de ce fait, ses acheteurs ont pu en obtenir de grandes quantités tandis que les Occidentaux souffraient de pénurie. Il n’y a pas non plus eu de désavantage commercial trop important, puisque le H20 coûtait à sa sortie entre trois et quatre fois moins cher que le H100.

Ces raisons avaient finalement poussé Washington à passer des plafonds de puissance par GPU aux quotas de quantité globale de TFLOPS exportables vers la Chine. Ou vers d’autres pays pareillement considérés comme des adversaires par les USA.

Mais cela n’a pas suffi. Nvidia a conçu son H20 avec 96 Go de mémoire HBM, contre 80 Go sur le H100. Cela signifie que le H20 est plus rapide que le H100 sur l’inférence (l’utilisation d’un LLM après son entraînement de base). Or, l’inférence ne sert pas qu’aux utilisateurs de chatbots. La présence de RAM supplémentaire aide aussi à accélérer le réentraînement d’un modèle, c’est-à-dire son perfectionnement. Une technique qui a notamment servi à faire de Deepseek R3 le modèle le plus efficace à sa sortie.

C’est sur ces arguments qu’OpenAI, Anthropic et Google sont parvenus en mars dernier à faire interdire tout export de GPU Nvidia à la Chine.

Ne surtout pas laisser Huawei prendre des parts de marché

Face au lobby des éditeurs de LLM, Jensen Huang argumente qu’interdire l’export de ses GPU en Chine ne servirait qu’à favoriser l’essor de GPU chinois. Or, c’est bien ce qui anime le fabricant Huawei. Celui-ci fournit déjà aux éditeurs locaux un GPU Ascend 910C totalisant 780 TFLOPS et 128 Go de mémoire HBM à 3,2 To/s. Il devrait leur proposer avant la fin de l’année son successeur, l’Ascend 920 totalisant 900 TFLOPS et une bande passante mémoire de 4 To/s.

« Quiconque ne tient pas compte de Huawei et de sa capacité de production est profondément naïf. Il dispose à présent d’un véritable savoir-faire dans la conception et aussi dans la fabrication de puces (...) Le fait qu’il y parvienne après y avoir travaillé depuis moins longtemps que Nvidia en dit long sur sa persévérance », vient ainsi de déclarer le PDG de Nvidia à nos confrères de CNBC et du média chinois Global Times, qui l’ont interviewé dans le cadre de sa visite en Chine.

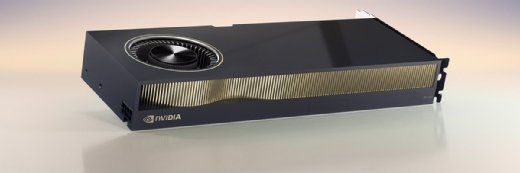

À date, on ignore encore les caractéristiques du GPU simplement baptisé RTX Pro que Nvidia compte également exporter en Chine. Dans son catalogue, les GPU RTX Pro 6000 et 5000 correspondent à ses derniers GPU Blackwell, mais disposant de moins de cœurs et d’une mémoire GDDR (96 et 48 Go, respectivement) moins performante que la mémoire HBM. Nvidia présente ses cartes RTX Pro comme plus adaptées à l’inférence.