Puces IA : dix fournisseurs proposent une alternative à Nvidia

La demande actuelle pour des GPU menace de dépasser les capacités de production de Nvidia. Selon leurs besoins, les entreprises peuvent se tourner vers dix autres fournisseurs.

Il n’est pas certain que Nvidia puisse à lui seul fournir toutes les puces nécessaires aux ambitions des États, des hyperscalers et des entreprises en matière d’intelligence artificielle. En revanche, il existe à l’heure actuelle dix autres fournisseurs qui développent des puces d’accélération pour l’IA. Ces puces ne sont pas toutes isofonctionnelles avec celles de Nvidia, mais il est probable que ce ne soit pas un problème pour une majorité des cas d’usage.

Les GPU Nvidia H100, H200 et désormais B100 ou B200 sont conçus pour entraîner des modèles d’IA, puis pour exécuter les modèles qu’ils ont entraînés. Cette exécution de l’IA, dite inférence, comprend des applications comme l’IA générative et la reconnaissance de motifs, que ce soit à partir de bandes audio, d’images, de vidéos, de métriques financières, etc.

Or, selon les analystes, c’est à présent le marché de l’inférence qui devrait le plus se développer. Au-delà des datacenters privés, ce cas d’usage devrait également occuper une grande part des ressources de calcul des mégaprojets étatiques et chez les hyperscalers. La bonne nouvelle est qu’il existe à présent des puces pour l’IA alternatives à celles de Nvidia et que, si elles ne sont pas toutes taillées pour l’entraînement, elles sont en revanche souvent meilleur marché pour l’inférence.

Voici ci-dessous les dix principaux fabricants de puces d’IA qui ont déjà lancé leurs offres sur le marché. Ils sont ici listés par ordre alphabétique.

Alphabet (Google)

Alphabet, la société mère de Google et de son cloud public GCP, a mis au point la puce Trillium, anciennement Tensor Processing Unit (TPU). Comme les GPU Hopper (H100/H200) et Blackwell (G100/G200) de Nvidia, elle sert à entraîner de grands modèles de langage dans un premier temps, puis à l’inférence dans un second temps.

Cette puce n’est toutefois pas achetable. Elle ne peut être utilisée qu’à partir de GCP, qui en conserve l’exclusivité. Elle garantit à Google que son cloud public aura toujours de la puissance IA à fournir à ses clients même s’il ne peut plus s’approvisionner en GPU Nvidia. GCP permet de constituer des pods, c’est-à-dire des clusters de calculs virtuels, où 256 Trillium travaillent ensemble. La dernière évolution de la puce Trillium est la v6e, lancée en octobre 2024.

Google s’est aussi lancé dans la conception de son propre processeur, l’Axios, une puce à base de cœurs ARM Neoverse V1. Toutefois, Google se garde bien de présenter l’Axios comme une puce d’IA, préférant dire qu’il s’agit juste d’une alternative moins énergivore aux processeurs x86 d’Intel et AMD.

Il est à noter que Google est par ailleurs très investi dans l’ordinateur quantique. Son cloud GCP donne à présent accès au processeur quantique de 105 qubits qu’il a mis au point, le Willow. Toutefois, il n’est pas encore certain qu’un processeur quantique soit utilisable pour les tâches d’intelligence artificielle. L’intérêt d’un processeur quantique est d’éviter tous les tests de condition dans un programme (les instructions « if… » en programmation), tandis que l’intérêt des GPU est d’exécuter très rapidement les fonctions trigonométriques qui servent à collecter des informations dans une matrice de connaissances.

AMD

Outre ses processeurs, AMD est le fournisseur de puces pour serveurs qui a sans doute l’offre GPU la plus proche de celle de Nvidia. Fin 2023, il lançait son GPU MI300X pour rivaliser avec le H100 de Nvidia. Fin 2024, il a mis sur le marché son GPU MI325X qui, cette fois, tient tête au Nvidia H200 dans les tests de performance MLPerf, mais moyennant une dissipation thermique supérieure. Ces GPU sont d’ores et déjà intégrés à des serveurs chez HPE et Dell.

Cette année, AMD devrait lancer un MI355X gravé avec une finesse de 3 nm qui éliminerait ces problèmes de températures. On ignore à ce stade si ce nouveau MI355X – dont la disponibilité se situerait durant l’été 2025 – rivalisera de performances avec les GPU Nvidia B100 et B200 commercialisés en même temps.

Côté processeurs, les Epyc d’AMD brillent par leur très grand nombre de cœurs qui sont très utiles pour exécuter un maximum d’applications dans un minimum d’espace en datacenters. Pour autant, l’absence d’un accès à une grande quantité de mémoire très rapide ne favorise en rien les Epyc pour l’inférence. En effet, si les GPU H100/H200 et MI300X/MI325X restent si utiles à l’inférence, ce n’est pas pour leur nombre de cœurs, mais pour la grande quantité de mémoire HBM (quasiment aussi rapide que la mémoire cache) qu’ils embarquent.

Apple

Les Mac d’Apple seraient de plus en plus utilisés pour l’inférence d’appoint. Leur avantage ? Leurs processeurs Silicon Mx (d’architecture ARM) intègrent dans la même puce toute la RAM de la machine et une grande quantité de cœurs optimisés pour l’inférence. Techniquement, cette intégration évite énormément de pertes de cycles pour accéder aux données. Par conséquent, c’est sur ces machines que sont apparus en premier les outils Open source d’inférence comme ML Studio et Ollama. Ces outils permettent d’installer localement un LLM pour l’interroger.

Face à ce succès inattendu, Apple réfléchirait à présent à une version serveur de son processeur, dans laquelle la RAM ne serait plus de la LPDDR, mais de la mémoire HBM aussi rapide que la mémoire cache. Comme les GPU haut de gamme de Nvidia et AMD. Cette puce, codéveloppée avec Broadcom, pourrait arriver sur le marché en 2026.

AWS

AWS a été le premier hyperscaler à songer à créer ses propres processeurs, les Graviton, pour ne plus dépendre des fournisseurs Intel et AMD. À présent, il dispose aussi de ses propres GPU : les Trainium, capables de rivaliser avec les GPU haut de gamme de Nvidia, et les Inferentia, dédiés à l’inférence.

L’avantage d’utiliser des puces d’AWS est que leur usage coûte 50 % moins cher que l’usage de processeurs x86 ou de GPU Nvidia, à puissance égale. L’inconvénient est que ces puces ne sont en revanche utilisables que depuis des machines virtuelles qui fonctionnent depuis le cloud public d’AWS.

AWS donne toutefois accès à des configurations très haut de gamme, une machine virtuelle Trn2 pouvant embarquer jusqu’à 16 GPU Trainium2, contre un maximum de 8 GPU H100 (similaires) dans un serveur d’appoint. En pratique, les serveurs physiques d’AWS n’embarquent réellement que deux GPU, mais AWS prétend que le réseau NeuronLink, qu’il a mis au point pour relier ses serveurs, est similaire au bus PCIe interne d’un serveur en matière de bande passante.

Cerebras

La startup Cerebras a développé une puce d’inférence pour le moins originale. Baptisée WSE, elle occupe toute la surface d’un wafer, soit 21,5 cm de côté dans sa forme carrée installée dans les serveurs ! Techniquement, l’intérêt de ce design est que les 84 cœurs communiquent entre eux sans aucune latence due aux interconnexions réseau et PCIe. Les 44 Go de mémoire qu’elle intègre sont par ailleurs d’autant plus rapides qu’il s’agit de la seule grande quantité de mémoire embarquée qui soit véritablement de la mémoire cache, c’est-à-dire gravée avec les cœurs.

Selon les tests de performance, la dernière version WSE-3 du processeur serait quinze fois plus rapide en inférence qu’un GPU H200 de Nvidia. Problème, mis à part quelques racks de serveurs que Cerebras a fabriqués lui-même à façon pour des centres de supercalcul, la puce WSE-3 n’est pas encore disponible chez les fabricants traditionnels de serveurs.

Le seul moyen de l’utiliser est pour l’heure de passer par le chatbot en ligne que Cerebras a mis en place et qui donne accès à une sélection de LLM dernier cri. Si ce service est disponible sans limitations depuis la France, il faut noter qu’il s’exécute sur le territoire des USA.

Groq

Fondée par l’ingénieur de Google qui a mis au point les GPU Trillium, la startup Groq (à ne pas confondre avec le LLM Grok d’Elon Musk) propose une puce GroqChip pour accélérer spécifiquement l’inférence. Dans ce domaine, la puce de Grok n’irait pas plus vite qu’un autre GPU, mais elle coûterait bien moins cher et consommerait en moyenne 16 fois moins d’énergie.

Si la startup fabrique bien elle-même une carte PCIe, elle ne propose plus sur site que des racks de serveurs qu’elle construit elle-même. En revanche, des fabricants d’équipements pour datacenters, dont HPE et Pure Storage, sont susceptibles de proposer des configurations embarquant l’accélérateur GroqChip.

IBM

IBM a développé une puce d’inférence baptisée Spire qui serait la plus douée du marché pour identifier des motifs dans un flot d’information. Plus précisément, la puce Spire est surtout vendue aux banques pour identifier en temps réel toute fraude dans un flot immense de transactions.

Le circuit Spire est livré sous deux formes. Il est soit intégré au processeur Telum II des mainframes z17 d’IBM lance en 2025, soit livré sous la forme d’une puce d’accélération qui en contient 32 exemplaires avec 128 Go de RAM LPDDR5 embarquée et qu’IBM commercialise sur une carte PCIe 5.0. À ce stade, il n’est toutefois pas certain que la carte PCIe Spire soit utilisable ailleurs que dans une machine d’IBM.

Spire devrait à terme évoluer en une puce NorthPole qui, selon IBM, battrait tous les records d’économie d’énergie.

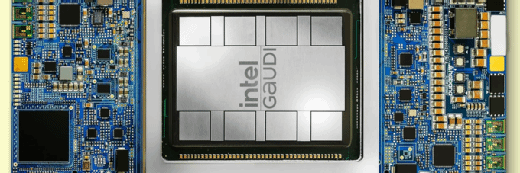

Intel

Comme AMD, Intel a lancé un GPU Gaudi3 censé rivaliser avec le H100 de Nvidia. Pour autant, cette puce ne semble pas avoir rencontré le succès escompté, puisque les fabricants de serveurs semblent préférer les MI300X d’AMD lorsqu’il s’agit de trouver une alternative aux GPU de Nvidia.

Fort de ce constat, Intel ne mettra pas sur le marché sa version suivante, connue sous le nom de code Falcon Shores. Mais il fournira tout de même les exemplaires qu’il avait déjà fabriqués à des centres de R&D pour développer tout un environnement logiciel, capable de rivaliser avec le kit Cuda de Nvidia. Le but est de préparer le mieux possible l’arrivée sur le marché, en 2026, de la puce Jaguar Shores (qui portera a priori le nom commercial Gaudi5).

Les pertes de part de marché d’Intel dans les datacenters au profit d’AMD, la mise à la retraite de son PDG Pat Gelsinger faute de résultats financiers satisfaisants et l’échec commercial de Gaudi3 suggèrent qu’Intel traverse une mauvaise passe dont on ne sait s’il se relèvera. D’autant que les rumeurs de son rachat, par Broadcom et d’autres, courent toujours.

Pour autant, Intel arrive au bout d’une longue période de préparatifs pour rattraper son retard technologique. Ses usines avec un procédé de gravure 18A (nom commercial censé faire penser à 18 angströms, soit 1,8 nanomètre) n’atteignent peut-être pas encore la finesse de gravure possible dans les usines de TSMC, mais leur étonnante capacité à graver des wafers des deux côtés pourrait produire en 2026 des puces moins énergivores dans toutes les catégories. Si tel est le cas, les puces d’Intel présenteront, face à la concurrence, l’avantage de coûter moins cher en électricité dans les datacenters. Or, cette question est centrale dans les projets de méga-usines d’IA.

Il est à noter qu’Intel a, comme Apple, proposé des processeurs qui embarquent dans leur puce la mémoire RAM de la machine hôte, gage de fortes accélérations pour l’inférence. Les modèles concernés sont le Xeon 4 Max (2023), avec mémoire HBM pour serveurs de supercalcul, et le Core Ultra 200V (lancé fin 2024) pour PC portables. Mais la quantité limitée de mémoire proposée (64 Go sur le Xeon Max, 16 ou 32 Go sur le Core Ultra 200V) a semble-t-il suffisamment déçu le public pour qu’Intel évoque ne plus réitérer l’aventure sur de futurs modèles.

Qualcomm

Longtemps cantonné aux processeurs ARM pour appareils mobiles, Qualcomm est celui qui a le mieux imité le modèle d’Apple d’un processeur ARM pour PC embarquant des cœurs d’accélération pour l’inférence et sa propre RAM. En 2024, il a ainsi lancé le SnapDragon X pour exécuter directement des LLM sur un poste local.

Fort de ce succès, Qualcomm a mis au point un GPU Cloud AI 100 qui bat le H100 de Nvidia dans les mesures de performances sur l’inférence. Il est aussi plus économique en énergie. Par exemple, le Cloud AI 100 parvient à traiter 227 prompts par watt contre 108 pour le H100 et à détecter 3,8 motifs par watts contre 2,4 pour le H100.

Tenstorrent

La startup Tenstorrent, fondée par les ingénieurs qui ont conçu les cœurs Zen des processeurs AMD, a mis au point les puces Wormhole n150 et n300 dédiées à la reconnaissance de motifs. Cependant, ces puces ne sont pour l’heure disponibles que dans les serveurs Galaxy que Tenstorrent fabrique lui-même.

Et Nvidia ?

Nvidia fournit à l’heure actuelle 98 % des GPU pour datacenters présents sur le marché. Après le succès de ses GPU H100 et H200, qui auraient cumulé 2 millions d’exemplaires vendus en 2024, Nvidia doit commercialiser en 2025 les B100 et B200 de la nouvelle génération Blackwell. Leur avantage est qu’elles seraient quatre fois plus puissantes que les précédentes pour une consommation similaire. Leur inconvénient est qu’elles coûteront vraisemblablement dans les 40 000 dollars l’unité et que leur production ne suffira pas à combler toutes les demandes.

À l’instar de GCP et d’AWS, Nvidia développe aussi son propre processeur ARM, le Grace, et tend à vouloir de plus en plus l’imposer avec ses GPU, notamment via une configuration préassemblée qui comprend un processeur Grace et deux GPU.

La génération censée succéder à Blackwell devrait porter le nom de Rubin. Les GPU R100 et R200 qui en découlent devraient être disponibles sur le marché entre fin 2026 et début 2027.