sdecoret - stock.adobe.com

Les 15 techniques les plus populaires de la data science

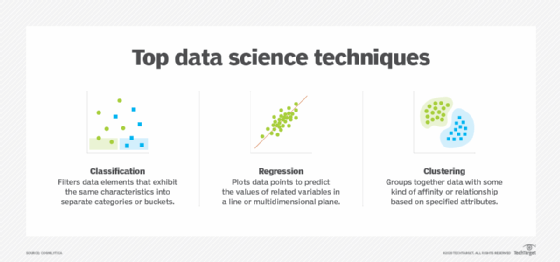

Les data scientists exploitent une variété de techniques statistiques et analytiques pour tirer de la valeur des jeux de données. Voici 15 méthodes de classification, de régression et de clustering.

La data science s’est imposée dans de nombreuses entreprises. Le data scientist est l’un des rôles les plus recherchés par les organisations désormais « data driven ». Les applications de data science reposent sur des technologies telles que le machine learning et les capacités du Big Data. Elles doivent extirper des données un flot d’indicateurs, et ouvrir le champ des possibles en se basant sur des analyses prédictives, de la reconnaissance d’objets et d’images ou encore le traitement du langage naturel.

Les études tendent à démontrer une nouvelle réalité. Les entreprises qui n’investissent pas suffisamment dans l’analyse des données seront bientôt laissées sur le bord de la route par des concurrents qui en tirent des avantages commerciaux importants.

Mais que font exactement les data scientists pour fournir des bénéfices si transformateurs ? Le champ d’expertise qui est le leur repose sur un ensemble d’éléments clés : la compilation d’approches statistiques et mathématiques pour extraire avec précisions des mesures pertinentes ; des techniques et des algorithmes qui facilitent l’exploitation de larges volumes de données ; des méthodologies pour étudier les informations d’un point de vue scientifique ; et de l’ingénierie, des outils, qui peuvent (entre autres) aider à convertir des quantités importantes de données dans les formats adéquats pour en tirer des indicateurs.

Comment la data science identifie des relations entre les données

Les data scientists cherchent une aiguille dans une botte de foin. Plus spécifiquement, ils doivent discerner comment les différents éléments de données entrent en corrélation ou en relation les uns avec les autres. Par exemple, si vous avez des points répartis sur un graphique, comment en tirez-vous du sens ?

Les données représentent peut-être un lien entre deux ou plusieurs variables. Le travail consiste alors à tracer une sorte de ligne ou de plan multidimensionnel qui décrit le mieux cette relation. Ou peut-être représentent-elles des clusters groupés qui ont une certaine affinité. D’autres données pourraient dépeindre différentes catégories.

En trouvant ces corrélations, nous conférons un sens aux données au lieu de nous laisser aveugler par leur apparence aléatoire. Une fois cette tâche effectuée, elles peuvent être analysées et visualisées afin de prodiguer aux dirigeants des indicateurs pour prendre des décisions ou planifier des stratégies.

Dans cet article, nous brossons un portrait des techniques statistiques et analytiques les plus couramment utilisés par les data scientists. Certaines d’entre elles sont les héritières directes de siècles de recherche en mathématiques et en statistiques. D’autres s’avèrent relativement nouvelles et tirent parti de travaux publiés ces trente dernières années en matière de machine learning, de deep learning et d’autres formes d’analytique avancée.

Techniques de classification

Avec les problèmes de classification, les data scientists cherchent à répondre à la question suivante : « À quelle catégorie appartiennent ces données ? ».

Il y a de multiples raisons qui poussent ces chercheurs à tenter de ranger ces éléments dans des cases. Si une image représente un texte manuscrit peut-être voulez-vous reconnaître les lettres ou les nombres qu’elle contient. Ou bien ces documents proviennent de dossiers de demande de prêts et vous souhaitez savoir s’il faut les trier dans les processus « approuvé » ou « refusé ». D’autres cas d’usage pourraient intimer aux data scientists de déterminer automatiquement le traitement adéquat pour un patient ou encore d’identifier des spams dans une boîte mail.

Voici les algorithmes et les techniques les plus utilisés pour classifier les données :

Arbres de décision. Il s’agit d’une structure logique ramifiée issue des arbres de paramètres et de valeurs générés par un ordinateur pour répertorier les données dans des catégories définies.

Classification naïve bayésienne. En s’appuyant sur une approche probabiliste, les classificateurs bayésiens peuvent aider à ranger les données dans des groupes simples.

Machines à vecteurs de support (Support Vector Machine ou SVM). Les SVM aussi appelés séparateurs à vaste marge sont utilisés pour dissocier les données en tirant une ligne qui traverse un plan (axes x et y). L’on calcule la distance entre la frontière (le tracé) et les échantillons (données) les plus proches de façon à optimiser le placement de cette ligne séparatrice et donc mieux classer les données, par exemple discerner un visage humain d’une gueule d’un animal.

Méthode des k plus proches voisins (Key Nearest Neighbors - KNN). Cette technique d’apprentissage supervisé s’appuie sur un procédé simple de décision paresseuse pour identifier à quelle catégorie un point de données appartient, en fonction des classes voisines les plus proches dans un data set. KNN est notamment déployé pour la reconnaissance de formes.

Régression logistique. Elle repose sur l’idée d’ajuster les données à une ligne pour distinguer les différentes catégories de chaque côté de cette séparation. La régression logistique dépend d’un modèle binaire. C’est-à-dire que le tracé est formé de telle sorte que les données sont déplacées vers une catégorie ou une autre plutôt que d’autoriser des corrélations plus fluides. Ici, l’analyse est qualitative, la régression logistique permet de noter les échantillons.

Réseaux de neurones. Il est possible de recourir à des réseaux de neurones artificiels de deep learning avec de multiples couches sous-jacentes. Ils ont démontré de profondes capacités de classification quand ils sont appliqués à de grands volumes de données.

Les techniques de régression

Et si, au lieu d’essayer de savoir dans quelle catégorie se situent les données, vous vouliez connaître la relation entre les différents points. L’idée principale de la régression est de répondre à la question : « Quelle est la valeur prévue pour ces données ? ».

Certaines techniques employées pour la classification, tel que les arbres de décision, les SVM et les réseaux de neurones peuvent également être utilisés pour effectuer des régressions. Il existe d’autres approches plus spécifiques. Les voici :

Régression linéaire. Cette méthode est l’une des plus populaires en data science. Ce modèle doit permettre de trouver la relation linéaire (la ligne) qui correspond le mieux aux données analysées en se basant sur la corrélation entre deux variables.

Lasso (ou régression lasso). Lasso est l’acronyme pour « least absolute shrinkage and selection operator ». Cette méthode statistique de contraction des coefficients de la régression améliore la précision des modèles de régression linéaire en exploitant un sous-ensemble de données.

Régression multiple (ou régression linéaire multiple). Cela implique différentes façons de trouver des lignes ou des plans, qui correspondent à plusieurs dimensions de données contenant potentiellement de nombreuses variables.

Techniques de clustering et d’associations de données

Cet ensemble de techniques entend répondre à la question suivante : « comment ces données forment-elles des groupes et à quels clusters elles appartiennent ? ». Les data scientists cherchent à discerner des clusters connexes qui partagent diverses caractéristiques communes. Le but, obtenir des informations utiles pour les applications analytiques.

Place aux procédés les plus adaptés aux regroupements de données.

K-moyennes (K-means). Il s’agit d’un algorithme non supervisé de clustering permettant de déterminer un certain nombre de grappes dans un jeu de données et de distinguer les « centroïdes » qui localisent les différents clusters, les points de données étant attribués au groupe le plus proche.

Décalage moyen (Mean Shift clustering). Autre procédé de regroupement basé sur les centroïdes, il peut être utilisé séparément ou pour améliorer les résultats de k-means en déplaçant les centroïdes désignés.

DBSCAN. Raccourci pour « Density-Based Spatial Clustering of Applications with Noise », DBSCAN est une autre technique pour découvrir des clusters qui reposent sur des approches plus avancées de mesure de la densité pour effectuer le partitionnement de données.

Modèle de mélange gaussien (Gaussian Mixture Model-GMM). Les modèles de mélange gaussien doivent aider à trouver des groupes via la distribution de variables aléatoires modélisées sous la forme d’une somme de plusieurs gaussiennes au lieu de considérer les données comme des points singuliers.

Regroupement hiérarchique. Similaire à un arbre de décision, cette technique utilise une approche hiérarchique et ramifiée pour localiser des grappes.

L’étude de règles d’association (association analysis en VO) est une technique connexe, mais distincte. Il s’agit de lister des modalités d’association qui décrivent les similarités entre les points de données. Comme pour le clustering, nous cherchons à trouver les groupes auxquels les données appartiennent. Cependant, dans ce cas précis, il s’agit de déterminer quand les points de données se retrouveront ensemble, plutôt que d’identifier leur groupe d’appartenance. Ici, on mesure le degré d’association entre les données : il ne s’agit plus de les séparer dans des ensembles distincts.

Les cas d’usage les plus répandus

Les méthodes, techniques et algorithmes susmentionnés font partie de la boîte à outils du data scientist. Leur utilisation dépend des problèmes qu’il doit résoudre et des données à disposition. Ce spécialiste doit être capable de convertir un objectif en une question : « ai-je besoin d’appliquer une régression, d’une classification ou d’un regroupement ? » – et adopter la meilleure approche algorithmique pouvant donner les réponses souhaitées compte tenu des caractéristiques des données.

C’est un procédé scientifique. Il ne s’agit pas d’appliquer des règles strictes, rapides à mettre en place, mais d’itérer, d’explorer pour trouver la bonne solution.

Cette boîte à outils permet tout de même de s’attaquer à un large éventail d’applications. Voici les cas d’usages les plus courants.

Détection d’anomalies. Si vous pouvez trouver le motif de données qui représente une situation « normale », vous pouvez aussi trouver les points de données en dehors des clous. Des entreprises de divers secteurs tels que la finance, la santé, la distribution ou le manufacturing utilisent régulièrement des méthodes de data science pour identifier des anomalies et détecter des fraudes, de la surveillance IT, de la cybersécurité, etc. Cette phase de repérage peut être également mise à contribution pour éliminer des valeurs aberrantes dans des jeux de données, afin d’améliorer des modèles prédictifs.

Classification binaire et multiclasse. L’une des principales applications des techniques de classification consiste à déterminer si une chose appartient ou non à une catégorie particulière. Cette forme binaire peut avoir des usages pratiques pour identifier une facture dans un lot de documents grâce à la reconnaissance d’images. Avec l’approche multiclasse, l’objectif est de ranger des fichiers ou des informations dans plusieurs catégories. Par exemple, le US Bureau of Labor Statistics [l’Insee américain N.D.L.R.], classifie automatiquement les accidents du travail.

Personnalisation. Les organisations qui cherchent à personnaliser les interactions avec leurs clients, ou leur recommander des produits et services, doivent d’abord les rassembler par le biais de groupes de données ayant des caractéristiques communes. Une approche efficace de la data science permet d’adapter les sites web, les offres marketing et autres, aux besoins et préférences spécifiques des individus. Les entreprises recourent à des technologies telles que les moteurs de suggestion et les systèmes d’hyperpersonnalisation qui sont pilotés par la mise en correspondance des données avec les profils détaillés des consommateurs.

Ce n’est là qu’un échantillon des applications utiles de la data science. En comprenant les différentes techniques, méthodes, outils et approches analytiques, les data scientists peuvent aider les entreprises qui les emploient à obtenir les avantages stratégiques et concurrentiels déjà maîtrisés par certains de leurs compétiteurs.