Qumulo chasse sur les terres d'Isilon avec sa technologie NAS en cluster

Lors qu'un tour de start-ups en Californie, LeMagIT a récemment fait le point avec Qumulo sur sa technologie de stockage NAS en cluster. L'occasion également de discuter de ses mérites face au stockage objet et de faire le point sur le développement de la firme en Europe.

LeMagIT a récemment rencontré les dirigeants de Qumulo, une société fondée par deux des principaux développeurs de OneFS, le système de fichiers d’Isilon, Neal Fachan et Peter Godman. L'occasion pour nous de faire le point plus en détail sur la technologie de stockage NAS en clusterde la firme

La firme est devenue un repère d’anciens d’Isilon, puisqu’elle est dirigée par Bill Richter, l’ex-patron de la division Isilon d’EMC et que sa vice-présidente des opérations n’est autre que Mary Godwin, l’ancienne patronne des opérations d’Isilon. Le directeur des ventes, Eric Scolard, était précédemment patron des ventes d’Isilon, etc.

Qumulo a récemment débuté la commercialisation de ses systèmes en Europe. La firme a implanté son QG européen en Allemagne en recrutant Stefan Radtke, l’ex-CTO Europe d’Isilon au poste de directeur technique, et Thore Rabbe, ex-vice-président EMEA de Dell EMC au poste de directeur général EMEA.

En Angleterre, la firme a constitué une équipe commerciale dirigée par Nick Connor (ex-Panasas, Clustrix, DDN et Infinidat) et elle serait en train de recruter une équipe pour la France. Toutes ces équipes auront pour mission d’accélérer la commercialisation de la technologie en Europe. Elles devront aussi travailler avec HPE avec lequel Qumulo a noué un accord mondial pour la revente de sa technologie sur les nœuds HPE Appolo 4200.

Un focus sur la performance

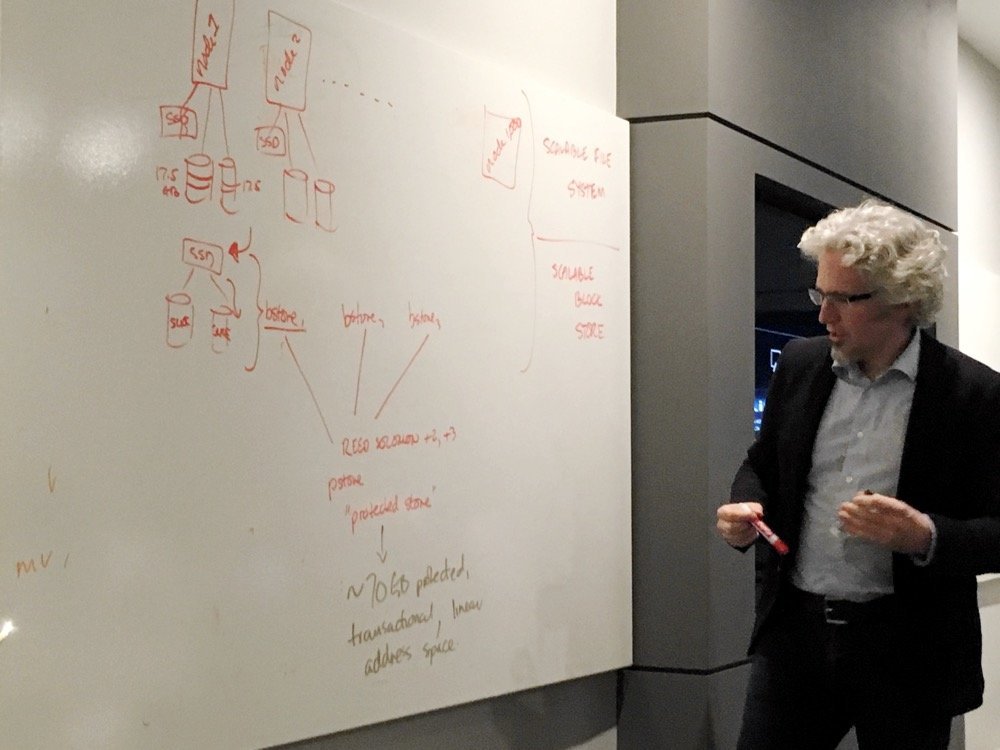

Peter Godman, CTO et cofondateur de Qumulo, détaille l'architecture du système de fichiers de la firme

Peter Godman, CTO et cofondateur de Qumulo, détaille l'architecture du système de fichiers de la firme

Qumulo a développé son propre système de fichiers en cluster, qu’il a baptisé QSFS. Ce système de fichiers s’appuie sur un cœur OS Ubuntu et s’exécute en mode utilisateur, à la fois pour des raisons de performances et pour des raisons de fiabilité. Les services essentiels de QSFS fonctionnant comme des processus utilisateurs et étant redondants, ils peuvent être mis à jour et redémarrés sans impact sur la production. Le fait de s’exécuter en mode utilisateur limite aussi les risques de corruption mémoire.

QSFS fournit un ensemble de services avancés comme le support de NFS et SMB, la réplication continue entre clusters (en mode asynchrone), le support des snapshots et des quotas, ainsi que des fonctions analytiques avancées (complétées par un service analytique en cloud).

Pour développer son système, Qumulo s’est attaqué à certains des problèmes fondamentaux qui affectent la performance des systèmes de fichiers distribués. Le filesystem maison sépare ainsi nettement les métadonnées des fichiers en les gérant dans une base de données ad hoc, QumuloDB. Cette approche a pour but d’éviter l’effondrement des performances du filesystem lorsqu’il faut gérer des milliards et des milliards de fichiers.

Comme l’explique Peter Godman, parcourir un filesystem massif pour une opération aussi simple que le calcul de la taille des répertoires peut prendre des heures, voire des jours sur un système comme Isilon. Il faut en effet parcourir l’intégralité de l’arborescence du système de fichiers pour accéder aux métadonnées liées aux fichiers pour agréger les données. Avec QumuloDB, cela n’est plus nécessaire. Un simple « query » suffit pour obtenir l’information, la base stockant l’intégralité des métadonnées associées aux fichiers ainsi que l’historique des opérations sur ces fichiers.

Scale-out NAS vs stockage objet

Interrogé sur la concurrence éventuelle des systèmes de stockage objet, Godman a affirmé sa conviction que les systèmes de stockage objet ne pourront jamais remplacer efficacement les systèmes de fichiers distribués pour la fourniture de services NFS ou SMB.

S’il convient que les systèmes de stockage objet ont trouvé leur marché, il estime qu’ils ne peuvent pas répondre aux besoins d’utilisateurs nécessitant des services de fichiers performants et à grande échelle. Il pointe du doigt les problèmes de latence et de cohérence que posent les systèmes de stockage objet pour la fourniture de services SMB ou NFS.

Il note aussi qu’aucun système objet ne supporte l’équivalent de commandes POSIX essentielles comme rename() ou link(), qui permettent respectivement de renommer un fichier (ou un répertoire) et de créer un lien symbolique. Ce support doit donc être artificiellement greffé dans les passerelles développées par les fournisseurs de systèmes de stockage objet lorsqu’ils veulent fournir des services NAS. Et ce genre de hack tue les performances.

Un autre argument en faveur de Qumulo est son usage “intelligent” des SSD. Dans un cluster Qumulo, des disques flash sont présents dans tous les nœuds pour fournir un cache performant en lecture, mais surtout pour accueillir en première intention l’ensemble des opérations d’écriture (les données écrites sont ensuite regroupées puis transférées vers des disques plus lents en fonction des politiques définies). À l’instar de ce que réalise WAFL, le système de fichiers de NetApp, ce mécanisme d’écriture à plusieurs étages permet d’optimiser les performances en n’écrivant que de façon séquentielle sur les disques durs (il est à noter que dans le cas des noeuds All-Flash, des disques "write intensive" sont utilisés pour le cache en écriture, tandis que des disques SATA économiques sont mise en oeuvre pour le stockage capacitif).

Des services de fichiers avancés au-dessus d’un système de stockage en mode bloc distribué

Si QSFS est bien un système de fichiers distribué, il s’appuie sur une brique de stockage distribué en mode bloc (SBS ou Scalable Block Store) qui sert de fondement au stockage des données du service de fichiers distribué en mode fichiers. Ce « SBS » a pour mission principale d’assurer la protection des données sur les disques.

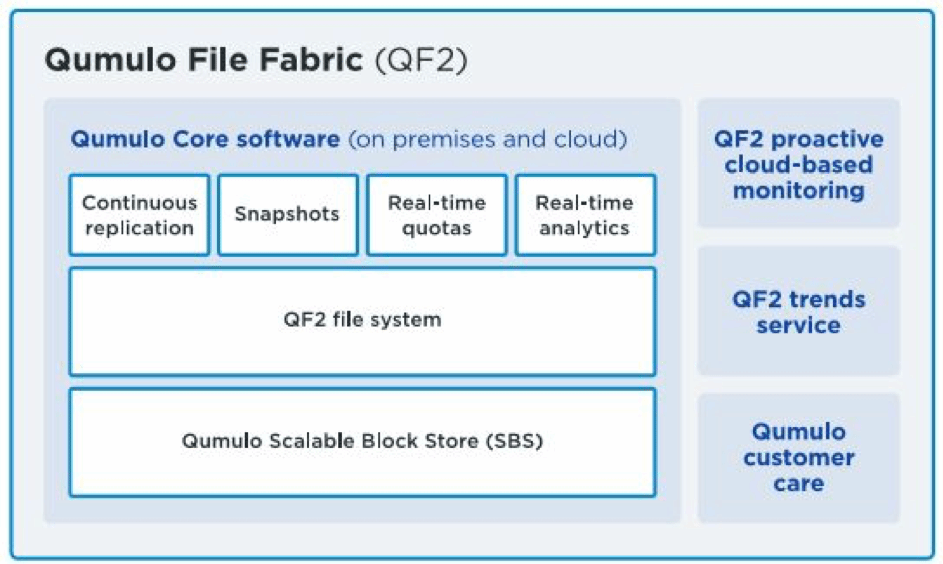

Architecture de la technologie Qumulo File Fabric

Architecture de la technologie Qumulo File Fabric

Chaque disque d’un système Qumulo est découpé en tranches de 17,5 Go puis ces tranches sont agrégées au sein de ce que la firme appelle un PStore (protected store) via un mécanisme d’erasure coding (6,4), qui nécessite un minimum de quatre noeuds pour initialiser un cluster. Ce mécanisme utilise la librairie d’accélération Intel ISA-L. Dans le cloud Amazon, Qumulo s’appuie alors sur la redondance native d’Elastic Block Store, le service de stockage en mode bloc d’Amazon et utilise un mécanisme de type (5,4), ce qui permet par exemple de déployer un service Qumulo sur AWS avec un seul nœud (contre un minimum de quatre pour une installation on-premises).

Le système de stockage en mode blocs bâti par Qumulo est conçu pour permettre une reconstruction rapide des données en cas de perte de nœud ou de disque. Il ne faut au pire que quelques heures pour reconstruire un nœud là où d’autres systèmes peuvent demander des jours, explique Godman. Surtout, comme la reconstruction s’effectue au niveau bloc, la performance de reconstruction n’est pas affectée par la taille des fichiers et est aussi efficace avec des petits qu’avec de gros fichiers.

Enfin, et ce n’est pas forcément intuitif, le retour à un état d’intégrité total est d’autant plus rapide que le nombre de nœuds dans le cluster est élevé. Les opérations de reconstruction sont en effet parallélisées.

Un premier pied dans le cloud

Une nouveauté récente est la possibilité d’avoir un filesystem massif distribué réparti entre on-premise et cloud, ce que la firme appelle QF2 ou Qumulo File Fabric. Il ne s’agit toutefois pas à proprement parler d’un système de fichiers unique. La technologie de l’éditeur permet en fait d’opérer plusieurs clusters autonomes et de les gérer comme un seul.

QF2 permet de déployer la technologie de Qumulo en mode cloud hybride

QF2 permet de déployer la technologie de Qumulo en mode cloud hybride

Qumulo met en œuvre un mécanisme de réplication continue en mode asynchrone qui permet de répliquer des fichiers d’un cluster à un autre. Cela permet par exemple à une société réalisant des calculs de rendu 3D, de répliquer des données locales vers le cloud pour y lancer des calculs en tirant parti des capacités de provisioning rapide de serveur dans le cloud.

Contrairement à des acteurs comme Avere ou Panzura, Qumulo ne promet pas la cohérence entre cloud et on-premises. La cohérence de données est garantie au sein de chaque cluster, mais les données ne sont qu’éventuellement cohérentes à l’échelle de la fabrique cloud (le temps que la réplication de données s’effectue). Cette approche satisfera toutefois sans doute la plupart des besoins.

Qumulo propose un mécanisme de facturation à la capacité, aussi bien dans le cloud qu’on-premises. Cela signifie que les licences sont transférables d’une plate-forme à l’autre et qu’elles incluent l’accès aux moutures les plus récentes du logiciel.

Un intérêt croissant pour les systèmes de fichiers distribués

Il est à noter que Qumulo n’est pas le seul à s’intéresser au marché du stockage de fichiers distribué. Au cours des deux dernières années, on a ainsi observé une renaissance des travaux autour des systèmes de fichiers distribués, un secteur historiquement dominé par des acteurs comme IBM (GPFS/Spectrum Scale) ou Lustre dans le monde HPC et par NetApp (clustered OnTap) ou Isilon dans le monde de l’entreprise.

En Israël, on peut par exemple noter les travaux d’Elastifile et de Weka.IO (qui ont respectivement signé des accords de distribution avec Dell EMC et HPE). En France, Rozo Systems a développé un système de fichier distribué séduisant en s’appuyant sur son savoir-faire original en matière de codes à effacement. Enfin, on peut aussi noter la conversion récente de Quantum au NAS, avec l’ajout de fonctions NAS distribuées à sa technologie StorNext, qui motorise ses baies Xcellis.