Puces IA : la Chine ne veut plus de Nvidia

Dans la guerre économique qui l’oppose aux USA, la Chine a décidé de ne plus dépendre des GPU américains, d’autant que son champion Huawei a désormais des solutions pour développer ses IA. Nvidia accuse le coup.

La Chine n’achètera plus de GPU à Nvidia. Tel est l’ordre que vient de donner Pékin à ses entreprises, dans le contexte d’un bras de fer économique avec les USA. Ces derniers interdisaient de toute façon à la Chine d’accéder aux puces les plus puissantes. Quant à celles incapables d’entraîner des IA, l’administration Trump avait choisi d’en augmenter le prix, en prélevant une taxe de 15 % sur leurs ventes. Interviewé par le Financial Times, Jensen Huang, le patron de Nvidia, dit sobrement prendre acte de ce rebondissement qui relève, dit-il, d’un « agenda plus large entre les deux pays [que le simple cas de Nvidia] ».

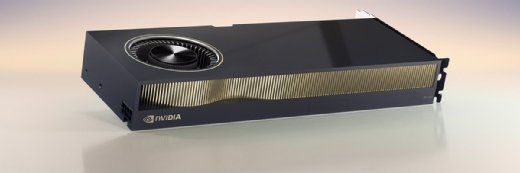

L’affaire est sans doute bien plus préoccupante pour Nvidia que son dirigeant veut bien l’admettre. Le constructeur a déjà fait fabriquer les nouvelles puces RTX Pro 6000D (anciennement B20) que plusieurs entreprises chinoises – dont le cloud Alibaba – devaient lui acheter par dizaines de milliers d’exemplaires au prix unitaire d’environ 8 000 dollars. Au moins pour exécuter des IA déjà entraînées.

Il n’est pas certain que Nvidia parvienne facilement à recycler ces GPU sur le marché occidental, où il propose déjà des RTX Pro 6000 au même prix, mais trois fois plus puissants, car non soumis aux restrictions américaines.

La Chine a une alternative : Huawei

La décision du gouvernement chinois est motivée, d’une part, par le fait que son constructeur local Huawei est désormais en mesure de fournir des GPU capables d’entraîner et d’utiliser l’IA. Ses actuels Ascend 910C sont près de trois fois plus performants que la puissance supposée des RTX Pro 6000D et ses prochains Ascend 920 devraient l’être davantage.

Surtout, les puces de Huawei supportent d’être déployées en 384 exemplaires dans les clusters de calcul. Cela les rend capables d’entraîner des IA 1,7 fois plus rapidement que ne le font les meilleurs clusters DGX occidentaux. Eux sont basés sur un maximum de 72 très puissants GPU B200 de Nvidia.

D’autre part, Pékin avait déjà fait savoir qu’il ne tolérait plus qu’on lui réserve des puces au rabais pour développer son IA. Après que l’administration Trump a levé l’embargo sur les précédents GPU H20 de Nvidia en juillet, en déclarant que ces puces bridées avaient pour seule vocation « de rendre les développeurs chinois accros à la technologie américaine », la Chine a finalement donné l’ordre de ne plus les importer.

Avant ces déconvenues, la Chine représentait 13 % des revenus de Nvidia, soit 17 milliards de dollars sur les 130 mds $ de son chiffre d’affaires 2024. Lors de la publication de ses résultats financiers du second trimestre de cette année, Jensen Huang expliquait même au média CNBC que le marché des puces IA pour la Chine devrait croître rapidement, qu’il pourrait à très court terme peser 50 mds $ par an.

Un moment compliqué pour Nvidia

Plus tôt cette semaine, le gouvernement chinois remettait aussi en cause la légalité du rachat de Mellanox par Nvidia en 2019. À l’époque, la Chine avait accepté de valider cette fusion à la condition que Nvidia continue de lui vendre ses puces. Ce que le gouvernement américain ne lui permet plus librement de faire. Les contrôleurs de Mellanox sont à la base des solutions réseau de Nvidia qui permettent à ses GPU de communiquer à pleine vitesse. Notamment via le protocole GPUdirect, essentiel pour éviter le goulet d’étranglement du processeur hôte.

Nvidia semble traverser une mauvaise passe. Dans le même temps, aux USA, deux de ses plus grands clients, les fournisseurs de services de calcul en ligne CoreWeave et Lambda, ont renégocié les contrats pour que Nvidia leur rembourse les GPU inutilisés.

Dans le premier cas, Nvidia doit louer tous les mois, jusqu’en avril 2032, la puissance de calcul que CoreWeave n’a pas réussi à commercialiser. Selon Reuters, cette location doit coûter à minima à Nvidia 6,3 milliards de dollars. Dans le second cas, Nvidia s’engage à louer jusqu’en 2029, pour une facture totale évaluée à 1,5 milliard de dollars, la puissance de calcul de plusieurs serveurs DGX qu’il a précédemment vendus à Lambda. La raison de ces montages financiers n’est pas claire.

Enfin, le média The Information croit savoir que Nvidia serait sur le point de cesser la commercialisation de son propre service de calcul en ligne, DGX Cloud. En cause, un soupçon grandissant de concurrence déloyale de la part des hyperscalers qui achètent à Nvidia des GPU et des serveurs pour vendre des services similaires. En mai dernier, Nvidia avait tenté de calmer les esprits en lançant le service de courtage DGX Cloud Lepton qui proposait de revendre leur puissance de calcul sous sa marque. Mais celui-ci n’aurait servi qu’à renforcer leur grogne. Les hyperscalers reprocheraient à l’entreprise de Jensen Huang de chercher ainsi à court-circuiter la relation directe avec leurs clients.

Même s’il reste le premier fournisseur de GPU pour l’IA, Nvidia est désormais concurrencé par AMD et ses GPU Instinct MI350X, lesquels auraient un meilleur rapport puissance/prix.

Pour approfondir sur Hardware IA (GPU, FPGA, etc.)

-

![]()

Puces IA : les GPU de Nvidia encore autorisés puis interdits en Chine

-

![]()

IA sur Kubernetes : les analystes épinglent la CNCF face à l’hégémonie de Nvidia

-

![]()

AMD et Nvidia reverseront 15 % de leurs revenus engrangés en Chine à l’Administration américaine

-

![]()

IA : Huawei dévoile son cluster de calcul rival de Nvidia