MarekPhotoDesign.com - stock.ado

8 enjeux éthiques à considérer dans le développement logiciel

À mesure que les logiciels s’imposent dans tous les aspects de l’expérience humaine, les développeurs ont une responsabilité éthique envers leurs clients. Découvrez comment assumer cette responsabilité.

Les logiciels n’ont pas toujours eu un impact direct sur la vie quotidienne, et le rythme de développement était lent. Désormais, les logiciels sont présents dans pratiquement tous les aspects de la vie. L’intelligence artificielle, le big data et l’analytique ont tous des répercussions réelles sur les individus.

Les développeurs de logiciels travaillent principalement en coulisses. Néanmoins, leurs décisions au cours d’un projet peuvent avoir un impact considérable, pour le meilleur ou pour le pire, en matière de conformité, d’équité, d’intégrité et de confiance. Tous les acteurs du secteur doivent être conscients des enjeux sociaux et éthiques liés au développement de logiciels.

Voici quelques exemples de questions éthiques et la manière dont les développeurs peuvent les aborder.

1. Design addictif

Tous les développeurs aspirent à créer des programmes que les gens adorent utiliser. Le problème, c’est que certaines équipes conçoivent des applications que les gens aiment trop. Le rôle des plateformes numériques, telles que les réseaux sociaux, soulève des questions éthiques.

Des critiques tels que Tristan Harris, du Center for Humane Technology, affirment que les éditeurs de réseaux sociaux tirent profit de l’indignation, de la confusion, de la dépendance et de la dépression, mettant ainsi en péril notre bien-être et notre démocratie. L’avis de M. Harris est notamment devenu viral alors qu’il travaillait chez Google, avec une présentation sur la promotion d’une conception technologique addictive (à ne pas confondre avec la conception additive, N.D.L.R.) et la responsabilité morale des entreprises dans la société.

Trouver un équilibre éthique entre les produits que les consommateurs adorent et ceux qui détournent leur attention relèvent davantage de l’art que de la science. Lors de la création et de la mise à jour de produits, posez-vous les questions suivantes :

- Qui en bénéficie ?

- Comment en bénéficient-ils ?

- Dans quelle mesure en bénéficient-ils ?

- Existe-t-il des garanties pour la santé et la santé mentale des utilisateurs ?

- Dans quelle mesure la monétisation et la collecte et l’utilisation des données clients, notamment par le biais de l’IA et de machine learning, sont-elles manifestes ? Ces pratiques sont-elles transparentes ?

David K. Bain, directeur général et fondateur du Technology Integrity Council, cite les exemples en apparence opposés de Duolingo et de TikTok. Ces deux applications génèrent de la croissance et des revenus pour leurs créateurs, mais la nature des avantages qu’elles apportent aux utilisateurs est différente.

Les clients de Duolingo acquièrent des compétences linguistiques et sont mis au défi par des activités qui favorisent la croissance neuronale et la plasticité cérébrale. Les utilisateurs de TikTok obtiennent une gratification immédiate grâce à des contenus vidéo qui inondent le cerveau de neurotransmetteurs enivrants.

Les deux applications ont des attitudes différentes envers les limites d’utilisation destinées à protéger contre l’addiction. Duolingo encourage la régularité et affirme avec force que son utilisation est liée à des courbes d’apprentissage optimisées. Duolingo incite clairement les usagers à atteindre leur quota quotidien et à maintenir leurs performances. Mais une fois les activités quotidiennes terminées, Duolingo les libère. En revanche, TikTok incite les siens à rester avec un buffet quasi illimité de médias consommables.

Les applications comprennent souvent des techniques de manipulation des utilisateurs, des méthodes de monétisation, la collecte de données utilisateur à des fins commerciales et des algorithmes de machine learning visant à les améliorer. Un éditeur d’applications transparent donnerait aux utilisateurs un certain niveau de connaissance et de compréhension de ces pratiques.

Voici comment cet aspect éthique se traduit dans les deux exemples d’applications : « Les utilisateurs de Duolingo sont clairement des victimes consentantes d’un régime quotidien imposé, mais ils ne sont certainement pas conscients que les publicités et les données d’utilisation sont reliées à un écosystème publicitaire beaucoup plus vaste », poursuit M. Bain. « Je suis persuadé que les utilisateurs de TikTok, en particulier les plus jeunes, ignorent largement et joyeusement les méthodes et les conséquences de leur addiction. »

2. Propriété douteuse des données personnelles

Le traitement par l’IA des données biométriques et autres données contextuelles sur les clients s’est imposé. Les systèmes modernes peuvent établir le profil des utilisateurs et prédire leurs comportements avec un niveau de détail effrayant.

« En général, la question éthique est de savoir quoi faire de ces données », explique Miguel Lopes, directeur produit chez TrafficGuard, une plateforme de vérification publicitaire et de prévention de la fraude. Cette question éthique est un dilemme pour les développeurs de tous les types d’entreprises, et pas seulement pour les géants des réseaux sociaux.

Un algorithme dirige la collecte d’informations et la création de profils, mais les actions qui en découlent sont intentionnelles. Le développeur est généralement conscient du pouvoir de ces données dans leur contexte.

L’une des causes profondes des préoccupations éthiques concerne la manière dont l’entreprise génère des revenus et motive les développeurs et les responsables commerciaux, selon Miguel Lopes. Dans de nombreux cas, les entreprises considèrent les données des utilisateurs comme précieuses et souhaitent les monétiser. « Ces facteurs peuvent amener ces organisations à partager les données de leurs utilisateurs de manière contraire à l’éthique », considère-t-il.

Les développeurs sont confrontés à une décision difficile. Doivent-ils concevoir des systèmes permettant d’exploiter les données des utilisateurs en sachant que la responsabilité incombe à l’organisation ? Ou doivent-ils faire part de leurs préoccupations, mais s’exposer à des sanctions pour avoir contrevenu aux objectifs du projet ?

Ces préoccupations ont suscité des débats dans les entreprises où M. Lopes a travaillé. Elles ont décidé de ne pas proposer de services « Freemium ». « Nous avons analysé les implications et préférons soutenir nos activités en vendant nos services plutôt que les données de nos utilisateurs, et ne pas soumettre notre équipe de développeurs à ces choix difficiles », avance-t-il.

La transparence interne au sein des entreprises est un facteur crucial. Les développeurs doivent être conscients du contexte global du projet sur lequel ils travaillent, et pas seulement du module qu’ils doivent réaliser. Les organisations doivent permettre aux développeurs d’exprimer facilement leurs préoccupations. Le service des ressources humaines pourrait mettre en place des mécanismes leur permettant d’exprimer leurs inquiétudes sans crainte de représailles. Par exemple à travers une ligne d’assistance anonyme. L’organisation devrait ensuite assurer un suivi et déterminer de manière indépendante si le cas d’usage enfreint les politiques en matière de confidentialité, de conformité ou d’éthique.

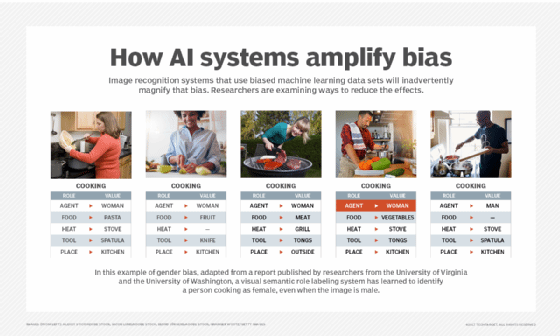

3. Biais algorithmique

Outre ces considérations, « l’un des problèmes éthiques les plus urgents auxquels sont confrontés les développeurs aujourd’hui est celui des biais », affirme Spencer Lentz, directeur de compte chez Pegasystems, un spécialiste de l’automatisation des flux de travail.

Les biais s’introduisent souvent dans le système sans être détectés. Spencer Lentz les compare à des virus. Les ordinateurs eux-mêmes n’ont pas de cadre moral inhérent. Les logiciels ne peuvent que refléter les préjugés de leurs créateurs. Par conséquent, les développeurs et les data scientists doivent tenter de les éliminer des données d’entraînement et des algorithmes qu’ils créent.

Les rapports et les recherches menées ces dernières années montrent comment les biais inhérents aux systèmes logiciels peuvent perpétuer le racisme systémique à l’encontre de certaines populations, ce qui entraîne une perte d’opportunités, une détérioration des soins médicaux et une augmentation des taux d’incarcération. Par exemple, dans son ouvrage « Race After Technology », Ruha Benjamin s’inquiète d’un cas où les développeurs n’ont pas pris en compte les voix des personnes d’origine africaine dans l’entraînement des algorithmes de reconnaissance vocale, partant du principe que peu d’entre elles utiliseraient l’application.

Les dirigeants, les data scientists et les développeurs doivent créer une culture organisationnelle qui établit des lignes directrices éthiques et encourage les individus à tous les niveaux de l’entreprise à s’exprimer s’ils constatent un problème.

« Désormais, la notion de biais dans l’IA est tellement connue que le concept d’hallucination des LLM est largement compris », constate Peter Wang, directeur de l’IA et de l’innovation et cofondateur d’Anaconda, une plateforme de data science. « Le plus grand risque aujourd’hui est que les gens soient tellement pris par l’engouement et la peur de prendre du retard qu’ils ne prennent pas le temps de mettre en place des mécanismes d’évaluation et de gouvernance rigoureux ».

« Le secteur tout entier doit être plus transparent sur les taux d’échec élevés des projets d’IA en entreprise, afin que les dirigeants et les cadres ne se sentent pas obligés de précipiter des enjeux extrêmement importants tels que l’alignement, la précision et la sécurité », souligne-t-il.

Il est temps de créer un organisme de réglementation pour les fournisseurs d’IA, similaire à l’Association médicale américaine pour les médecins, fait valoir M. Wang. Cet organisme pourrait établir des lignes directrices éthiques et de bonnes pratiques à l’échelle du secteur. « Ces technologies sont encore relativement nouvelles dans le contexte commercial, et nous aurions tous intérêt à adopter des normes éthiques issues de notre intelligence collective, plutôt que de laisser chaque individu ou organisation décider par lui-même », avance-t-il.

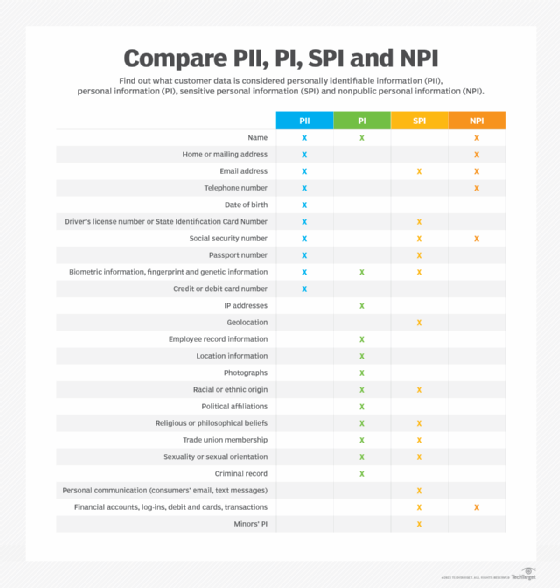

4. Faiblesse de la sécurité et de la protection des informations personnelles identifiables (PII)

Au-delà des biais, rares sont les équipes de développeurs formés à la sécurité « by design ».

« L’accent est presque entièrement mis sur la mise sur le marché d’un produit », explique Randolph Morris, fondateur et architecte logiciel principal chez Bit Developers, une société de conseil en développement logiciel. Une fois qu’un logiciel est disponible au public, l’attention se porte sur les nouvelles fonctionnalités et l’optimisation des performances, de sorte que la sécurité continue d’occuper un intérêt minime.

Les cyberattaquants causent des dommages réels à de vraies personnes. Une approche réactive de la cybersécurité, qui consiste à corriger les vulnérabilités au fur et à mesure qu’elles sont découvertes, n’est ni pratique ni pragmatique.

Pour assumer cette responsabilité éthique en matière de sécurité des clients, les développeurs ont besoin d’être formés, mais généralement, seuls les cours spécifiques à la cybersécurité abordent ces sujets. Pour commencer, sensibilisez votre équipe aux failles de cybersécurité, telles que la violation historique des données médicales gérées par l’assureur Anthem en 2015, où les informations personnelles des patients étaient stockées en texte clair. « Si ces informations avaient été chiffrées, elles n’auraient pas été aussi faciles à utiliser et aussi précieuses à diffuser », rappelle Randolph Morris.

De plus, le secteur a besoin de normes de sécurité révisées. Les organisations peuvent faire davantage pour adopter des normes visant à protéger les informations personnelles et confidentielles. La norme de sécurité des données de paiement PCI DSS et la loi HIPAA pour les applications de santé constituent un bon début, mais les développeurs devraient également prendre en compte d’autres formes d’informations, ainsi que les patterns applicatifs qui les protègent mieux.

5. Privilégier les fonctionnalités plutôt que l’impact

Au cœur de nombreuses questions éthiques se trouve la décision consistant à privilégier les fonctionnalités plutôt que leurs effets.

« Si l’équipe de développement est évaluée sur le nombre de nouvelles fonctionnalités, il y a de fortes chances que l’éthique d’une implémentation donnée ne soit pas une priorité, que ce soit lors de la phase de conception ou lors de la phase d’implémentation », explique Tim Mackey, responsable de la stratégie de gestion des risques liés à la chaîne logistique logicielle chez Black Duck, une plateforme de sécurité des applications.

L’entreprise elle-même doit donner le ton en matière de normes éthiques. Voici quelques moyens permettant d’y parvenir :

- Intégrer les priorités éthiques tout au long du cycle de vie du logiciel, de la conception à l’exploitation.

- Former le personnel aux choix éthiques tels que l’octroi de licences et l’utilisation de logiciels open source.

- Former les développeurs, les architectes, les testeurs et les autres membres de l’équipe logicielle aux pratiques de gestion des données conformes à la réglementation et aux attentes des clients.

Les développeurs ne suivent pas toujours l’actualité des dernières mesures législatives dans les juridictions où les clients utilisent leurs logiciels, note M. Mackey, mais l’entreprise doit s’assurer qu’ils sont informés.

La collaboration entre les responsables techniques et les équipes juridiques peut aider à éviter les lacunes éthiques. Par exemple, l’entreprise doit se concentrer sur l’accès aux données personnelles des clients et leur conservation. Les contrôles d’accès aux données et les mécanismes d’enregistrement sont activés au moment de la mise en œuvre du logiciel. Les développeurs, chargés de créer un produit fonctionnel et convivial, peuvent considérer ces restrictions d’accès comme relevant de la responsabilité d’une autre équipe. Au contraire, veillez à ce que la protection des données soit une fonctionnalité intégrée dès la conception d’une application, « by design ».

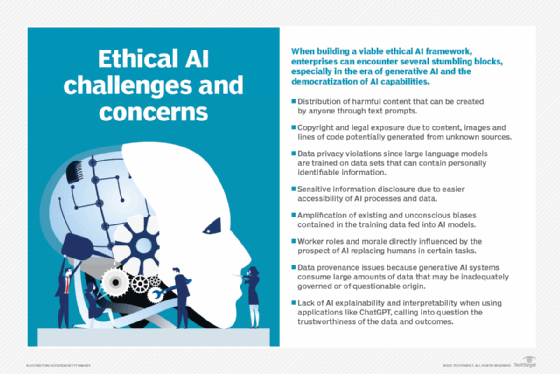

6. Le mirage de la transparence de l’IA

Les grands modèles de langage jouent un rôle croissant dans le développement de logiciels pour des tâches telles que la génération de code et le traitement de données non structurées. En raison de la complexité des LLM, il est facile de négliger la manière dont ces systèmes sont entraînés, configurés et déployés, ainsi que ce que cela implique pour les utilisateurs.

« Les éditeurs de logiciels devraient toujours divulguer la manière dont ils constituent leurs moteurs d’IA », souligne Miguel Lopes. « La manière dont les données des utilisateurs sont collectées, souvent à leur insu, puis intégrées aux LLM, soulève de sérieuses questions concernant le consentement, la sécurité et les limites éthiques de l’automatisation. »

« Nous avons vu des entreprises collecter des données comportementales sans consentement, transformant ainsi les utilisateurs en contributeurs non rémunérés aux modèles mêmes qui pourraient un jour remplacer leur emploi », poursuit-il.

Un agent IA nécessite une configuration approfondie, une supervision et des humains talentueux, donc aux salaires élevés. « Les coûts que vous pensez économiser en négligeant un développement adéquat sont presque toujours éclipsés par les dommages causés par un agent mal spécialisé, qu’il s’agisse de risques de sécurité, de désinformation ou de perte de confiance des clients », martèle M. Lopes.

7. Impact environnemental

Les préoccupations relatives à l’impact environnemental de diverses activités ne cessent de croître, alimentées par une prise de conscience accrue des effets de l’activité humaine sur le changement climatique.

Selon l’ADEME, l’empreinte carbone du numérique représente 4 % des émissions GES dans le monde en 2024. Si cette portion reste faible par rapport à d’autres secteurs, l’agence française, comme son homologue l’AIE (Agence Internationale de l’Énergie), constate un « emballement » provoqué par l’IA générative. L’IAE prévoirait une hausse de 75 % de la consommation électrique des data centers d’ici à 2026.

Si beaucoup des moyens pour freiner cet emballement consistent à rallonger la durée de vie des équipements, qu’ils soient des serveurs ou des smartphones, les développeurs ont aussi leur part de responsabilité. Selon Greenly, les plus grands réseaux sociaux, dont TikTok, pollueraient autant que certains pays européens.

Cette responsabilité s’exerce dans leurs usages des LLM lors du développement et de l’architecture de leurs systèmes, dans l’écoconception de solutions logicielles qui utilisent la juste quantité de ressources, dans le choix de langage moins énergivore, dans l’optimisation de leur code, dans le choix des régions cloud où ils déploient leurs instances.

D’autres aspects incluent le risque que les nouvelles applications logicielles encouragent des choix environnementaux néfastes. Une application éphémère pourrait générer des revenus au détriment d’une augmentation des déchets.

8. Impact social et sur les droits de la personne

Les multiples dimensions à prendre en compte, pour évaluer l’impact des pratiques de développement logiciel sur les droits de la personne, comprennent leurs effets potentiels sur les activités économiques et sociales des individus.

Sur le plan du travail, l’une des préoccupations concerne la multiplication des ateliers dits « d’étiquetage de données », qui expose ces travailleurs à des contenus toxiques afin d’améliorer la modération des systèmes d’IA. Bien que la plupart des entreprises ne soient pas directement impliquées dans ce processus, elles peuvent négliger les procédés de leurs fournisseurs et sous-traitants en matière d’IA et de systèmes de données.

De plus, il est essentiel de prendre en compte les impacts potentiels de l’optimisation des applications pour des aspects relativement faciles à quantifier, tels que le rendement des entrepôts, par rapport à ceux qui sont plus difficiles à dénombrer, comme la santé ou le bien-être mental des travailleurs. Le risque est que certains types de maximisation de la productivité puissent avoir des effets négatifs sur la vie de ces personnes.

Quelques principes pour le développement éthique de logiciels

Voici plusieurs moyens de favoriser des pratiques ayant un impact positif sur la société :

Proactivité. Soyez curieux de connaître l’impact et le contexte des choix en matière d’ingénierie logicielle sur le développement éthique de logiciels et le monde en général.

Honnêteté. Réfléchissez à la manière dont les choix en matière d’ingénierie logicielle peuvent entrer en conflit avec les principes éthiques, même si cela vous met mal à l’aise personnellement ou que cela dérange l’entreprise.

Responsabilité. Identifiez des moyens d’évaluer et de communiquer sur les questions éthiques au sein de l’entreprise, afin de vous assurer que tout le monde est sur la même longueur d’onde.

Équilibrez la responsabilité sociale et les compétences techniques. N’oubliez pas que les développeurs peuvent aider à contextualiser l’impact des choix techniques sur les considérations éthiques pour d’autres rôles au sein de l’entreprise.