Datacenters : Cisco veut tout casser avec l'Unified Computing System

Cisco a officiellement présenté hier sa stratégie Unified Computing et a levé le voile sur sa gamme de serveurs x86 UCS 5100. S'appuyant sur un partenariat étroit avec VMware et BMC, Cisco entend simplifier l'administration des grands datacenters virtualisés et accélérer l'adoption des architectures convergentes Ethernet qu'il appelle de ses voeux.

Cisco a officiellement levé le voile hier sur sa stratégie en matière de datacenter et a présenté son premier châssis pour serveurs lames à base de processeurs x86, l'UCS 5100 (Unified Computing System 5100). L'entrée de Cisco sur le marché des serveurs était attendue depuis plusieurs mois et elle vient couronner près de trois ans de travaux sur la virtualisation des datacenters. De fait, le lancement des serveurs lames de Cisco ne se fait pas dans le vide : Il s'appuie sur des recherches menées depuis près de trois ans par l'équipe issue du rachat de Nuova, notamment en matière de réseaux convergents, ainsi que sur les travaux effectués en commun avec VMware sur la commutation Ethernet en environnements virtuels.

Une architecture complète pour les datacenters virtualisés

C'est donc une architecture complète pour les datacenters virtualisés que Cisco a présenté hier, dans la grande tradition des plans en cinq ou six étapes habituellement présentés par le géant des réseaux lors des grandes occasions. Comme nous le pressentions dans un article récent, l'objectif de Cisco est de fournir une plate-forme complète incluant les éléments serveurs, réseau ainsi que les composants d'administration nécessaires pour opérer un datacenter virtualisé à grande échelle. Pas n'importe quel datacenter virtualisé toutefois : Si ses serveurs fonctionneront avec Hyper-V ou XenServer, le futur vSphere de VMWare sera l'hyperviseur privilégié, du fait des développements effectués en commun par les deux sociétés sur la commutation réseau en environnement virtuel (notamment la technologie VN-Link et le commutateur virtuel distribué Nexus 1000V). De même, Ethernet sera la couche transport unique dans les serveurs Cisco. Pas de Fibre Channel ni d'InfiniBand. L'objectif est ici d'utiliser Ethernet comme la couche transport convergente pour l'ensemble des besoins de connectivité.

Ces choix radicaux pourront être critiqués, mais ils ont le mérite de la cohérence et de la simplicité. Libre ensuite aux entreprises de s'en satisfaire ou d'opter, si elles jugent la solution Cisco trop propriétaire ou du moins trop "intéressée", pour des solutions plus traditionnelles et plus génériques chez les constructeurs de serveurs comme Dell, HP, IBM ou Sun.

Un châssis pour serveurs lames simplifié

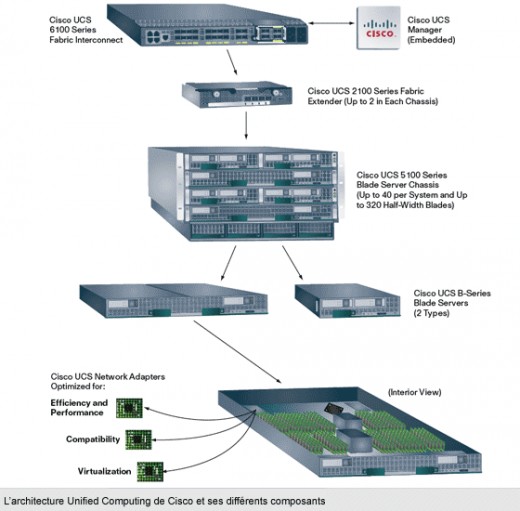

L'architecture conçue par Cisco est largement influencée par l'historique réseau de la société. Ainsi, lorsque l'on analyse de près son architecture, chaque élément peut être vu comme un élément réseau. Au point même que l'administration ne se fait pas dans les châssis mais depuis un point d'administration inséré dans un commutateur externe – mais nous y reviendrons un peu plus tard. Pour assurer une mobilité totale des machines virtuelles et de leurs paramètres entre serveurs, l'architecture de Cisco s'évertue aussi à maintenir un domaine de commutation unique reliant l'ensemble des éléments physiques (serveurs) et logiques (VM). Le tout pouvant s'étendre à un maximum de 40 châssis serveurs au sein d'un datacenter.

Ces choix techniques ont des conséquences sur l'architecture des châssis et des serveurs présentés par le géant des réseaux. Ainsi, le châssis UCS 5100 est simplifié à l'extrême de même que les lames UCS-B. Ces dernières peuvent accueillir un ou deux processeurs Nehalem EP et deux cartes Ethernet convergentes au format mezzanine. Parmi ces adaptateurs réseaux figurent une carte d'origine Intel implémentant le support de FCOE de façon logicielle et deux CNA (Converged Network adapters) signés Qlogic ou Emulex. Ces choix ne sont pas anodins : les trois cartes sont celles que Cisco a certifié pour son commutateur virtuel VMware, le Nexus 1000V. Une dernière carte réseau devrait faire son apparition fin 2009 ou début 2010 et implémentera la technologie VN-Link (co-développée par Cisco et VMware et proposée à l'IEEE comme standard) en matériel. Elle sera à même de taguer les flux réseaux des VM et travaillera de concert avec les commutateurs Nexus pour permettre la mobilité des machines virtuelles. Elle permettra aussi de minimiser l'impact des entrées/sorties sur les performances des serveurs. Cette carte et son support de VN-Link, permettront de se passer du commutateur virtuel Nexus 1000V et de maintenir un domaine de commutation de bout en bout jusqu'aux VM.

Si fondamentalement les lames Cisco ne sont que des lames x86 traditionnelles, le constructeur Cisco a toutefois veillé a intégrer une innovation, à savoir une technologie d'extension de mémoire qui devrait permettre de multiplier par un facteur de quatre la capacité mémoire des lames. Cisco reste très discret sur cette technologie, mais elle rappelle étrangement la technologie Scalable Memory Buffer développée par Intel pour ses serveurs Itanium, celle la-même qui a justifié le report des puces Tukwila à l'été. Il ne serait pas surprenant que Cisco ait décliné la technologie Intel pour l'appliquer aux serveurs à base de puces Nehalem à moins qu'il ne s'agisse encore d'un développement issu des travaux de Nuova. Cette aptitude à gérer de grands volumes de mémoire sera bien sûr précieuse en environnements virtuels mais elle pourrait aussi séduire certains grands comptes ou opérateurs télécoms pour des applications décisionnelles ou des bases de données en mémoire.

Une infrastructure de connexion convergente basée sur la technologie des commutateurs Nexus

Les lames et les châssis de Cisco, s'ils constituent la principale nouveautés de l'annonce, ne sont toutefois qu'un élément d'un ensemble. Et en l'occurrence, l'élément indispensable pour assurer la souplesse et la flexibilité d'administration des environnements virtuels promises par Cisco est la présence d'un étage de commutation assuré par un commutateur convergent baptisé UCS6100 Series. Ce commutateur est en fait dérivé d'un Nexus 5000 mais s'en démarque par la présence d'un composant baptisé UCS Manager qui est en fait un agent de management et un point de contrôle capable de piloter jusqu'à 10 châssis lames UCS.

L'UCS Manager permet depuis un point unique d'obtenir les informations sur l'ensemble des éléments du châssis mais aussi d'éxécuter des opérations en n'importe quel point des éléments gérés. L'UCS Manager est pilotable au travers d'une API XML publiée par Cisco et qui est pour l'instant notamment utilisée par BMC qui a développé une suite d'administration spécifiquement conçue pour les châssis de Cisco. Cette suite, vient compléter les outils d'administration basiques fournis par le constructeur. Notons toujours au chapitre réseau que l'UCS6100 peut être étendu au niveau du châssis par le rajout de modules de commutation baptisés UCS 2100. Ces modules sont à l'UCS 6100 ce que les Nexus 2000 sont au Nexus 5000, c'est à dire une extension. L'ensemble UCS 6100 + UCS 2100 est physiquement un commutateur réparti, mais est considéré comme une entité logique unique.

L'intérêt de l'architecture définie par Cisco est que l'ensemble de ses éléments opèrent dans un domaine de commutation de niveau 2 uniforme, au sein duquel les machines virtuelles peuvent être déplacées de façon transparente avec leur profil associé. Ce profil inclut des éléments techniques essentiels comme le paramétrage réseau, le niveau de firmware des cartes, le niveau des pilotes utilisés , les règles de sécurité...et il assure que la machine virtuelle déplacée le sera avec l'ensemble des paramètres techniques associés. Une forme de Stateless Computing, comme le décrit Bruno Dutriaux, le Business Developpement Manager de Cisco sur la gamme UCS.

Il est à noter que le service Profile associé à une VM peut être défini de façon collaborative entre les équipes réseaux et systèmes de l'entreprise, chacun définissant les règles la concernant dans le profile.

Un plein potentiel dans des environnements VMWare et Cisco

Si Cisco prêche l'ouverture pour sa nouvelle offre – de fait les UCS 5100 et UCS-B fonctionneront sous XenServer, Hyper-V ou tout hyperviseur Linux – la gamme Unified Computing ne devrait dans un premier temps donner sa pleine mesure que sous VMWare du fait des co-développement effectués par les deux firmes dans le domaine de la commutation réseau en environnement virtuel. Le support du commutateur virtuel Nexus 1000 dans le futur vSphere et en effet la clé pour maintenir un domaine de niveau 2 unifié jusqu'aux machines virtuelles.

De même, Cisco ne cache pas son fort biais en faveur d'Ethernet comme technologie de commutation de niveau 2, un biais qui élimine l'accès direct en Fibre Channel aux lames. Il faudra donc en passer par FCOE ou par iSCSI ou un protocole NAS pour l'accès au stockage en réseau. D'où la présence dans l'architecture d'un commutateur convergent de classe Nexus, l'UCS 6100. Sans surprise, Cisco reste cohérent et vise avec VMware à solidifier son implantation dans les entreprises utilisant déjà ses technologies réseaux et la technologie d'hypervision de VMware.

Le constructeur a dès lors beau jeu de prêcher l'ouverture et la conformité aux standards (de fait) et il n'a pas tout a fait tord. Rien n'empêche en effet un client d'intégrer une infrastructure serveur non Cisco à une architecture Unified Computing. Il lui faut simplement pour cela équiper ses serveurs de cartes CNA Intel, Qlogic ou Emulex, installer le vswitch Nexus 1000 dans le futur vSphere, adopter FCOE comme protocole SAN et les commutateurs Nexus comme couche de transport unifiée de niveau 2. Bref la solution est ouverte pour peu que l'on accepte de recourir massivement aux technologies de VMware et Cisco et que l'on admette que la couche d'accès au SAN est FCOE.

Reste que certains concurrents n'entendent pas en rester là et préparent déjà leur réplique à l'offensive de Cisco. Juniper et IBM travaillent ainsi de concert sur le projet Stratus pour définir une nouvelle architecture de commutation pour les datacenter. Objectif là encore, offrir un domaine de commutation unique à grande échelle pour assurer la mobilité des machines virtuelles à l'échelle du datacenter voire à l'échelle d'un nuage de serveurs. Gageons qu'HP a dans ses tiroirs des idées similaires et que sa division Procurve ne laissera pas passer l'occasion de marquer quelques points en travaillant conjointement avec les concepteurs des Proliant pour riposter à Cisco.

La gamme UCS devrait être disponible en juin, mais aucun prix n'a pour l'instant été communiqué par Cisco. L'élément du prix devrait toutefois être déterminant si Cisco veut parvenir à s'insérer dans les datacenter face à des concurrents bien plus gros que lui sur le marché des serveurs et notamment Dell, HP, IBM et Sun...