Qu'est-ce que l'IA (intelligence artificielle) ? Définition, types, exemples et cas d'utilisation

L'intelligence artificielle (IA) est la simulation des processus de l'intelligence humaine par des machines, en particulier des systèmes informatiques. Elle comprend l'apprentissage, le raisonnement et l'autocorrection. Parmi les exemples d'applications de l'IA, on peut citer les systèmes experts, le traitement du langage naturel (NLP), la reconnaissance vocale, la vision artificielle et les outils génératifs tels que ChatGPT et Perplexity.

Alors que l'engouement pour l'IA s'accélère, les fournisseurs se précipitent pour promouvoir la manière dont leurs produits et services l'intègrent. Souvent, ce qu'ils appellent « IA » est une technologie bien établie, telle que l'apprentissage automatique.

L'IA nécessite du matériel et des logiciels spécialisés pour écrire et entraîner des algorithmes d'apprentissage automatique. Aucun langage de programmation n'est utilisé exclusivement dans l'IA, mais Python, R, Java, C++ et Julia sont tous des langages populaires parmi les développeurs d'IA.

Comment fonctionne l'IA ?

En général, les systèmes d'IA fonctionnent en ingérant de grandes quantités de données d'entraînement étiquetées, en analysant ces données pour trouver des corrélations et des modèles, et en utilisant ces modèles pour faire des prédictions sur des états futurs.

Par exemple, un chatbot IA alimenté par des exemples de texte peut apprendre à générer des échanges réalistes avec des personnes, et un outil de reconnaissance d'images peut apprendre à identifier et à décrire des objets dans des images en examinant des millions d'exemples. Les techniques d'IA générative, qui ont connu une avancée rapide au cours des dernières années, peuvent créer des textes, des images, de la musique et d'autres médias réalistes.

La programmation des systèmes d'IA se concentre sur des compétences cognitives telles que les suivantes :

- Apprentissage. Cet aspect de la programmation de l'IA consiste à acquérir des données et à créer des règles, appelées algorithmes, afin de les transformer en informations exploitables. Ces algorithmes fournissent aux appareils informatiques des instructions étape par étape pour accomplir des tâches spécifiques.

- Raisonnement. Cet aspect consiste à choisir l'algorithme approprié pour obtenir le résultat souhaité.

- Auto-correction. Cet aspect implique que les algorithmes apprennent et s'ajustent en permanence afin de fournir les résultats les plus précis possibles.

- Créativité. Cet aspect utilise des réseaux neuronaux, des systèmes basés sur des règles, des méthodes statistiques et d'autres techniques d'IA pour générer de nouvelles images, du texte, de la musique, des idées, etc.

Différences entre l'IA, l'apprentissage automatique et l'apprentissage profond

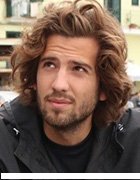

Les termes « IA », « apprentissage automatique » et « apprentissage profond » sont souvent utilisés de manière interchangeable, en particulier dans les supports marketing des entreprises, mais ils ont des significations distinctes. En bref, l'IA décrit le concept général de machines simulant l'intelligence humaine, tandis que l'apprentissage automatique et l'apprentissage profond sont des techniques spécifiques dans ce domaine.

Le terme « IA », inventé dans les années 1950, englobe un large éventail de technologies en constante évolution qui visent à simuler l'intelligence humaine, notamment l'apprentissage automatique et l'apprentissage profond. L'apprentissage automatique permet à un logiciel d'apprendre de manière autonome des modèles et de prédire des résultats en utilisant des données historiques comme input. Cette approche est devenue plus efficace grâce à la disponibilité de grands ensembles de données d'entraînement. L'apprentissage profond, un sous-ensemble de l'apprentissage automatique, vise à imiter la structure du cerveau à l'aide de réseaux neuronaux en couches. Il est à la base de nombreuses avancées majeures et récentes dans le domaine de l'IA, notamment les véhicules autonomes et ChatGPT.

Pourquoi l'IA est-elle importante ?

L'IA est importante en raison de son potentiel à changer notre façon de vivre, de travailler et de nous divertir. Elle a été utilisée efficacement dans le monde des affaires pour automatiser des tâches traditionnellement effectuées par des humains, notamment le service à la clientèle, la génération de prospects, la détection des fraudes et le contrôle qualité.

Dans plusieurs domaines, l'IA peut accomplir des tâches plus efficacement et avec plus de précision que les humains. Elle est particulièrement utile pour les tâches répétitives et minutieuses, telles que l'analyse d'un grand nombre de documents juridiques afin de s'assurer que les champs pertinents sont correctement remplis. La capacité de l'IA à traiter d'énormes ensembles de données permet aux entreprises d'obtenir des informations sur leurs opérations qu'elles n'auraient peut-être pas remarquées autrement. La gamme en pleine expansion des outils d'IA générative prend également de l'importance dans des domaines allant de l'éducation au marketing en passant par la conception de produits.

Les progrès réalisés dans le domaine des techniques d'IA ont non seulement contribué à une explosion de l'efficacité, mais ont également ouvert la voie à des opportunités commerciales totalement nouvelles pour certaines grandes entreprises. Avant la vague actuelle d'IA, par exemple, il aurait été difficile d'imaginer utiliser un logiciel informatique pour mettre en relation des passagers et des taxis à la demande, mais c'est précisément en faisant cela qu'Uber est devenue une entreprise classée au Fortune 500.

L'IA est devenue un élément central pour bon nombre des entreprises les plus importantes et les plus prospères d'aujourd'hui, notamment Alphabet, Apple, Microsoft et Meta, qui l'utilisent pour améliorer leurs opérations et devancer leurs concurrents. Chez Google, filiale d'Alphabet, par exemple, l'IA est au cœur de son moteur de recherche éponyme, et la société de voitures autonomes Waymo a vu le jour en tant que division d'Alphabet. Le laboratoire de recherche Google Brain a également inventé l'architecture Transformer qui sous-tend les récentes avancées en matière de traitement du langage naturel, telles que ChatGPT d'OpenAI.

Quels sont les avantages et les inconvénients de l'intelligence artificielle ?

Les technologies d'IA, en particulier les modèles d'apprentissage profond tels que les réseaux neuronaux artificiels, peuvent traiter de grandes quantités de données beaucoup plus rapidement et faire des prédictions plus précises que les humains. Alors que le volume considérable de données créées chaque jour submergerait un chercheur humain, les applications d'IA utilisant l'apprentissage automatique peuvent exploiter ces données et les transformer rapidement en informations exploitables.

L'un des principaux inconvénients de l'IA est le coût élevé du traitement des grandes quantités de données qu'elle nécessite. À mesure que les techniques d'IA sont intégrées dans un nombre croissant de produits et de services, les organisations doivent également être conscientes du risque que l'IA crée, intentionnellement ou non, des systèmes biaisés et discriminatoires.

Avantages de l'IA

Voici quelques avantages de l'IA :

- Excellence dans les tâches exigeant une grande attention aux détails. L'IA est particulièrement adaptée aux tâches qui consistent à identifier des modèles et des relations subtils dans des données qui pourraient échapper à l'œil humain. Par exemple, en oncologie, les systèmes d'IA ont démontré une grande précision dans la détection des cancers à un stade précoce, tels que le cancer du sein et le mélanome, en mettant en évidence les zones préoccupantes qui doivent faire l'objet d'une évaluation plus approfondie par les professionnels de santé.

- Efficacité dans les tâches impliquant un volume important de données. Les systèmes d'IA et les outils d'automatisation réduisent considérablement le temps nécessaire au traitement des données. Cela s'avère particulièrement utile dans des secteurs tels que la finance, l'assurance et la santé, qui impliquent un volume important de saisie et d'analyse de données de routine, ainsi que la prise de décisions basées sur les données. Par exemple, dans le secteur bancaire et financier, les modèles d'IA prédictifs peuvent traiter de grands volumes de données afin de prévoir les tendances du marché et d'analyser les risques liés aux investissements.

- Gain de temps et gains de productivité. L'IA et la robotique permettent non seulement d'automatiser les opérations, mais aussi d'améliorer la sécurité et l'efficacité. Dans le secteur manufacturier, par exemple, les robots alimentés par l'IA sont de plus en plus utilisés pour effectuer des tâches dangereuses ou répétitives dans le cadre de l'automatisation des entrepôts, ce qui réduit les risques pour les travailleurs humains et augmente la productivité globale.

- Cohérence des résultats. Les outils d'analyse actuels utilisent l'IA et l'apprentissage automatique pour traiter de grandes quantités de données de manière uniforme, tout en conservant la capacité de s'adapter à de nouvelles informations grâce à un apprentissage continu. Par exemple, les applications d'IA ont fourni des résultats cohérents et fiables dans le domaine de la révision de documents juridiques et de la traduction linguistique.

- Personnalisation et individualisation. Les systèmes d'IA peuvent améliorer l'expérience utilisateur en personnalisant les interactions et la diffusion de contenu sur les plateformes numériques. Sur les plateformes de commerce électronique, par exemple, les modèles d'IA analysent le comportement des utilisateurs afin de recommander des produits adaptés aux préférences de chacun, ce qui augmente la satisfaction et l'engagement des clients.

- Disponibilité 24 heures sur 24. Les programmes d'IA n'ont pas besoin de dormir ni de faire de pause. Par exemple, les assistants virtuels basés sur l'IA peuvent fournir un service client ininterrompu, 24 heures sur 24 et 7 jours sur 7, même en cas de volume d'interactions élevé, ce qui améliore les temps de réponse et réduit les coûts.

- Évolutivité. Les systèmes d'IA peuvent évoluer pour gérer des volumes croissants de travail et de données. L'IA est donc particulièrement adaptée aux scénarios dans lesquels les volumes de données et les charges de travail peuvent croître de manière exponentielle, comme la recherche sur Internet et l'analyse commerciale.

- Accélération de la recherche et du développement. L'IA peut accélérer le rythme de la R&D dans des domaines tels que l'industrie pharmaceutique et la science des matériaux. En simulant et en analysant rapidement de nombreux scénarios possibles, les modèles d'IA peuvent aider les chercheurs à découvrir de nouveaux médicaments, matériaux ou composés plus rapidement qu'avec les méthodes traditionnelles.

- Durabilité et conservation. L'IA et l'apprentissage automatique sont de plus en plus utilisés pour surveiller les changements environnementaux, prévoir les événements météorologiques futurs et gérer les efforts de conservation. Les modèles d'apprentissage automatique peuvent traiter des images satellites et des données de capteurs pour suivre, par exemple, les risques d'incendies de forêt, les niveaux de pollution et les populations d'espèces menacées.

- Optimisation des processus. L'IA est utilisée pour rationaliser et automatiser des processus complexes dans divers secteurs. Par exemple, les modèles d'IA peuvent identifier les inefficacités et prévoir les goulots d'étranglement dans les flux de travail de fabrication, tandis que dans le secteur de l'énergie, ils peuvent prévoir la demande en électricité et répartir l'approvisionnement en temps réel.

Inconvénients de l'IA

Voici quelques inconvénients de l'IA :

- Coûts élevés. Le développement de l'IA peut être très coûteux. La création d'un modèle d'IA nécessite un investissement initial important dans l'infrastructure, les ressources informatiques et les logiciels nécessaires pour former le modèle et stocker ses données d'apprentissage. Après la formation initiale, d'autres coûts liés à l'inférence et au réentraînement du modèle viennent s'ajouter. Par conséquent, les coûts peuvent rapidement grimper, en particulier pour les systèmes avancés et complexes tels que les applications d'IA générative. Le PDG d'OpenAI, Sam Altman, a déclaré que la formation du modèle GPT-4 de l'entreprise avait coûté plus de 100 millions de dollars.

- Complexité technique. Le développement, l'exploitation et le dépannage des systèmes d'IA, en particulier dans des environnements de production réels, nécessitent un savoir-faire technique considérable. Dans de nombreux cas, ces connaissances diffèrent de celles requises pour créer des logiciels non basés sur l'IA. Par exemple, la création et le déploiement d'une application d'apprentissage automatique impliquent un processus complexe, en plusieurs étapes et hautement technique, allant de la préparation des données à la sélection des algorithmes, en passant par le réglage des paramètres et les tests de modèles.

- Pénurie de talents. Outre la complexité technique, il existe une pénurie importante de professionnels formés à l'IA et à l'apprentissage automatique, alors que les besoins en compétences dans ce domaine ne cessent de croître. Cet écart entre l'offre et la demande de talents en IA signifie que, même si l'intérêt pour les applications d'IA ne cesse de croître, de nombreuses organisations ne parviennent pas à trouver suffisamment de travailleurs qualifiés pour mener à bien leurs initiatives en matière d'IA.

- Biais algorithmiques. Les algorithmes d'IA et d'apprentissage automatique reflètent les biais présents dans leurs données d'entraînement. Lorsque les systèmes d'IA sont déployés à grande échelle, ces biais s'amplifient également. Dans certains cas, les systèmes d'IA peuvent même amplifier les biais subtils présents dans leurs données d'entraînement en les codant dans des modèles renforçables et pseudo-objectifs. Dans un exemple bien connu, Amazon a développé un outil de recrutement basé sur l'IA pour automatiser le processus d'embauche, qui favorisait involontairement les candidats masculins, reflétant ainsi les déséquilibres entre les sexes à plus grande échelle dans le secteur technologique.

- Difficulté de généralisation. Les modèles d'IA excellent souvent dans les tâches spécifiques pour lesquelles ils ont été formés, mais ont du mal à faire face à des scénarios nouveaux. Ce manque de flexibilité peut limiter l'utilité de l'IA, car de nouvelles tâches peuvent nécessiter le développement d'un modèle entièrement nouveau. Un modèle NLP formé sur des textes en anglais, par exemple, pourrait être peu performant sur des textes dans d'autres langues sans une formation supplémentaire approfondie. Bien que des travaux soient en cours pour améliorer la capacité de généralisation des modèles (ce que l'on appelle l'adaptation de domaine ou l'apprentissage par transfert), cela reste un problème de recherche ouvert.

- Suppression d'emplois. L'IA peut entraîner des pertes d'emplois si les organisations remplacent les travailleurs humains par des machines, ce qui est une source de préoccupation croissante à mesure que les capacités des modèles d'IA deviennent plus sophistiquées et que les entreprises cherchent de plus en plus à automatiser leurs flux de travail à l'aide de l'IA. Par exemple, certains rédacteurs ont déclaré avoir été remplacés par des modèles linguistiques à grande échelle (LLM) tels que ChatGPT. Si l'adoption généralisée de l'IA peut également créer de nouvelles catégories d'emplois, celles-ci peuvent ne pas recouper les emplois supprimés, ce qui soulève des inquiétudes quant aux inégalités économiques et à la reconversion professionnelle.

- Failles de sécurité. Les systèmes d'IA sont vulnérables à un large éventail de cybermenaces, notamment l'empoisonnement des données et l'apprentissage automatique antagoniste. Les pirates informatiques peuvent par exemple extraire des données d'entraînement sensibles d'un modèle d'IA ou tromper les systèmes d'IA afin qu'ils produisent des résultats incorrects et nuisibles. Cela est particulièrement préoccupant dans les secteurs sensibles en matière de sécurité, tels que les services financiers et les administrations publiques.

- Impact environnemental. Les centres de données et les infrastructures réseau qui sous-tendent le fonctionnement des modèles d'IA consomment de grandes quantités d'énergie et d'eau. Par conséquent, la formation et l'exécution des modèles d'IA ont un impact significatif sur le climat. L'empreinte carbone de l'IA est particulièrement préoccupante pour les grands modèles génératifs, qui nécessitent d'importantes ressources informatiques pour leur formation et leur utilisation continue.

- Questions juridiques. L'IA soulève des questions complexes en matière de confidentialité et de responsabilité juridique, en particulier dans un contexte réglementaire en constante évolution qui varie d'une région à l'autre. L'utilisation de l'IA pour analyser et prendre des décisions sur la base de données personnelles a par exemple de graves implications en matière de confidentialité, et on ne sait toujours pas comment les tribunaux considéreront la paternité des contenus générés par des modèles linguistiques à grande échelle (LLM) entraînés à partir d'œuvres protégées par le droit d'auteur.

IA forte vs IA faible

L'IA peut généralement être classée en deux catégories : l'IA étroite (ou faible) et l'IA générale (ou forte).

- IA étroite. Cette forme d'IA désigne des modèles entraînés à effectuer des tâches spécifiques. L'IA étroite fonctionne dans le cadre des tâches pour lesquelles elle a été programmée, sans capacité à généraliser ou à apprendre au-delà de sa programmation initiale. Parmi les exemples d'IA étroite, on peut citer les assistants virtuels, tels que Siri d'Apple et Alexa d'Amazon, ainsi que les moteurs de recommandation, tels que ceux que l'on trouve sur les plateformes de streaming comme Spotify et Netflix.

- IA générale. Ce type d'IA, qui n'existe pas encore à l'heure actuelle, est plus souvent appelé « intelligence artificielle générale » (AGI). Si elle était créée, l'AGI serait capable d'effectuer toutes les tâches intellectuelles dont un être humain est capable. Pour ce faire, l'AGI devrait être capable d'appliquer son raisonnement à un large éventail de domaines afin de comprendre des problèmes complexes pour lesquels elle n'aurait pas été spécifiquement programmée. Cela nécessiterait alors ce que l'on appelle en IA la logique floue : une approche qui tient compte des zones d'ombre et des degrés d'incertitude, plutôt que des résultats binaires, en noir et blanc.

Il est important de noter que la question de savoir si l'AGI peut être créée - et les conséquences d'une telle création - reste vivement débattue parmi les experts en IA. Même les technologies d'IA les plus avancées à l'heure actuelle, telles que ChatGPT et d'autres LLM très performants, ne démontrent pas des capacités cognitives équivalentes à celles des humains et ne peuvent pas généraliser à partir de situations diverses. ChatGPT, par exemple, est conçu pour la génération de langage naturel et n'est pas capable d'aller au-delà de sa programmation initiale pour effectuer des tâches telles que des raisonnements mathématiques complexes.

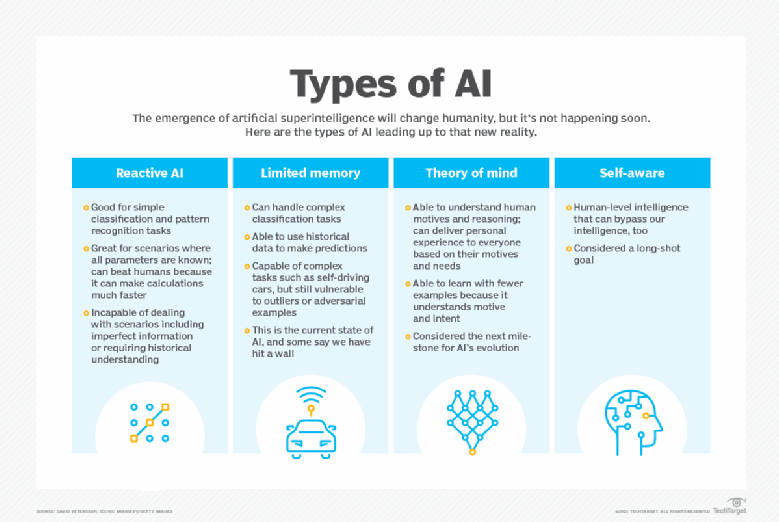

4 types d'IA

L'IA peut être classée en quatre types, à commencer par les systèmes intelligents spécifiques à une tâche, largement utilisés aujourd'hui, jusqu'aux systèmes sensibles, qui n'existent pas encore.

Les catégories sont les suivantes :

- Type 1 : Machines réactives. Ces systèmes d'IA n'ont pas de mémoire et sont spécifiques à une tâche. Deep Blue, le programme d'échecs d'IBM qui a battu le grand maître russe Garry Kasparov dans les années 1990, en est un exemple. Deep Blue était capable d'identifier les pièces sur un échiquier et de faire des prédictions, mais comme il n'avait pas de mémoire, il ne pouvait pas utiliser ses expériences passées pour éclairer ses expériences futures.

- Type 2 : mémoire limitée. Ces systèmes d'IA disposent d'une mémoire, ce qui leur permet d'utiliser leurs expériences passées pour éclairer leurs décisions futures. Certaines des fonctions décisionnelles des voitures autonomes sont conçues de cette manière.

- Type 3 : Théorie de l'esprit. La théorie de l'esprit est un terme psychologique. Appliquée à l'IA, elle désigne un système capable de comprendre les émotions. Ce type d'IA peut déduire les intentions humaines et prédire les comportements, une compétence nécessaire pour que les systèmes d'IA deviennent des membres à part entière d'équipes historiquement humaines.

- Type 4 : Conscience de soi. Dans cette catégorie, les systèmes d'IA ont une conscience de soi, ce qui leur confère une conscience. Les machines dotées d'une conscience de soi comprennent leur état actuel. Ce type d'IA n'existe pas encore.

Quels sont les exemples de technologie d'IA et comment est-elle utilisée aujourd'hui ?

Les technologies d'IA peuvent améliorer les fonctionnalités des outils existants et automatiser diverses tâches et processus, ce qui a une incidence sur de nombreux aspects de la vie quotidienne. Voici quelques exemples notables.

Automatisation

L'IA améliore les technologies d'automatisation en élargissant la gamme, la complexité et le nombre de tâches pouvant être automatisées. Un exemple est l'automatisation robotisée des processus (RPA), qui automatise les tâches répétitives de traitement des données basées sur des règles, traditionnellement effectuées par des humains. Comme l'IA aide les robots RPA à s'adapter aux nouvelles données et à réagir de manière dynamique aux changements de processus, l'intégration des capacités d'IA et d'apprentissage automatique permet à la RPA de gérer des flux de travail plus complexes.

Apprentissage automatique

L'apprentissage automatique est la science qui consiste à enseigner aux ordinateurs à apprendre à partir de données et à prendre des décisions sans être explicitement programmés pour le faire. L'apprentissage profond, un sous-ensemble de l'apprentissage automatique, utilise des réseaux neuronaux sophistiqués pour effectuer ce qui est essentiellement une forme avancée d'analyse prédictive.

Les algorithmes d'apprentissage automatique peuvent être classés en trois grandes catégories : l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage par renforcement.

- L'apprentissage supervisé forme des modèles à partir d'ensembles de données étiquetées, leur permettant ainsi de reconnaître avec précision des modèles, de prédire des résultats ou de classer de nouvelles données.

- L'apprentissage non supervisé forme des modèles à trier des ensembles de données non étiquetés afin de trouver des relations ou des regroupements sous-jacents.

- L'apprentissage par renforcement adopte une approche différente, dans laquelle les modèles apprennent à prendre des décisions en agissant comme des agents et en recevant un retour d'information sur leurs actions.

Il existe également l'apprentissage semi-supervisé, qui combine des aspects des approches supervisées et non supervisées. Cette technique utilise une petite quantité de données étiquetées et une plus grande quantité de données non étiquetées, améliorant ainsi la précision de l'apprentissage tout en réduisant le besoin de données étiquetées, dont l'obtention peut demander beaucoup de temps et de travail.

Vision par ordinateur

La vision par ordinateur est un domaine de l'IA qui vise à enseigner aux machines comment interpréter le monde visuel. En analysant des informations visuelles telles que des images et des vidéos à l'aide de modèles d'apprentissage profond, les systèmes de vision par ordinateur peuvent apprendre à identifier et à classer des objets, puis à prendre des décisions basées sur ces analyses.

L'objectif principal de la vision par ordinateur est de reproduire ou d'améliorer le système visuel humain à l'aide d'algorithmes d'IA. La vision par ordinateur est utilisée dans un large éventail d'applications, de l'identification des signatures à l'analyse d'images médicales en passant par les véhicules autonomes. La vision industrielle, un terme souvent confondu avec la vision par ordinateur, désigne spécifiquement l'utilisation de la vision par ordinateur pour analyser les données des caméras et des vidéos dans des contextes d'automatisation industrielle, tels que les processus de production dans le secteur manufacturier.

Traitement du langage naturel

Le NLP désigne le traitement du langage humain par des programmes informatiques. Les algorithmes NLP peuvent interpréter et interagir avec le langage humain, en effectuant des tâches telles que la traduction, la reconnaissance vocale et l'analyse des sentiments. L'un des exemples les plus anciens et les plus connus du NLP est la détection des spams, qui examine l'objet et le texte d'un e-mail et détermine s'il s'agit d'un courrier indésirable. Parmi les applications plus avancées du NLP, on trouve les LLM tels que ChatGPT et Claude d'Anthropic.

Robotique

La robotique est un domaine de l'ingénierie qui se concentre sur la conception, la fabrication et l'exploitation de robots : des machines automatisées qui reproduisent et remplacent les actions humaines, en particulier celles qui sont difficiles, dangereuses ou fastidieuses à réaliser pour les humains. Parmi les exemples d'applications robotiques, on peut citer la fabrication, où les robots effectuent des tâches répétitives ou dangereuses sur les chaînes de montage, et les missions d'exploration dans des zones éloignées et difficiles d'accès, telles que l'espace et les profondeurs marines.

L'intégration de l'IA et de l'apprentissage automatique élargit considérablement les capacités des robots en leur permettant de prendre des décisions autonomes mieux informées et de s'adapter à de nouvelles situations et données. Par exemple, les robots dotés de capacités de vision artificielle peuvent apprendre à trier des objets sur une chaîne de fabrication en fonction de leur forme et de leur couleur.

Véhicules autonomes

Les véhicules autonomes, plus communément appelés voitures autonomes, peuvent détecter leur environnement et s'y déplacer avec une intervention humaine minimale, voire nulle. Ces véhicules s'appuient sur une combinaison de technologies, notamment le radar, le GPS et toute une série d'algorithmes d'intelligence artificielle et d'apprentissage automatique, tels que la reconnaissance d'images.

Ces algorithmes apprennent à partir de données réelles sur la conduite, le trafic et les cartes afin de prendre des décisions éclairées sur le moment où freiner, tourner et accélérer, comment rester dans une voie donnée et comment éviter les obstacles imprévus, y compris les piétons. Bien que la technologie ait considérablement progressé ces dernières années, l'objectif ultime d'un véhicule autonome capable de remplacer entièrement un conducteur humain n'a pas encore été atteint.

IA générative

Le terme « IA générative » désigne les systèmes d'apprentissage automatique capables de générer de nouvelles données à partir d'invites textuelles, le plus souvent du texte et des images, mais aussi des fichiers audio, des vidéos, du code logiciel et même des séquences génétiques et des structures protéiques. Grâce à un apprentissage sur des ensembles de données massifs, ces algorithmes apprennent progressivement les modèles des types de médias qu'ils seront amenés à générer, ce qui leur permet ensuite de créer de nouveaux contenus similaires aux données d'apprentissage.

L'IA générative a connu une croissance rapide en popularité après l'introduction en 2022 de générateurs de texte et d'images largement disponibles, tels que ChatGPT, Dall-E et Midjourney, et est de plus en plus utilisée dans le monde des affaires. Si les capacités de nombreux outils d'IA générative sont impressionnantes, elles soulèvent également des questions concernant les droits d'auteur, l'utilisation équitable et la sécurité, qui font toujours l'objet d'un débat ouvert dans le secteur technologique.

Quelles sont les applications de l'IA ?

L'IA a fait son entrée dans un large éventail de secteurs industriels et de domaines de recherche. Voici quelques-uns des exemples les plus notables.

L'IA dans le domaine de la santé

L'IA est appliquée à toute une série de tâches dans le domaine des soins de santé, avec pour objectifs généraux d'améliorer les résultats pour les patients et de réduire les coûts systémiques. L'une des principales applications consiste à utiliser des modèles d'apprentissage automatique entraînés sur de grands ensembles de données médicales pour aider les professionnels de santé à établir des diagnostics plus précis et plus rapides. Par exemple, un logiciel basé sur l'IA peut analyser des scanners et alerter les neurologues en cas de suspicion d'accident vasculaire cérébral.

Du côté des patients, les assistants de santé virtuels en ligne et les chatbots peuvent fournir des informations médicales générales, prendre des rendez-vous, expliquer les processus de facturation et effectuer d'autres tâches administratives. Les algorithmes d'IA de modélisation prédictive peuvent également être utilisés pour lutter contre la propagation de pandémies telles que la COVID-19.

L'IA dans les affaires

L'IA est de plus en plus intégrée dans diverses fonctions commerciales et industries, dans le but d'améliorer l'efficacité, l'expérience client, la planification stratégique et la prise de décision. Par exemple, les modèles d'apprentissage automatique alimentent aujourd'hui de nombreuses plateformes d'analyse de données et de gestion de la relation client (CRM), aidant les entreprises à comprendre comment mieux servir leurs clients en personnalisant leurs offres et en proposant un marketing mieux adapté.

Les assistants virtuels et les chatbots sont également déployés sur les sites Web d'entreprise et dans les applications mobiles afin d'offrir un service client 24 heures sur 24 et de répondre aux questions courantes. En outre, de plus en plus d'entreprises explorent les capacités des outils d'IA générative tels que ChatGPT pour automatiser des tâches telles que la rédaction et la synthèse de documents, la conception et l'idéation de produits, ainsi que la programmation informatique.

L'IA dans l'éducation

L'IA offre de nombreuses applications potentielles dans le domaine des technologies éducatives. Elle peut automatiser certains aspects des processus de notation, ce qui permet aux enseignants de consacrer plus de temps à d'autres tâches. Les outils d'IA peuvent également évaluer les performances des élèves et s'adapter à leurs besoins individuels, facilitant ainsi des expériences d'apprentissage plus personnalisées qui permettent aux élèves de travailler à leur propre rythme. Les tuteurs IA pourraient également apporter un soutien supplémentaire aux élèves, en veillant à ce qu'ils restent sur la bonne voie. Cette technologie pourrait également modifier le lieu et la manière dont les élèves apprennent, voire changer le rôle traditionnel des enseignants.

À mesure que les capacités des modèles d'apprentissage profond (LLM) tels que ChatGPT et Google Gemini se développent, ces outils pourraient aider les enseignants à créer du matériel pédagogique et à impliquer les élèves de manière innovante. Cependant, l'avènement de ces outils oblige également les enseignants à repenser les pratiques en matière de devoirs et d'évaluations et à réviser les politiques en matière de plagiat, d'autant plus que les outils de détection et de filigranage basés sur l'IA ne sont actuellement pas fiables.

L'IA dans la finance et la banque

Les banques et autres organismes financiers utilisent l'IA pour améliorer leur prise de décision dans des domaines tels que l'octroi de prêts, la fixation de limites de crédit et l'identification d'opportunités d'investissement. De plus, le trading algorithmique, optimisé par l'IA avancée et l'apprentissage automatique, a transformé les marchés financiers, exécutant des transactions à des vitesses et avec une efficacité bien supérieures à celles que les traders humains pourraient atteindre manuellement.

L'IA et l'apprentissage automatique ont également fait leur entrée dans le domaine du crédit à la consommation. Par exemple, les banques utilisent des chatbots IA pour informer leurs clients sur leurs services et leurs offres, et pour traiter les transactions et les questions qui ne nécessitent pas d'intervention humaine. De même, Intuit propose des fonctionnalités d'IA générative dans son produit de déclaration fiscale en ligne TurboTax, qui fournissent aux utilisateurs des conseils personnalisés basés sur des données telles que leur profil fiscal et le code fiscal de leur lieu de résidence.

L'IA dans le domaine juridique

L'IA transforme le secteur juridique en automatisant des tâches fastidieuses telles que l'examen de documents et la réponse aux demandes de communication de pièces, qui peuvent être longues et laborieuses pour les avocats et les assistants juridiques. Aujourd'hui, les cabinets d'avocats utilisent l'IA et l'apprentissage automatique pour diverses tâches, notamment l'analyse et l'IA prédictive pour analyser les données et la jurisprudence, la vision par ordinateur pour classer et extraire des informations à partir de documents, et le traitement du langage naturel pour interpréter et répondre aux demandes de communication de pièces.

En plus d'améliorer l'efficacité et la productivité, cette intégration de l'IA libère les professionnels du droit, qui peuvent ainsi consacrer plus de temps à leurs clients et se concentrer sur des tâches plus créatives et stratégiques, pour lesquelles l'IA est moins bien adaptée. Avec l'essor de l'IA générative dans le domaine juridique, les cabinets explorent également la possibilité d'utiliser des LLM pour rédiger des documents courants, tels que des contrats types.

L'IA dans le divertissement et les médias

Le secteur du divertissement et des médias utilise les techniques d'IA dans la publicité ciblée, les recommandations de contenu, la distribution et la détection des fraudes. Cette technologie permet aux entreprises de personnaliser l'expérience des membres de leur audience et d'optimiser la diffusion de contenu.

L'IA générative est également un sujet brûlant dans le domaine de la création de contenu. Les professionnels de la publicité utilisent déjà ces outils pour créer des supports marketing et retoucher des images publicitaires. Cependant, leur utilisation est plus controversée dans des domaines tels que l'écriture de scénarios pour le cinéma et la télévision et les effets visuels, où ils offrent une efficacité accrue, mais menacent également les moyens de subsistance et la propriété intellectuelle des créatifs.

L'IA dans le journalisme

Dans le domaine du journalisme, l'IA peut rationaliser les flux de travail en automatisant les tâches routinières, telles que la saisie de données et la relecture. Les journalistes d'investigation et les journalistes spécialisés dans les données utilisent également l'IA pour trouver et rechercher des sujets en passant au crible de grands ensembles de données à l'aide de modèles d'apprentissage automatique, ce qui leur permet de mettre au jour des tendances et des liens cachés qui seraient longs à identifier manuellement. Par exemple, cinq finalistes du prix Pulitzer 2024 pour le journalisme ont révélé avoir utilisé l'IA dans leurs reportages pour effectuer des tâches telles que l'analyse de volumes massifs de dossiers policiers. Si l'utilisation des outils traditionnels d'IA est de plus en plus courante, le recours à l'IA générative pour rédiger des contenus journalistiques soulève des questions, car il suscite des inquiétudes quant à la fiabilité, la précision et l'éthique.

L'IA dans le développement logiciel et l'informatique

L'IA est utilisée pour automatiser de nombreux processus dans le développement de logiciels, le DevOps et l'informatique. Par exemple, les outils AIOps permettent la maintenance prédictive des environnements informatiques en analysant les données du système afin de prévoir les problèmes potentiels avant qu'ils ne surviennent, et les outils de surveillance basés sur l'IA peuvent aider à signaler les anomalies potentielles en temps réel sur la base des données historiques du système. Les outils d'IA générative tels que GitHub Copilot et Tabnine sont également de plus en plus utilisés pour produire du code d'application à partir de commandes en langage naturel. Bien que ces outils aient suscité un intérêt précoce et prometteur parmi les développeurs, ils ne sont pas susceptibles de remplacer complètement les ingénieurs logiciels. Ils constituent plutôt des aides à la productivité utiles, automatisant les tâches répétitives et l'écriture de code standard.

L'IA dans le domaine de la sécurité

L'IA et l'apprentissage automatique sont des mots à la mode très utilisés dans le marketing des fournisseurs de solutions de sécurité, les acheteurs doivent donc faire preuve de prudence. Néanmoins, l'IA est une technologie utile à plusieurs égards dans le domaine de la cybersécurité, notamment pour la détection des anomalies, la réduction des faux positifs et l'analyse comportementale des menaces. Par exemple, les entreprises utilisent l'apprentissage automatique dans les logiciels de gestion des informations et des événements de sécurité (SIEM) pour détecter les activités suspectes et les menaces potentielles. En analysant de grandes quantités de données et en reconnaissant les modèles qui ressemblent à des codes malveillants connus, les outils d'IA peuvent alerter les équipes de sécurité des attaques nouvelles et émergentes, souvent bien plus rapidement que ne le pourraient des employés humains ou les technologies précédentes.

L'IA dans le secteur manufacturier

Le secteur manufacturier a été à l'avant-garde de l'intégration des robots dans les flux de travail, les progrès récents se concentrant sur les robots collaboratifs, ou cobots. Contrairement aux robots industriels traditionnels, qui étaient programmés pour effectuer des tâches uniques et fonctionnaient séparément des travailleurs humains, les cobots sont plus petits, plus polyvalents et conçus pour travailler aux côtés des humains. Ces robots multitâches peuvent assumer davantage de responsabilités dans les entrepôts, les usines et autres espaces de travail, notamment dans les domaines de l'assemblage, de l'emballage et du contrôle qualité. En particulier, l'utilisation de robots pour effectuer ou aider à accomplir des tâches répétitives et physiquement exigeantes peut améliorer la sécurité et l'efficacité des travailleurs humains.

L'IA dans les transports

Outre leur rôle fondamental dans le fonctionnement des véhicules autonomes, les technologies d'IA sont utilisées dans le transport automobile pour gérer le trafic, réduire les embouteillages et améliorer la sécurité routière. Dans le domaine du transport aérien, l'IA peut prédire les retards de vol en analysant des données telles que les conditions météorologiques et le trafic aérien. Dans le domaine du transport maritime international, l'IA peut améliorer la sécurité et l'efficacité en optimisant les itinéraires et en surveillant automatiquement l'état des navires.

Dans les chaînes d'approvisionnement, l'IA remplace les méthodes traditionnelles de prévision de la demande et améliore la précision des prévisions concernant les perturbations et les goulots d'étranglement potentiels. La pandémie de COVID-19 a mis en évidence l'importance de ces capacités, car de nombreuses entreprises ont été prises au dépourvu par les effets d'une pandémie mondiale sur l'offre et la demande de marchandises.

Intelligence augmentée vs intelligence artificielle

Le terme « intelligence artificielle » est étroitement lié à la culture populaire, ce qui pourrait créer des attentes irréalistes parmi le grand public quant à l'impact de l'IA sur le travail et la vie quotidienne. Un autre terme proposé, « intelligence augmentée », distingue les systèmes informatiques qui assistent les humains des systèmes entièrement autonomes que l'on trouve dans la science-fiction, comme HAL 9000 dans 2001 : L'Odyssée de l'espace ou Skynet dans la série de films Terminator.

Les deux termes peuvent être définis comme suit :

- Intelligence augmentée. Avec sa connotation plus neutre, le terme « intelligence augmentée » suggère que la plupart des implémentations d'IA sont conçues pour améliorer les capacités humaines plutôt que pour les remplacer. Ces systèmes d'IA étroits améliorent principalement les produits et services en effectuant des tâches spécifiques. Citons par exemple la mise en évidence automatique de données importantes dans les rapports de veille économique ou le surlignage d'informations clés dans les documents juridiques. L'adoption rapide d'outils tels que ChatGPT et Gemini dans divers secteurs indique une volonté croissante d'utiliser l'IA pour soutenir la prise de décision humaine.

- Intelligence artificielle. Dans ce cadre, le terme « IA » serait réservé à l'IA générale avancée afin de mieux gérer les attentes du public et de clarifier la distinction entre les cas d'utilisation actuels et l'aspiration à atteindre l'AGI. Le concept d'AGI est étroitement lié à celui de singularité technologique, un avenir dans lequel une super intelligence artificielle dépasserait de loin les capacités cognitives humaines, pouvant potentiellement remodeler notre réalité d'une manière qui dépasse notre compréhension. La singularité est depuis longtemps un thème récurrent de la science-fiction, mais certains développeurs d'IA s'efforcent aujourd'hui activement de créer une AGI.

Utilisation éthique de l'intelligence artificielle

Si les outils d'IA offrent toute une gamme de nouvelles fonctionnalités aux entreprises, leur utilisation soulève d'importantes questions éthiques. Pour le meilleur ou pour le pire, les systèmes d'IA renforcent ce qu'ils ont déjà appris, ce qui signifie que ces algorithmes dépendent fortement des données sur lesquelles ils ont été entraînés. Comme ce sont des êtres humains qui sélectionnent ces données d'entraînement, le risque de biais est inhérent et doit être surveillé de près.

L'IA générative ajoute une autre couche de complexité éthique. Ces outils peuvent produire des textes, des images et des fichiers audio très réalistes et convaincants, ce qui est utile pour de nombreuses applications légitimes, mais peut également constituer un vecteur potentiel de désinformation et de contenus préjudiciables, tels que les deepfakes.

Par conséquent, toute personne souhaitant utiliser l'apprentissage automatique dans des systèmes de production réels doit tenir compte de l'éthique dans ses processus de formation à l'IA et s'efforcer d'éviter tout biais indésirable. Cela est particulièrement important pour les algorithmes d'IA qui manquent de transparence, tels que les réseaux neuronaux complexes utilisés dans l'apprentissage profond.

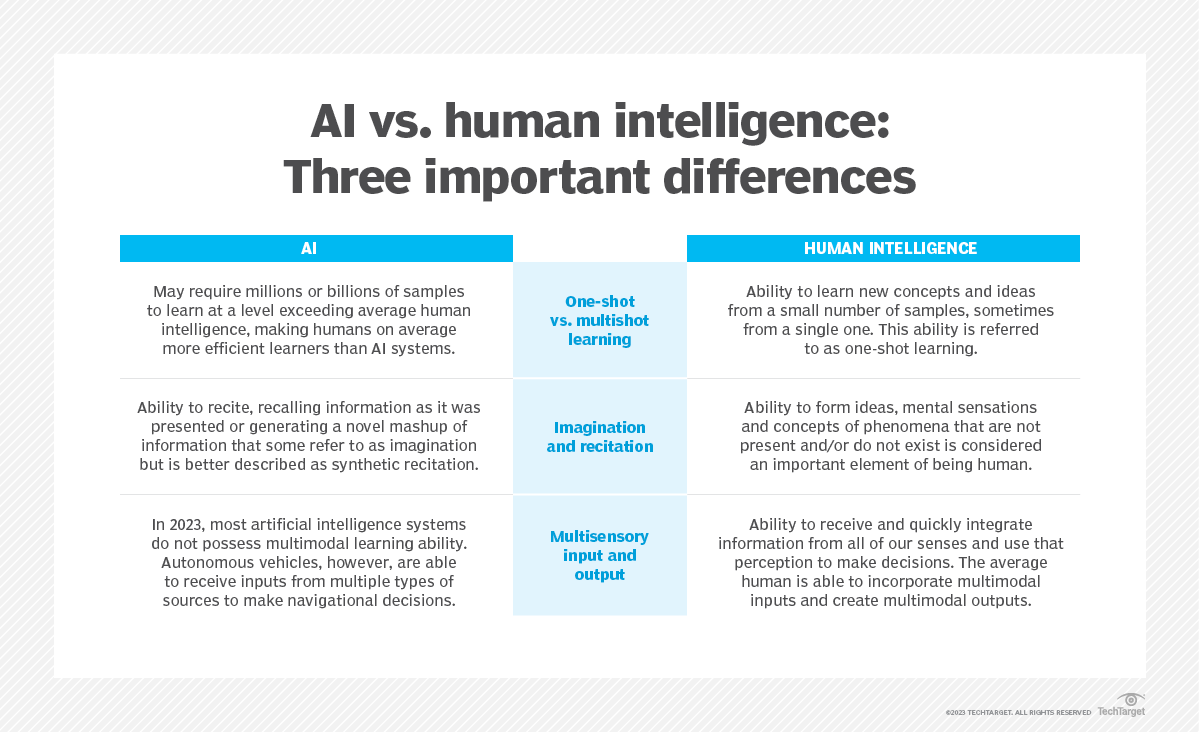

L'IA responsable désigne le développement et la mise en œuvre de systèmes d'IA sûrs, conformes et socialement bénéfiques. Elle est motivée par des préoccupations liées aux biais algorithmiques, au manque de transparence et aux conséquences imprévues. Ce concept trouve ses racines dans des idées anciennes issues de l'éthique de l'IA, mais il a pris de l'importance avec la généralisation des outils d'IA générative et, par conséquent, avec l'augmentation des risques qu'ils présentent. L'intégration des principes de l'IA responsable dans les stratégies commerciales aide les organisations à atténuer les risques et à renforcer la confiance du public.

L'explicabilité, ou la capacité à comprendre comment un système d'IA prend ses décisions, est un domaine qui suscite un intérêt croissant dans la recherche sur l'IA. Le manque d'explicabilité constitue un obstacle potentiel à l'utilisation de l'IA dans les secteurs soumis à des exigences réglementaires strictes. Par exemple, les lois sur l'équité en matière de crédit obligent les institutions financières américaines à expliquer leurs décisions d'octroi de crédit aux demandeurs de prêts et de cartes de crédit. Cependant, lorsque ces décisions sont prises par des programmes d'IA, les corrélations subtiles entre des milliers de variables peuvent créer un problème de « boîte noire », où le processus décisionnel du système est opaque.

En résumé, les défis éthiques liés à l'IA sont les suivants :

- Biais dus à des algorithmes mal formés et à des préjugés ou des négligences humaines.

- Utilisation abusive de l'IA générative pour produire des deepfakes, des escroqueries par hameçonnage et d'autres contenus préjudiciables.

- Problèmes juridiques, notamment les questions relatives à la diffamation et aux droits d'auteur dans le domaine de l'IA.

- Suppression d'emplois due à l'utilisation croissante de l'IA pour automatiser les tâches professionnelles.

- Les préoccupations relatives à la confidentialité des données, en particulier dans des domaines tels que la banque, la santé et le droit, qui traitent des données personnelles sensibles.

Gouvernance et réglementation de l'IA

Malgré les risques potentiels, il existe actuellement peu de réglementations régissant l'utilisation des outils d'IA, et de nombreuses lois existantes s'appliquent à l'IA de manière indirecte plutôt qu'explicite. Par exemple, comme mentionné précédemment, les réglementations américaines en matière de prêt équitable, telles que l'Equal Credit Opportunity Act, obligent les institutions financières à expliquer leurs décisions de crédit aux clients potentiels. Cela limite la mesure dans laquelle les prêteurs peuvent utiliser des algorithmes d'apprentissage profond, qui sont par nature opaques et difficilement explicables.

L'Union européenne s'est montrée proactive dans le domaine de la gouvernance de l'IA. Le règlement général sur la protection des données (RGPD) de l'UE impose déjà des limites strictes à l'utilisation des données des consommateurs par les entreprises, ce qui a une incidence sur la formation et les fonctionnalités de nombreuses applications d'IA destinées aux consommateurs. En outre, la loi européenne sur l'IA, qui vise à établir un cadre réglementaire complet pour le développement et le déploiement de l'IA, est entrée en vigueur en août 2024. Cette loi impose différents niveaux de réglementation aux systèmes d'IA en fonction de leur niveau de risque, les domaines tels que la biométrie et les infrastructures critiques faisant l'objet d'une surveillance accrue.

Si les États-Unis font des progrès, le pays ne dispose toujours pas d'une législation fédérale spécifique similaire à la loi européenne sur l'IA. Les décideurs politiques n'ont pas encore adopté de législation complète sur l'IA, et les réglementations fédérales existantes se concentrent sur des cas d'utilisation spécifiques et la gestion des risques, complétées par des initiatives au niveau des États. Cela dit, les réglementations plus strictes de l'UE pourraient finir par établir des normes de facto pour les multinationales basées aux États-Unis, à l'instar de la manière dont le RGPD a façonné le paysage mondial de la protection des données.

En ce qui concerne les développements spécifiques de la politique américaine en matière d'IA, le Bureau de la politique scientifique et technologique de la Maison Blanche a publié en octobre 2022 un « projet de charte des droits de l'IA », qui fournit des orientations aux entreprises sur la manière de mettre en œuvre des systèmes d'IA éthiques. La Chambre de commerce américaine a également appelé à la mise en place d'une réglementation sur l'IA dans un rapport publié en mars 2023, soulignant la nécessité d'une approche équilibrée qui favorise la concurrence tout en tenant compte des risques.

Plus récemment, en octobre 2023, le président Biden a publié un décret sur le thème du développement sûr et responsable de l'IA. Entre autres choses, ce décret enjoignait aux agences fédérales de prendre certaines mesures pour évaluer et gérer les risques liés à l'IA, et aux développeurs de systèmes d'IA puissants de communiquer les résultats des tests de sécurité. Le résultat de la prochaine élection présidentielle américaine est également susceptible d'influencer la future réglementation en matière d'IA, car les candidats Kamala Harris et Donald Trump ont adopté des approches différentes en matière de réglementation technologique.

Il ne sera pas facile d'élaborer des lois pour réglementer l'IA, d'une part parce que l'IA comprend une variété de technologies utilisées à des fins différentes, et d'autre part parce que les réglementations peuvent freiner les progrès et le développement de l'IA, provoquant une réaction négative de la part de l'industrie. L'évolution rapide des technologies d'IA constitue un autre obstacle à l'élaboration de réglementations pertinentes, tout comme le manque de transparence de l'IA, qui rend difficile la compréhension du fonctionnement des algorithmes. De plus, les avancées technologiques et les nouvelles applications telles que ChatGPT et Dall-E peuvent rapidement rendre les lois existantes obsolètes. Et, bien sûr, les lois et autres réglementations ont peu de chances de dissuader les acteurs malveillants d'utiliser l'IA à des fins nuisibles.

Quelle est l'histoire de l'IA ?

Le concept d'objets inanimés dotés d'intelligence existe depuis l'Antiquité. Dans les mythes, le dieu grec Héphaïstos était représenté en train de forger des serviteurs ressemblant à des robots à partir d'or, tandis que les ingénieurs de l'Égypte antique construisaient des statues de dieux capables de bouger, animées par des mécanismes cachés actionnés par des prêtres.

Au fil des siècles, des penseurs tels que le philosophe grec Aristote, le théologien espagnol du XIIIe siècle Ramon Llull, le mathématicien René Descartes et le statisticien Thomas Bayes ont utilisé les outils et la logique de leur époque pour décrire les processus de pensée humaine sous forme de symboles. Leurs travaux ont jeté les bases de concepts d'IA tels que la représentation générale des connaissances et le raisonnement logique.

La fin du XIXe siècle et le début du XXe siècle ont vu naître les travaux fondamentaux qui ont donné naissance à l'ordinateur moderne. En 1836, Charles Babbage, mathématicien à l'université de Cambridge, et Augusta Ada King, comtesse de Lovelace, ont inventé le premier modèle de machine programmable, connu sous le nom de « machine analytique ». Babbage a esquissé les plans du premier ordinateur mécanique, tandis que Lovelace, souvent considérée comme la première programmeuse informatique, a pressenti que cette machine serait capable d'aller au-delà des simples calculs pour effectuer toute opération pouvant être décrite de manière algorithmique.

Au cours du XXe siècle, des avancées majeures dans le domaine de l'informatique ont façonné ce qui allait devenir l'IA. Dans les années 1930, le mathématicien britannique Alan Turing, décrypteur de codes pendant la Seconde Guerre mondiale, a introduit le concept d'une machine universelle capable de simuler n'importe quelle autre machine. Ses théories ont joué un rôle crucial dans le développement des ordinateurs numériques et, à terme, de l'IA.

années 1940

Le mathématicien de Princeton John Von Neumann a conçu l'architecture de l'ordinateur à programme enregistré, c'est-à-dire l'idée que le programme d'un ordinateur et les données qu'il traite peuvent être conservés dans la mémoire de l'ordinateur. Warren McCulloch et Walter Pitts ont proposé un modèle mathématique de neurones artificiels, jetant ainsi les bases des réseaux neuronaux et d'autres développements futurs de l'IA.

années 1950

Avec l'avènement des ordinateurs modernes, les scientifiques ont commencé à tester leurs idées sur l'intelligence artificielle. En 1950, Turing a mis au point une méthode permettant de déterminer si un ordinateur est intelligent, qu'il a appelée « jeu d'imitation », mais qui est plus communément connue sous le nom de « test de Turing ». Ce test évalue la capacité d'un ordinateur à convaincre ses interrogateurs que ses réponses à leurs questions ont été données par un être humain.

Le domaine moderne de l'IA est largement considéré comme ayant vu le jour en 1956 lors d'une conférence estivale au Dartmouth College. Parrainée par la Defense Advanced Research Projects Agency, cette conférence a réuni 10 sommités du domaine, dont les pionniers de l'IA Marvin Minsky, Oliver Selfridge et John McCarthy, à qui l'on attribue la paternité du terme « intelligence artificielle ». Étaient également présents Allen Newell, informaticien, et Herbert A. Simon, économiste, politologue et psychologue cognitif.

Les deux hommes ont présenté leur programme révolutionnaire Logic Theorist, un programme informatique capable de prouver certains théorèmes mathématiques et souvent considéré comme le premier programme d'IA. Un an plus tard, en 1957, Newell et Simon ont créé l'algorithme General Problem Solver qui, bien qu'il ne parvienne pas à résoudre des problèmes plus complexes, a jeté les bases du développement d'architectures cognitives plus sophistiquées.

années 1960

À la suite de la conférence du Dartmouth College, les leaders du domaine naissant de l'IA ont prédit que l'intelligence créée par l'homme et équivalente au cerveau humain était à portée de main, attirant ainsi un soutien important de la part des gouvernements et de l'industrie. En effet, près de 20 ans de recherche fondamentale bien financée ont permis de réaliser des progrès significatifs dans le domaine de l'IA. McCarthy a développé Lisp, un langage initialement conçu pour la programmation de l'IA qui est encore utilisé aujourd'hui. Au milieu des années 1960, le professeur Joseph Weizenbaum du MIT a développé Eliza, l'un des premiers programmes de traitement du langage naturel qui a jeté les bases des chatbots actuels.

années 1970

Dans les années 1970, la réalisation de l'AGI s'est avérée difficile à atteindre, voire impossible, en raison des limites du traitement informatique et de la mémoire, ainsi que de la complexité du problème. En conséquence, le soutien des gouvernements et des entreprises à la recherche en IA s'est affaibli, entraînant une période de stagnation qui a duré de 1974 à 1980, connue sous le nom de premier hiver de l'IA. Pendant cette période, le domaine naissant de l'IA a connu une baisse significative de son financement et de l'intérêt qu'il suscitait.

années 1980

Dans les années 1980, les recherches sur les techniques d'apprentissage profond et l'adoption par l'industrie des systèmes experts d'Edward Feigenbaum ont déclenché une nouvelle vague d'enthousiasme pour l'IA. Les systèmes experts, qui utilisent des programmes basés sur des règles pour imiter la prise de décision des experts humains, ont été appliqués à des tâches telles que l'analyse financière et le diagnostic clinique. Cependant, comme ces systèmes restaient coûteux et limités dans leurs capacités, la renaissance de l'IA a été de courte durée, suivie d'un nouvel effondrement du financement public et du soutien de l'industrie. Cette période de baisse d'intérêt et d'investissement, connue sous le nom de deuxième hiver de l'IA, a duré jusqu'au milieu des années 1990.

années 1990

L'augmentation de la puissance de calcul et l'explosion des données ont déclenché une renaissance de l'IA au milieu et à la fin des années 1990, ouvrant la voie aux progrès remarquables que nous observons aujourd'hui dans ce domaine. La combinaison du big data et de la puissance de calcul accrue a permis des avancées décisives dans le traitement du langage naturel, la vision par ordinateur, la robotique, l'apprentissage automatique et l'apprentissage profond. Une étape importante a été franchie en 1997, lorsque Deep Blue a battu Kasparov, devenant ainsi le premier programme informatique à battre un champion du monde d'échecs.

années 2000

Les progrès réalisés dans les domaines de l'apprentissage automatique, de l'apprentissage profond, du traitement du langage naturel, de la reconnaissance vocale et de la vision par ordinateur ont donné naissance à des produits et services qui ont façonné notre mode de vie actuel. Parmi les développements majeurs, citons le lancement du moteur de recherche Google en 2000 et celui du moteur de recommandation Amazon en 2001.

Toujours dans les années 2000, Netflix a développé son système de recommandation de films, Facebook a introduit son système de reconnaissance faciale et Microsoft a lancé son système de reconnaissance vocale pour la transcription audio. IBM a lancé son système de questions-réponses Watson, et Google a lancé son initiative de voiture autonome, Waymo.

années 2010

La décennie 2010-2020 a été marquée par une succession ininterrompue d'avancées dans le domaine de l'IA. Parmi celles-ci, citons le lancement des assistants vocaux Siri d'Apple et Alexa d'Amazon, les victoires d'IBM Watson au jeu télévisé Jeopardy, le développement de fonctions de conduite autonome pour les voitures et la mise en œuvre de systèmes basés sur l'IA capables de détecter les cancers avec un haut degré de précision. Le premier réseau antagoniste génératif a été développé et Google a lancé TensorFlow, un framework open source d'apprentissage automatique largement utilisé dans le développement de l'IA.

Une étape clé a été franchie en 2012 avec le lancement révolutionnaire d'AlexNet, un réseau neuronal convolutif qui a considérablement fait progresser le domaine de la reconnaissance d'images et popularisé l'utilisation des GPU pour l'entraînement des modèles d'IA. En 2016, le modèle AlphaGo de Google DeepMind a battu le champion du monde de Go Lee Sedol, démontrant ainsi la capacité de l'IA à maîtriser des jeux stratégiques complexes. L'année précédente a vu la création du laboratoire de recherche OpenAI, qui allait faire des progrès importants dans la seconde moitié de la décennie en matière d'apprentissage par renforcement et de NLP.

années 2020

La décennie actuelle a jusqu'à présent été dominée par l'avènement de l'IA générative, qui peut produire de nouveaux contenus à partir des demandes des utilisateurs. Ces demandes prennent souvent la forme de texte, mais elles peuvent également être des images, des vidéos, des plans de conception, de la musique ou tout autre type de données que le système d'IA peut traiter. Les contenus générés peuvent aller d'essais à des explications de résolution de problèmes, en passant par des images réalistes basées sur des photos d'une personne.

En 2020, OpenAI a publié la troisième version de son modèle linguistique GPT, mais cette technologie n'a été largement médiatisée qu'en 2022. Cette année-là, la vague de l'IA générative a commencé avec le lancement des générateurs d'images Dall-E 2 et Midjourney, respectivement en avril et juillet. L'engouement et le battage médiatique ont atteint leur apogée avec la sortie générale de ChatGPT en novembre.

Les concurrents d'OpenAI ont rapidement réagi à la sortie de ChatGPT en lançant des chatbots LLM rivaux, tels que Claude d'Anthropic et Gemini de Google. Des générateurs audio et vidéo tels que ElevenLabs et Runway ont suivi en 2023 et 2024.

La technologie d'IA générative en est encore à ses débuts, comme en témoignent sa tendance persistante à l'hallucination et la recherche continue d'applications pratiques et rentables. Quoi qu'il en soit, ces développements ont fait entrer l'IA dans le débat public d'une manière nouvelle, suscitant à la fois enthousiasme et inquiétude.

Outils et services d'IA : évolution et écosystèmes

Les outils et services d'IA évoluent à un rythme effréné. Les innovations actuelles remontent au réseau neuronal AlexNet de 2012, qui a inauguré une nouvelle ère d'IA haute performance basée sur les GPU et les grands ensembles de données. La principale avancée a été la découverte que les réseaux neuronaux pouvaient être entraînés sur des quantités massives de données à travers plusieurs cœurs GPU en parallèle, rendant le processus d'entraînement plus évolutif.

Au XXIe siècle, une relation symbiotique s'est développée entre, d'une part, les avancées algorithmiques réalisées par des organisations telles que Google, Microsoft et OpenAI et, d'autre part, les innovations matérielles mises au point par des fournisseurs d'infrastructures tels que Nvidia. Ces développements ont permis d'exécuter des modèles d'IA toujours plus volumineux sur des GPU plus connectés, ce qui a entraîné des améliorations révolutionnaires en termes de performances et d'évolutivité. La collaboration entre ces sommités de l'IA a été cruciale pour le succès de ChatGPT, sans parler des dizaines d'autres services d'IA révolutionnaires. Voici quelques exemples d'innovations qui stimulent l'évolution des outils et services d'IA.

Transformateurs

Google a ouvert la voie en trouvant un processus plus efficace pour fournir une formation en IA sur de grands clusters d'ordinateurs grand public équipés de processeurs graphiques. Cela a ensuite permis la découverte des transformateurs, qui automatisent de nombreux aspects de la formation en IA sur des données non étiquetées. Dans leur article intitulé « Attention Is All You Need » publié en 2017, les chercheurs de Google ont présenté une architecture novatrice qui utilise des mécanismes d'auto-attention pour améliorer les performances des modèles sur un large éventail de tâches de traitement du langage naturel, telles que la traduction, la génération de texte et la synthèse. Cette architecture de transformateurs a été essentielle au développement des LLM contemporains, notamment ChatGPT.

Optimisation matérielle

Le matériel informatique est tout aussi important que l'architecture algorithmique dans le développement d'une IA efficace, performante et évolutive. Les processeurs graphiques (GPU), initialement conçus pour le rendu graphique, sont désormais indispensables au traitement de jeux de données volumineux. Les unités de traitement tensoriel et les unités de traitement neuronal, spécialement conçues pour l'apprentissage profond, ont accéléré l'entraînement de modèles d'IA complexes. Des fournisseurs tels que Nvidia ont optimisé le microcode pour qu'il fonctionne en parallèle sur plusieurs cœurs de GPU pour les algorithmes les plus populaires. Les fabricants de puces collaborent également avec les principaux fournisseurs de cloud computing afin de rendre cette fonctionnalité plus accessible en tant qu'IA en tant que service (AIaaS) via des modèles IaaS, SaaS et PaaS.

Transformateurs génératifs pré-entraînés et réglage fin

La pile IA a évolué rapidement au cours des dernières années. Auparavant, les entreprises devaient former leurs modèles IA à partir de zéro. Aujourd'hui, des fournisseurs tels qu'OpenAI, Nvidia, Microsoft et Google proposent des transformateurs génératifs pré-entraînés (GPT) qui peuvent être affinés pour des tâches spécifiques à un coût, un niveau d'expertise et un temps considérablement réduits.

Services cloud d'IA et AutoML

L'un des principaux obstacles qui empêchent les entreprises d'utiliser efficacement l'IA est la complexité des tâches d'ingénierie et de science des données nécessaires pour intégrer les capacités de l'IA dans des applications nouvelles ou existantes. Tous les principaux fournisseurs de cloud computing déploient des offres IAaaS de marque afin de rationaliser la préparation des données, le développement de modèles et le déploiement d'applications. Parmi les exemples les plus marquants, citons Amazon AI, Google AI, Microsoft Azure AI et Azure ML, IBM Watson et les fonctionnalités IA d'Oracle Cloud.

De même, les principaux fournisseurs de services cloud et d'autres fournisseurs proposent des plateformes d'apprentissage automatique (AutoML) pour automatiser de nombreuses étapes du développement du ML et de l'IA. Les outils AutoML démocratisent les capacités de l'IA et améliorent l'efficacité des déploiements IA.

Modèles d'IA de pointe en tant que service

Les principaux développeurs de modèles d'IA proposent également des modèles d'IA de pointe en plus de ces services cloud. OpenAI dispose de plusieurs LLM optimisés pour le chat, le NLP, la multimodalité et la génération de code, qui sont fournis via Azure. Nvidia a adopté une approche plus indépendante du cloud en vendant une infrastructure d'IA et des modèles fondamentaux optimisés pour le texte, les images et les données médicales à tous les fournisseurs de cloud. De nombreux acteurs plus modestes proposent également des modèles personnalisés pour divers secteurs et cas d'utilisation.

George Lawton a également contribué à cet article.